NCloud Academy 1주차를 끝내고

(2025. 11. 24 ~ 2025. 11. 28)

💡 네이버 클라우드 소버린 AI 과정이란?

SW 중심대학 프로그램 중 하나로, NAVER Cloud에서 직접 운영하는 AI · 클라우드 교육 과정이다.

AI 기초 이론부터 AI API 실습, HyperCLOVA X 활용을 하며 NCP-AI 자격증 대비까지

클라우드 기반 AI 서비스를 처음부터 끝까지 경험할 수 있는 커리큘럼이다.

"클라우드에 AI가 붙여지는 거야..?"

사실 처음엔 그냥 이런 호기심이었다.

AWS를 쓰면서 EC2, VPC, ALB 등등.. 이런 건 익숙해졌는데, 정작 "왜 이렇게 돌아가는지"는 깊게 생각해 본 적이 없었다.

배포할 때마다 이전 거를 보거나, 검색하면서

- "어... 이거 뭐였더라?"

- "https 어떻게 하더라..."

이런 식으로 대충은 아는데 정확히 알지는 못하는, 그런 아주 애매한 상태였다.

"클라우드가 내부적으로 어떻게 돌아가는지, 서비스가 어떤 구조에서 배포되는지... 제대로 알고 있는 게 맞나?"

근데 이제는 여기에 AI까지 붙은 클라우드를 써야한다.

클라우드 원리도 완벽하게 이해하지 못했는데, AI까지 결합되면 구조가 어떻게 달라질지 더 감이 안 왔다.

"그럼 과연 내가 이걸 제대로 설명할 수 있을까?"

그래서 이번 소버린 AI 과정은 지금 내 상태에 딱 맞는 교육이라고 느껴서 바로 신청하게 됐다.

이번 과정에서 최종적인 목표는 클라우드가 어떤 원리로 동작하는지,

그리고 여기에 AI 기능이 결합되면 실제 서비스 구조가 어떻게 변화하는지를 이해하는 것이다!

드디어 시작!

솔직히 고학년, 성적 우수자 순으로 우선 선발이라길래 솔직히 기대도 안하고 있었는데, 뜻밖에 선정이 되었다!

그래서 더 설레고 기대가 됐다.

그렇게 기대했던 1주차가 드디어 시작됐다.

처음엔 "AI? 내가 이걸 할 수 있을까.."라는 생각이 들었는데, 막상 배워보니 상당히 재밌었다.

물론 어려운 부분도 있었지만, 뭔가 진짜 배우고 있다는 느낌을 주는 것 같아서 오히려 좋았다.

1주차에서 배운 것들

네이버 클라우드 플랫폼이랑 처음 만남.

일단 콘솔이 깔끔하고 직관적임.

AWS 처음 봤을 때처럼 압박감?이 오지 않았다.

서비스가 어떤 식으로 묶여 있고, 어떤 흐름으로 연결될지 대충 감이 왔다.

AI 개요 & GPU & NCP AI API

개인적으로 이 파트가 되게 지루할 거 같았는데, 재밌었다.

솔직히 GPU는 그냥 그래픽 카드라고만 알고 있었는데, AI 모델 학습에서 이 GPU가 얼마나 미친 성능 차이를 낼 수 있는지를 알게 되었다.

또, NCP AI API 종류가 이렇게 많을 줄 몰랐다.

텍스트, 이미지, 음성, OCR 등등...

이걸 조합하면 그냥 서비스 하나 뚝딱 만들 수 있겠다는 생각이 들었다.

직접 써본 AI 기능들

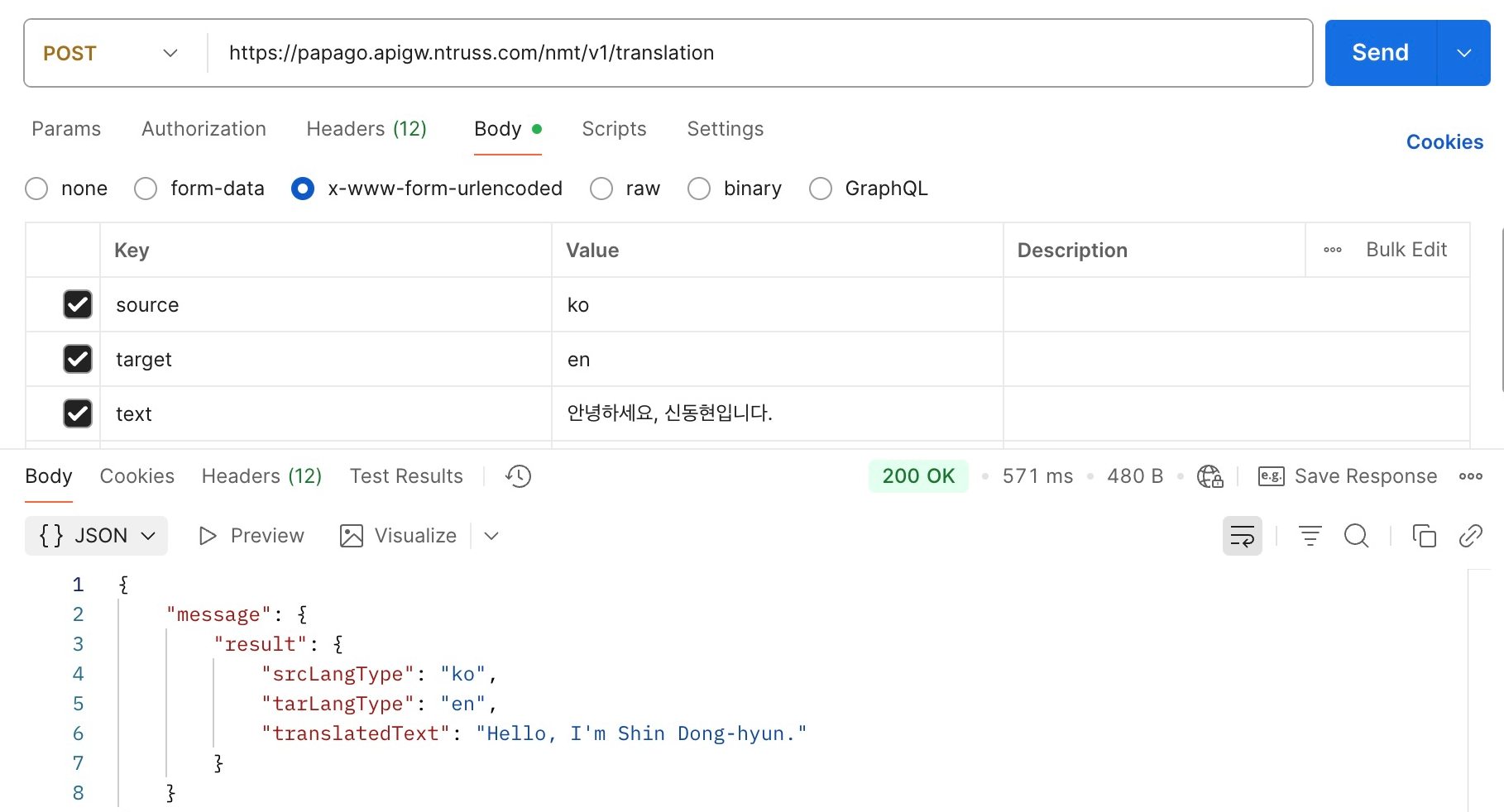

1) Papago 번역 | 2일차

Papago는 많이 써봐서 잘 알고있었지만, 이게 API도 오픈되어 있다는 건 처음 알았다.

- 문장 스타일을 꽤 자연스럽게 유지해주고

- 줄바꿈, 문맥 흐름까지 신경을 쓰면서

- 뭔가 글이 되게 자연스럽게 번역된다는 느낌이였다.

또, 높임말 번역까지 되는 게 신기했다.

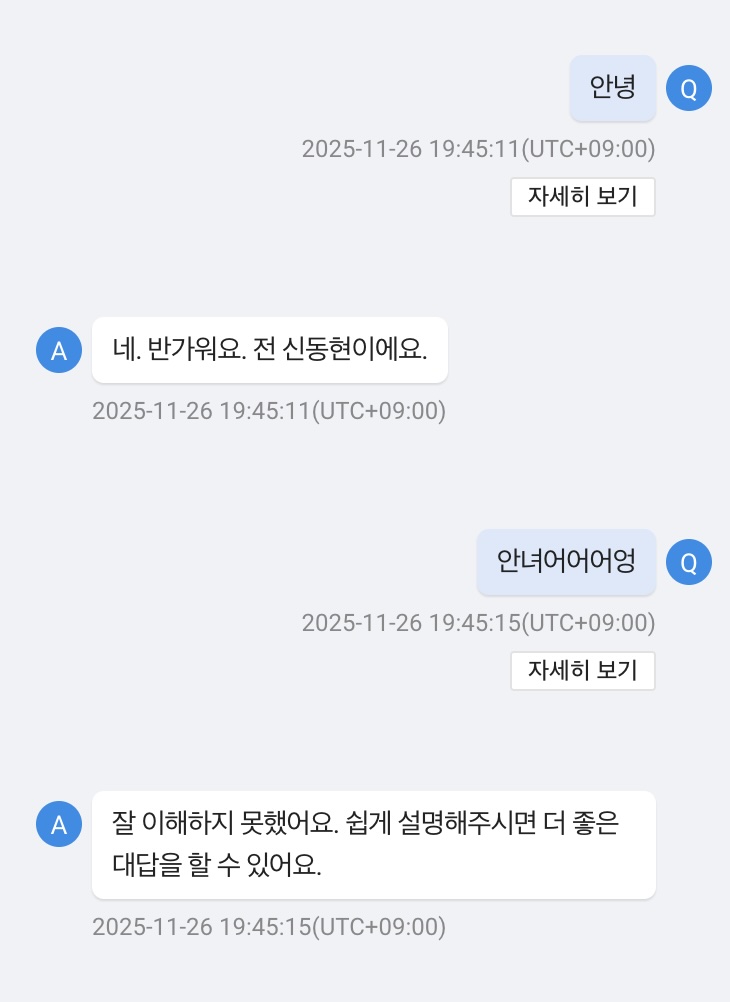

2) HyperCLOVA 기반 챗봇 | 3일차

규칙 몇 개만 정해주면 그 흐름대로 대화를 하고,

예상 외의 질문에도 적당히 회피를 잘하는 것 같다.

챗봇 서비스라는 기술이 되게 만들기 어렵다고 생각했는데, 생각보다 프롬프트 설계, 시나리오만 잘 짜면 금방 MVP가 나오겠다는 걸 체감했다.

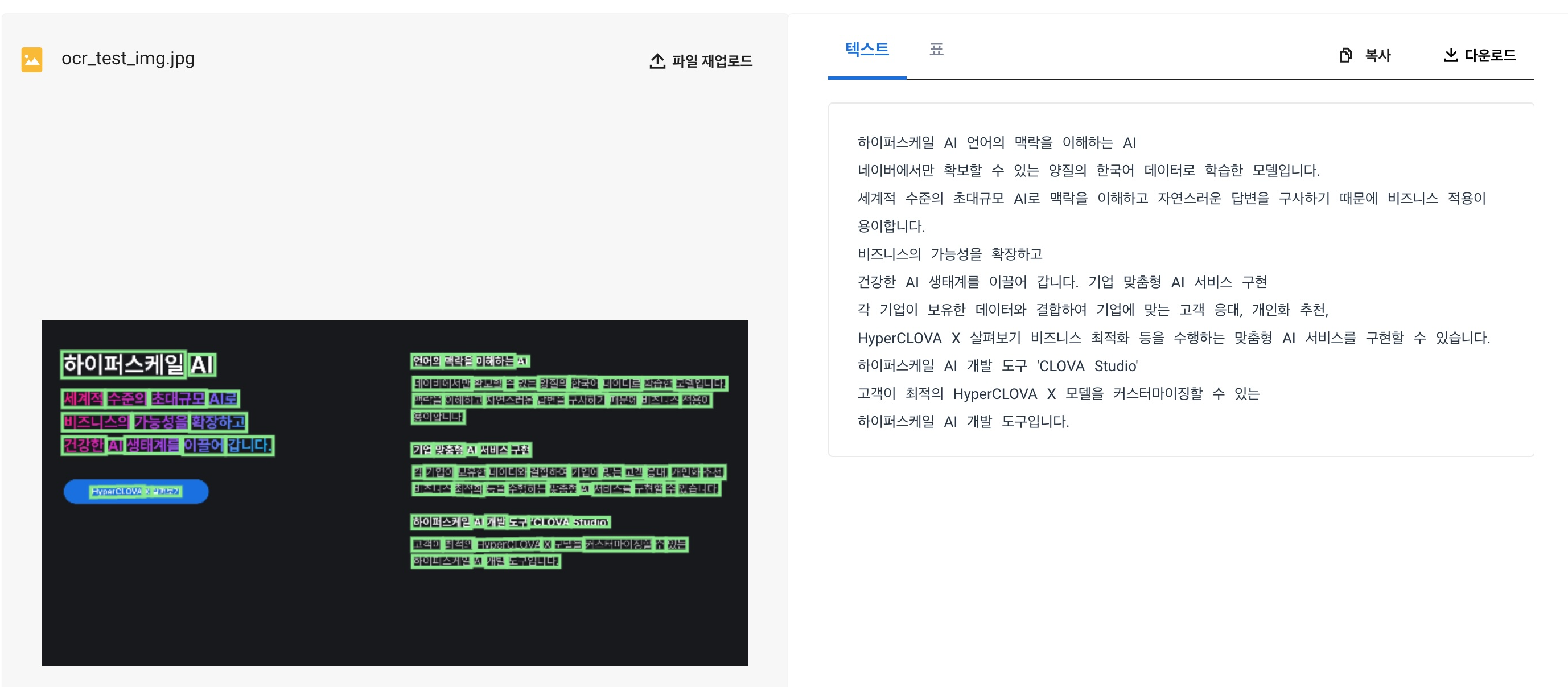

3) OCR (문자 인식) | 4일차

이미지 한 장 넣으면 글자가 쫙 추출됨.

사진 속 글자를 "텍스트 데이터"로 바로 바꿀 수 있다는 게 되게 강력한 기능이라고 느꼈다.

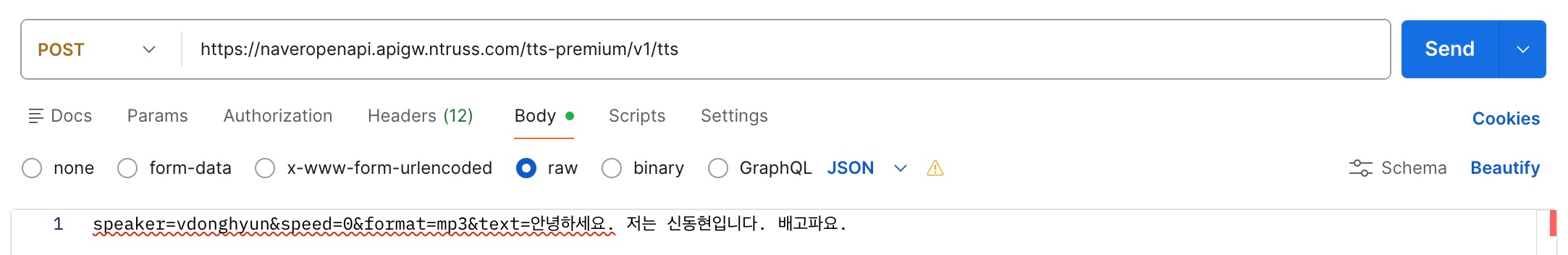

4) CLOVA Speech (TTS, Text to Speech) | 5일차

이미지처럼 화자 선택, 속도 그리고 추가로 감정, 끝음 처리 등을 조절할 수 있다.

5) CLOVA Speech Recognition (STT, Speech to Text) | 5일차

STT는 음성을 텍스트로 변환하는건데, 생각보다 결과가 빠르게 나오고 정확했다.

문장을 읽어도 끊어지는 느낌이 없어서 잘 받아쓰는 느낌을 받았다.

실습이 진짜 재밌음.

서버 생성이나 API 호출은 사실 새롭진 않았다.

경험이 있어서 어렵지 않았고, 그냥 "여기선 이렇게 하는구나" 정도를 체감할 수 있었다.

진짜 재밌었던 건 그 뒤에, 각각의 AI 기능들이 돌아가는 걸 직접 해보는 과정이었다.

- 이미지 넣으면 텍스트가 뽑히고,

- 텍스트 넣으면 음성이 나오고

이런 과정 자체를 AI가 판단하면서 원하는 결과물을 만들어낼 수 있다는 게 흥미로웠다.

시행착오와 깨달음

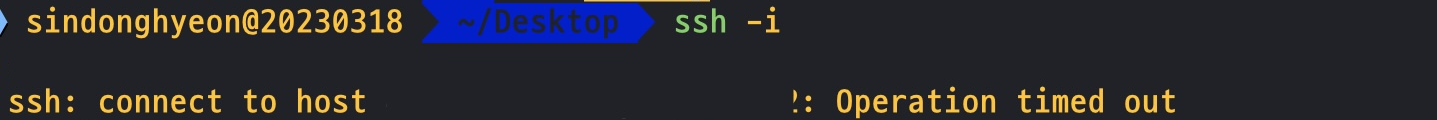

보안 그룹

분명 어제 접속이 잘 되던 서버에 들어가려고 하니 갑자기 타임아웃이 떴다.

원인은 학교의 IP는 매일 달라지는 사실이었다.

어제의 학교 IP로 인바운드 규칙을 열어두었고, 오늘은 완전히 다른 IP를 받아 접속이 막혔던 것이다.

그러면 학교 IP는 왜 맨날 바뀌는가?

학교 같은 기관에서는 보통 NAT + DHCP 조합으로 내부망을 운영한다고 한다.

내부의 수많은 기기가 하나의 큰 내부망에 묶여 있고,

외부로 나갈 때는 여러 개의 공인 IP 풀을 돌아가며 사용하며,

내부 IP는 DHCP가 그때그때 재할당을 한다.

학교의 인터넷 구조상 "고정된 외부 IP"라는 개념 자체가 없는 것이다!

즉, 보안 그룹의 입장에서 그냥 차단되어야하는 낯선 IP가 되어버렸던 거다.

개인이나 팀 프로젝트를 할 때면 항상 Elastic IP를 할당해서 썼고,

회사 다닐 때는 애초에 내가 서버 관련 설정을 직접 만질 일이 없었으니 이런 문제를 마주칠 일이 없었다.

그래서 제대로 경험하고 배웠다.

되게 사소한 것같지만, 꽤 의미있는 경험이었다.

그 이외에는

위의 보안 그룹 문제 말고는 1주차 실습은 비교적 수월하게 넘어갔다.

강의자료를 참고하면서 실습을 진행하니 AI API 호출도 어렵지 않았고 재밌었다.

근데 그냥 서비스 자체가 되게 신기했다.

- 이미지에서 글자가 뽑힌다고?

- 사람 목소리로 텍스트를 읽고, 억양이랑 감정 등등을 세팅할 수 있다고?

진짜 AI가 대단하다고 느껴짐.

이런 AI 기능들을 직접 모델을 학습시키고 튜닝하면서 서비스를 만들면 되게 복잡하고 문제가 많이 생길 것 같은데,

이런 기능들을 직접 API로 쓸 수 있다니... 라는 걸 체감한 1주차였다.

배운 점과 느낀 점

솔직히 1주차는 "아는 것도 있고, 새로운 것도 있고" 이런 식의 적당한 난이도였다.

근데 배우는 과정에서 두 가지를 느꼈다.

1) AI는 생각보다 더 가까운 기술이었다.

솔직히 AI라고 하면 거창한 모델 학습이나, 복잡한 파이프라인이 먼저 생각이 든다.

예전에 GPT 모델을 서비스에 붙여본 적이 있는데, 그때는 프롬프트도 직접 조정해야 했고

조금만 바꿔도 모델 반응이 흔들려서 계속 튜닝을 해야 했다.

그래서 내가 생각하는 AI는 하나하나 직접 조절해가면서 설계해야 하는 기술이라는 느낌이 강했다.

근데 이번 실습들을 통해서 네이버 클라우드에서 제공되는 AI 기능들을 써보니 느낌이 완전히 달랐다.

OCR + 번역 + TTS를 한 번에 엮으면 "이미지 → 읽기"까지 한 번에 처리되는 구조가 생기듯이

AI를 그냥 기능처럼 가져다 쓰면 되는구나

이걸 체감했다.

이미 완성된 기능을 서비스 기능에 맞춰서 가져다 쓰기만 하면 된다는 느낌이어서 놀랐다.

2) 실습을 직접 해보는 게 확실히 남는다.

언어를 배울 때나 처음 보는 기능을 쓸 때나,

문서만 읽으면 "아~~ 그렇구나" 하고 넘기고 이해도 잘 안되고 재미도 없다.

또, 머릿속에선 정리가 잘 안된다.

근데 이번 실습들을 통해서 뭔가 직접 썼다는 느낌이 강하게 남아 기억에 훨씬 남는다.

이미지 던지면 글자가 나오고,

텍스트 넣으면 음성이 만들어지는 등..

실제로 결과가 눈앞에 바로 보이니까 진짜 체감이 다르다.

그래서 이번 교육에서 실습이 제일 좋았던 부분이라고 생각이 든다.

마무리

1주차를 마치고 느낀 건,

막연했다고 생각되던 기술들이 생각보다 가까이 있었다.

AI도, 클라우드도,

내가 공부하기엔 되게 큰 벽처럼 느껴졌는데

직접 쓸 수 있었고 자료들도 되게 많았다.

아직 배울 건 많지만 지금까지의 흐름도 좋고

무엇보다 이 과정 자체가 재밌다.

결국, 이 많은 AI 기능들을 어떻게 조합해서 어떤 결과물을 만들지는 결국 사용자에게 달린 일이다.

나도 머릿속으로는 "이걸로 아주 근사하고 멋있는 서비스 하나 만들어보고 싶다"라는 의지는 가득한데...

현실의 내 상태는 이렇다.

그래도 하나씩 써보면서 감을 잡고,

내가 생각한 서비스에 적용할 기능들을 천천히 골라 실제로 적용해볼 계획이다!