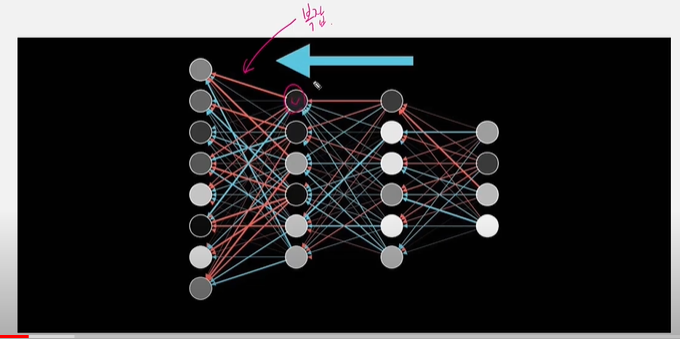

Backpropagation : 오차 역전파

인공신경망을 학습시키기 위한 알고리즘

local gradient를 미리 저장한다는 것이 어떤 것인지, 최종 loss값은 어떻게 구해지는 지 알아오기!

Forward pass -> Backward Pass

target과 모델이 예측한 값의 차이= loss를 뒤로 전달하면서, 각 node의 weigt를 갱신시켜줌!

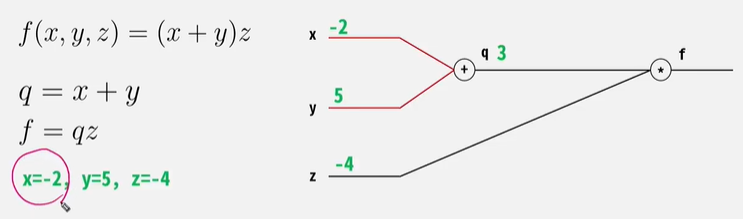

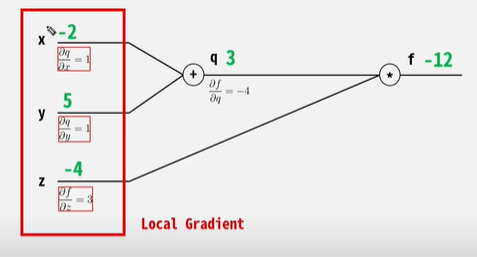

(1) Forward pass

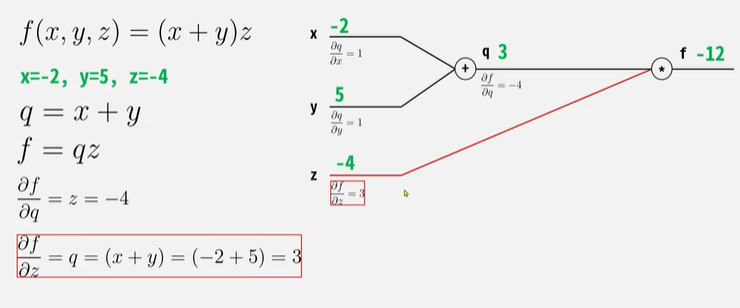

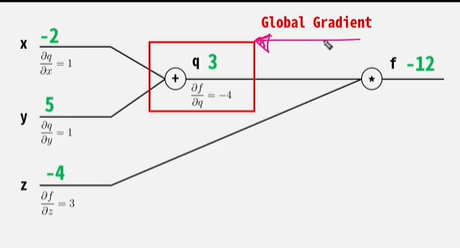

(2) Backward Pass

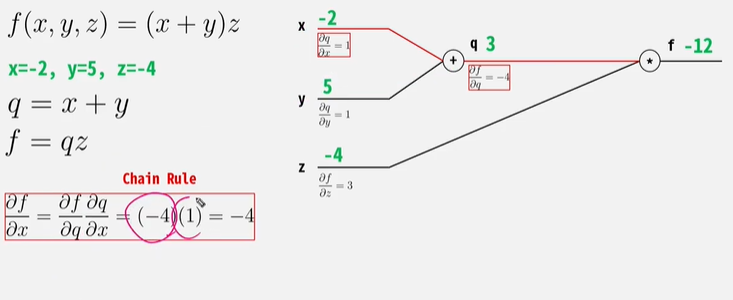

정리

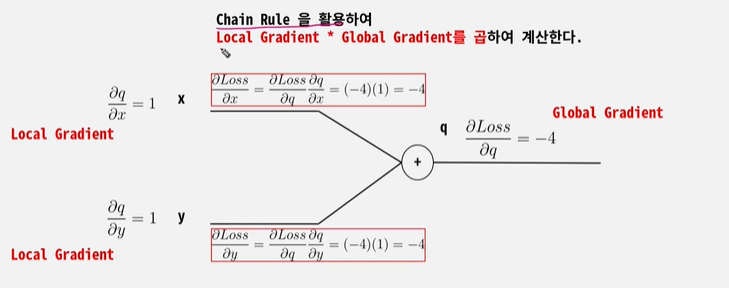

- 아무리 깊고 복잡한 층으로 구성되어 있다 하더라도 Chain Rule을 활용하여 미분 값을 얻어낼 수 있다.

- Forward Pass 시 Local Gradient를 미리 계산하여 저장해 둔다.

- 저장해둔 Local Gradient와 Global Gradient를 Backward Pass 시 곱하여 최종 미분값(=loss에 대한 미분값)을 얻는다.

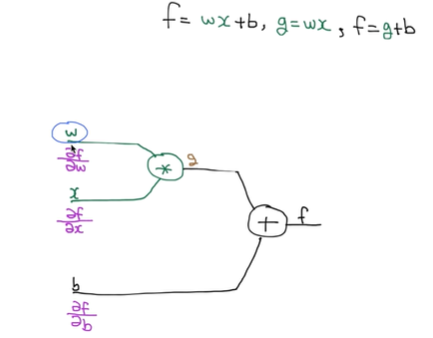

(?) 미분값을 구하는 이유 :

f를 w (f = wx+b, g=wx, f=g+b)에 대하여 편미분한다고 하면, 이는 w가 변할 때, f가 얼마나 변하는 지를 의미 즉, f가 w에 의해 받는 영향을 의미한다.

즉, 미분값을 구하는 이유는 각 노드에 의해 최종 출력값이 받는 영향을 구하기 위해서이다.