강의 제목 : 머신러닝 & AI 첫걸음 시작하기

2주차

- 단순선형회귀분석을 이해하고 회귀모수를 추정할 수 있다.

- 다중선형회귀분석을 이해하고 회귀모수를 추정할 수 있다.

- 선형회귀분석 결과를 해석하고 검정할 수 있다.

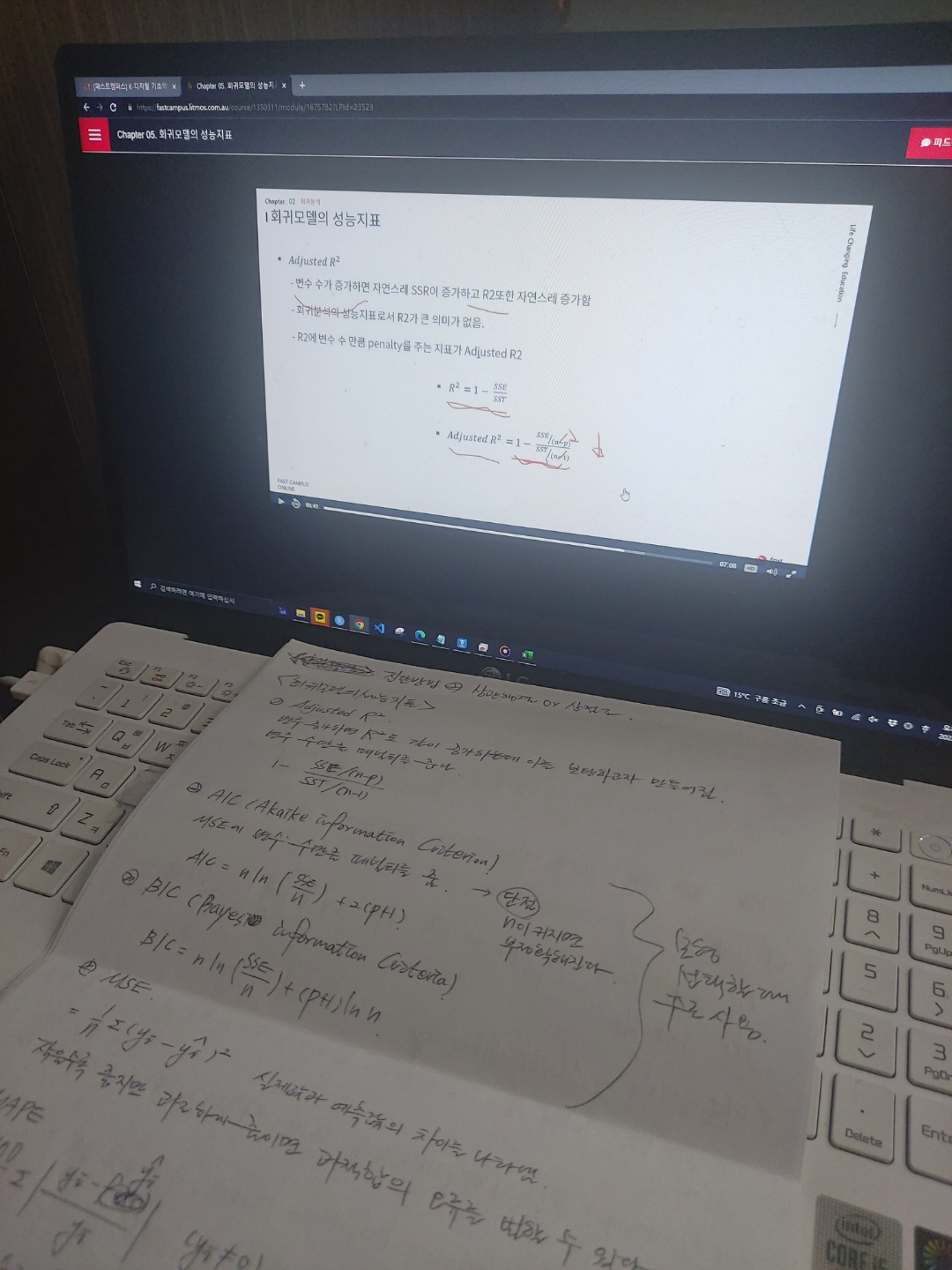

- 회귀모형의 성능지표를 이용하여 모형의 성능을 파악하고 비교할 수 있다.

- 회귀분석의 기본 가정을 이해하고 가정이 맞는지 확인할 수 있다.

- 변수 선택의 중요성을 이해하고, 여러 방법들을 설명할 수 있다.

1. 선형 회귀분석

-

단순선형회귀분석 (Simple Linear Regression)

&&

y = \beta_0 + \beta_1 x_1 + \epsilon

&& -

다중선형회귀분석 (Multiple Linear Regresion)

&&

y = X\boldsymbol{\beta} + \boldsymbol{\epsilon}

&&

1) 회귀분석의 기본가정

1) 오차항 가정: 오차항은 서로 독립이고 분산이 동일한 정규분포를 따른다.

2) 선형 가정: 독립변수와 종속변수는 서로 선형관계이다.

2) 회귀계수의 추정

- 잔차(Residual) : 실제 관측값 - 예측값

&&

e = y_i - \hat{y}_i

&& - 잔차를 최소화할 수 있는 를 추정해야 한다. -> 잔차제곱합 편미분 이용

&&

\beta_0 = \bar{y}-dd,,,

&&

3) 회귀모형 검정(F 검정)

- 귀무가설() :

대립가설() : not - 즉, 설명변수들이 종속변수를 설명하지 않는다를 귀무가설로 두는 것이다.

4) 회귀계수 유의성 검정(T 검정)

- 해석: 설명변수 가 한단위 증가할 때 값이 만큼 증가한다.

5) 회귀분석 주의할 점

(a) 다중공선성(Multicollinearity)

- 설명변수들 사이에 강한 상관관계가 있을 때 다중공선성이 있다고 한다.

- 다중공선성이 있으면, 잘못된 변수를 해석할 수도 있고, 예측의 정확도를 하락시킨다.

- VIF(분산팽창인자)가 10이 넘으면 다중공선성이 있다고 판단한다.

(b) 회귀분석의 기본 가정 확인

- 잔차의 분포를 그려 정규분포를 따르는지 확인한다.

- 잔차의 산점도를 그려본다.

- Q-Q plot을 통해 정규성을 확인한다.

- 잔차 대 예측값 그래프를 확인한다.

(c) 회귀분석의 기본 가정이 위배되었을 때

- 값에 로그 또는 루트를 씌운다.

- 이상치를 제거한다.

- 다항회귀분석을 해 본다. (고차원일 경우에는 과적합이 쉽게 발생할 수 있으니 주의해야 한다.)

5) 변수선택

- 전체 변수를 사용하는 것보다 최적의 변수조합을 발견하고 필요한 변수만 사용하는 것이 효율적이다.

- 일발적인 방법: 전진선택법, 후진제거법, Stepwise

2. 로지스틱 회귀분석

- 종속변수가 연속형이 아닌 이항형일때 할 수 있는 회귀방법

- 성공을 1, 실패를 0이라고 할 때 성공할 확률에 대해 모델링한다.

- 로짓 함수

- 로지스틱 함수

- 해석 : 설명변수 가 한 단위 늘어났을 때 성공할 확률이 실패할 확률보다 배 크다.

3. 회귀계수 축소법 (Ridge, Lasso, ElasticNet)

- 다음에 다시 정리하자.

느낀점

이번주는 너무 바빴다 ㅜㅜ 반성하자.

회귀분석을 다시 복습할 수 있어서 좋았다.

Ridge, Lasso 등은 다시 완벽하게 복습해야할 것 같다.