한국어 뉴스 댓글 데이터

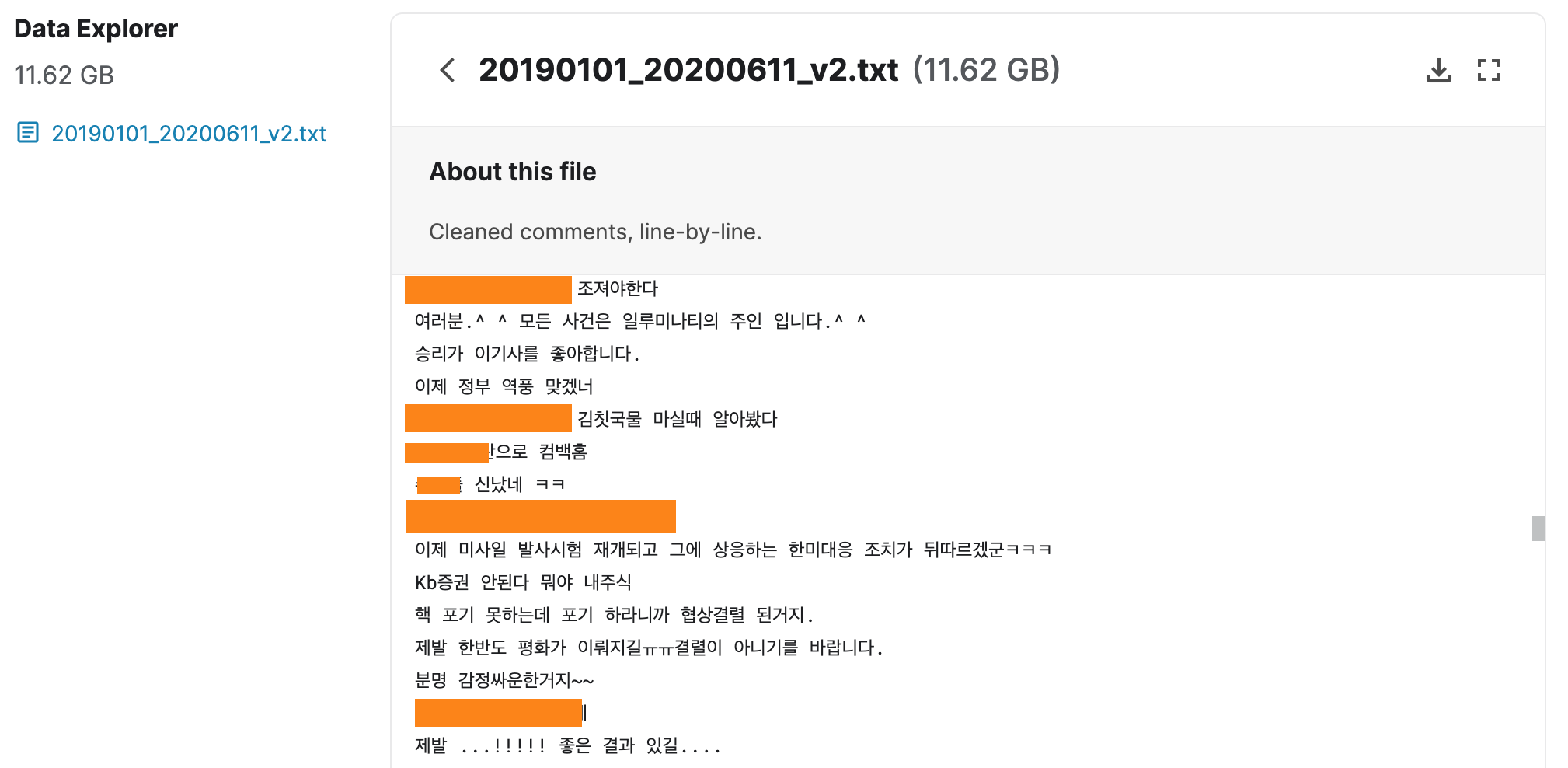

한국어 뉴스 데이터로 사전 학습한 BERT인 KcBERT를 학습시킨 데이터를 캐글에 공개해주셨다.

12GB의 데이터로 필요에 따라 다운로드 후 활용 가능하다.

댓글이 한줄한줄씩 되어있는데, 무난한 내용이 미리보기에는 안보이네요;;;

데이터 경로

데이터 정제 방법

import re

import emoji

from soynlp.normalizer import repeat_normalize

emojis = ''.join(emoji.UNICODE_EMOJI.keys())

pattern = re.compile(f'[^ .,?!/@$%~%·∼()\x00-\x7Fㄱ-힣{emojis}]+')

url_pattern = re.compile(

r'https?:\/\/(www\.)?[-a-zA-Z0-9@:%._\+~#=]{1,256}\.[a-zA-Z0-9()]{1,6}\b([-a-zA-Z0-9()@:%_\+.~#?&//=]*)')

def clean(x):

x = pattern.sub(' ', x)

x = url_pattern.sub('', x)

x = x.strip()

x = repeat_normalize(x, num_repeats=2)

return x