Citation

@article{craswell2020orcas,

title={ORCAS: 18 Million Clicked Query-Document Pairs for Analyzing Search},

author={Craswell, Nick and Campos, Daniel and Mitra, Bhaskar and Yilmaz, Emine and Billerbeck, Bodo},

journal={arXiv preprint arXiv:2006.05324},

year={2020}

}

Abstract

- document ranking과 passage ranking에서 대량의 Train Data를 이용할 수 있을 때, 어떤 방법이 가장 좋은지에 대한 연구 내용이다.

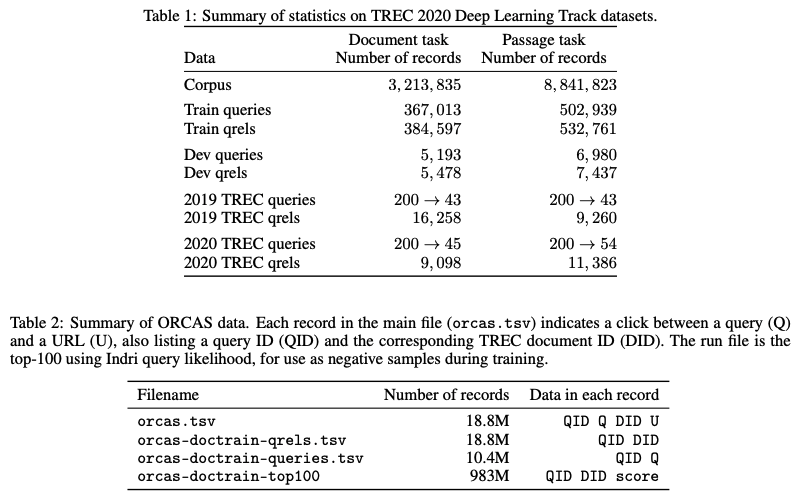

Document Ranking Task

- 367,013개의 쿼리와 3,213,835개의 문서로 구성

- [3] Perfectly relevant, [2] Highly relevant, [1] Relevant, [0] Irrelevant

- Binary의 경우 : [3] Perfectly relevant + [2] Highly relevant + [1] Relevant / [0] Irrelevant

Full Ranking Subtask

- 제공된 전체 문서 집합에서 질문과의 관련성에 따라 문서의 순위를 매긴다. 최대 100개의 문서에 대한 순위를 매길 수 있다.

Re-Ranking Subtask

- a telescoping architecture [Matveeva et al., 2006, Wang et al., 2011]를 통해서 100개의 문서에 대한 초기 순위가 제공되며, 질문과의 관련성에 따라 문서의 순위를 매긴다. 100명의 작업자들이 순위를 매김.

Passage Ranking Task

- 1,010,916개의 쿼리와 8,841,823개의 구절로 구성

- [3] Perfectly relevant, [2] Highly relevant, [1] Relevant, [0] Irrelevant

- Binary의 경우 : [3] Perfectly relevant + [2] Highly relevant / [1] Relevant + [0] Irrelevant

Full Ranking Subtask

- 질문이 주어졌을 때, 질문에 대한 답변이 포함될 여부에 따라 구절의 순위를 매진다. 최대 1,000개의 구절에 대한 순위를 매길 수 있다.

Re-Ranking Subtask

- BM25를 통해서 1,000개의 구절에 대한 초기 순위가 제공되며, 질문에 대한 답변이 포함될 가능성에 따라 구절의 순위를 매긴다.