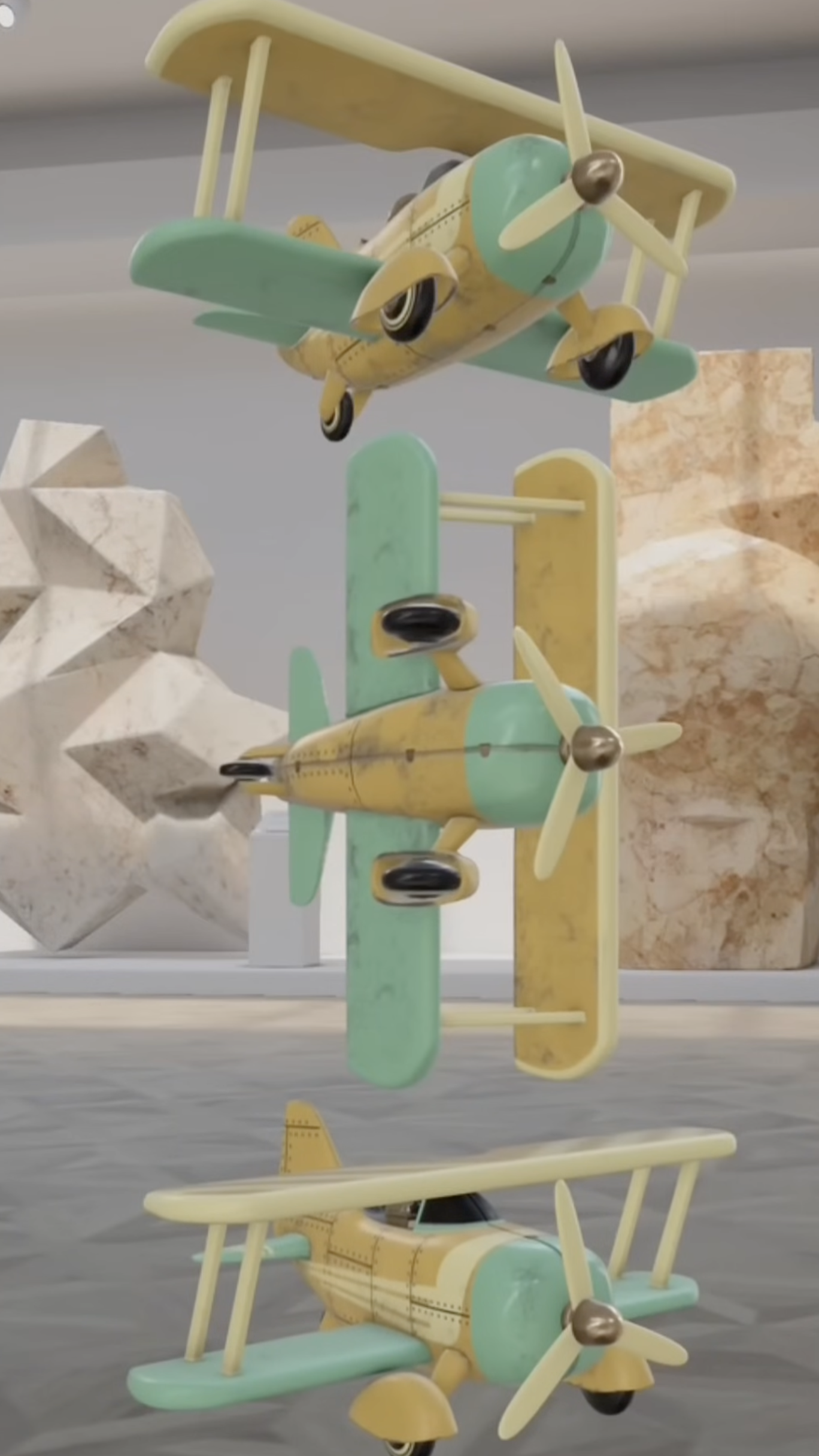

Volumetric features

SwiftUI에 새로 추가된 기능들로 인해 더 놀라운 Volumetric 경험을 제공해 줄 수 있다.

이렇게 depth align이 가능해서

이렇게 가독성을 높일수도 있고

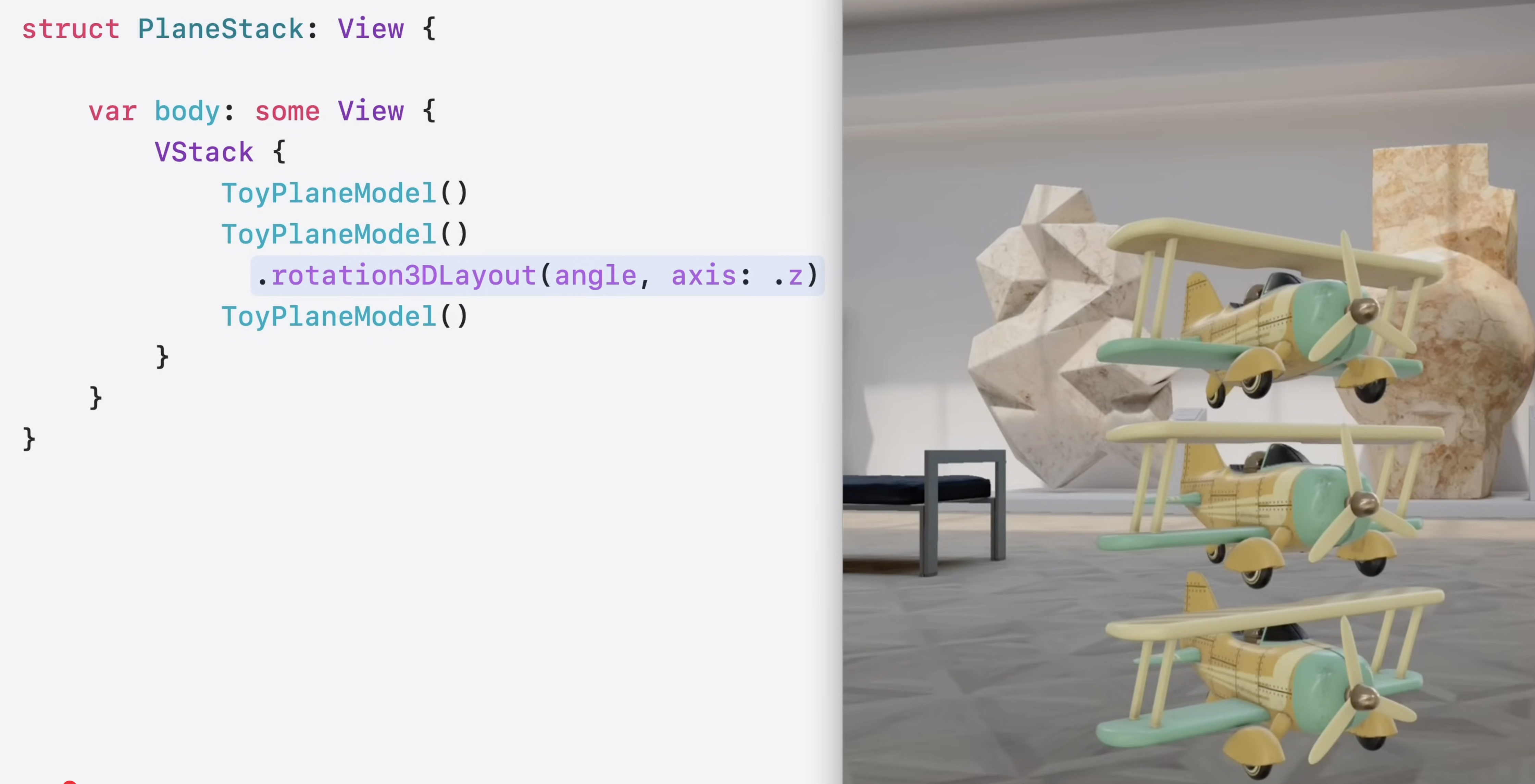

앱에서 3D object를 회전시키려면

이렇게 rotation3DLayout 모디파이어를 통해서 회전시킬수도 있다.

더 많은 것은 Meet SwiftUI spatial layout 비디오를 살펴봐라.

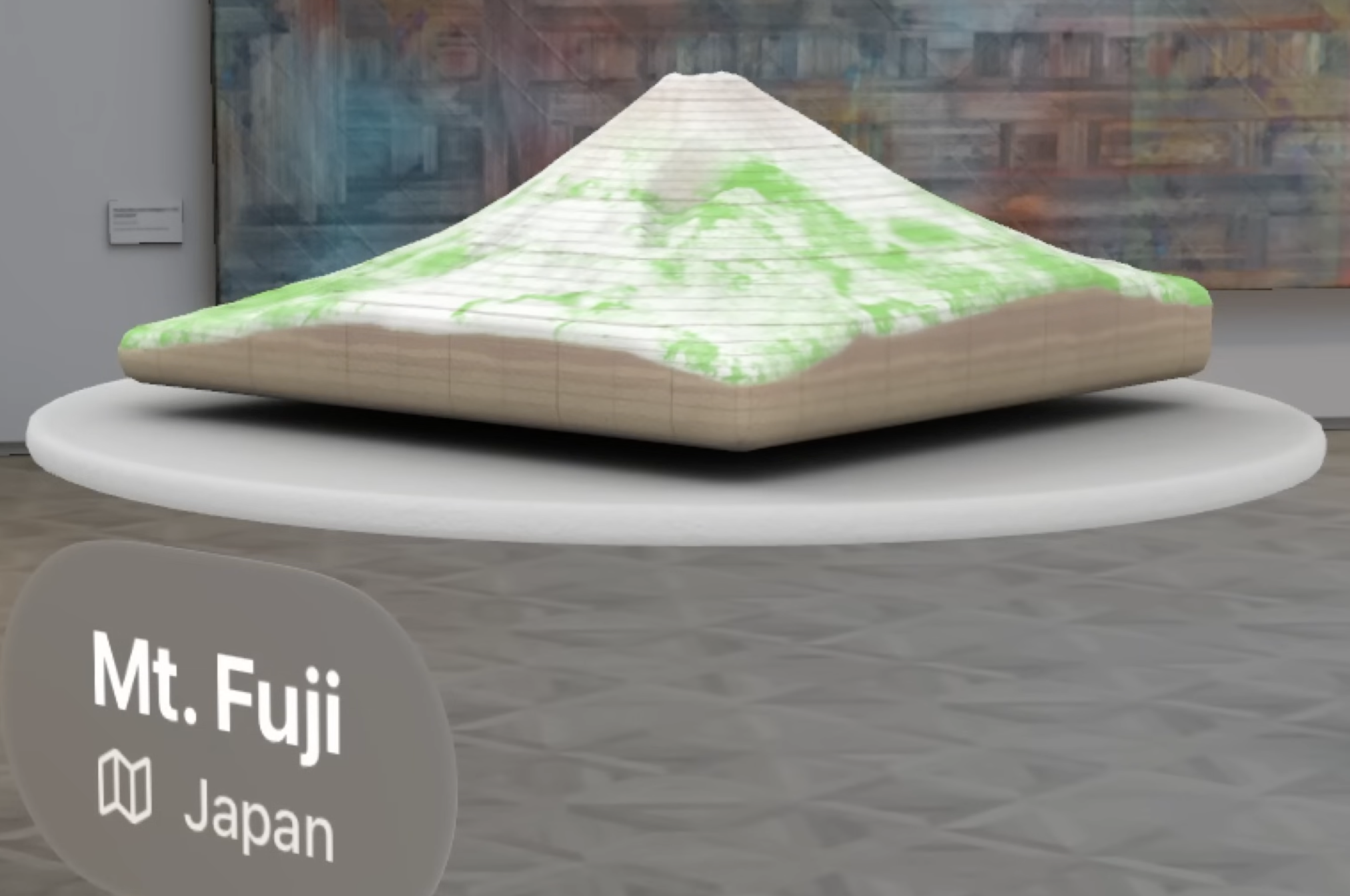

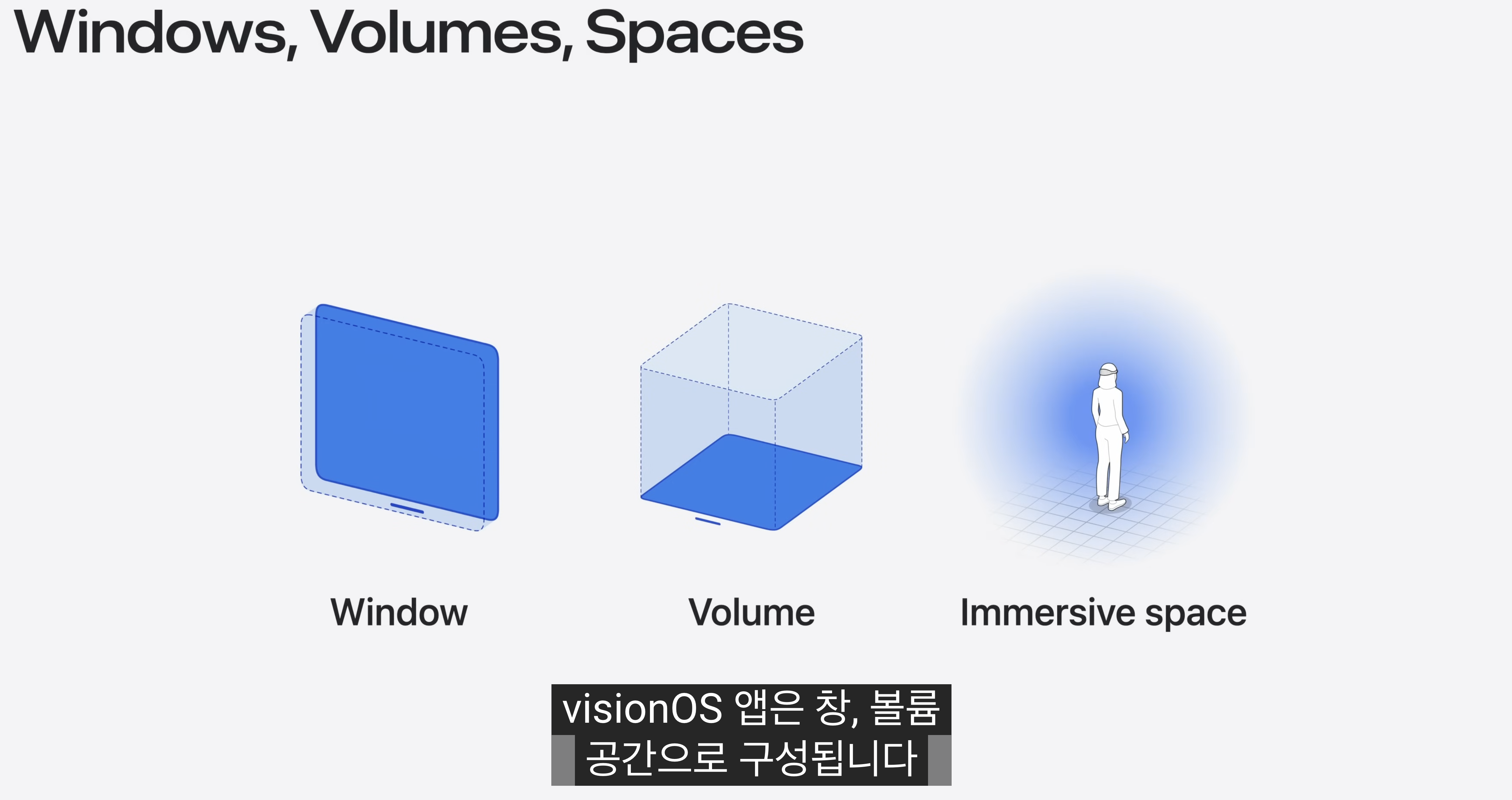

Windows, Volumes, Spaces

특히 volumetric experience는 shared space에서 매력적이다.

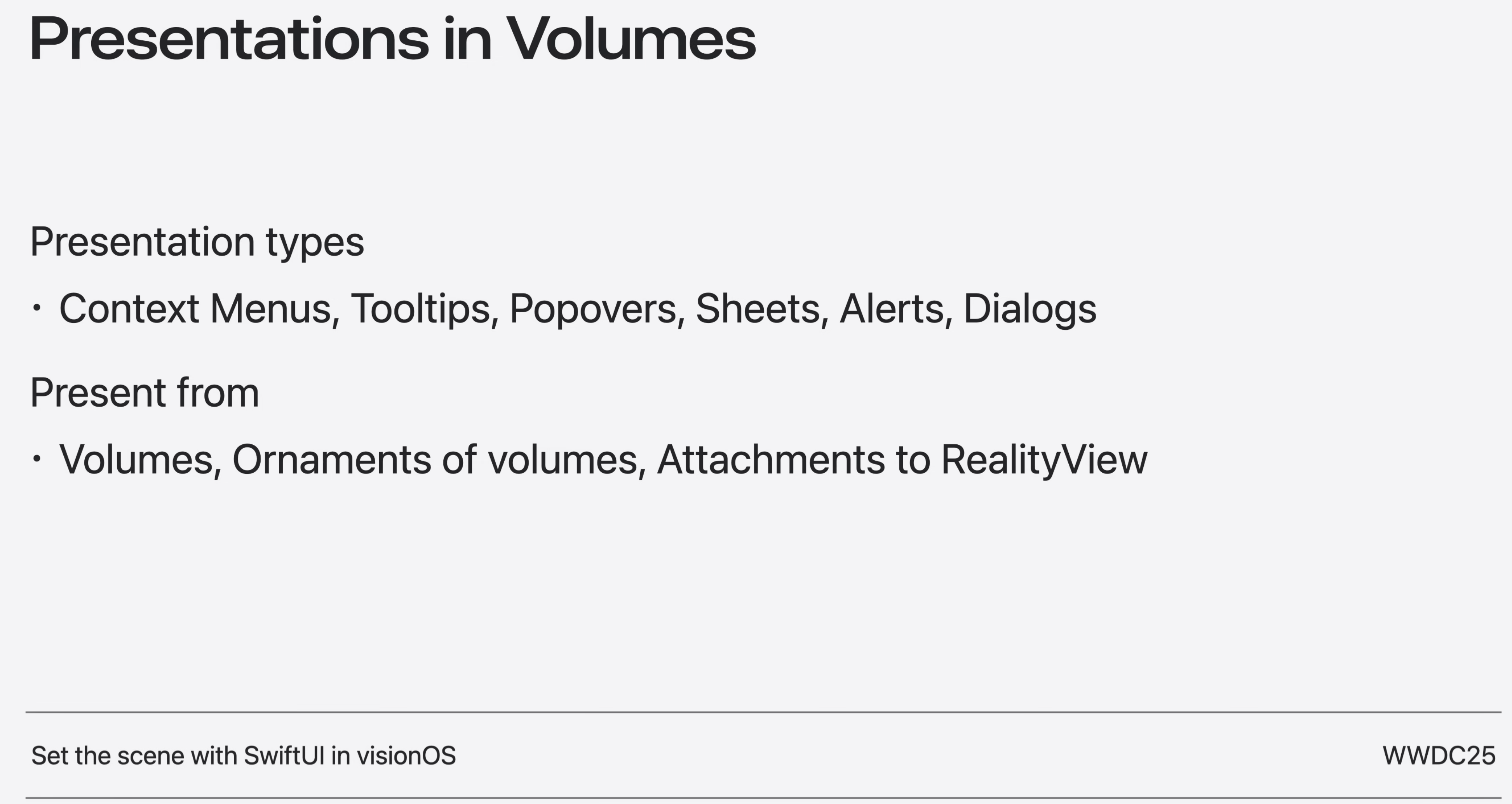

알림, 시트, 메뉴, 팝오버도 볼륨 내부와 볼륨 위에 표시하는 것이 가능해졌다.

window와 volume은 앱의 UI와 콘텐츠를 제한하는 컨테이너 역할을 하며, shared space에서 콘텐츠를 표시하고 상호 작용할 수 있는 정의된 영역을 제공한다.

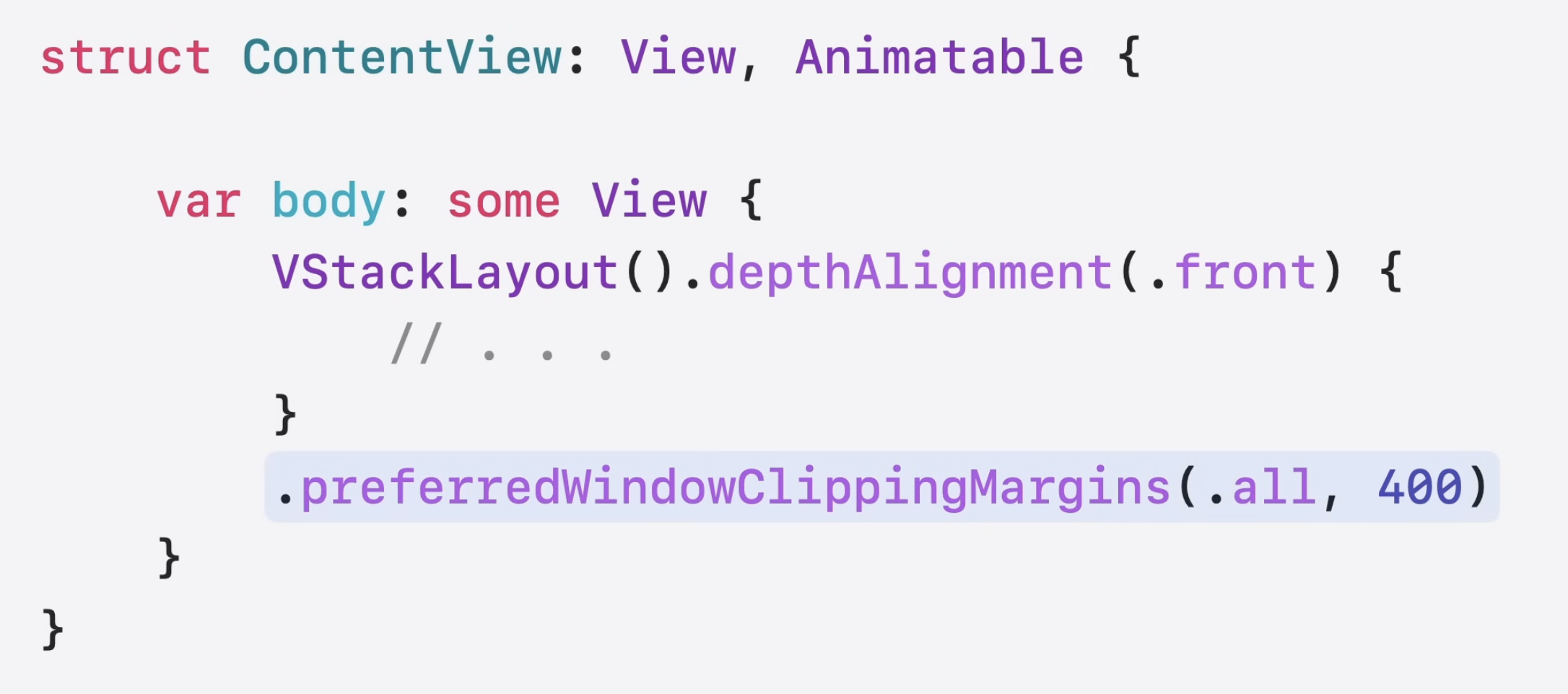

이제 dynamic bounds restriction을 구성하면 실제 세상과 앱이 더 자연스럽게 blend될 수 있다.

간단하게 이 효과를 적용할 수 있으며, 콘텐츠가 경계 밖으로 얼마나 많이 드러나도록 할지 지정할 수 있다. 이를 통해 앱의 크기를 바꾸지 않고도 앱의 몰입도를 높일 수 있다.

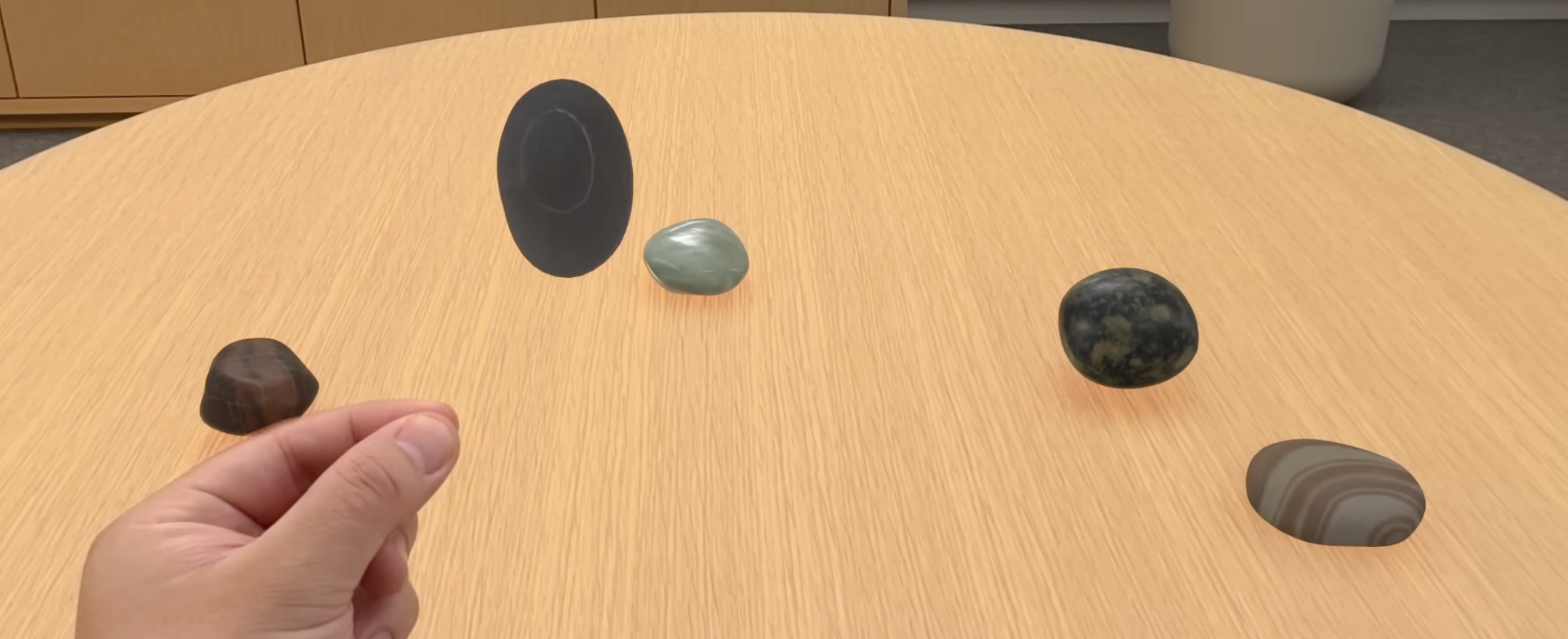

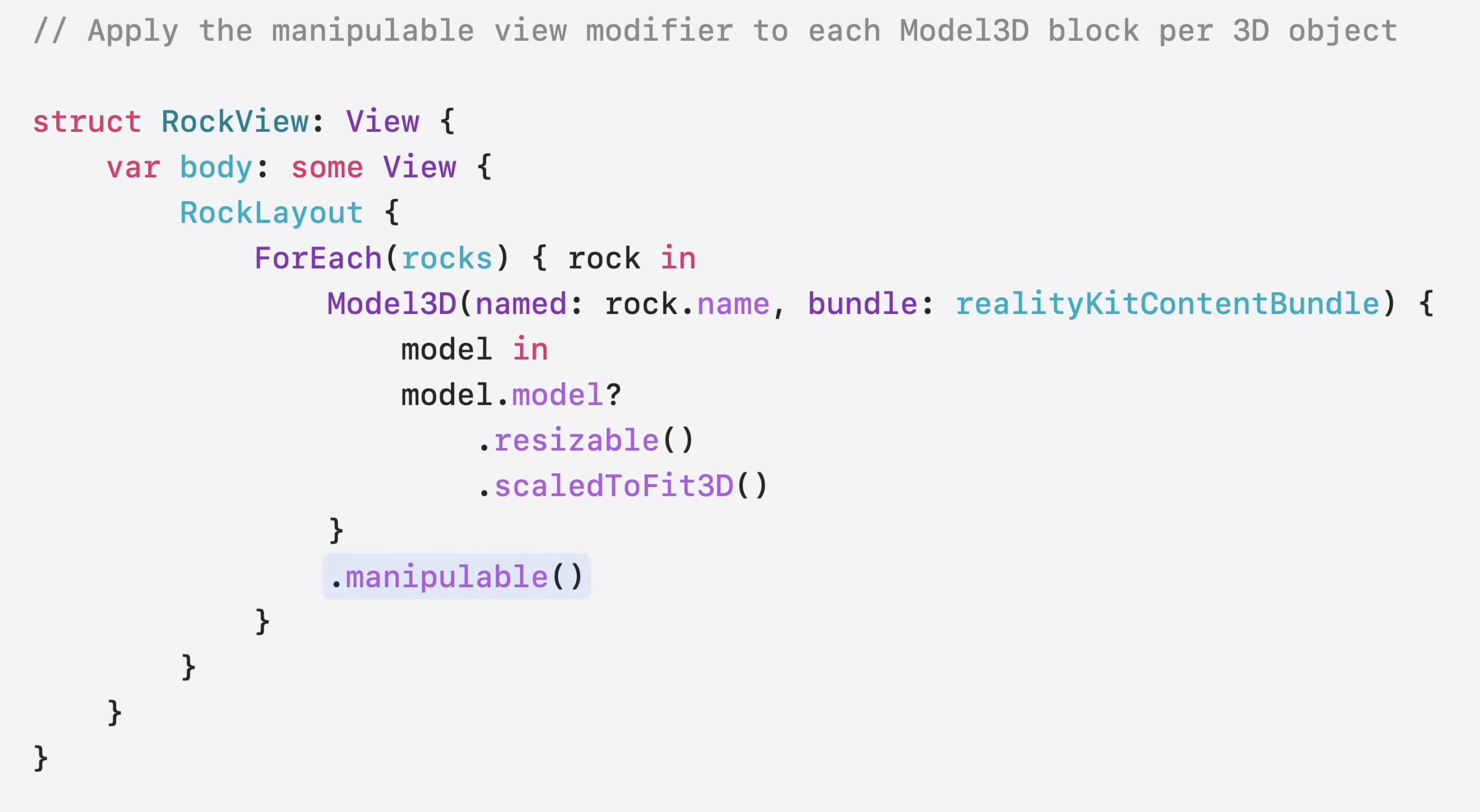

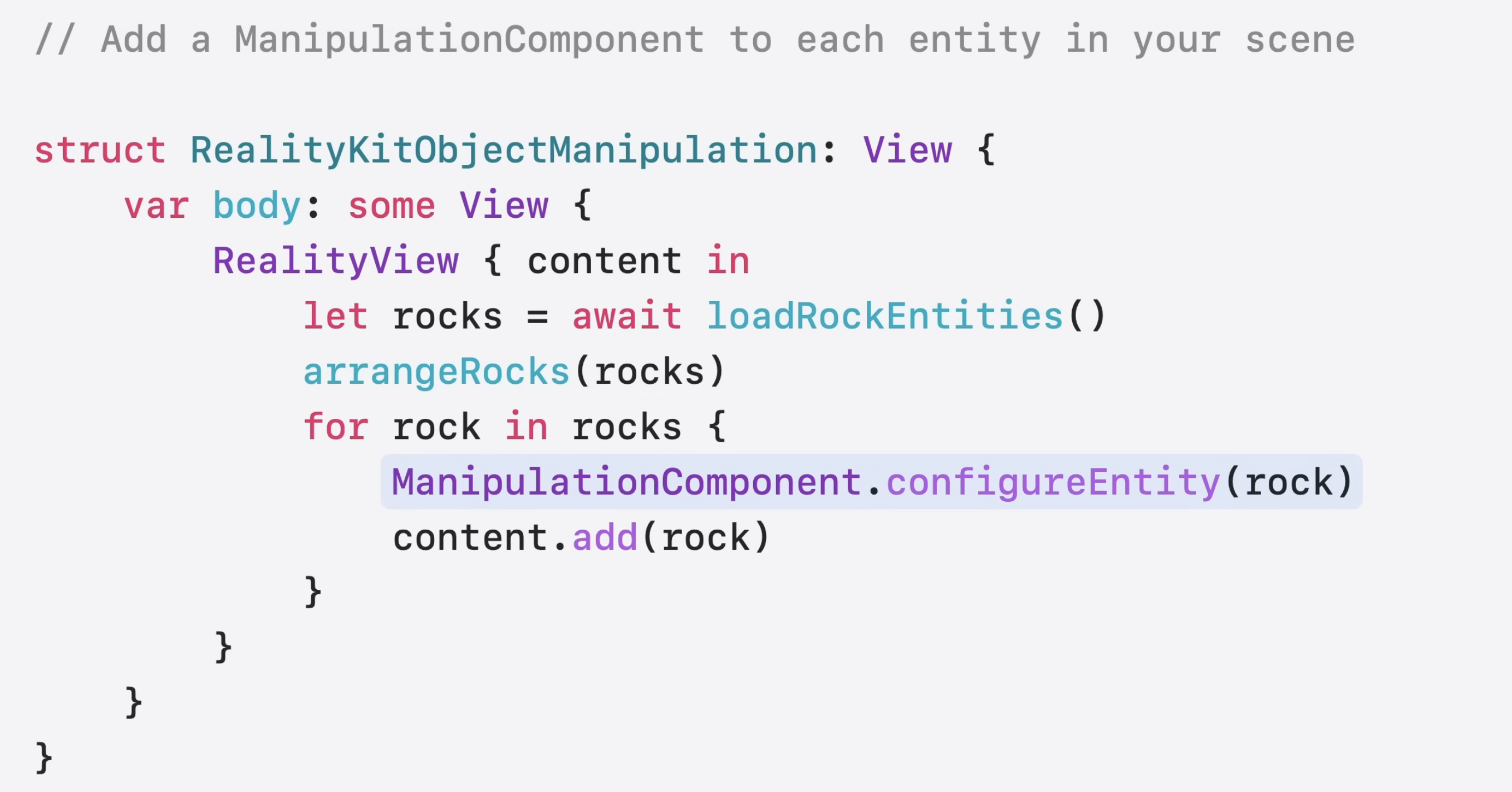

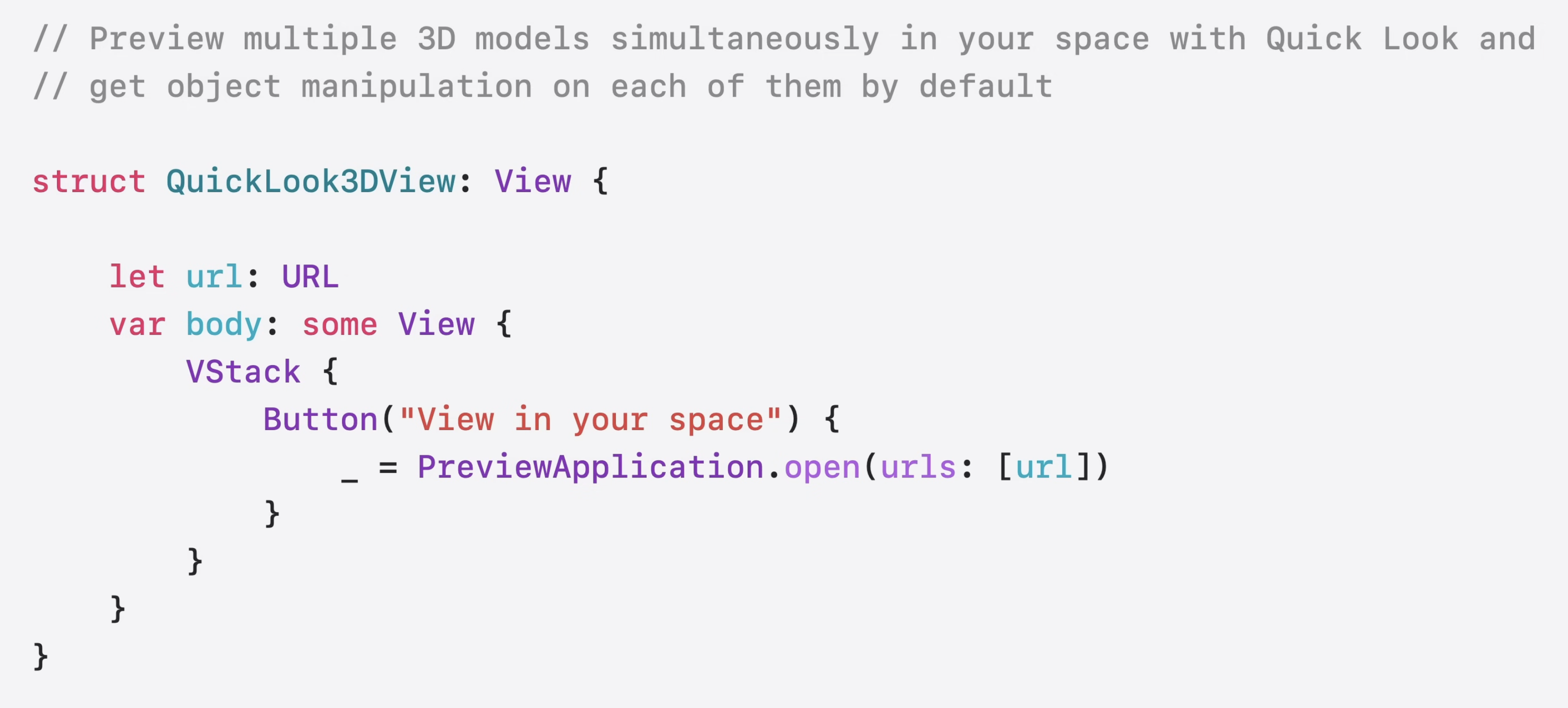

virtual objcet와의 상호 작용은 현실 세계를 모방하여 자연스럽게 느껴져야 한다. 이제 마치 실제 물건을 쥐고 있는 것처럼 직관적으로 물체를 회전시킬 수 있다. Quick Look과 통합해서 공간 내에서 3D 콘텐츠를 조작하고 위치를 조정하는 작업이 훨씬 더 원활하게 이루어진다. (04:55)

이 modifier를 통해 손 쉽게 적용할 수 있다.

RealityKit에서는 ManipulationComponent를 사용하면 된다.

Quick Look API를 사용하는 경우에는 기본적으로 조작이 가능하다.

visionOS에서 앱을 빌드하는 데 사용할 수 있는 familiar framework가 많이 있다.

그 중 SwiftUI는 앱의 기반과 사용자 인터페이스 요소를 제공한다.

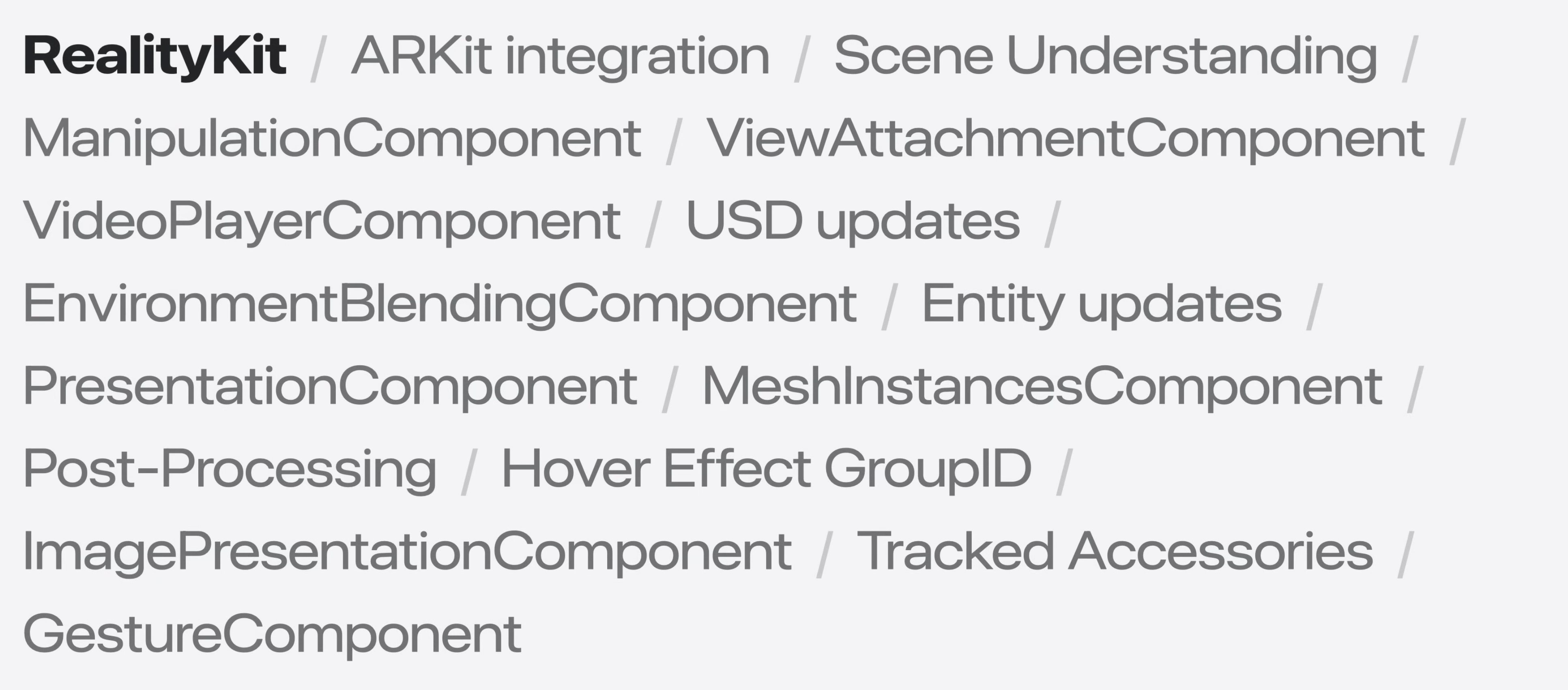

RealityKit은 3D 콘텐츠를 선보이는 가장 좋은 방법이다.

ARKit은 실제 세계 환경에 대한 풍부한 맥락적 정보를 제공한다.

이제 새로운 API 세트가 franework간의 통합을 강화한다.

Unified Coordinate Conversion API

통합 좌표 변환 API를 사용하면 뷰와 엔터티를 장면 간에 간편하게 이동할 수 있으며, 뷰와 ARKit accessory anchor간에도 가능하다.

이를 통해 SwiftUI, RealityKit, ARKit의 좌표 공간에서 빌드 할 때 콘텐츠 배치가 대폭 간소화 된다.

RealityKit의 Entity와 애니메이션은 관찰이 가능하기에, SwiftUI 뷰에서 직접 사용할 수 있다.

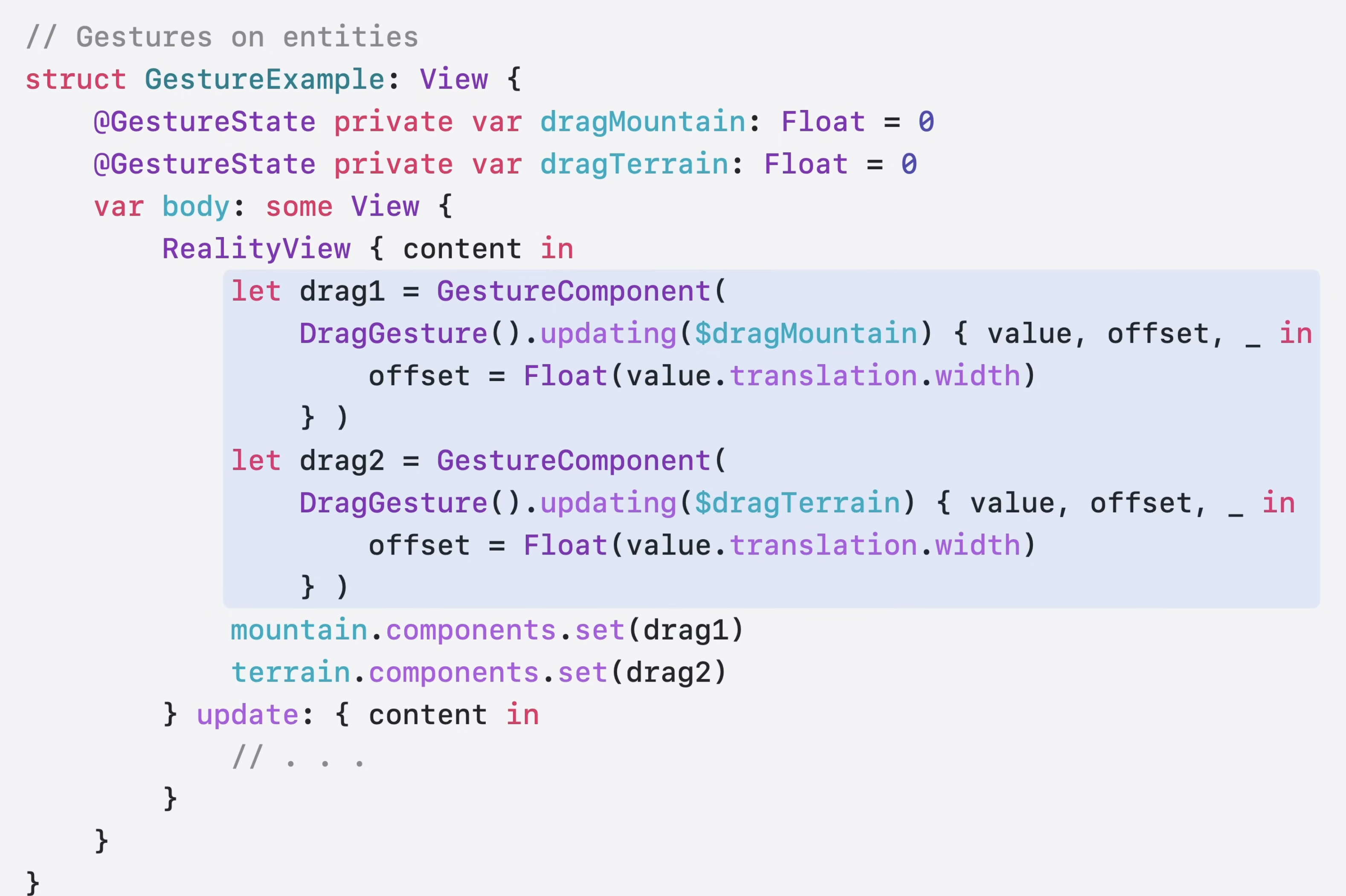

RealityView를 중개자로 사용하지 않고도 제스처를 RealityKit entity에 직접 첨부할 수 있다. SwiftUI 제스처를 엔터티에 직접 사용하면 플랫폼과 프레임워크 전반에 걸ㄹ쳐 제스처 처리를 더욱 통합하는 보다 일관되고 powerful한 API surface가 생성된다.

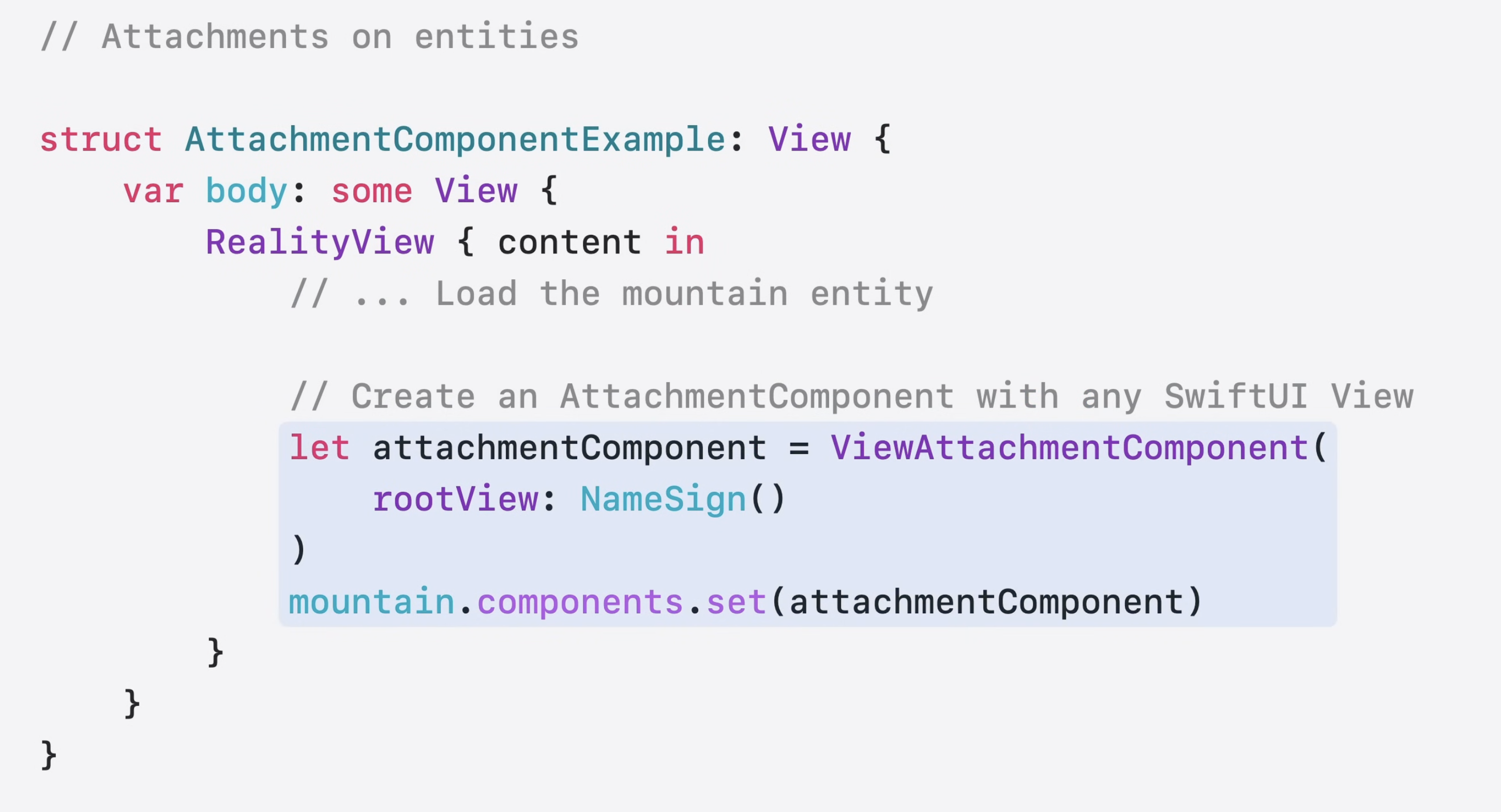

visionOS 1에서는 SwiftUI View를 attachment를 통해 RealityKit 장면에 추가하곤 했다. 이제 ViewAttachmentComponent를 통해 RealityKit 코드의 나머지 부분과 함께 UI를 인라인으로 작성이 가능하다. 더 이상 attachment를 미리 만들 필요가 없고 원하는대로 장면에 구성 요소로 추가할 수 있다.

Model3D에서 이제 애니메이셔 재생, 정지 등이 가능해졌고 USD 파일에서 variants를 선택하고 .reality 파일에서 configuration을 로드하여 선택할 수 있다.

3D 콘텐츠를 빛나게 하거나 반짝반짝하게 만들고 싶다면 RealityView가 필요하다.

RealityView는 layout system과 원활하게 작동하며 realityViewSizingBehavior Modifier를 사용할 수 있다. 이를 통해 RealityView의 크기를 3D 콘텐츠에 맞춰 조정할 때 flexibility를 얻을 수 있다.

이 외에 다른 사항은

이 비디오를 봐라.

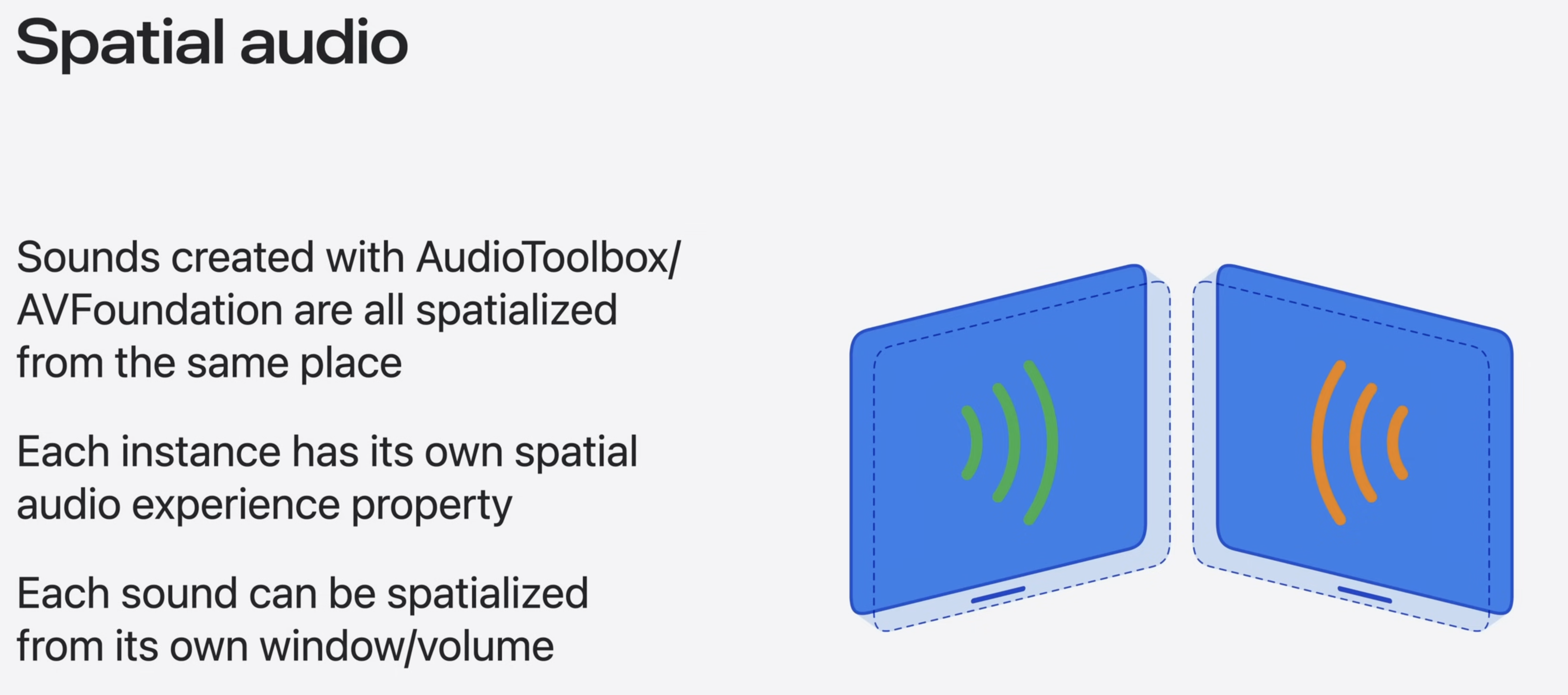

이전에 visionOS에서는 사운드가 앱의 첫번째 window에서 공간화 되었다.

새로운 Spatial Audio Experience API를 이용하면 각 소리를 별도의 window나 volume에서 spatialize 할 수 있다. 그리고 장면 간에 사운드를 원활하게 옮길 수도 있다.

RealityKit의 성능도 업데이트 되어서 현실과 더욱 자연스럽게 융합이 되었는데, Environment Occlusion(폐색)을 사용하여 가상 객체가 정적인 실체 객체로 가려지는 효과를 얻을 수 있다. (09:09) 이는 pin Widget과 Quick Look 3D model에 자동으로 적용된다.

그리고 EnvironmentBlendingComponent를 엔터티에 추가하면 Immersive RealityKit 앱에 이러한 동작을 적용할 수 있다.

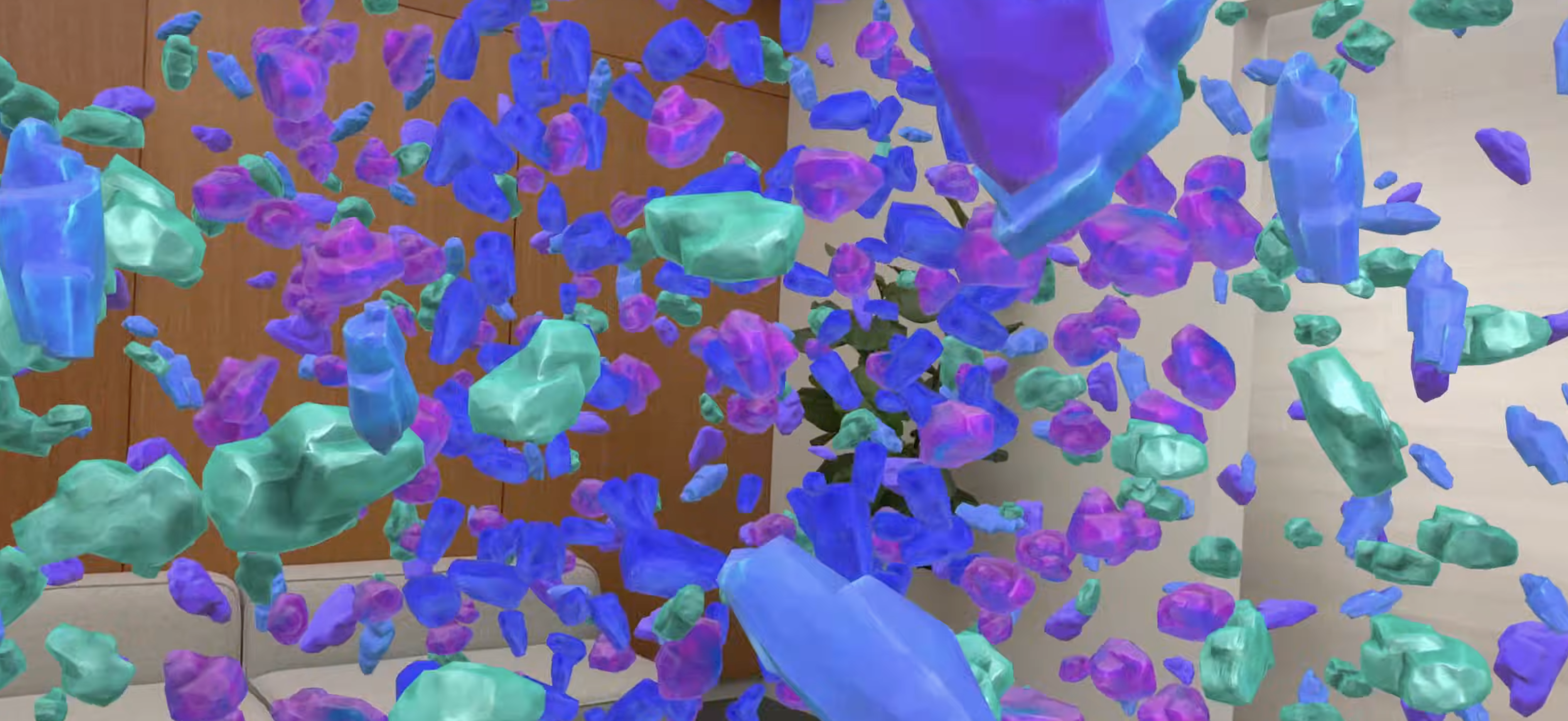

또 다른 멋진 기능은 다양한 고유한 asset 변형을 효과적으로 그릴 수 있는 새로운MeshInstancesComponent이다.

이 샘플은 단 5개의 고유한 asset에서 파생된 1000개의 unique한 asset을 랜더링하고 애니메이션화하는 방법을 보여준다. AV1 이미지 파일 형식의 텍스처를 지원하여 quality와 performance를 향상 시킬 수 있다. (09:38)

새로운 ImagePresentationComponent를 통해 scene understanding update, entity update, 그리고 새로운 유형의 이미지 등 많은 기능을 추가하고 있다.

RealityKit으로 어떻게 게임 만드는지 보려면 이 샘플을 다운 받아라.

System features

지속적으로 발전 중.

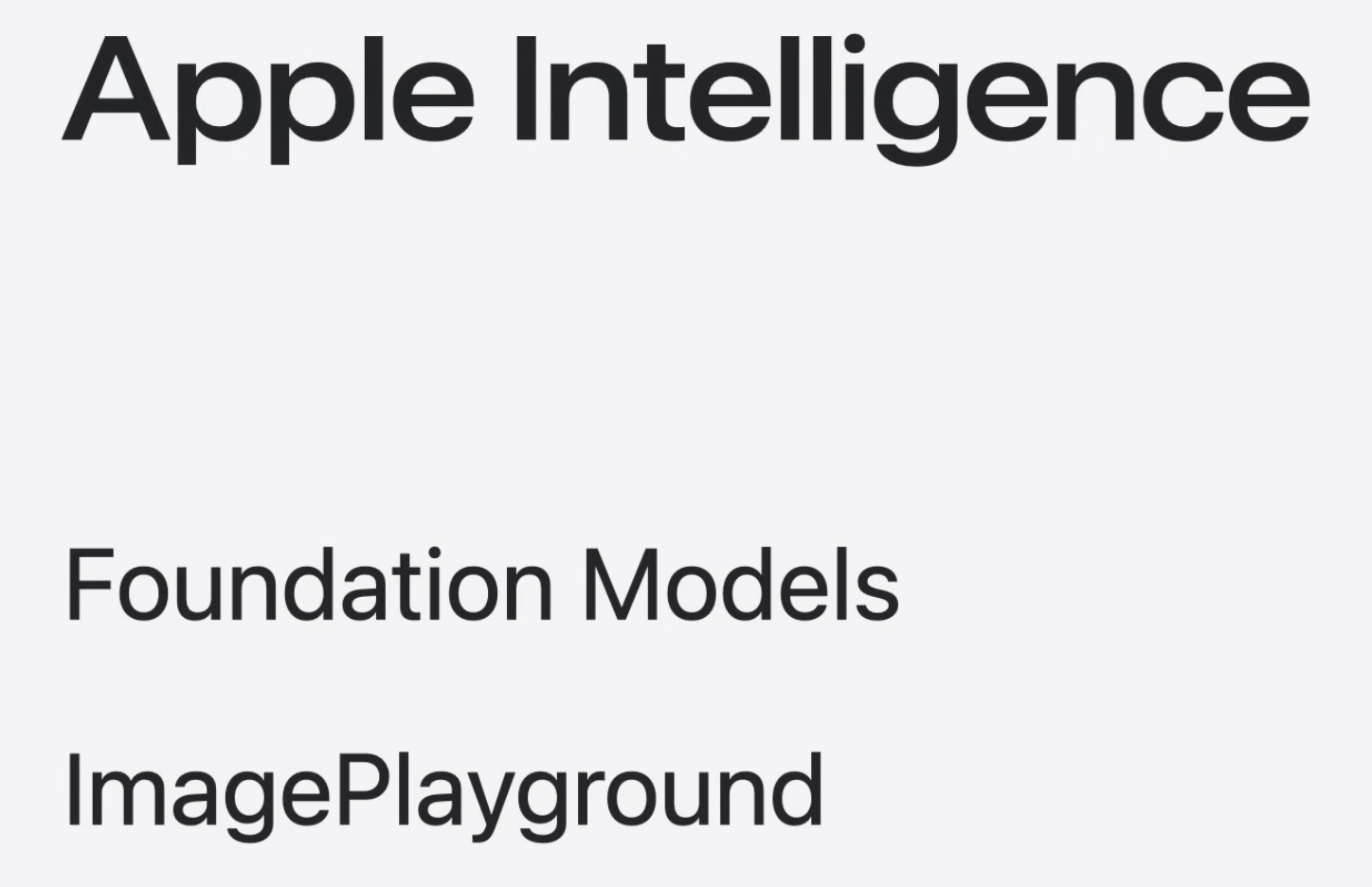

새로운 Foundation Model 프레임워크를 사용하면 많은 Apple Intelligence 기능의 핵심인 기기 내 LLM 모델에 접근 할 수 있다.

Guided generation을 사용하면 구조화된 출력을 생성할 수 있고,

Tool calling을 통해 모델이 코드에서 정의한 작업을 자율적으로 수행할 수 있다.

visionOS 2.4에서는 image Playground for visionOS를 출시.

SpeechAnalyzer라는 새로운 stt도 출시된다.

SpeechAnalyzer는 Swift의 힘을 활용하여 최첨단 stt로 변환 기술을 제공하는 고급 음성 인식 기술이다. 이 기술은 노트, facetime 실시간 자막 등 다양한 시스템 앱의 기능에 적용되고 있다. SpeechAnalyzer를 사용하면 이러한 흥미로운 기능을 앱에 쉽게 구현할 수 있다.

또한 새로은 음성-텍스트 모델인 SpeechTranscriber도 출시된.이전 새대보다 빠르고 유연해서 미디어 캡션 작성과 같은 까다로운 필사 작업에 이상적이다. SpeechAnalyzer는는 전적으로 기기에서 실행되므로 사용자의 데이터는 완벽하게 비공개로 유지된다.

이제 Quick Look의 window, scene, 심지어 2D나 3D콘속 지속되어 재시작 후에도 같은 위치에 다시 나타난다.

SwiftUI의 restoration API를 사용하면 복원할 수 있는 장면을 지정할 수 있고 snap surface에 반응할 수도 있다.

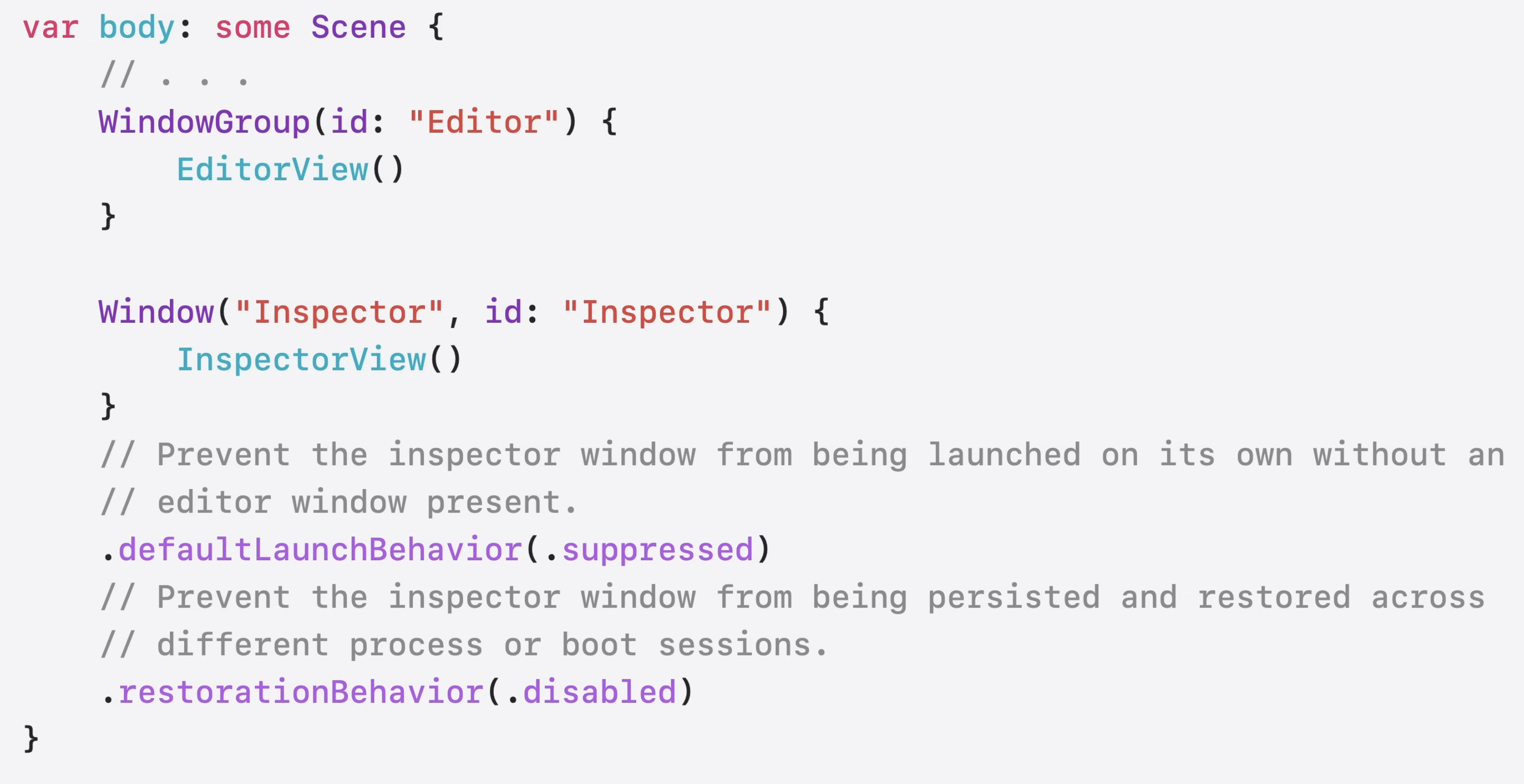

예를 들어, 앱에서 Inspector window 같은 window에 접근하면 이제는 시작 시에 생성을 억제 하고 복원을 비활성화 하도록 플래그를 지정할 수도 있다. 이러한 API와 새로운 snapping enironment property를 사용하면 앱을 공간에 맞춰 배치하고, 표면 유형에 따라 콘텐츠를 동적으로 변경하며 다음에 앱이 space에 방문할 때 적절한 window 세트를 제공할 수 있다.

그리고 이러한 behavior를 새로운 종류의 콘텐츠에도 적용하고 있다.

위젯

위젯은 개인화된 정보를 제공하는 가벼운 앱 확장 프로그램인데 벽이나 테이블에 부착되어서 주변 환경에 자연스럽게 어울리며 배치한 위치에 그대로 유지된다.

visionOS에서는 WidgetKit과 SwiftUI를 사용해서 iOS 및 iPadOS용으로 작성된 위젯이 더욱 멋지게 보인다.

위젯은 깊이와 차원을 활용하여 새로운 시각적 처리를 자동으로 적용하여 따로 변경할 사항이 없다.

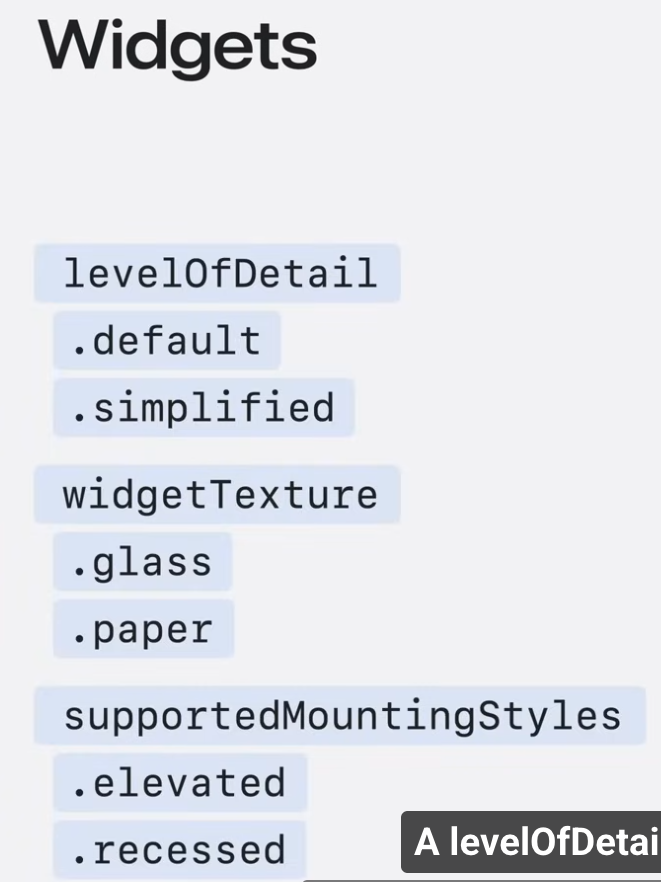

추가 API도 도입될 예정인데, 위젯은 사용자 공간 내에서 가상 객체로 존재하므로 다양한 거리에서 위젯과 interact가 가능하다.

levelOfDetail API를 사용하면 user proximity에 따라 대체 보기를 표시할 수 있어서 위젯에 적절한 양의 정보만 표시된다.

또한 widgetTexture API를 추가해서 위젯의 모양을 유리에서 종이로 바꿀 수 있게 되었다.

Games and spatial accessories

비전프로에서 손과 눈을 사용한 입력은 사용자가 content와 interact하는 주요 방법이다. visionOS26에서는 최대 3배 빠른 hand tracking을 지원한다. 이를 통해 추가 코드 없이도 게임의 반응성이 향상된다.

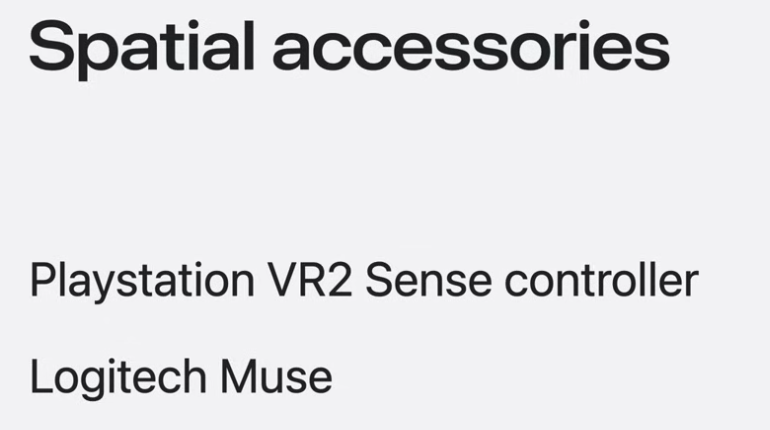

또한 visionOS에서 완전히 새로운 input 매커니즘을 제공하는 두가지 spatial accessory도 도입된다.

이 spatial controller는 게임에 적합하다. 6 degrees of freedom으로 무선 추적이 가능하고 hand breakthrough와 system naivigation을 지원하고 tap out of the box와 같은 시스템 수준의 제스처도 지원한다.

이러한 새로운 기능을 통해 더 많은 새로운 경험들을 제공할 수 있게 되었다. (16:22)

그림 그리기나 조작과 같은 정밀한 작업이 필요한 공간적 경험의 경우에는 Logitech Muse를 사용할 수 있는데, 4개의 센서를 통해 팁과 측면 버튼에 다양한 입력을 할 수 있으며, 앱에 통합하기 위한 촉각 피드백도 가능하다.

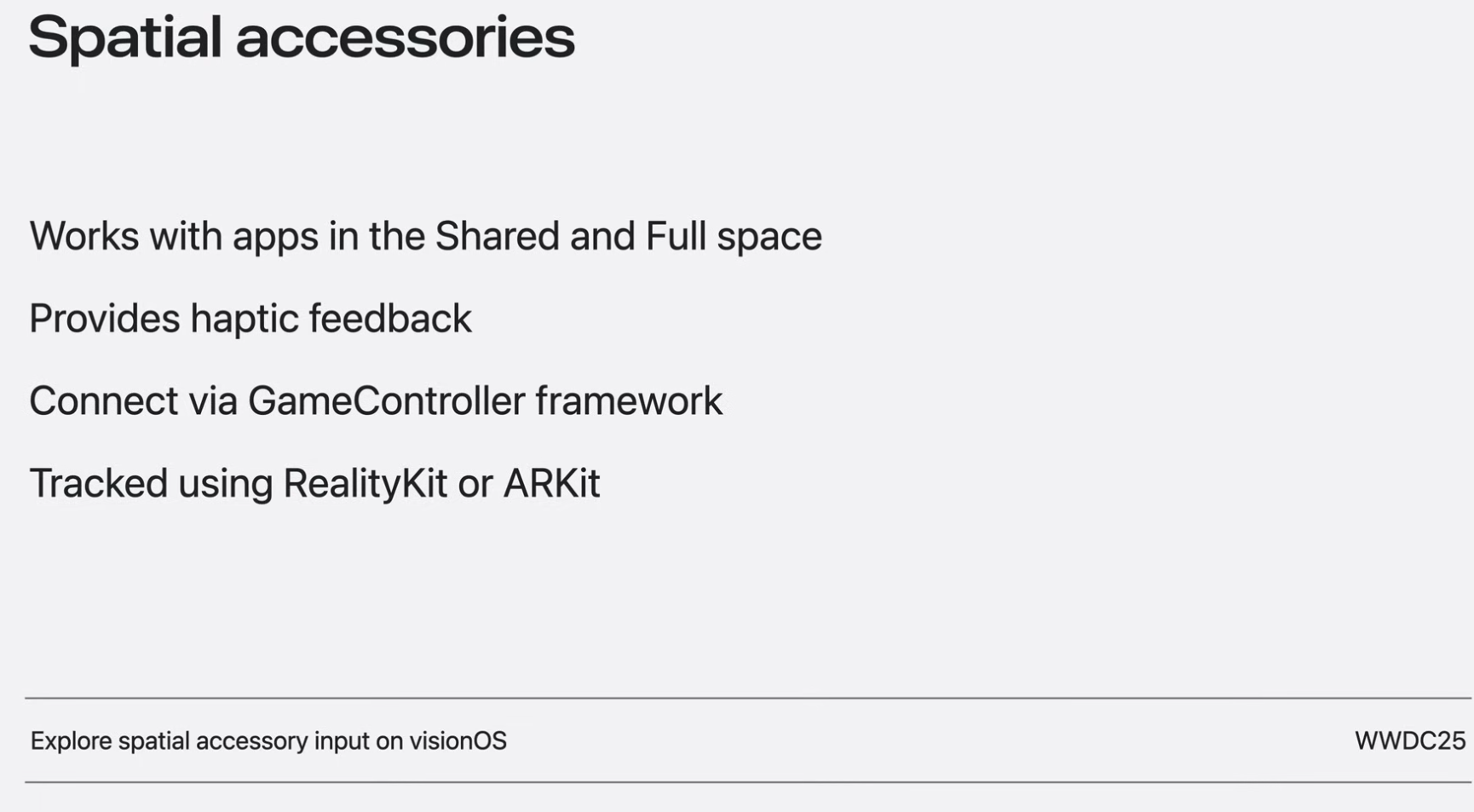

이러한 공간 액세서리는 하나 이상의 앱을 열어 놓은 상태에서 작동한다. 또한 몰입도를 높이기 위해 촉각적 피드백을 제공하고 GameController framework를 사용하여 bluetooth 연결을 찾을 수 있다.

또한 tracking을 위해 Metal 및 Compositor Service와 함께 사용자 지정 렌더러를 사용하는 경우 RealityKit이나 ARKit을 사용할 수 있다.

visionOS에서 메모리 한도 지원이 새롭게 확대되면서 App Store Connect를 사용하여 하이엔드 iPad 게임을 Vision Pro로 가져올 수 있다.

visionOS SDK를 기반으로 기존 게임을 빌드하면 추가 코드가 거의 없이 Vision Pro의 고해상도 디스플레이와 기본 제공 게임 컨트롤러 지원 기능을 활용할 수 있다.

Native framework로 개발하는 경우 progressive immersion style을 사용하면 기존 iOS 앱과 게임에 더 많은 차원을 부여할 수 있다.

이를 통해 immersion 범위를 맞춤 설정할 수 있고, 사람들이 현실 세계에 집중하는 동시에 점진적으로 몰입형 경험을 제공할 수 있는 매력적인 방법이다. visionOS에서 작동하도록 재컴파일된 기존 iPhone 또는 iPad 게임에 적합하다.

올해에는 새로운 가로 및 세로 종횡비를 지원하기 위해 progressive immersion style을 확장했는데, 움직임이 많은 게임을 선보이는 데 이상적이다.

SwiftUI와 RealityKit을 사용하면 이 두 가지 새로운 처리 방식을 모두 활용할 수 있다.

그리고 자체 Metal 랜더링 엔진을 visionOS에 도입하는 경우, progressive immersion style을 Compositor Services로 확장할 수 있다.

Compositor Services를 사용하면 자체 Metal 엔진을 visionOS에 적용하여 full, mixed, progressive style로 몰입형 공간에 랜더링 할 수 있다.

Compositor Services에 두 가지 새로운 기능을 추가했는데, hover effect와 dynamic render quality이다.

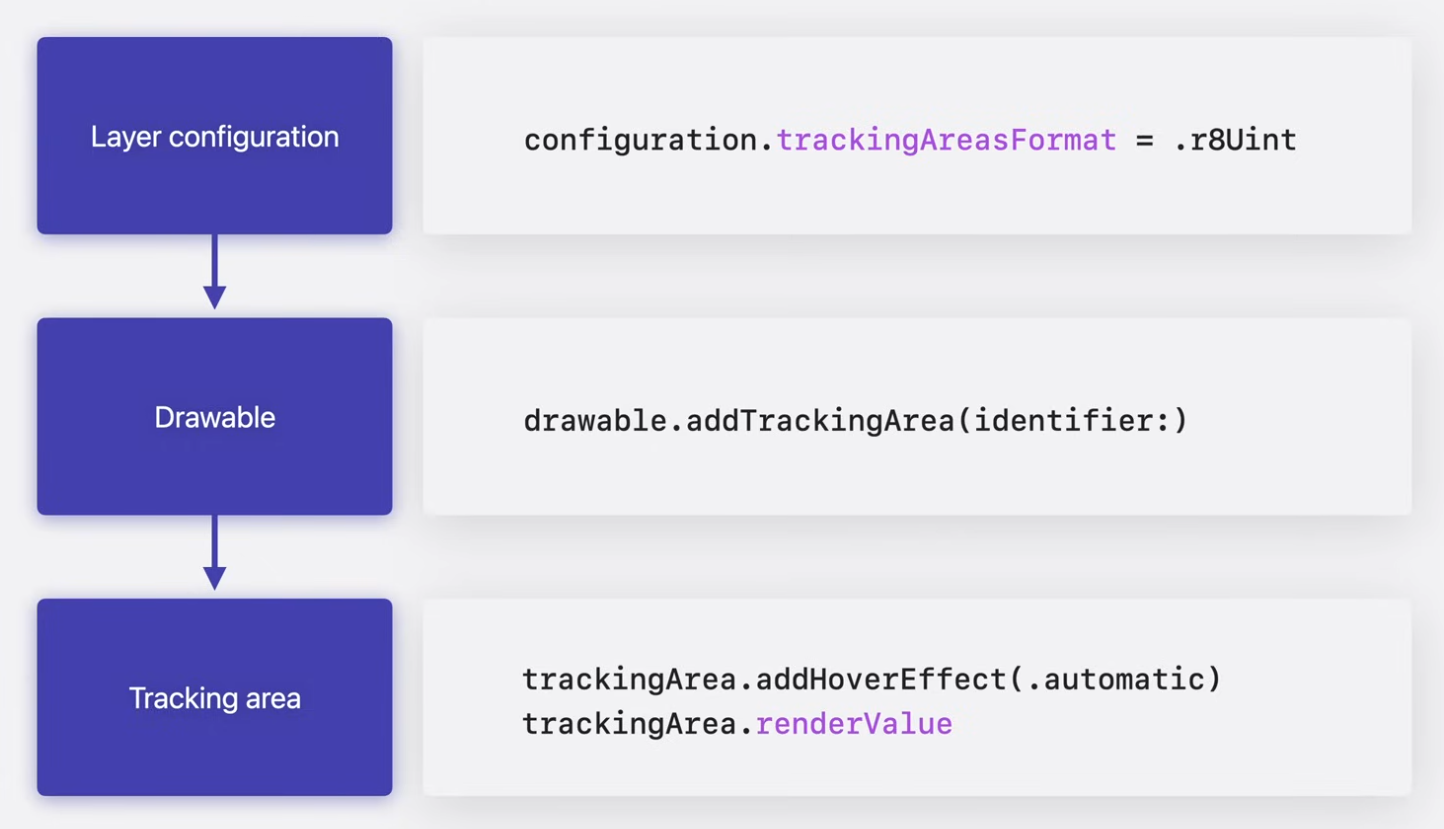

hover effect는 사용자가 앱 내의 대화영 요소를 볼 때 highlight effect를 추가하여 상호 작용을 향상시킨다. 올해에는 Metal immersive 앱에 privacy를 보호하는 호버 효과 지원을 활성화 할 예정이다.

이 기능을 사용하려면 tracking area의 texture 형식을 구성하고 drawable에 tracking area를 추가한 다음 tracking area에 hover effect를 구성하고 렌더 값을 그려야 한다.

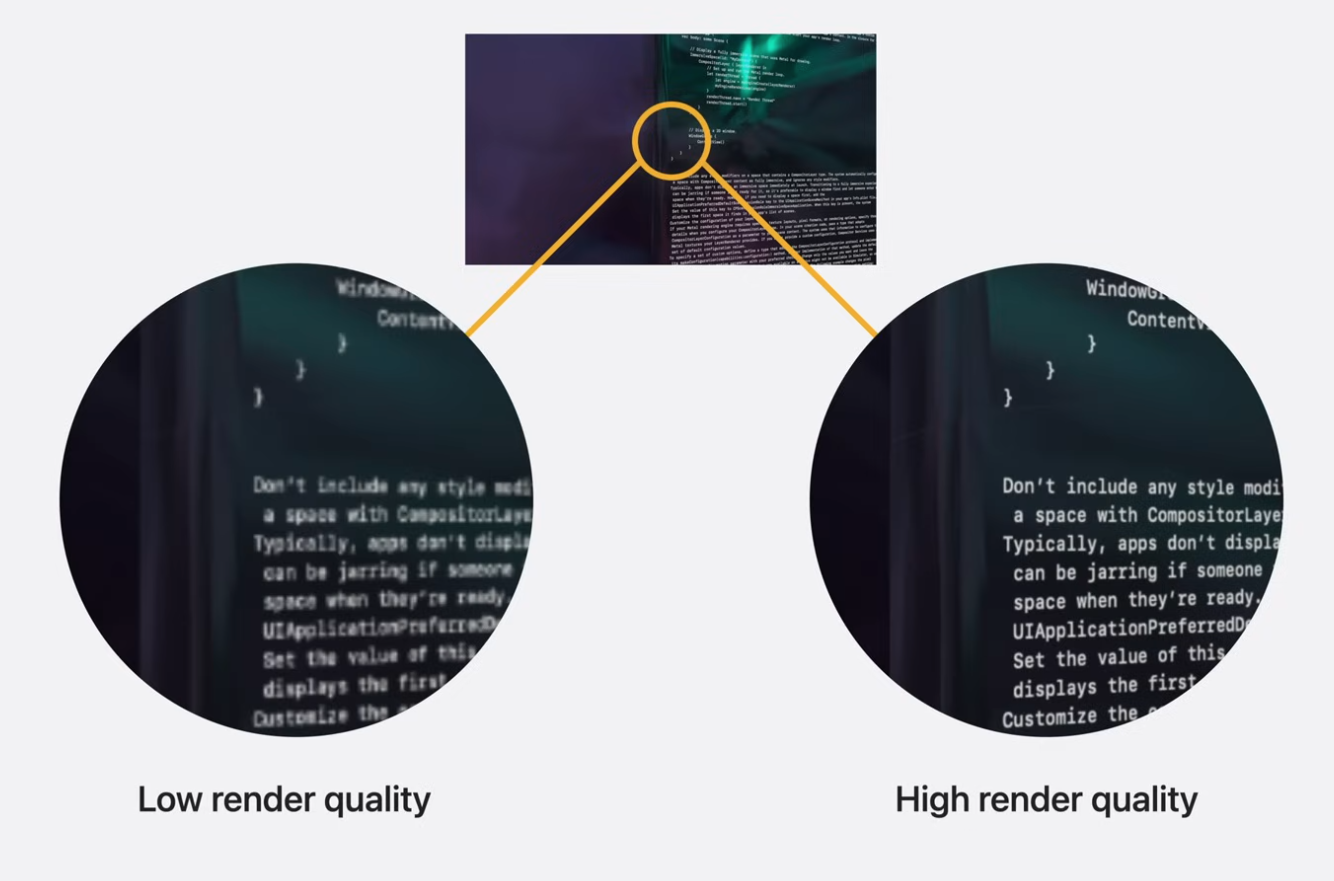

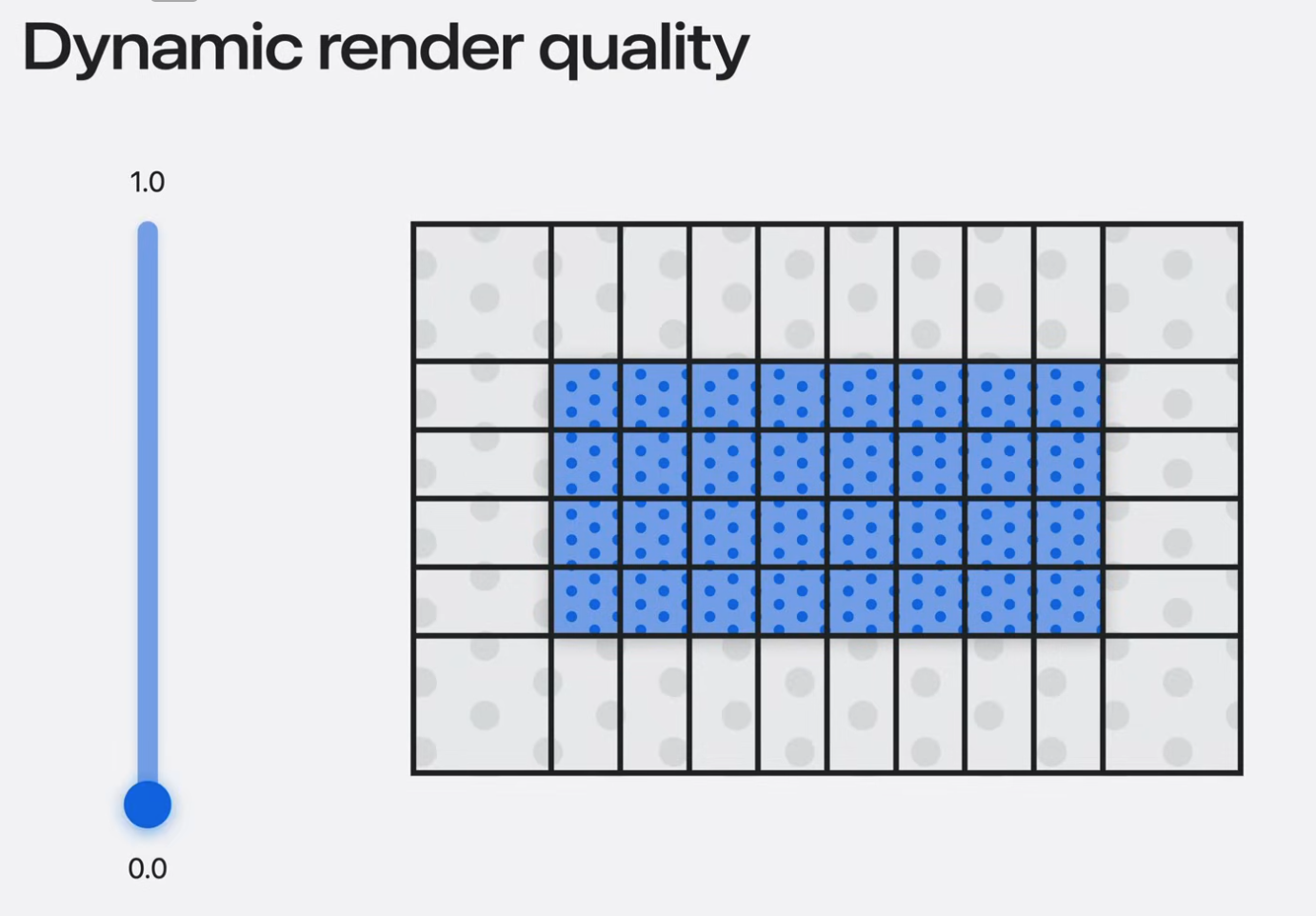

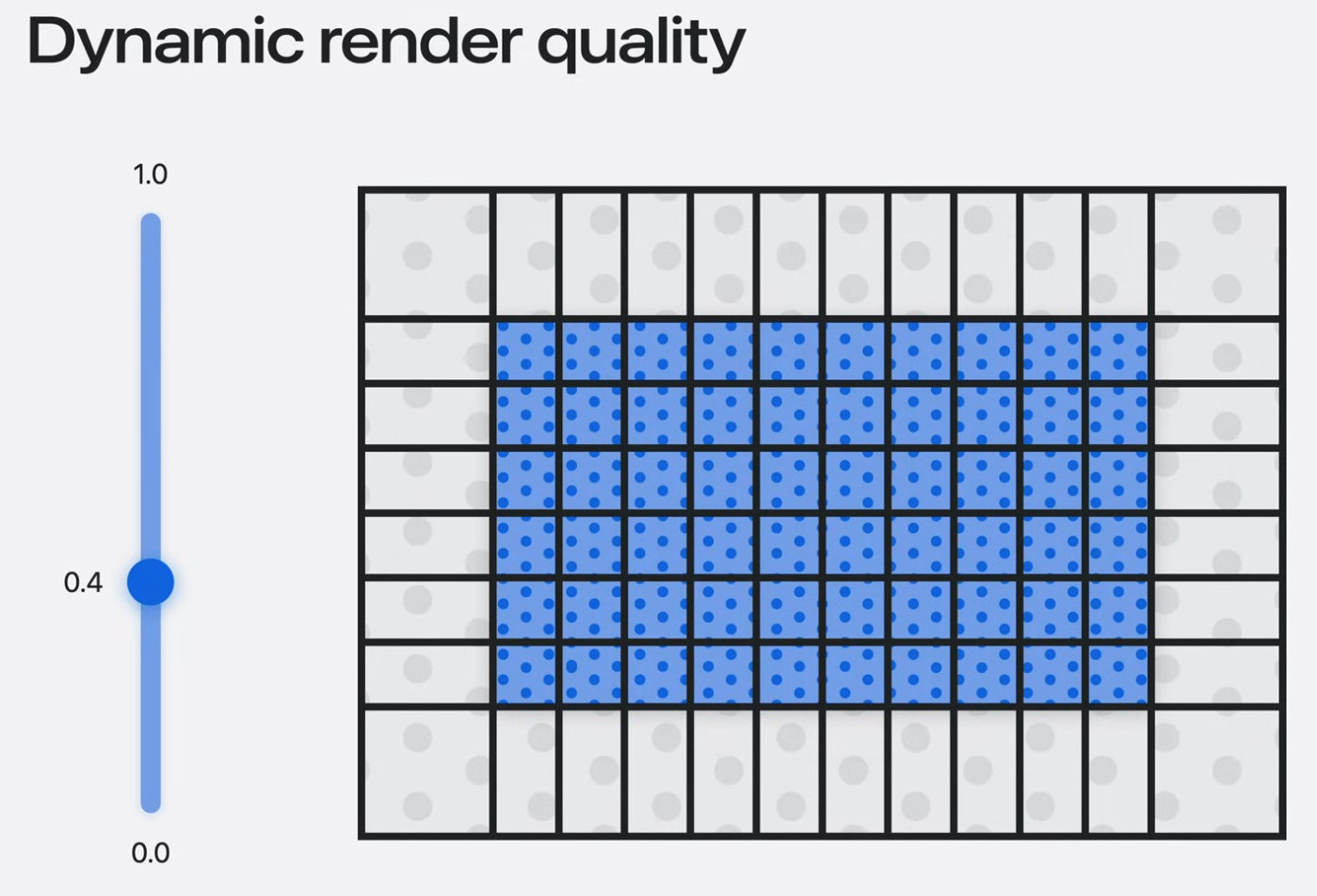

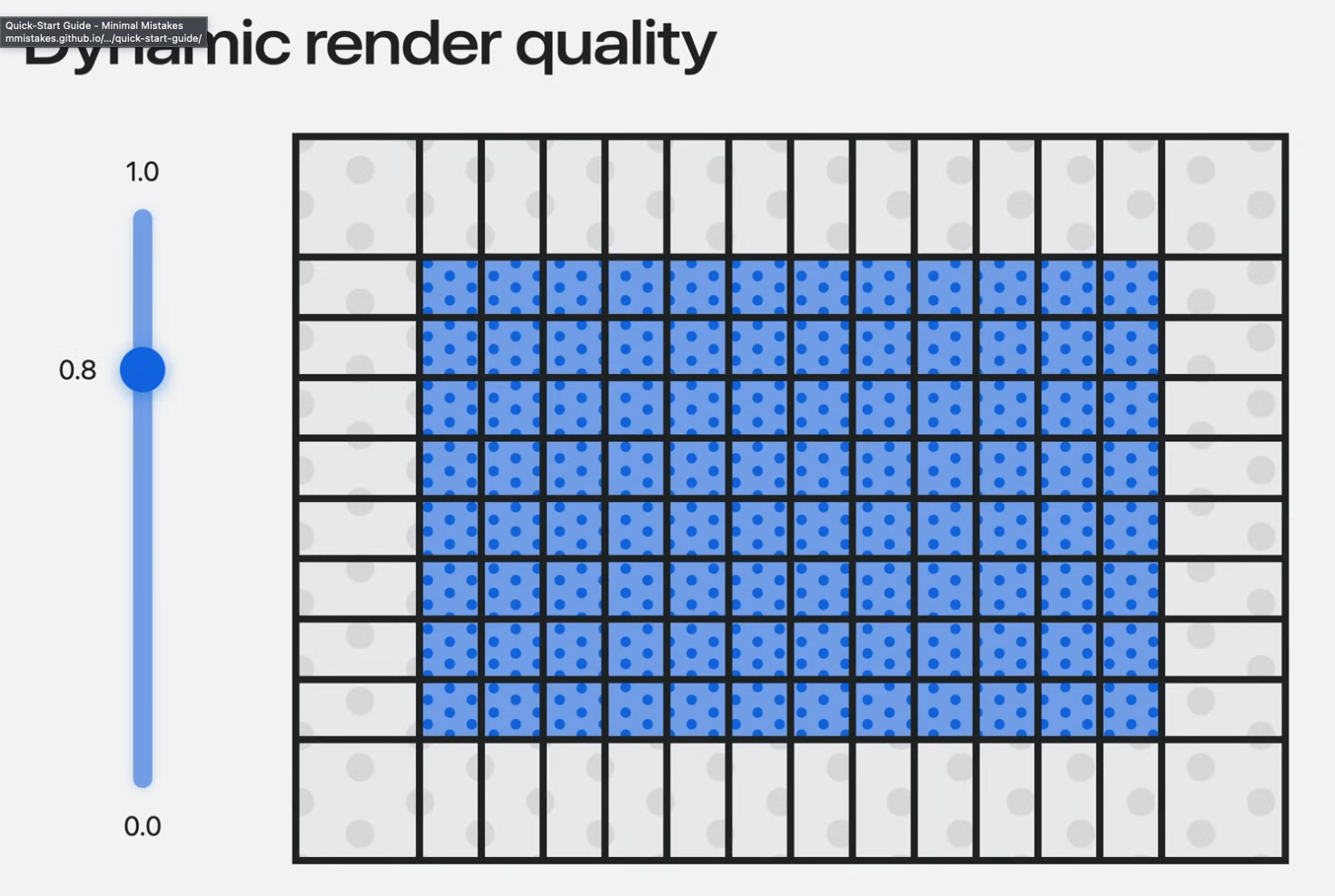

앱의 랜더링 성능을 최적화하려면 세부적인 제어가 필요할 수 있으므로, Compositor Services에서 동적 렌더링 품질에 대한 지원을 추가하여 세부적인 장면이 돋보이게 표현되도록 했다.

랜더링된 장면의 해상도가 높아지면 사용자 경험이 크게 향상 될 수 있다.

이 새로운 기능을 사용하면 앱에서 렌더링 되는 프레임의 품질을 제어할 수 있다.

랜더링 품질을 높이면 텍스쳐에서 relevance area가 확장되어 전체 텍스처 크기가 커진다.

앱의 품질이 높아질 수록 메모리와 전력도 더 많이 사용하게 된다.

text나 사용자 interface 요소를 렌더링하는 경우 렌더링 품질을 높이는 것이 좋다. 앱이 원활하게 실행되도록 하려면 higher resolution 영상과 앱의 성능 및 메모리 사용량 관리 간의 균형을 찾는 것이 중요하다.

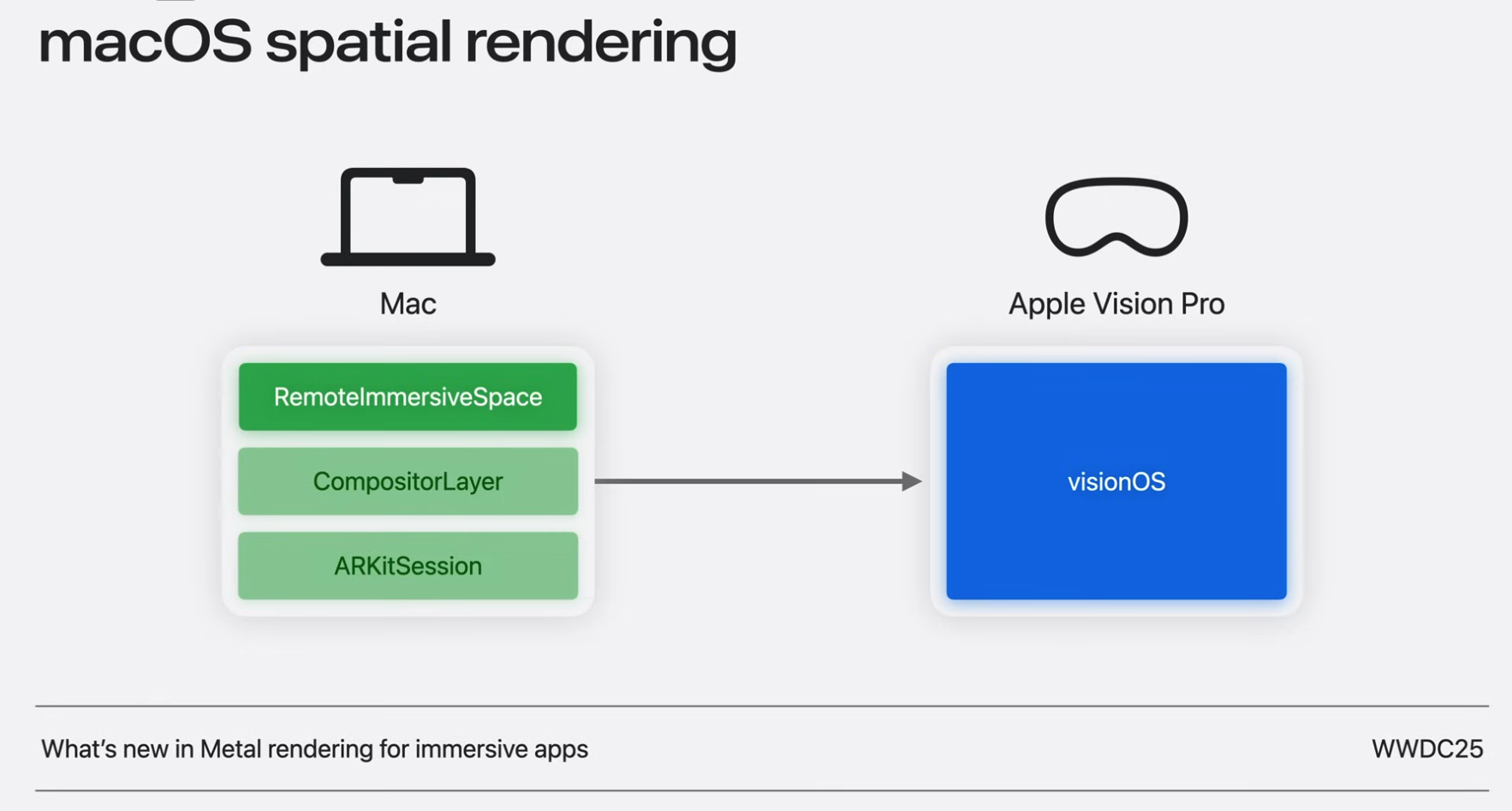

macOS 공간 렌더링이 추가되어 Mac의 성능을 활용하여 몰입형 콘텐츠를 Vision Pro로 직접 렌더링하고 스트리밍 할 수 있다.

기존 Mac 앱에 몰입형 환경을 추가하여 spatial content를 미리 보는 것부터 완전히 몰입형 게임을 만드는 것까지 앱에서 Mac의 놀라운 랜더링 기능과 Vision Pro의 고급 고해상도 디스플레이를 결합할 수 있다.

Mac에서 지원되는 immersive experience를 구축하기 위해, native 몰입형 앱을 만드는데 사용되는 익숙한 프레임워크를 사용할 것이다.

Compositor Services와 ARKit은 이제 Mac에서 사용할 수 있으며 새로운 Remote Immersive Space SwiftUI scene type과 함께 사용할 수 있다.

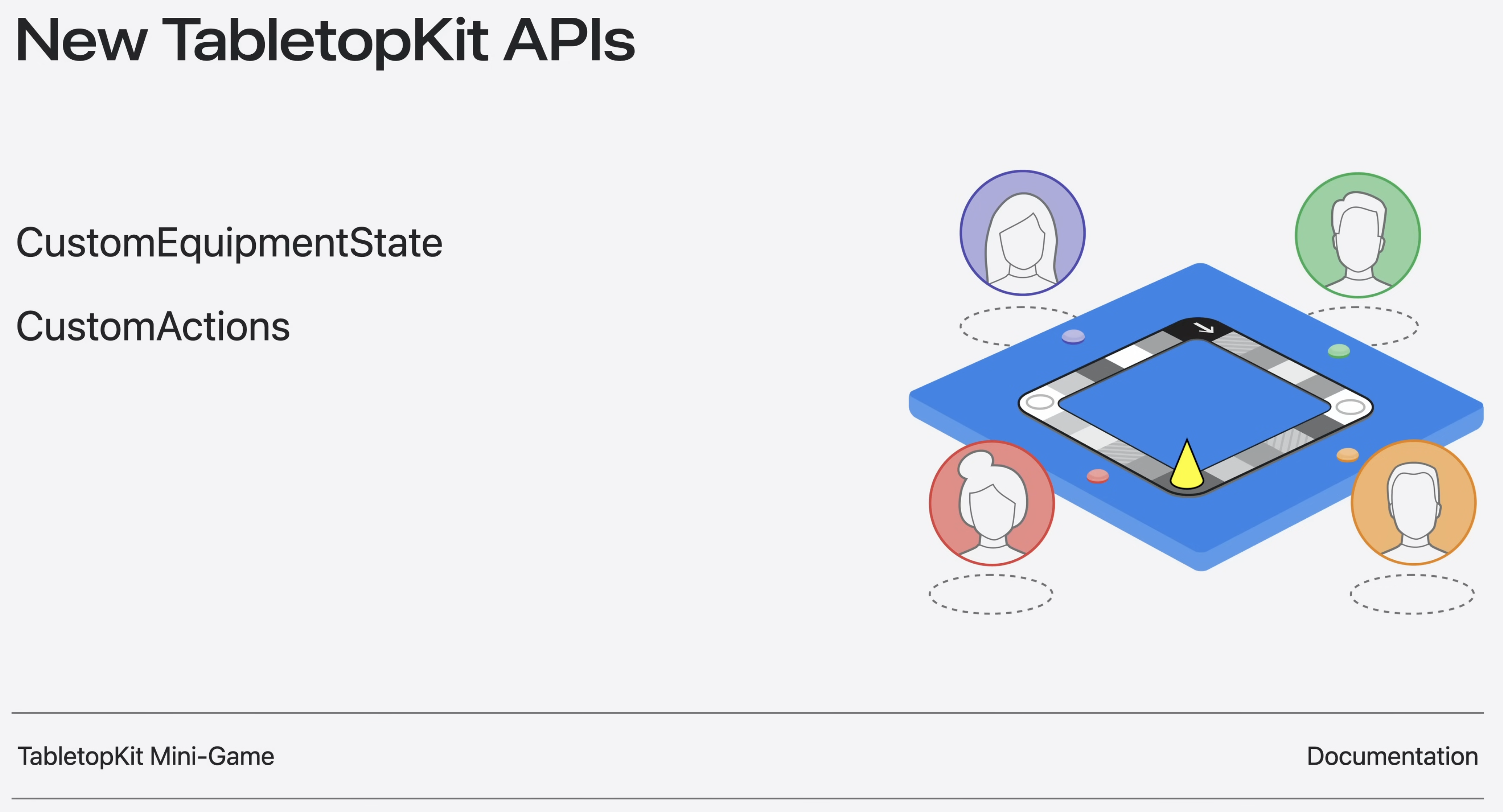

visionOS26에서는 TabletopKit의 새로운 기능을 통해 함께 게임을 하는 것이 더욱 흥미로워졌다.

CustomEquipmentState를 사용하면 equipment라고 하는 game 조각에 사용자 정의 데이터 필드를 추가할 수 있다. 이 사용자 지정 상태는 원활한 동기화를 위해 자동으로 네트워크화 된다. CustomeActions를 사용하면 플레이 중에 트리거 할 나만의 액션을 정의할 수 있다. 소유권 변경부터 동적 색상 업데이트까지 사용자 정의 작업이 손쉽게 네트워크로 연결된다. 네트워킹이나 의견 수렴 같은 어려운 부분에 대해 걱정할 필요가 없으므로 게임에만 집중이 가능하다.

Shared experiences

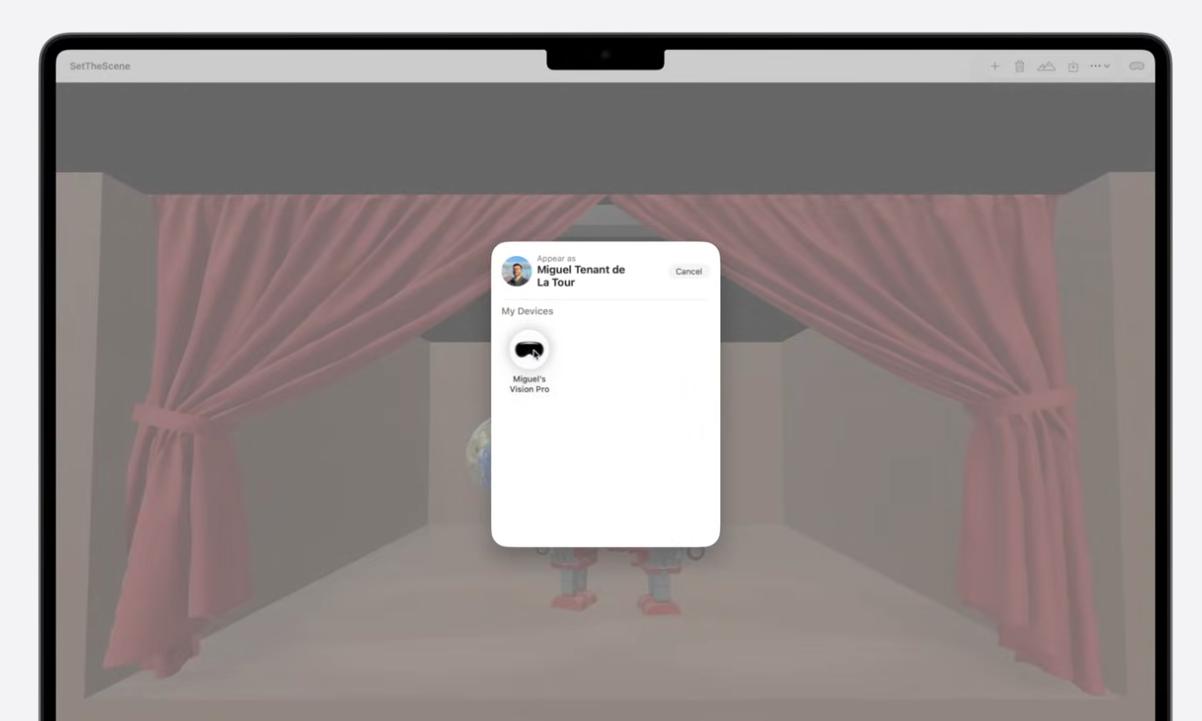

Vision Pro에서 바로 옆에 있는 사람을 공간적 경험으로 가져오고 싶다면?

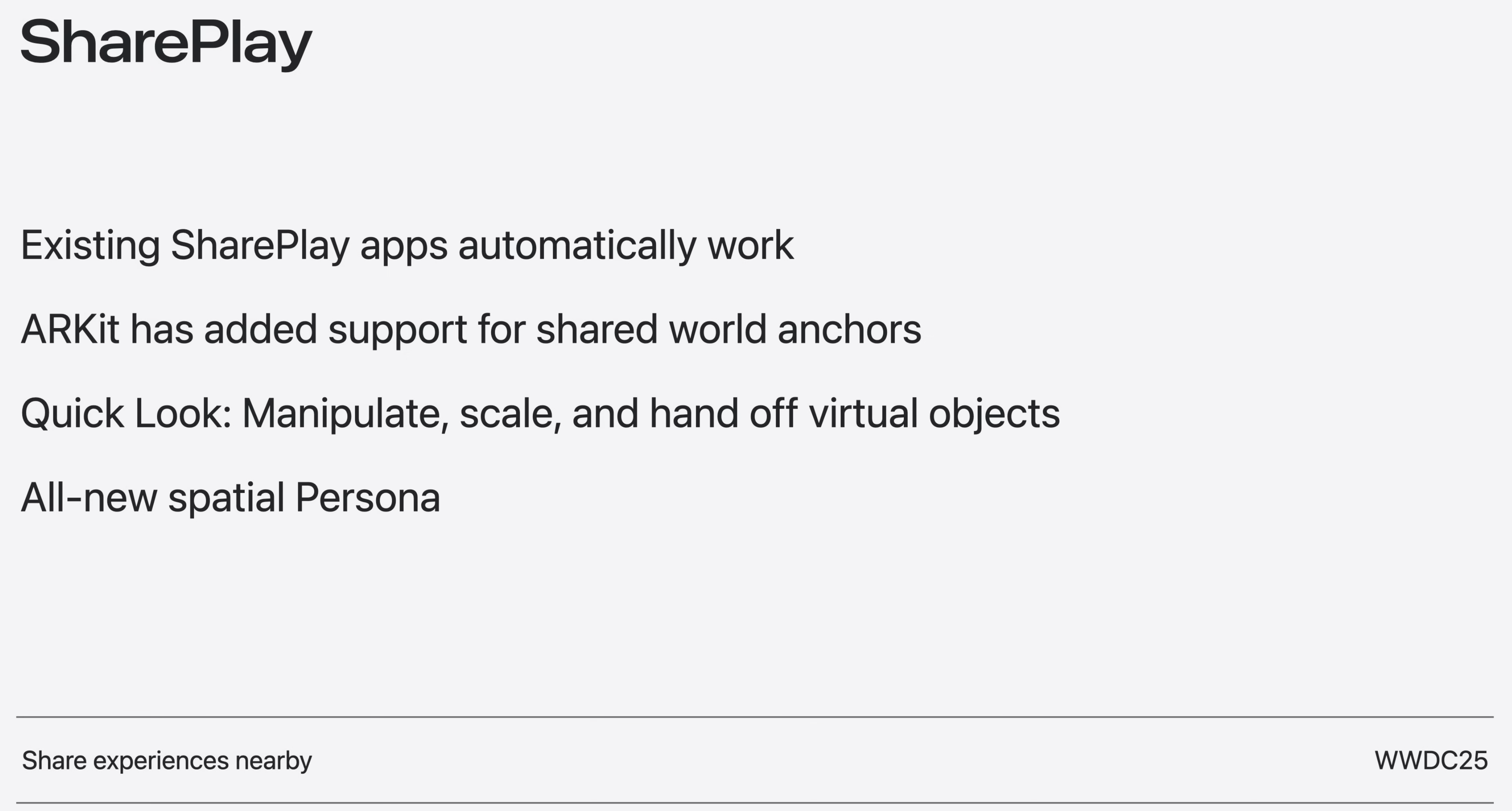

visionOS 26에서는 근처 창 공유 기능을 통해 같은 방에 있는 사람들이 공유하는 공간 경험을 구축할 수 있다.

ARKit은 shared world anchor에 대한 지원을 추가하여 공유 콘텐츠를 방에 정확하게 고정할 수 있게 되었다. SharePlay 세션 중에 앱과 콘텐츠를 주변 환경에 맞게 이동, 크기 조절, 스냅할 수 있다.

Quick Look을 사용하면 물리적인 객체와 마찬가지로 가상 객체를 조작하고, 크기를 조정하고, 서로에게 전달할 수 있다.

Spatial Persona는 베타 버전을 벗어나 머리카락, 피부색, 표정, 표현 등 광범위한 개선 사항을 갖추게 되었다.

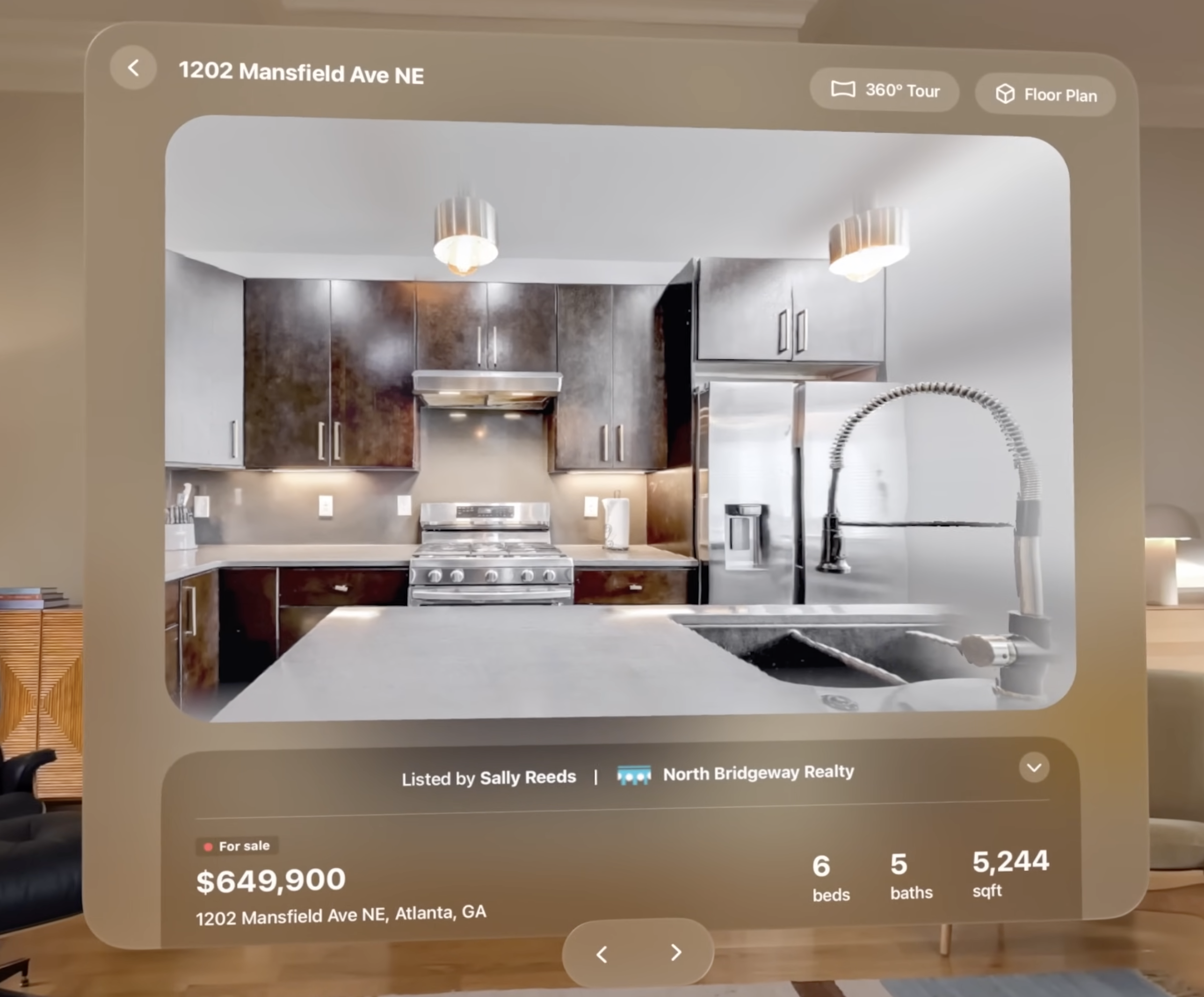

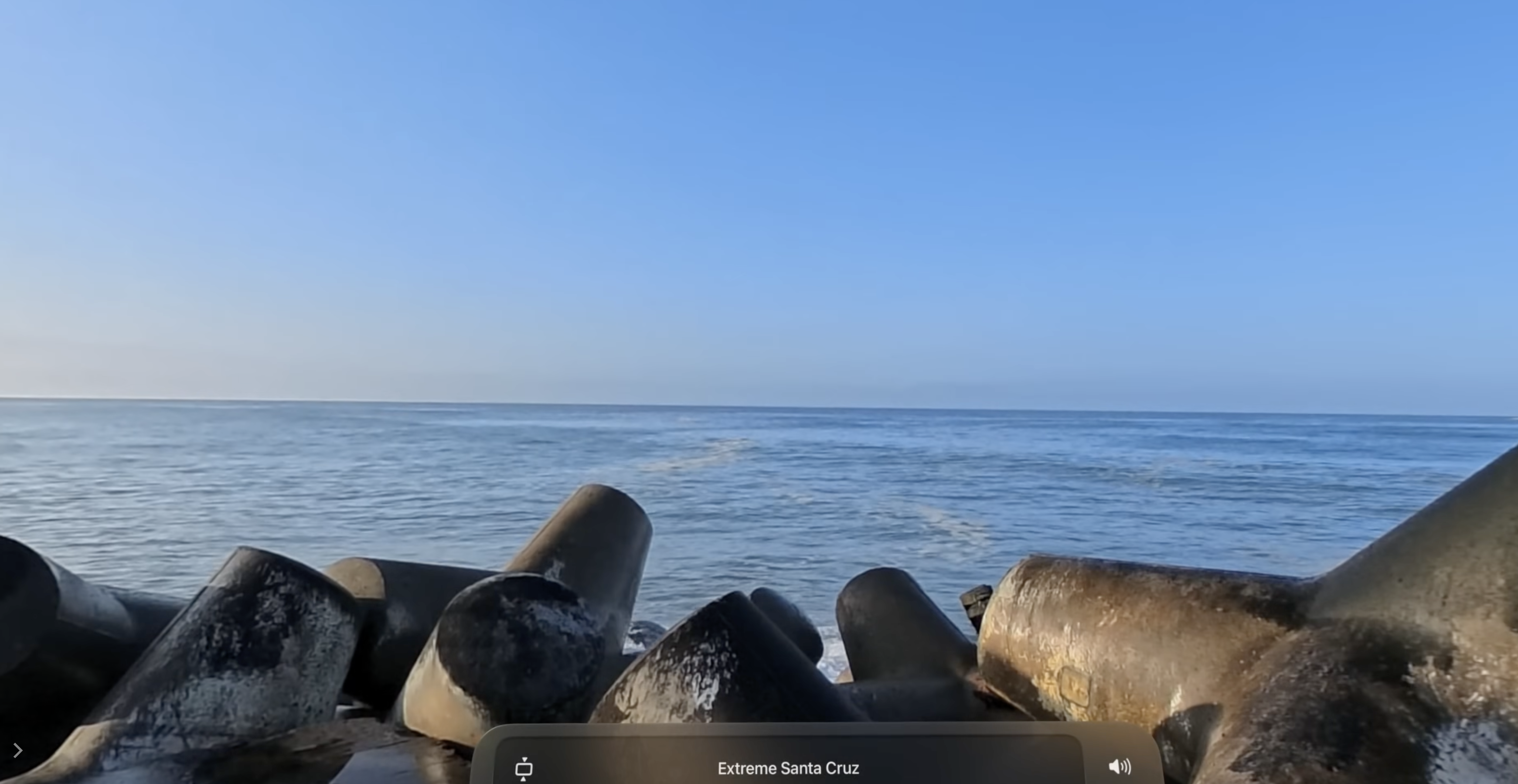

Immersive media ecosystem

사람들은 Vision Pro에서 추억을 되살리는 것을 좋아한다. RealityKit의 새로운 ImagePresentationComponent를 사용하면 기기 내 생성 AI를 활용하여 여러 관점에서 실시간 렌더링에 최적화된 3D 공간 장면에서 monoscopic 혹은 spatial stereo content를 표시할 수 있다.

이를 통해 사용자는 마치 물리적으로 그 자리에 있는 것처럼 몸을 기울여 콘텐츠를 둘러볼 수 있다.

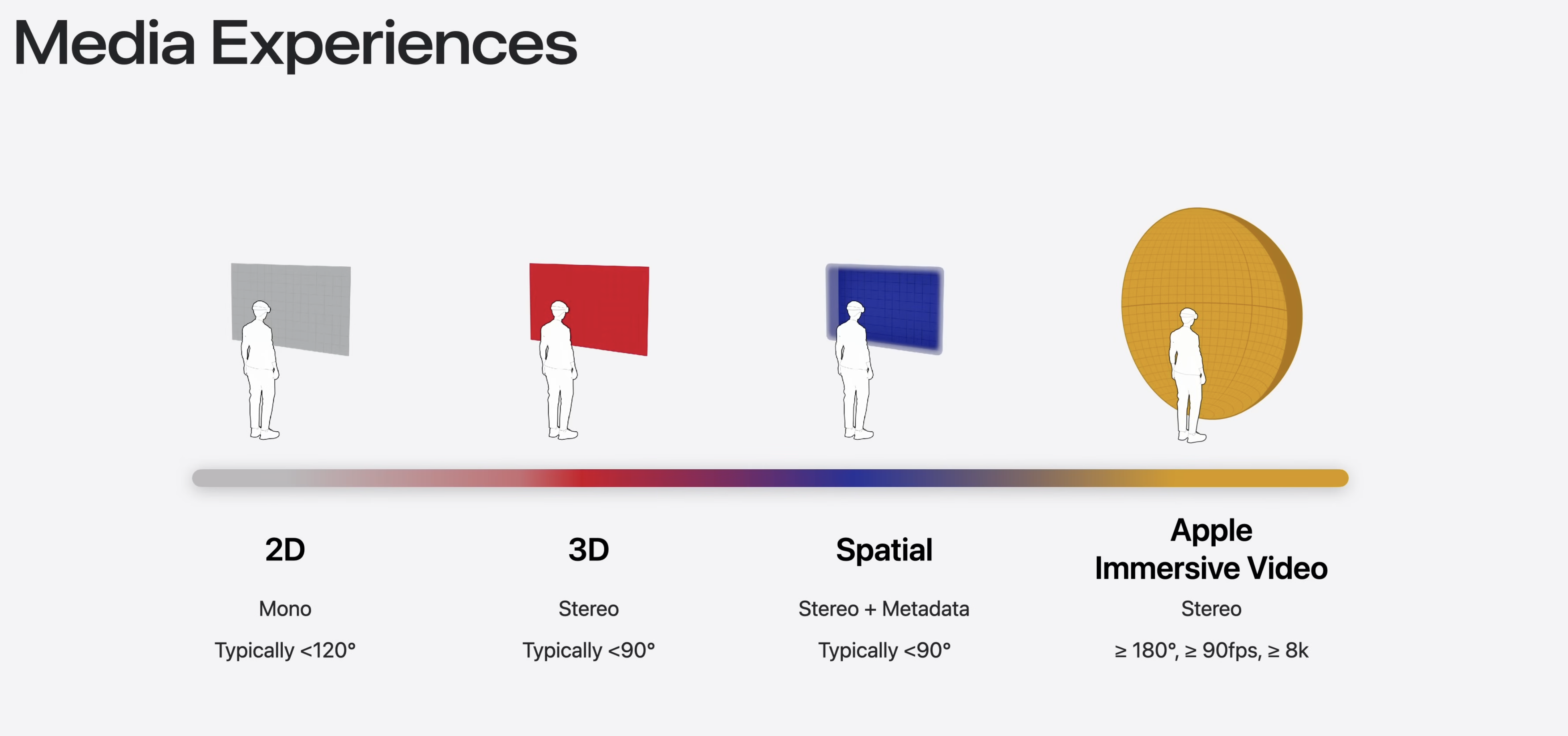

기존에는 이러한 경험들이 가능했으나

이러한 경험들이 추가 될 예정이다.

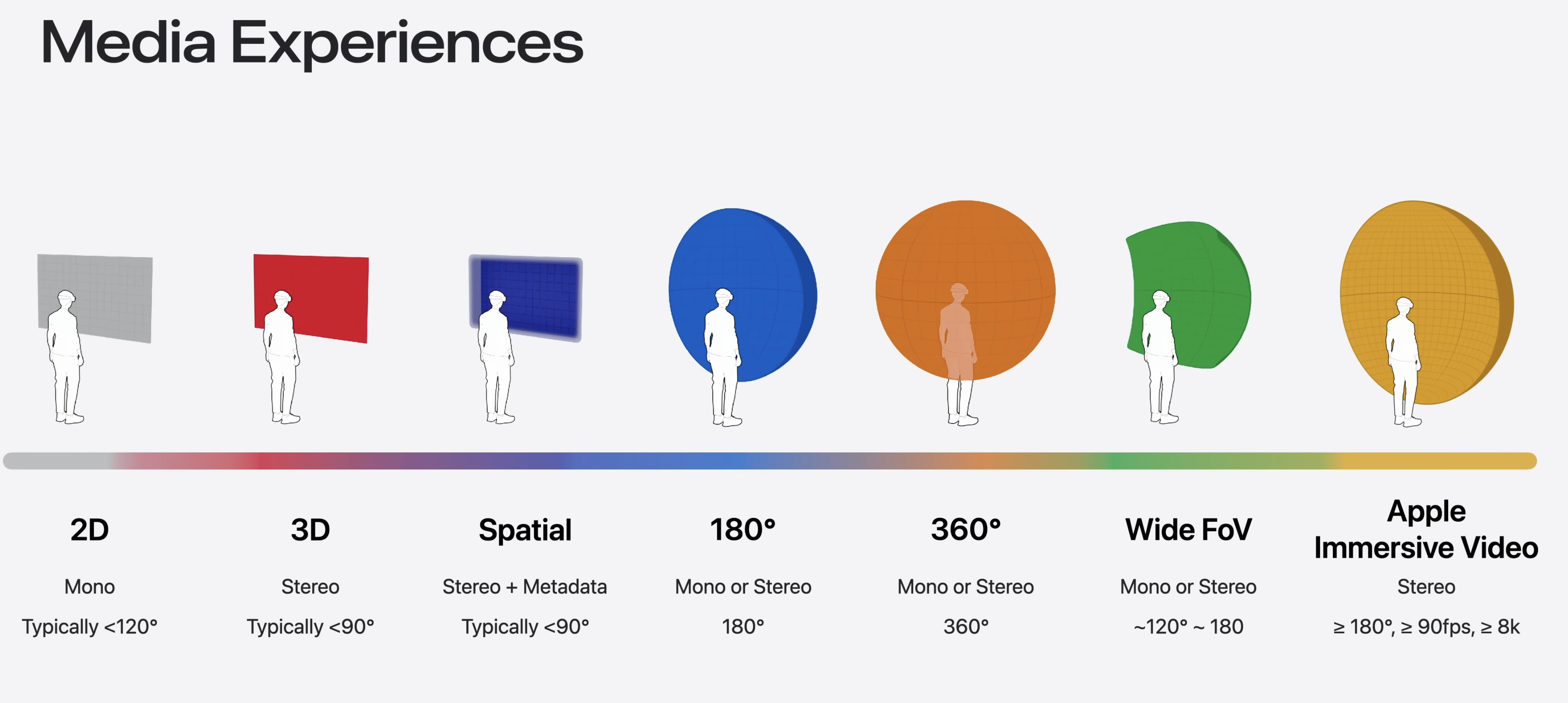

Canon, GoPro, Insta360 등 인기 있는 타사 카메라로 촬영한 광각 시야의 미디어에 대한 시스템 수준 지원을 제공한다.

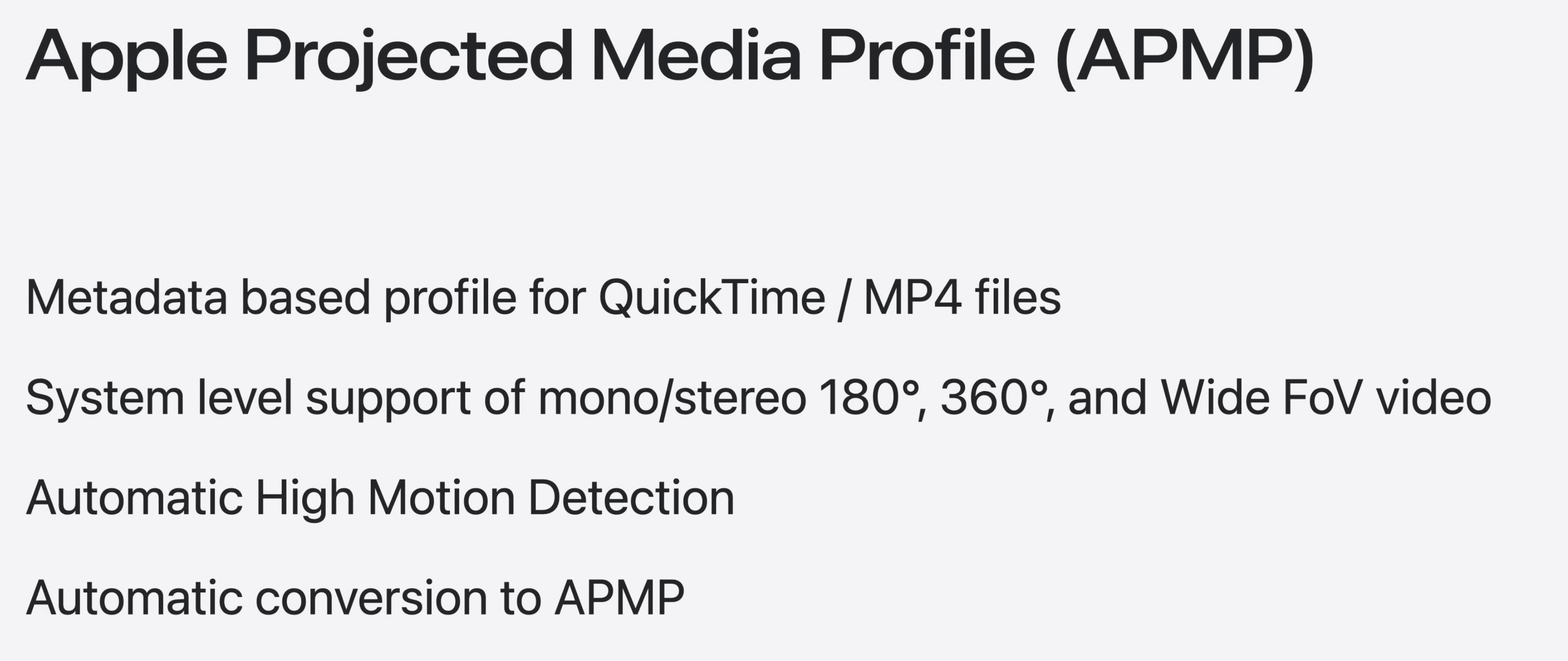

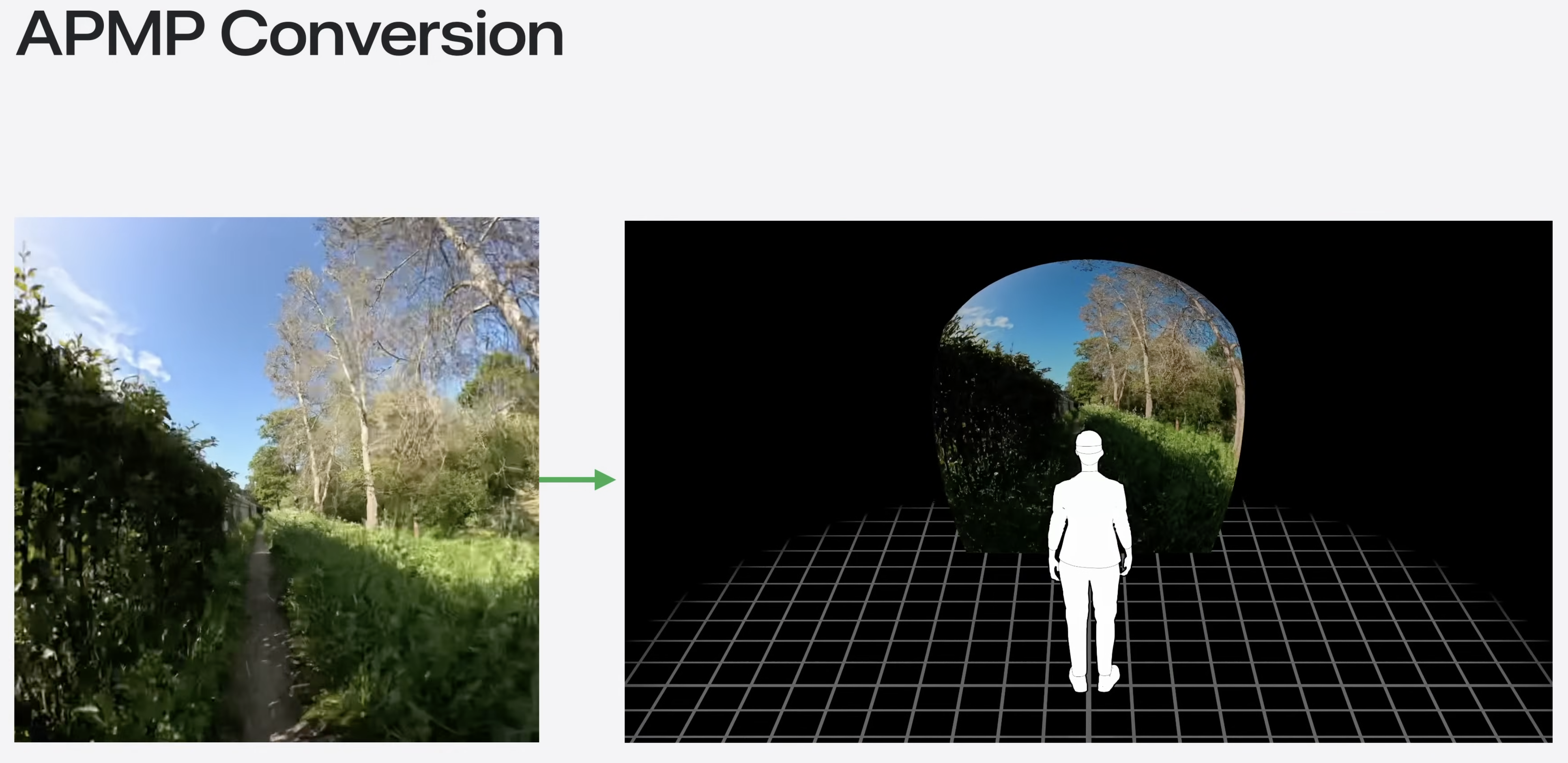

Apple Projected Media Profile(APMP) 덕분에 업계 최고 수준의 지원이 가능해졋다. 이를 통해 시청자에게 이상적인 프레젠테이션을 위해 projection(투영)이라고 하는 픽셀당 추가 기하학적 연산을 표현하는 유연한 방식을 제공한다.

APMP는 Quick Time 및 MPEG-4 파일에 180도, 360도 또는 광시야각(WFoV)를 표시할 수 있는 메타데이터 기반 접근 방식이다.

이는 올바른 재생 및 편집 워크플로를 구현하는 데 필수적이다.

또한 APMP에는 높은 동작 감지 기능을 내장하여 액션 카메라 영상과 같은 까다로운 콘텐츠를 몰입감 있게 보여줄 때 시청자가 편안함을 느낄 수 있도록 지원했다.

그리고 인기 있는 타사 카메라로 촬영한 유사한 콘텐츠의 기존 라이브러리가 많이 있으므로 visionOS는 특정 타사 카메라에 대한 APMP 메타 데이터를 자동으로 생성한다.

APMP의 핵심 원칙

왼쪽의 캡처 장치는 표준 비디오 프레임을 생성한다.

광각 어안 렌즈의 특성상 콘텐츠가 왜곡된 이미지로 기록된다. 원본 영상은 렌즈로 인해 배럴 왜곡이 발생한다. Apple Immersive Video에서 사용하는 접근 방식을 차용한 APMP를 사용하면 미디어 프레임워크에서 카메라 렌즈와 장치 캡처 모드로 정의된 곡면에 픽셀을 투사하여 렌즈 왜곡을 해제할 수 있다.

이를 통해 이전에는 2D로만 보던 콘텐츠를 몰입형 미디어 세계로 가져와 액션 카메라로 촬영한 경험을 더욱 실감나게 즐길 수 있는 환상적인 방법을 제공한다.

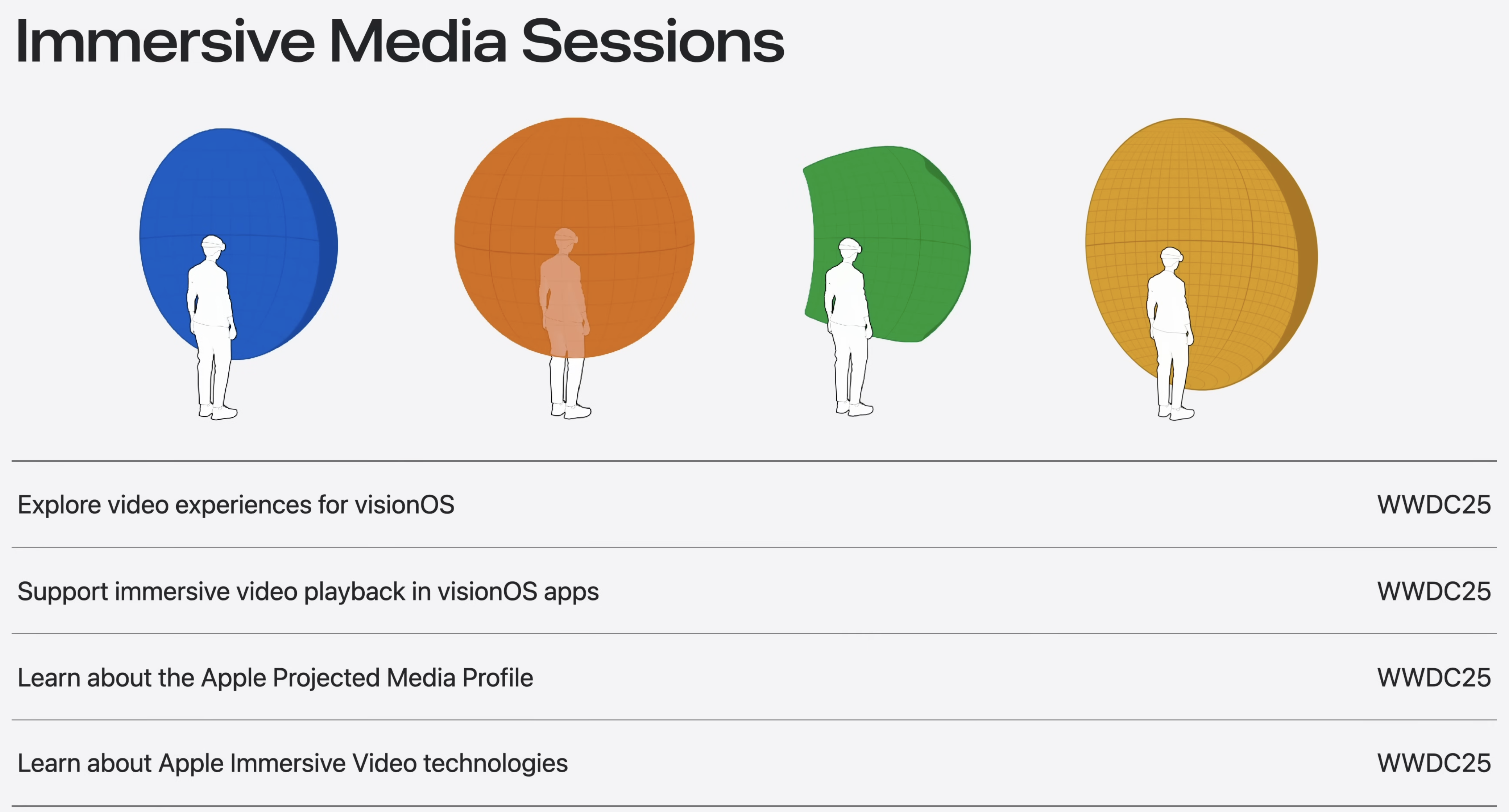

APMP를 통해 시스템에 지원을 통합하여 180도, 360도 및 Wide FoV 미디어를 완벽하게 수용했다.

Apple Immersive Video를 포함한 모든 몰입형 미디어 형식을 파일 앱의 Quick Look에서 바로 체험하거나 앱 내에서 Progressive Immersion을 완벽하게 지원하여 몰입 수준을 맞춤 설정할 수 있다.

재생에는 익숙한 AVKit, RealityKit, Quick Look와 WebKit에서 지원되므로 어떤 유형의 경험을 구축하든 다양한 형식의 멋진 미디어를 원활하게 통합할 수 있다.

아래와 같은 도구를 이용하는 creator는 앱이나 사파리의 웹에서 해당 콘텐츠를 재생할 수 있다.

macOS와 visionOS의 최신 업데이트에서는 새로운 Immersive Media Support framework를 통해 자체 제작 파이프라인에서 Apple Immersive Video 콘텐츠를 만들고, 처리하고 공유할 수 있다.

Vision Pro에서 콘텐츠를 녹화하는 경우 이제 Reality Composer Pro를 사용하여 세션당 3배 더 많은 콘텐츠를 캡처할 수 있다. 이제 시뮬레이터는 장치가 없어도 녹화할 수 있ㅇ르 뿐만 아니라 4K 해상도도 지원한다.

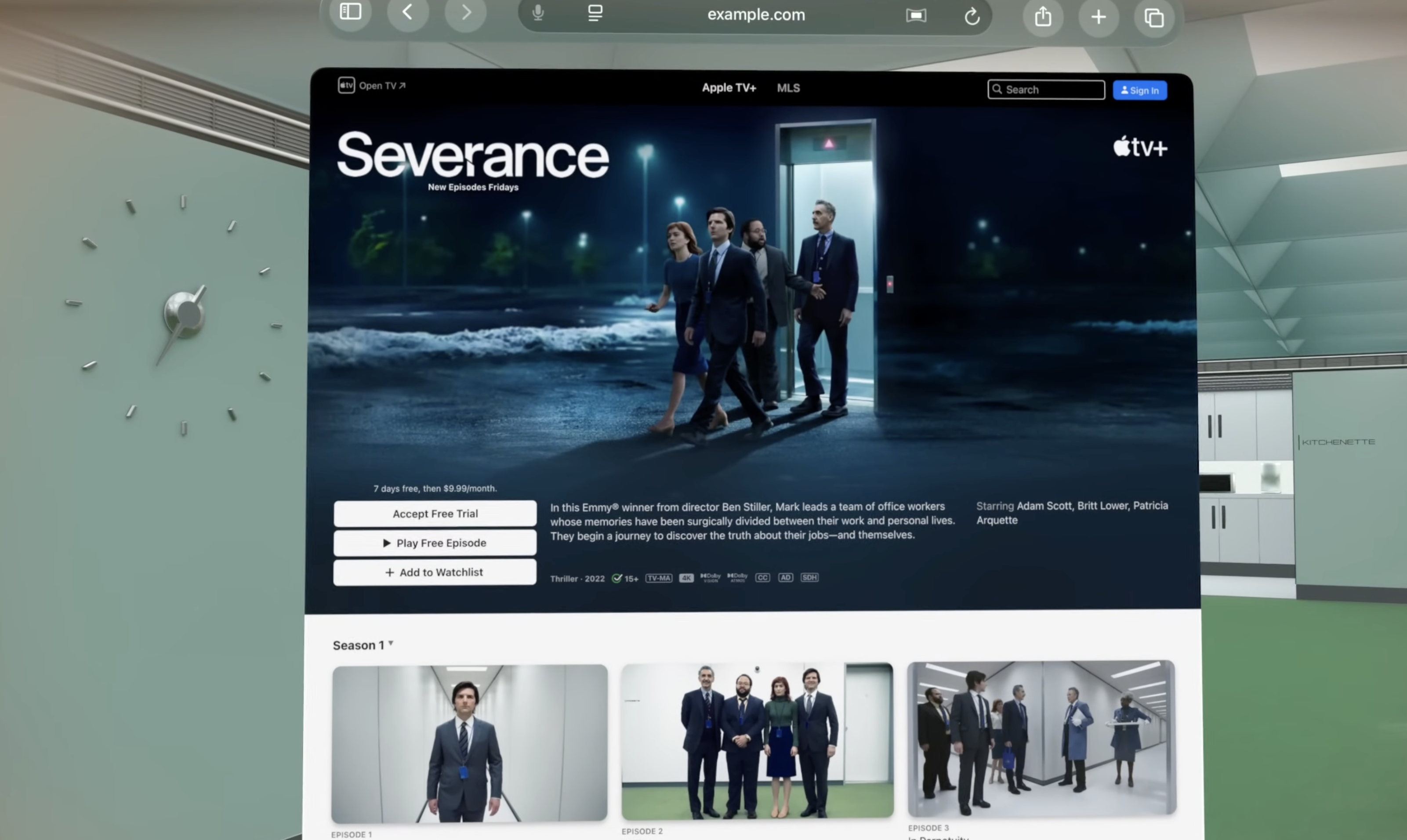

Spatial web

사파리에 대한 새로운 사항! 비디오를 시청하고 탐색하는 새로운 간편한 방법이 생겼다. 비디오를 시청하는 동안에도 페이지에 있는 추가 콘텐츠를 참조할 수 있다.

공간 탐색 버튼을 선택하면 스크롤 할 때마다 생동감이 넘치는 inline 공간 미디얼르 볼 수 있도록 웹 페이지를 변환할 수 있다. iOS, macOS에서 브라우징 버튼 리더 모드로 전통적으로 볼 수 있던 모든 페이지는 safari를 벗어나지 않고도 전체 화면으로 전환되어 주변에 표시된 공간 미디어를 볼 수 있다.

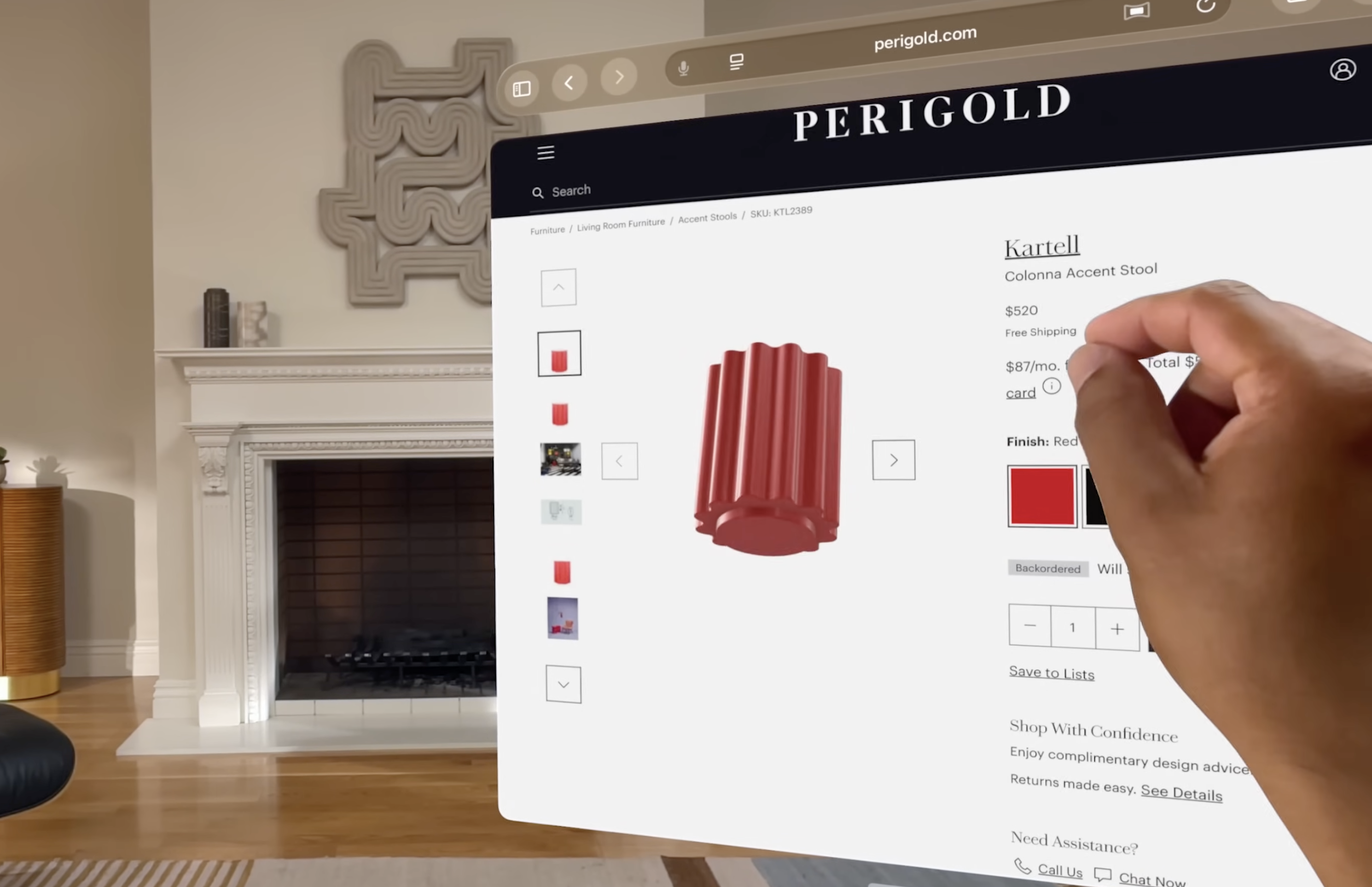

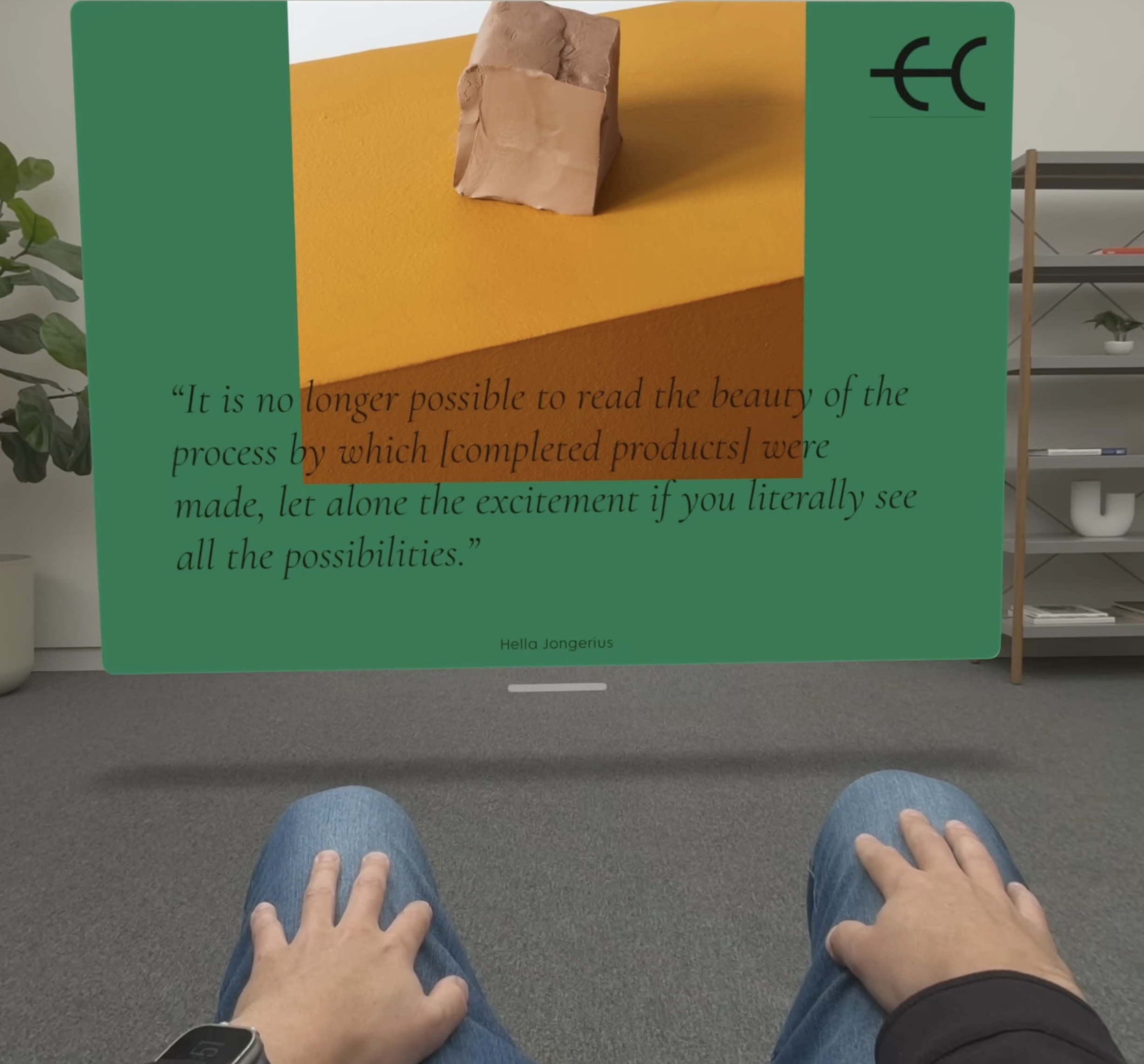

웹 개발자의 경우, 새로운 HTML model element를 사용하여 웹 페이지에 3D model을 쉽게 넣을 수 있다. Through 간단한 선언적 API를 통해 USDZ 모델을 입체적으로 보여줄 수 있다.

모델은 페이지의 일부가 되며, CSS로 스타일을 지정하고 JavaScript로 구성할 수 있다. 또한 Quick Look을 사용하여 페이지에서 끌어내어 실제 세계에 배치할 수 있어, 보고 있는 항목을 직접 만져보는 듯한 느낌을 받을 수 있다.

사파리에는 다양한 공간 미디어 형식에 대한 지원이 추가되었는데,

사파리에서 공간 이미지를 표시하는 것 외에도 기존 HTML 비디오 element를 사용하여 웹 페에지에 Apple Immersive Video를 포함한 모든 지원 형식을 사용하여 공간 비디오를 추가하여 전체 화면으로 전환할 때 몰입감 있게 공간 콘텐츠를 즐길 수 있다.

그리고 HTML 마크업을 통해 방문자에게 맞춤형 몰입형 환경을 제공할 수 있는 Web Backdrop이라는 새로운 개발자 미리보기 기능도 제공한다. (33:15)

이 영상에서 더 알아볼 수 있음.

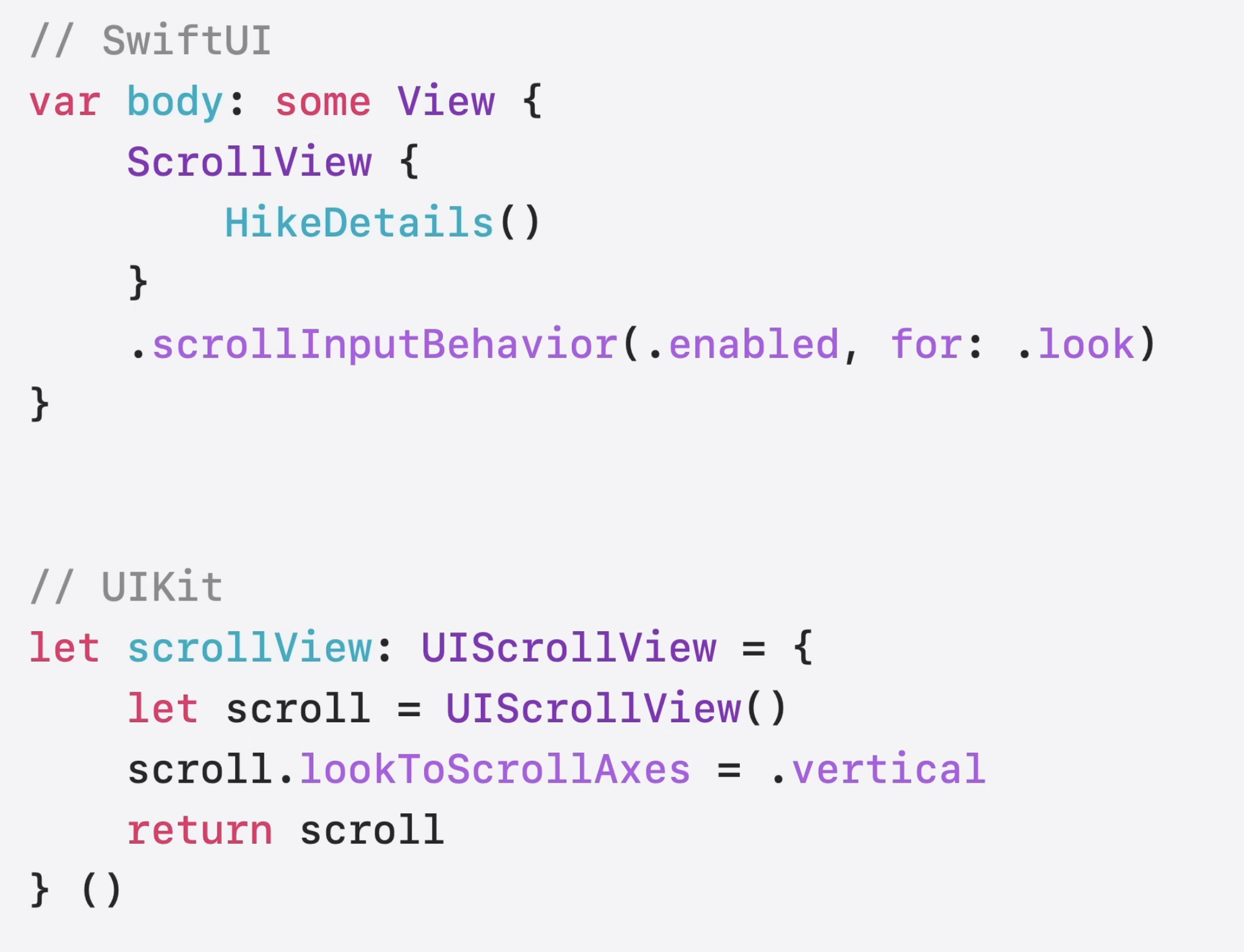

눈만 사용하여 웹과 콘텐츠를 탐색할 수 있는 새로운 핸즈프리 방식인 "Look to Scroll" 기능도 추가되었다. 이 기능은 Safari, TV, 음악, 앱 스토어, 메모, 메일, Quick Look 등의 앱을 만드는 데 효과적이다.

SwiftUI와 UIKit의 API를 통해 앱에서 이를 채택할 수 있다.

New enterprise API

기업이 비전프로를 도입하기 더 쉬워졌다.

Shared Space Main Camera

다른 공간 앱과 동시에 카메라 기반 환경을 실행할 수 있다.

Stereoscopic Main Camera

왼쪽 및 오른쪽 메인 카메라 피드에 동시에 액세스 할 수 있게 되었다.

Camera Region

ARKit의 새로운 CameraRegionProvider를 사용하면 관심 있는 특정 영역에 대한 향상되고 안정화된 비디오 피드를 받을 수 있다.

이 기능을 활용하여 주변에서 중요한 정보를 시야에 들어오게 하거나 안정화된 시야의 일부를 원격 참석자와 공유할 수 있다. contrast를 높이거나 생동감을 높이는 등 고정된 영역을 향상시키기 위해 추가 매개변수를 제공할 수도 있다.

Protected Content

카메라 외에도 민감한 데이터를 더 효과적으로 보호하기 위해 protested content라는 새로운 API를 추가했다.

contentCaptureProtected를 사용하면 앱의 뷰를 보호된 것으로 표시할 수 있으며, 시스템은 해당 뷰의 콘텐츠 캡처를 금지한다. 스크린샷, 화면 녹화, AirPlay, ShrePlay가 비활성화 된다.

Window Follow Mode

마지막으로, 라이선스 권한이 있는 visionOS 앱의 경우 Window를 Window Follow Mode로 전환하여 사용자가 공간에서 움직일 때 앱이 자동으로 사용자의 위치를 따라가도록 할 수 있다.

그 외...

Return to Service를 통해 기업 내 팀원 간에 장치를 보다 쉽고 안전하게 공유할 수 있다.

Vision Pro를 활성화하면 여러 사람이 MDM을 통해 다운로드한 앱을 보존하는 동시에 세션 간에 모든 민감한 정보가 삭제된다.

이러한 재설정은 미리 정의된 시간 간격으로 실행될 수도 있고, 수동으로 실행되어 다음 사람을 위해 장치를 준비할 수도 있다.

Return to Service를 이용하려면 Apple Business Manager에서 기기를 구성해야 한다. 공인된 기업을 통해 구매한 비전 프로는 Apple Business Manager에 자동으로 등록된다.

다른 곳에서 구매한 기기는 IT 전문가가 Apple Business Manager에 비전 프로를 수동으로 등록하여 조직의 기기를 감독하는 것이 더 쉬워지도록 iOS용 Apple Configurator를 업데이트 했다.

QuickStart 기능 향상으로 이제 사용자는 iCloud나 iOS 기기에 저장된 비전프로 설정 데이터를 가져올 수 있어 손과 눈을 다시 등록할 필요가 없다.

FaceTime과 SharePlay를 사용하지 않는 기업도 자체 인프라를 활용하여 로컬로 공유되는 경험을 만들 수 있다.

ARKit의 SharedCoordinateSpaceProvider API를 통해 관리되는 권한을 사용하면 동일한 물리적 공간에 있는 사람들이 기본 데이터에 대한 엑세스를 요청할 수 있으므로 collaborative한 디자인과 리뷰가 가능해진다.