- "카메라 2억 화소 실화?"...갤럭시S23 울트라, 역대급 스팩된다

- "실물 떴다" 아이폰14 카툭튀 개선 커녕 더툭튀… 유력 출시일도 나와

- ‘아이폰14’ VS ‘갤럭시S22울트라’ 카메라 성능 비교... 야간촬영 승자는?

스마트폰이 나온지 10여년이 지났음에도 불구하고 아직도 스마트폰 카메라에 대한 혁신은 매년 더해가고 있다.

Multi Camera가 도입된 이후로 최근 2~3년간은 스마트폰 제조사간 화소 경쟁이 불타오르고 있는데 이 과정에서 알아두면 유용하고 재밌는! 스마트폰 고해상도 Camera 방식에 관한 내용들을 정리하려한다.

화소수가 4배 많아졌대요! 4배 더 잘 찍히겠네요!!?

최근 아이폰 14에서는 4800만 화소를 지원한다고 발표했으며,

삼성에선 2억 화소를 지원하는 이미지 센서를 개발했고 갤럭시 S23에 적용한다는 소식에 많은 사용자들의 관심이 집중되고 있다.

그렇다면, 화소수에 비례하여 사진 결과물이 좋아지는 것일까??

결론부터 말하면 그럴수도.. 안 그럴수도.. 있다.

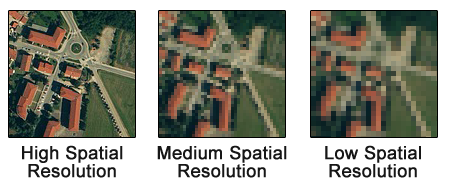

Full HD 영상보단 4K 영상이, 4K 영상보단 8K 영상이 더 선명하게 보이는 것처럼

일반적으로 이미지 해상도가 높으면 높을수록 더 미세하게 공간을 표현할 수 있다.

하지만, 한 이미지 센서가 있다고 가정할 때

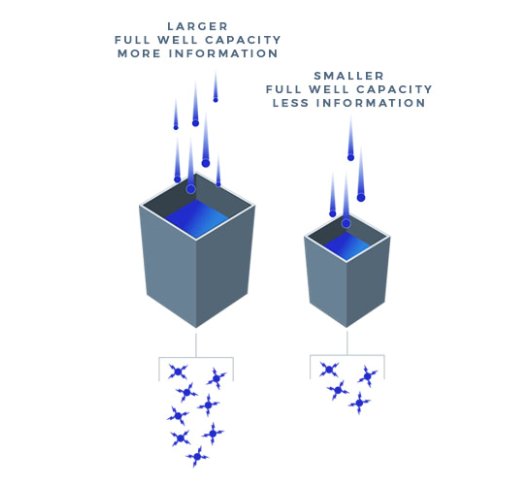

지원하는 해상도가 높으면 높을수록 하나의 pixel이 가지는 면적은 그만큼 더 작아져야한다.

pixel 크기가 작아지게 되면 빛의 신호를 받을 수 있는 면적 또한 작아지게 되고 작아진 빛의 신호를 읽기 위해 신호를 증폭함으로써 보다 높은 노이즈 정보를 포함한 결과를 얻게 된다.

이러한 연유로 광량이 풍부한 곳에서 고해상도 사진을 촬영하게 되면 작은 pixel 크기를 가져도 충분한 정보를 받을 수 있기 때문에 디테일한 결과를 표현할 수 있지만, 작은 pixel 크기를 가진 이미지 센서로 저조도 상황에서 고해상도 촬영을 하게 되면.. 노이즈가 가득한 결과를 얻게 되는 것이다.

물론, 큰 이미지 센서에 높은 해상도를 지원하면 Game over 겠지만..

덩달아 카메라 크기도 커지게 되는 문제가 발생하기에

모든 스마트폰 제조사에서 카메라 성능을 올리면서 어떻게 하면 카툭튀를 최소화할 수 있을까에 대해 매년 1순위로 고심하고 있는 이유이다.

하지만 다시 본론으로 들어왔을 때 의문이 드는 부분은 다음과 같이 나타날 수 있다.

(1) 4800만 화소(48MP)를 지원하게 되면 1200만 화소(12MP)를 지원했을 때보다 pixel의 갯수는 4배 씩이나 더 많아지게 되는 것인데 어떻게 카메라 크기는 그만큼 커지지 않았을 수 있었던 것일까?

(2) 고해상도 카메라를 지원하고 있음에도 불구하고 저조도 촬영 품질(Nightography)은 어떻게 점점 좋아지는 것일까?

그리고 이 의문의 답은 바로 pixel binning에 있다.

Pixel Binning

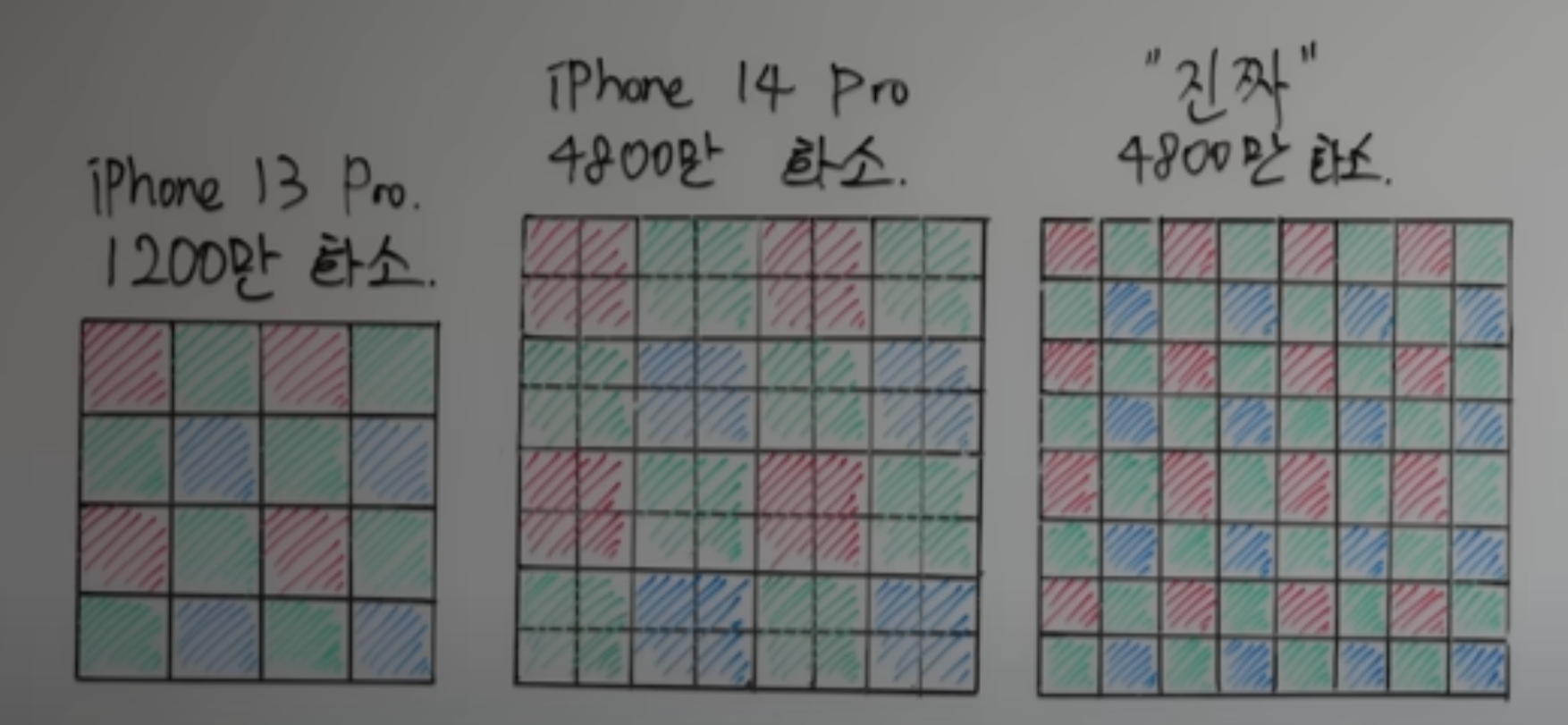

첫 번째 그림은 아이폰 13 Pro의 1200만 화소(12MP) 센서

두 번째 그림은 아이폰 14 Pro의 4800만 화소(48MP) 센서이다.

왜 아이폰 14 Pro는 세 번째 그림과 같은 화소 센서를 사용하지 않았을까?

가장 큰 이유는 빛을 받아들이는 수광량을 높이기 위해서이다.

화소가 높아짐으로써 각 pixel의 면적은 작아지게 되었는데, 앞서 말했듯이 pixel의 크기가 작아지면 빛을 적게 받아들이고 노이즈는 커지기에 4개의 pixel을 묶어 마치 1개의 pixel처럼 활용하는 것이다.

이렇게 4개의 pixel을 묶게 되면, 한 pixel의 크기가 기존 12MP의 한 pixel 크기보다 더 커지게 되고 빛을 더 많이 받아들일 수 있게 되어 색상 정확도를 더 명확히 나타낼 수 있는 것이다. 이러한 기술을 pixel binning 이라고 하며, 다음과 같이 저조도, HDR 상황에서 큰 이점으로 작용한다.

저조도 비교

HDR 비교

참고로 갤럭시 S22 ultra의 경우 4(2x2)개의 pixel을 묶는 것을 넘어서 9(3x3)개 16(4x4)개 pixel을 binning 하고 있다. 그렇다면, 이렇게 pixel binning 된 이미지는 어떻게 이용되는 것일까?

Demosaic algorithm

스마트폰 Camera에서 사용하는 이미지 센서는 대부분 한 pixel 당 하나의 색만 받아들이는 RAW Bayer 패턴을 사용하고 있다.

이에 따라, 우리가 눈으로 볼 수 있는 이미지로 변환하기 위해선

초록색만 있는 pixel은 주변에서 빨간색, 파란색을 빌려오고

빨간색만 있는 pixel은 주변에서 초록색, 파란색을 빌려오고

파란색만 있는 pixel은 주변에서 빨간색, 초록색을 빌려오는 등 근접 pixel color를 참조하는 작업을 거쳐야 한다.

이렇게 주변의 pixel color를 참조해 한 pixel이 R,G,B 화소값을 갖도록 보간하는 과정을 Demosaic 이라고 부르며 해당 알고리즘 성능에 따라 최종 이미지의 화질이 크게 좌우될 수 있다.

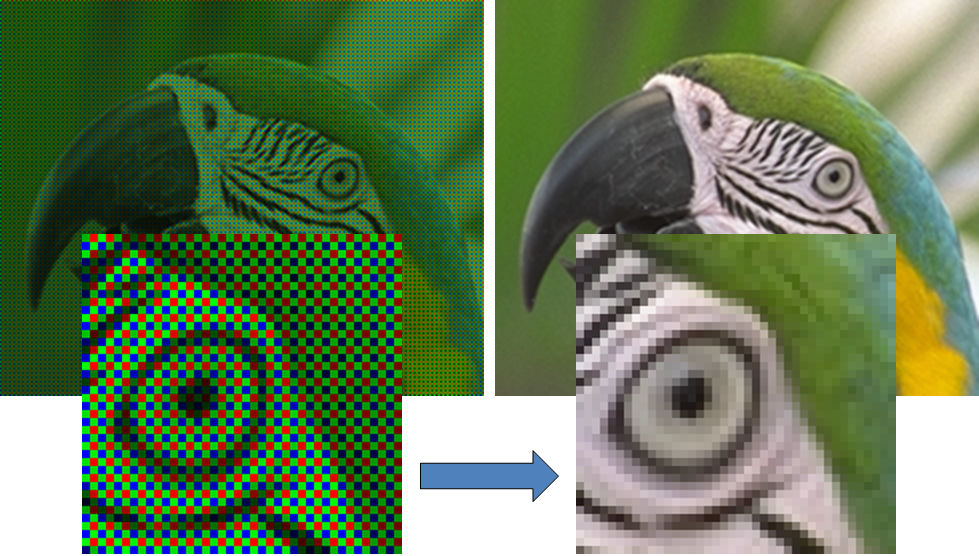

하지만, 다음과 같이 pixel binning이 적용됐을 경우 화소간 거리가 멀어지게 되기에 Demosaic 을 통한 color 해상도 보정력은 RAW bayer 패턴일 때보다 떨어지게 되고

그 결과, 상황에 따라 color 왜곡이 발생하거나 화소가 뭉개지는 결과를 얻을 수도 있다.

즉 pixel binning을 적용하는 것이 하지 않는 것보다 여러모로 장점이 더 많지만, 잃어버린 색을 찾는 Demosaic 과정이 보다 복잡하기 때문에 항상 더 좋은 결과물을 얻을 수 있을 것은 아니란 것이다.

하지만, 여기서 또 한가지 의문이 생기게 된다.

pixel binning을 통해 근접 pixel을 하나로 묶어서 처리한다고 했는데 그렇다면 pixel binning을 적용한 이미지 센서는 본래 자신이 지원하는 48MP, 108MP 등의 최대 해상도 촬영을 어떻게 하는 것일까?

Remosaic algorithm

pixel binning을 통해서 근접 pixel을 묶었지만 48MP, 108MP 등 이미지 센서가 지원하는 최대 해상도 촬영을 하기 위해선 다시 묶은 pixel들을 개별 pixel로 나타내야할 필요가 있다.

하지만, pixel은 실제로 물리적으로 이동하거나 결합하지 않기 때문에 SW 수준에서 RAW Bayer 패턴으로 변환하는 것을 Remosaic 이라고 한다.

이렇게 Remosaic 과정을 통해서 선명도를 잃어버릴 수도 있지만, 결과적으로 각 pixel마다 data를 가지게 되면서 이미지 센서가 최대로 지원하는 사진 크기로 촬영할 수 있는 것이다.

하지만, 반복해서 말했듯이 고해상도를 지원함에따라 각각의 pixel 크기는 이에 비례하여 작아졌으므로 충분한 광량이 있는 곳에서 고해상도 촬영을 해야 의미가 있는 것이다.

그래서 Samsung의 경우 주변 조도에 따라 SW 수준에서 자동으로 Pattern을 변경하여 지원하고있다.

그리고 삼성이 이번에 발표한 200MP ISOCELL HP-1 이미지 센서를 보면

다음과 같이 16(4x4)개 pixel을 하나의 큰 단위로 결합하고 있는 것을 알 수 있으며

상황에 따라 hybrid 형태로 pixel binning 동작 한다는 것을 알 수 있다.

마무리

이렇게 짧게 스마트폰 고해상도 카메라에 대한 개요..? 를 알아봤다.

앞으론 스마트폰 카메라가 점점 어떻게 변할지 기대가 된다!

그리고 물리적인 스마트폰의 한계를 개선하기 위해 끊임없이 노력하는 제조사들에게 박수를 보낸다.🤞