OpenVINO 기능 개요

- CPU/NPU를 위한 LLM 추론 프레임워크

- 모델 양자화 지원

- LLM 저장 포맷을 OV 포맷으로 변환 지원 (OpenVINO 자체 모델 포맷)

- AI Agent를 위한 경량 모델 추론 프레임워크로 활용 가능

설치 프로세스

# for llm inference

pip install openvino-genai

# for OV format conversion

pip install nncf

pip install git+https://github.com/huggingface/optimum-intel.git

# for supporting latest models

pip install -U transformers

모델 변환

optimum-cli export openvino --model $기존모델경로 --task text-generation-with-past --weight-format int4 $변환모델경로

optimum-cli export openvino --model $기존모델경로 --task image-text-to-text --weight-format int4 $변환모델경로

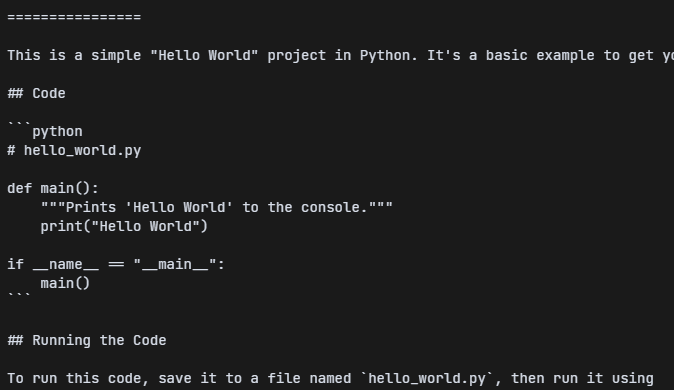

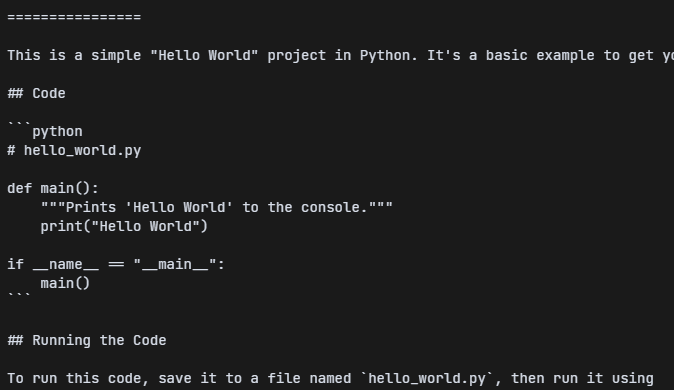

모델 로딩 및 생성

import openvino_genai as ov_genai

pipe = ov_genai.LLMPipeline(OV_MODEL_PATH, "CPU")

pipe.generate("hello world", max_new_tokens=100)

- 생성 예시