로드 밸런싱이란?

서버가 처리해야 할 업무 혹은 요청(Load)을 여러 대의 서버로 나누어(Balancing) 처리하는 것한 대의 서버로 부하가 집중되지 않도록 트래픽을 관리해 각각의 서버가 최적의 퍼포먼스를 보일 수 있도록 하는 것이 목적

서비스의 규모가 커지고, 이용자 수가 늘어나게 되면 기존의 서버만으로는 원활한 서비스 동작이 불가능하게 되고, 이에 대처할 수 있는 방법은 크게 두가지로 나뉜다.

- 기존의 서버 성능을 확장(Sclae-up 방식)

- 기존의 서버와 동일하거나 낮은 성능의 서버를 증설(Scale-out 방식)

이때 Scale-out 방식을 통해 증가한 트래픽에 대처하기로 했다면, 여러대의 서버로 트래픽을 균등하게 분산해주는 로드 밸런싱이 반드시 필요하다.

로드 밸런싱 기법

서버의 능력을 고려하여 분배해야 하기 때문에 서버의 상황에 맞춰 적절한 방법선택해야 한다.

라운드 로빈 방식

서버에 들어온 요청을 순서대로 돌아가며 배정하는 방식

클라이언트의 요청을 순서대로 분배하기 때문에 여러 대의 서버가 동일한 스펙을 갖고 있고, 서버와의 연결(세션)이 오래 지속되지 않은 경우에 활용하기 적합

가중 라운드 로빈 방식

각각의 서버마다 가중치를 매기고 가중치가 높은 서버에 클라이언트 요청을 우선적으로 배분

주로 서버의 트래픽 처리 능력이 상이한 경우 사용되는 부하 분산 방식이다.

EX)

A(Server): 가중치 = 5

B(Server): 가중치 = 2

로드 밸런서는 라운드 로빈 방식으로 A 서버에 5개 B 서버에 2개의 요청을 전달한다.

IP 해시 방식

클라이언트의 IP 주소를 특정 서버로 매핑하여 요청을 처리하는 방식

사용자의 IP를 해싱하여(Hashing, 임의의 길이를 지닌 데이터를 고정된 길이의 데이터로 매핑하는 것, 또는 그런 함수) 로드를 분배하기 때문에 사용자가 항상 동일한 서버로 연결되는 것을 보장한다.

최소 연결 방식

요청이 들어온 시점에 가장 적은 연결상태를 보이는 서버에 우선적으로 트래픽을 배분

자주 세션이 길어지거나, 서버에 분배된 트래픽들이 일정하지 않은 경우에 적합한 방식이다.

최소 응답 시간 방식

서버의 현재 연결 상태와 응답 시간(서버에 요청을 보내고 최초 응답을 받을 때 까지 소요되는 시간)을 모두 고려하여 트래픽을 배분

가장 적은 연결 상태와 가장 짧은 응답 시간을 보이는 서버에 우선적으로 로드를 배분하는 방식이다.

L4 로드 밸런싱과 L7 로드 밸런싱

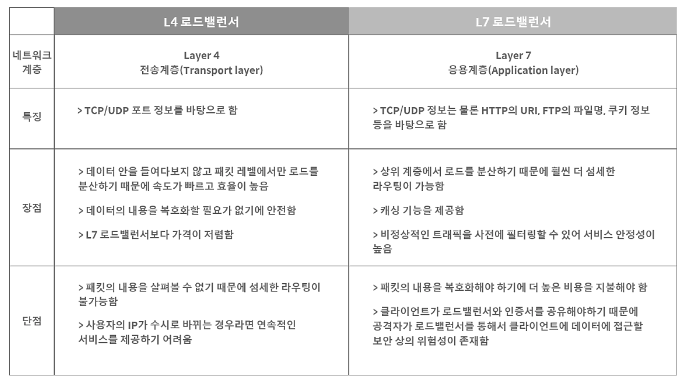

L4, L7은 각각 Layer 4(전송 계층) 프로토콜과 Layer 7(응용 계층) 프로토콜의 헤더를 부하 분산에 이용하기 때문에 붙은 접두사이다. 모든 요청을 L4 혹은 L7 로드 밸런서가 받아 서버들에게 적절히 나누어 준다.

L4 로드 밸런서

네트워크 계층이나 전송계층의 정보(IP 주소, 포트번호, MAC 주소, 전송 프로토콜)를 바탕으로 로드를 분산

L7 로드 밸런서

애플리케이션 계층에서 로드를 분산하기 때문에 HTTP 헤더, 쿠키 등과 같은 사용자의 요청을 기준으로 특정 서버에 트래픽을 분산하는 것이 가능하다.

쉽게 말해 패킷의 내용을 확인하고 그 내용에 따라 로드를 특정 서버에 분배하는 것이 가능한 것이다.

URL에 따라 부하를 분산시키거나, HTTP 헤더의 쿠키 값에 따라 부하를 분산하는 등 클라이언트의 요청을 보다 세분화해 서버에 전달 할 수 있다.

또한 L7 로드 밸런서의 경우 특정한 패턴을 지닌 바이서를 감지해 네트워크를 보호 할 수 있으며, Dos/DDos와 같은 비정상적인 트래픽을 필터링 할 수 있어 네트워크 보안 분야에서도 활용되고 있다.