paper with code

다 읽고 쓰려고 했는데 오늘 읽은데까지만 쓰고 자야겠습니다!

(감기이슈)

title과 abstract

논문 제목은 AN IMAGE IS WORTH 16X16 WORDS: TRANSFORMERS FOR IMAGE RECOGNITION AT SCALE 입니다. 이미지 인식을 위한 transformer를 설명합니다.

Transformer Architecture는 원래 자연어 처리 작업을 위해 설계되었습니다.

컴퓨터 비전 분야에서 이미지 인식 작업에 transformer를 적용합니다.

기존의 빙법은 CNN과 결합되거나 CNN의 일부 구성 요소를 대체하는 방식으로 사용되었으나, 이 논문의 kick은 이미지 패치를 사용함으로써 이미지를 작은 패치로 나누고 이 패치들을 순차적으로 transformer에 입력으로 처리하면서 NLP의 token처럼 취급하여 처리한다는 점입니다.

이로 인해 많은 양의 데이터를 사전 학습한 후 전이 학습을 합니다.

introduction과 conclusion

Transformer는 NLP에서 훌륭한 성과를 보이며 널리 사용되고 있습니다.

transformer를 응용하여 이미지를 직접 학습하는 Vision Transformer 모델을 도입했습니다.

이미지를 패치(patch)로 나누고 각 패치를 NLP의 단어(token)처럼 처리합니다.

ImageNet과 같은 중간 크기 데이터셋에서 학습 시, 기존 ResNet보다 성능이 약간 떨어집니다. 이유는 transformer가 CNN의 고유 편향(translation equivariance, locality)과 같은 특성 부족때문입니다.

그러나 14M-300M 이미지로 이루어진 대규모 데이터셋에서 학습 시 뛰어난 성능으로 고유 편향 문제를 극복할 수 있습니다.

ImageNet-21k, JFT-300M 데이터셋에서 사전 학습 시 여러 이미지 인식 벤치마크에서 SOTA(State of the Art)에 도달하거나 성능을 능가합니다.

대규모 데이터셋으로 사전 학습(pre-training)할 때 놀라울 만큼 좋은 성능을 보입니다.

Vision Transformer(ViT)는 여러 이미지 분류 데이터셋에서 최첨단 수준의 성능을 달성하거나 이를 초과합니다. 상대적으로 사전 학습 비용이 저렴합니다.

challenge

탐지가나 세분화 같은 다른 컴퓨터 비전작업에 ViT를 적용할 수 있습니다.

초기 실험에서 자기 지도 사전학습을 통해 개선을 보였으나, 자기 지도 학습과 대규모 지도 학습 사이에는 여전히 큰 격차가 있습니다.

ViT의 성능을 더욱 개선시키기 위해 모델의 크기를 확장해야 합니다.

figures

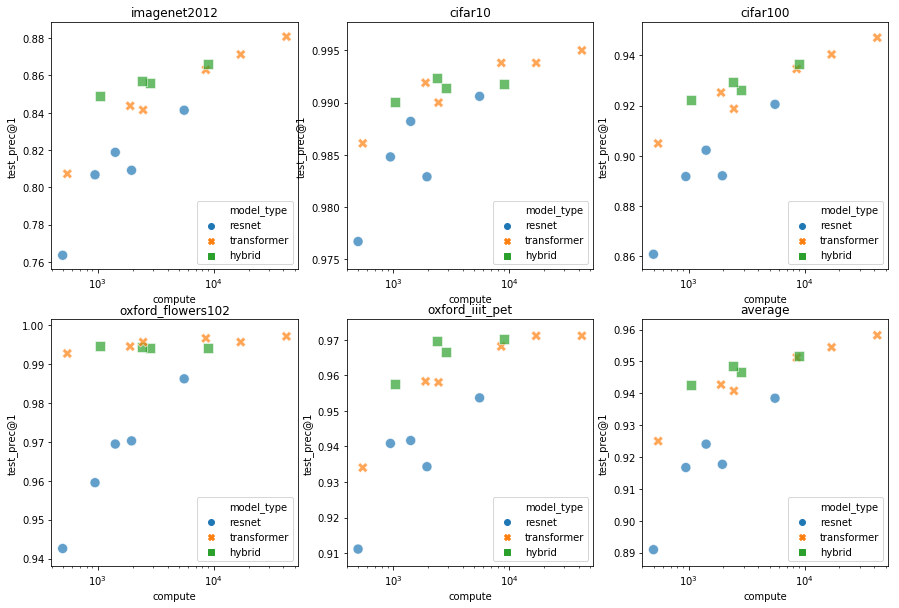

실험 조건

Vision Transformer(ViT) 모델을 다양한 크기의 데이터셋에서 사전 학습했다.

데이터셋 크기: ImageNet, ImageNet-21k, JFT-300M.

더 작은 데이터셋에서 성능을 높이기 위해 세 가지 기본 정규화 매개변수(weight decay, dropout, label smoothing)를 최적화했다.

실험 결과

- 작은 데이터셋 (ImageNet)

ViT-Large 모델이 ViT-Base 모델보다 성능이 낮다.

ViT는 작은 데이터셋에서는 ResNet보다 더 많은 과적합(overfit)을 보인다.

작은 데이터셋 (9M)에서 ViT-B/32는 ResNet50보다 성능이 낮다. - 중간 크기 데이터셋 (ImageNet-21k)

ViT-Large 모델과 ViT-Base 모델의 성능이 비슷하다. - 큰 데이터셋 (JFT-300M)

더 큰 모델(ViT-Large)이 더 작은 모델보다 성능이 크게 향상된다.

작은 데이터셋에서는 컨볼루션 네트워크의 inductive bias이 더 유용하다.

큰 데이터셋에서는 데이터 자체로부터 패턴을 학습하는 것이 충분하고 유익하다.

실험 결론

큰 데이터셋에서 더 큰 ViT 모델의 장점이 극대화된다.

정규화 매개변수의 최적화를 통해 작은 데이터셋에서도 성능을 어느 정도 유지한다.