RNN 활성함수를 TANH를 쓰는 이유

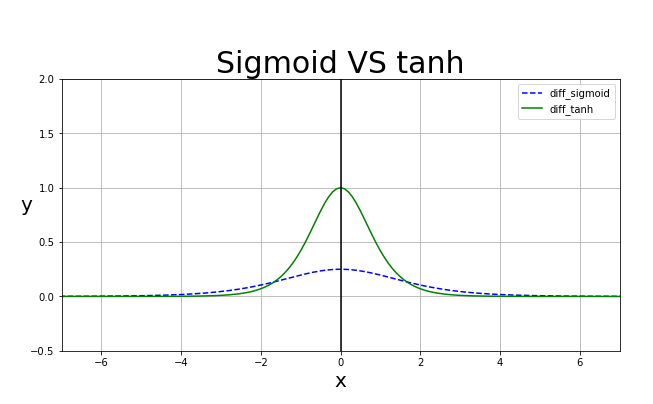

하이퍼볼릭 탄젠트 는 시그모이드와 비슷하게 생겼습니다.

미분시 이렇게 표현됩니다.

순전파(Propagation) 관점에서 Relu와 Tanh, sigmoid는 전부 비선형 함수이지만 tanh는 -1~1사이에 y값이 존재하며 sigmoid는 0~1사이에 y값이 위치합니다. 하지만 relu는 x가 양수가 되는 지점에서 y=x 형상을 지니고 있습니다. rnn계열은 같은 레이어를 여러번 반복하는 성질을 가지고 있어 x가 1보다 큰값이 들어오게 되면 레이어가 반복하면서 값이 발산할수 있습니다. 예로 1.5의 8승은 25.6289으로 발산합니다. 따라서 tanh 나 sigmoid를 사용합니다. 한편 역전파(Back Propagation)관점에서는 tanh가 sigmoid보다 미분 최대값이 더 크기 때문에 vanishing gradinent 문제에 더 잘 버티는 것은 tanh 입니다. 따라서 tanh함수를 활성함수로 씁니다.