Kafka Connect?

Kafka 메시지 시스템

(Broker | Producer | Consumer)를 기반으로

다양한 데이터 소스 시스템에서 발생한 데이터 이벤트를

다른 데이터 타겟 시스템으로

별도의 Kafka Client 코딩 없이,

Seamless하게 실시간으로 전달하기 위해 만들어진데이터 통합 도구

Data Integration (데이터 통합) 변천사

1. EAI (Enterprise Architecture Integration)

기업 내 필요한 여러 애플리케이션(채널)이 있을텐데 이런 각종 애플리케이션 간에 상호 연동이 가능하도록 통합하는 솔루션

2. CDC (Change Data Capture)

데이터베이스에서 변경된 데이터를 감지하고 이를 캡처하여 실시간으로 추적하는 기술

3. Kafka Connect

분산 데이터 통합 플랫폼의 한 부분으로, 다양한 소스 및 대상 시스템 간에 데이터를 이동시키는 기능을 제공

Kafka Connect의 활용

Data Pipeline

- 데이터 파이프라인에서 사용되어 여러 소스 및 대상 시스템 간에 대량의 데이터를 안정적으로 이동하고 중계할 수 있는 플랫폼을 제공합니다.

Data Warehouse ETL

- 데이터 웨어하우스의 데이터를 추출하고 변환한 후, 데이터 웨어하우스로 효율적으로 로드하여 분석에 활용합니다.

Micro Service

- 마이크로서비스 아키텍처에서 다양한 서비스 간의 비동기적인 통신을 지원하며, 서비스 간에 발생하는 이벤트 기반의 통합을 단순화하는 데 활용됩니다.

Database Off Loading

- 데이터베이스 오프로딩에서 Kafka Connect는 실시간으로 데이터베이스에서 변경된 데이터를 캡처하고, 이를 대상 데이터베이스나 데이터 웨어하우스로 전송하여 부하를 줄이고 확장성을 향상시킵니다.

Kafka Connect 구성요소

Connector

Kafka Connect에서

데이터를 소스나 대상 시스템으로 이동시키는 특정 데이터 소스 또는 대상 시스템과의 통합을 담당하는 모듈

Transformation

Kafka Connect에서

데이터의 형식을 변환, 필터링하거나 재구성하는 역할을 하는 모듈

Convertor

Kafka Connect에서

데이터의 직렬화 및 역직렬화를 담당하는 모듈

Config

Kafka Connect에서

각 Connector 및 Transformation의 동작을 제어하기 위한 설정을 관리하는 모듈

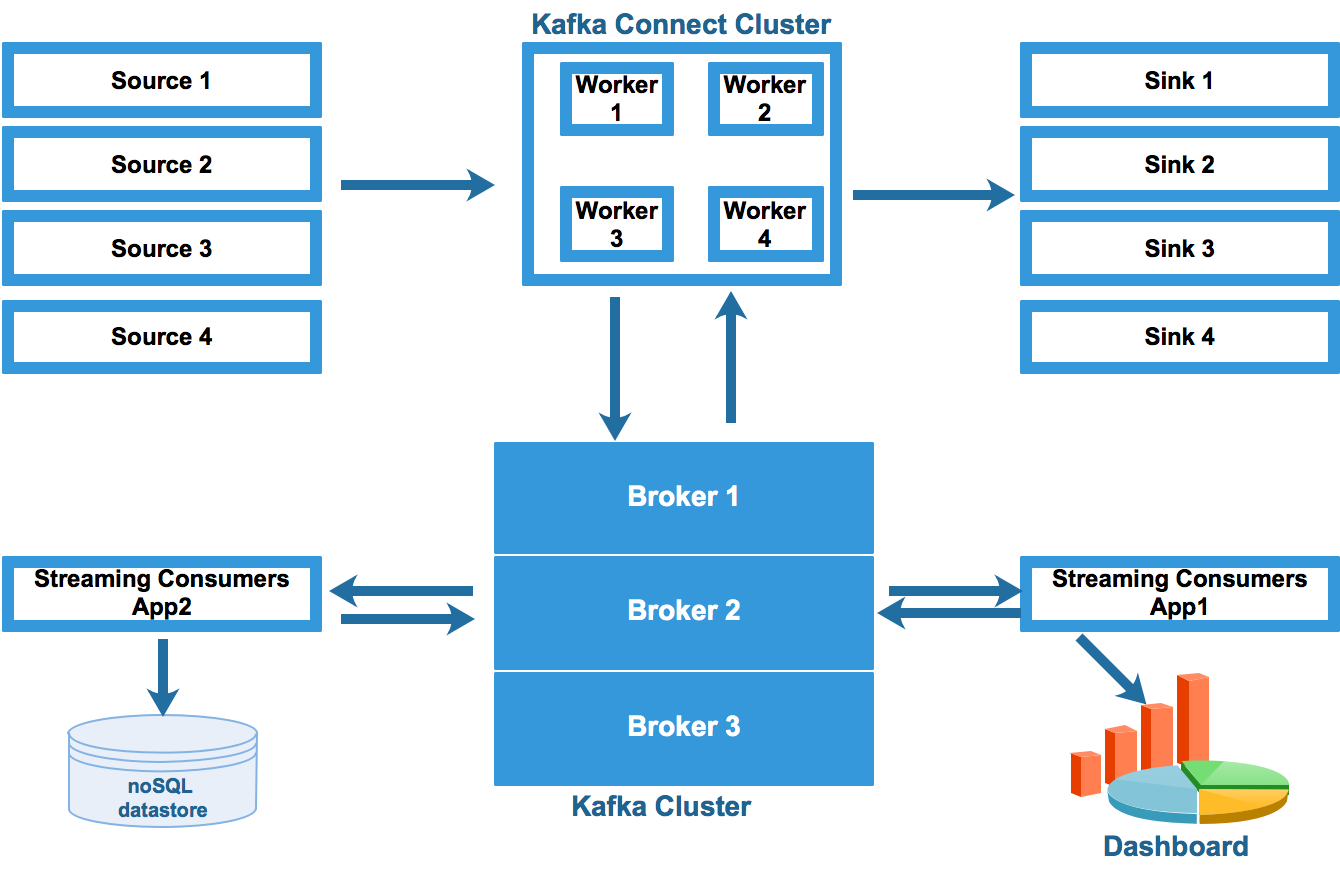

Connect Cluster Architecture

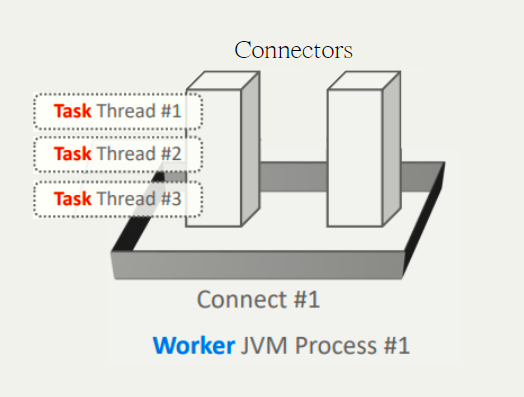

즉, Kafka Connect Cluster 내에

Worker는 단일 Connect Process를 의미한다.

Connect는

Connector를 기동시키기 위한 Framework를 갖춘 JVM Process Model

Connector Instance의 실제 수행은 Thread 레벨로 수행

-> Task

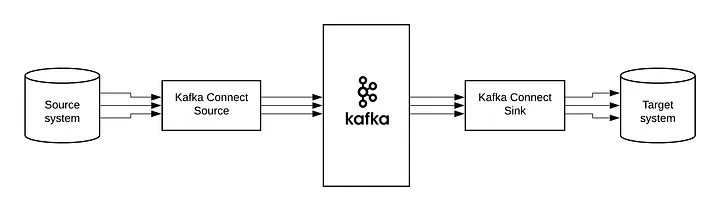

Connector의 유형

Source Connector

Source 시스템에서 Kafka Broker로 데이터 전송

Sink Connector

Kafka Broker에서 Target 시스템으로 데이터 전송