24' google cloud summit

Welcome to innovators

- 고가용성을 위한 cloud 구축의 필요성

- data ai 를 위한 리소스

- 클라우드의 상호호환성이 중요 ㅋㅋ

(근데 얘내들도 outbound 는 돈받음) - 보안강화 (당연한거긴함)

planet-sacle protection ㅋㅋㅋㅋㅋ - 비용 최적화 (scale-up, scale-out)

provides near-real-time or short lag for biling data and alerts

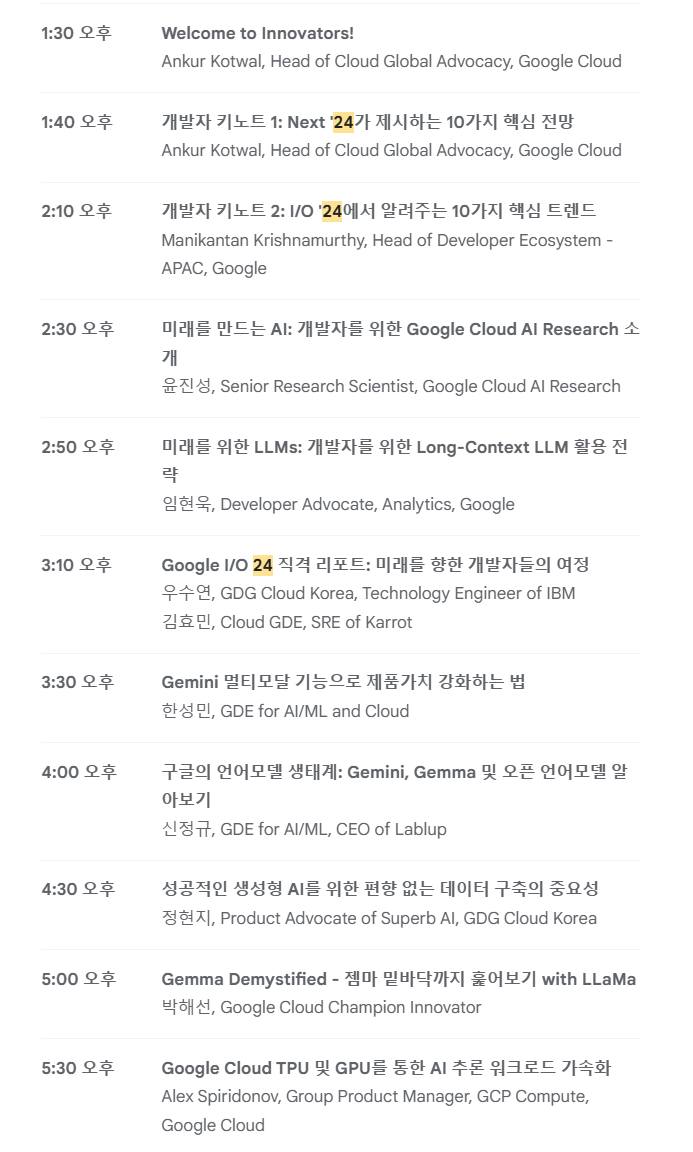

개발자 키노트1 : Next'24 제시하는 10가지 핵심 전망

wht's new AI

Gemini 1.5 pro

2M context winodw, context caching

1M for high-volume tasks where cost and latency matter

(with low cost)

Hugging face intergration with Vertex AI

published model hugging face

(based by domain)

promt management

(version history and management)

google cloud infrastructure (GPU/TPU)

vertex ai agents

(using natural language)

langchain on verex AI

(flameworks에 따라 다르지만 최대한 지원하는편)

langchain을 어떻게 이용하는지 보여주는 부분이 필요 (개발형 모델을 선택하고 도구 정의 - 오케스트레이션 앱 간리형 배포)

Ground with google search

vertex ai search (out of the box)

Rag system APIs Call (by myself)

Firebase **이거 뭔지 모름

https://appmaster.io/ko/blog/paieobeiseuran-mueosibnigga

개발자

liner google (tool)

Gemma open models

LLM (미래를 만드는 AI 개발자를 위한 GOOGLE CLOUD AI RESEARCH)

gEMINI 1.5 FLASH 검새기반 답변 기술이 필요

COLUD AI 검진 엔진

유저질문 > 클라우드 AI 검색엔진 > 답변 (관련된 고객 문서)

(검색엔진의 맞춤화) - 이거 아마도

llms distillation (증류) : 더 작교 효율적인 모델로 합축하는 기술

prompt engineering 까지해서

답변이 나오는 이유까지

vertex AI

LLMs 관련 진행연구

(정형 데이터 행성 )

context 크기 비교

long context 토큰의 갯수가 연관이 있기때문에

multi-turn

long context or RAG

CHATBOT은 RAG을 적용하기 좋을것임

멀티모달은 Long context로 적용하기 좋을 것임

Gemini 멀티모달 기능으로 제품가치 강화하는 법

long context 학습시간이 오래 걸릴것임!!