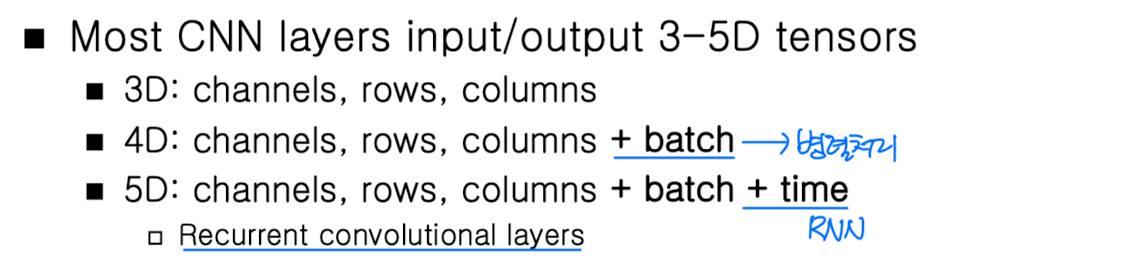

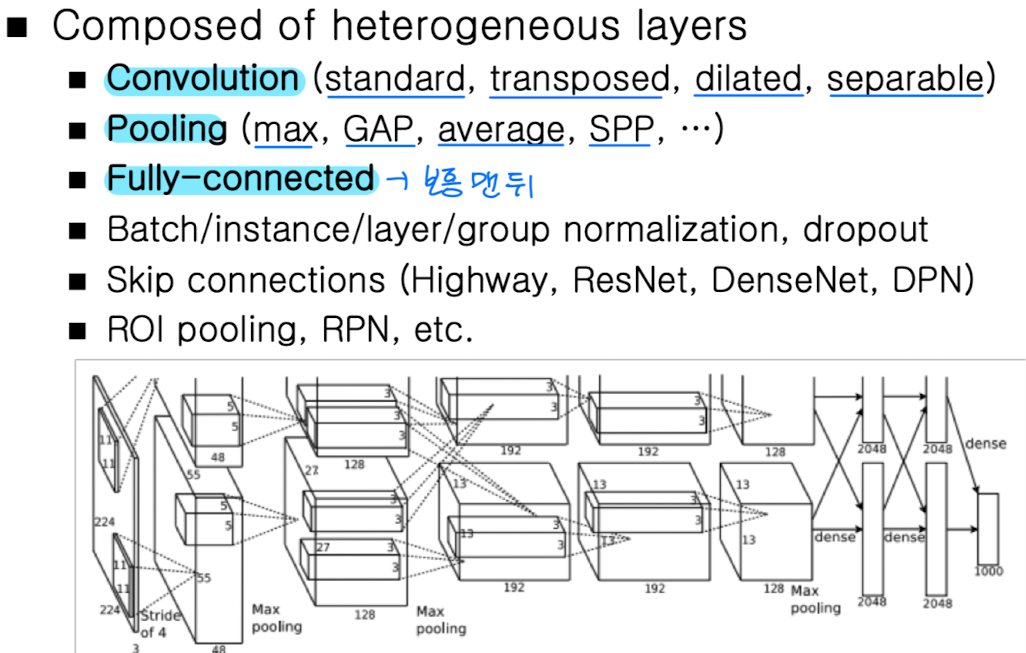

Fundamentals of CNNs

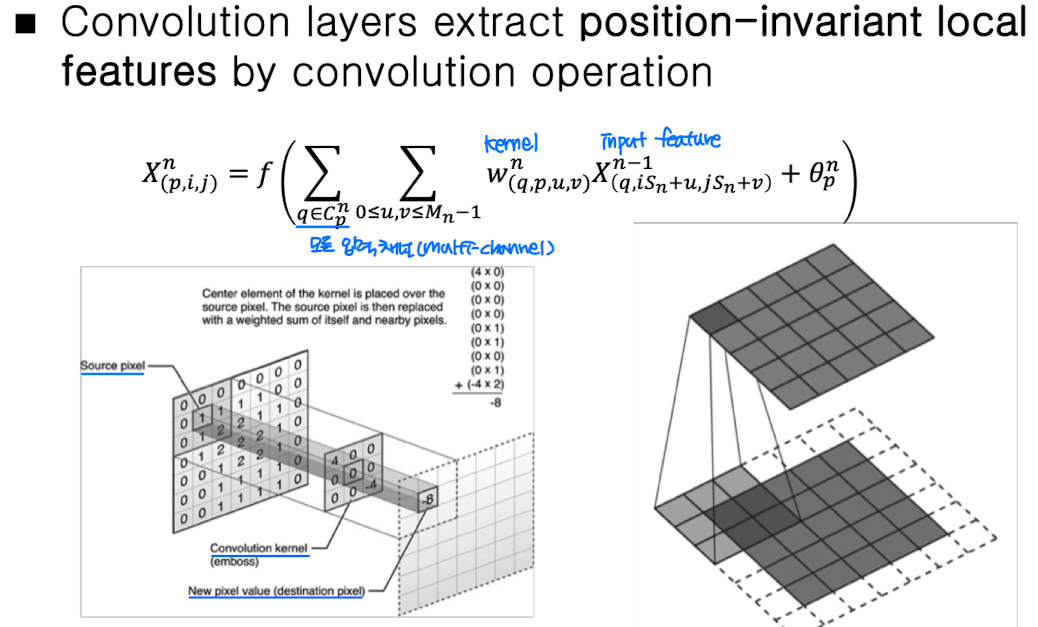

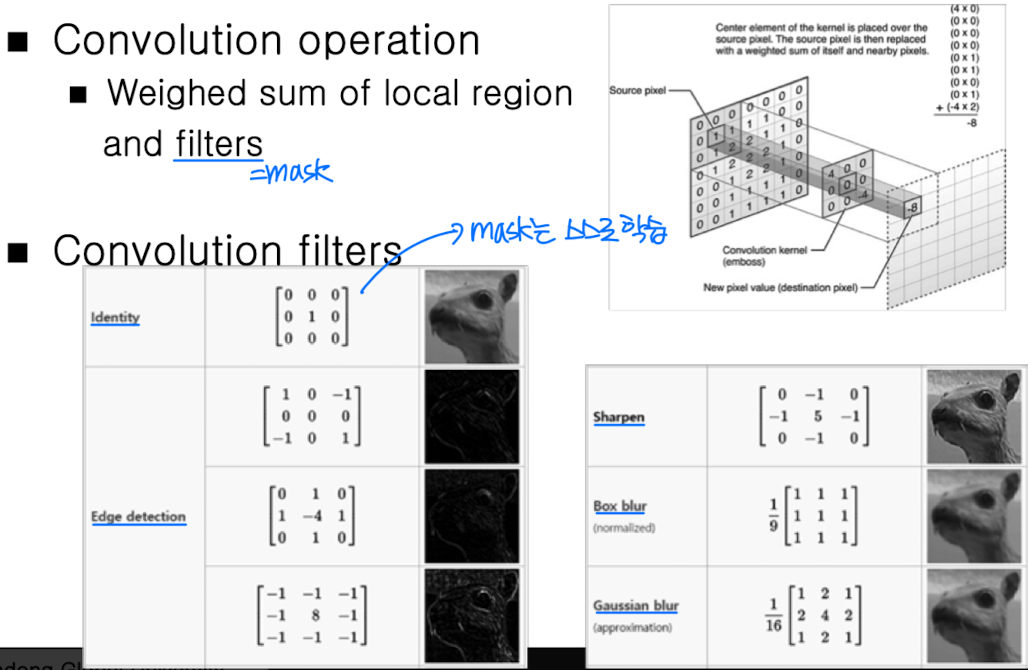

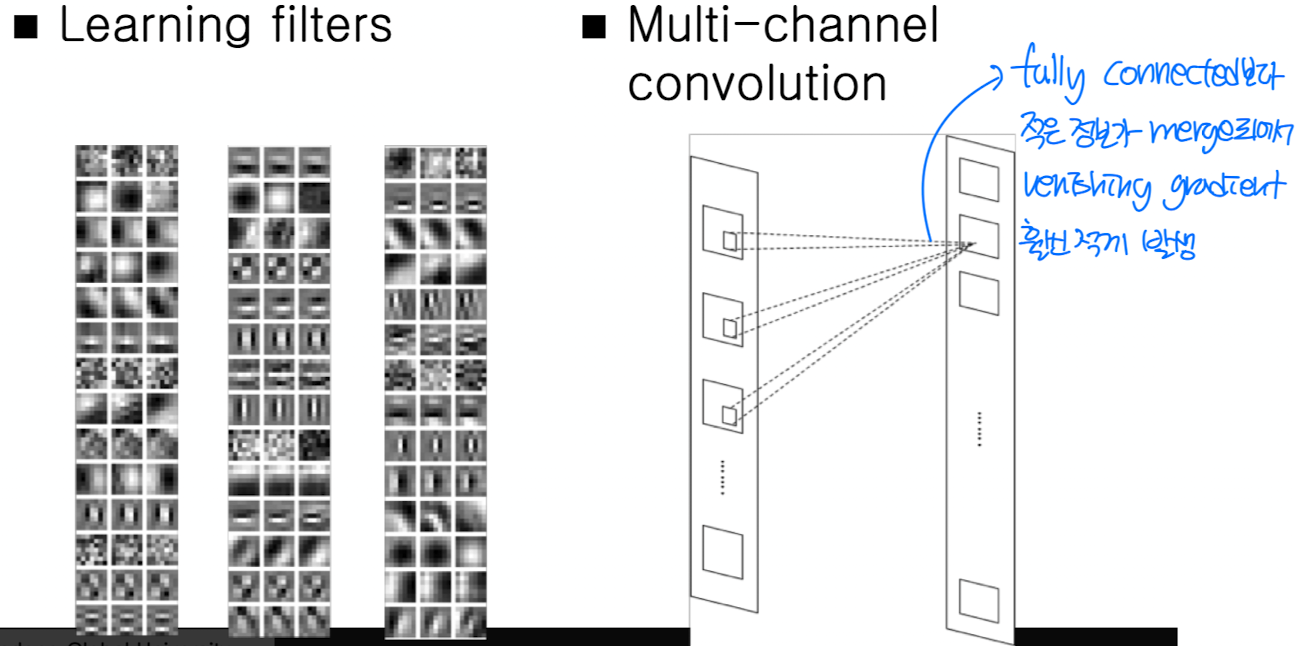

Convolution Layers

➡️ 여러 operation 가능

➡️ position invariant한 값을 추출하는 역할

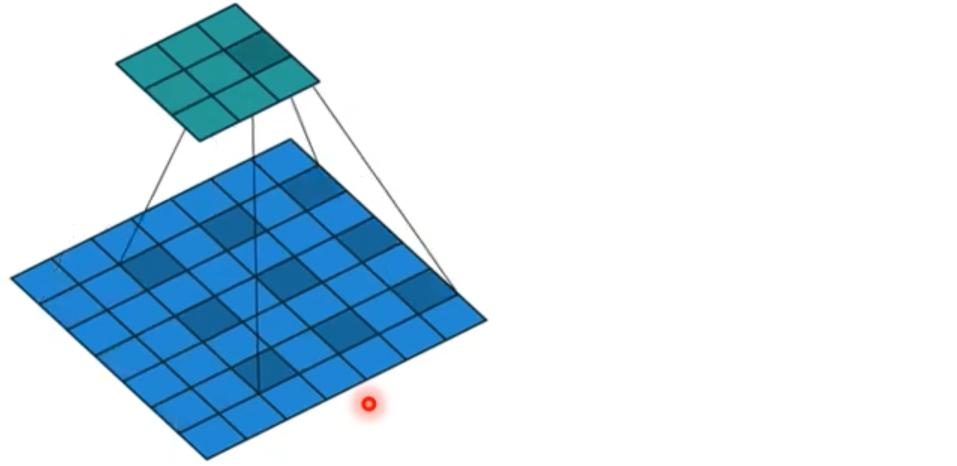

Astrous Convolution ( Dilated Conv )

➡️ Reduces computation and parameters ( weights )

➡️ Receptive field ( local feature가 커버하는 영역 ) 크기가 커짐

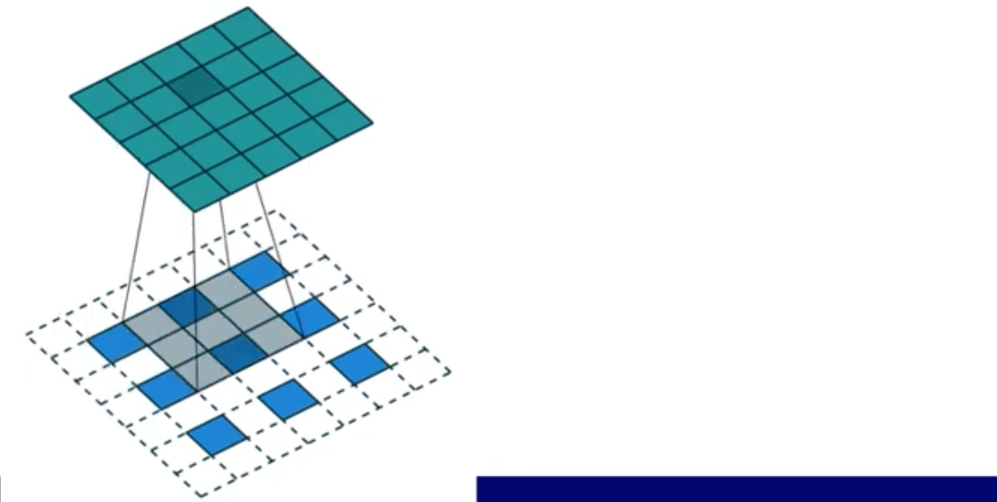

Transposed Convolution

A.k.a. "fractionally-strided conv", "deconvolution"

➡️ Feature upsampling ( size가 커짐 )

Ex_ 3 x 3 ➡️ 5 x 5

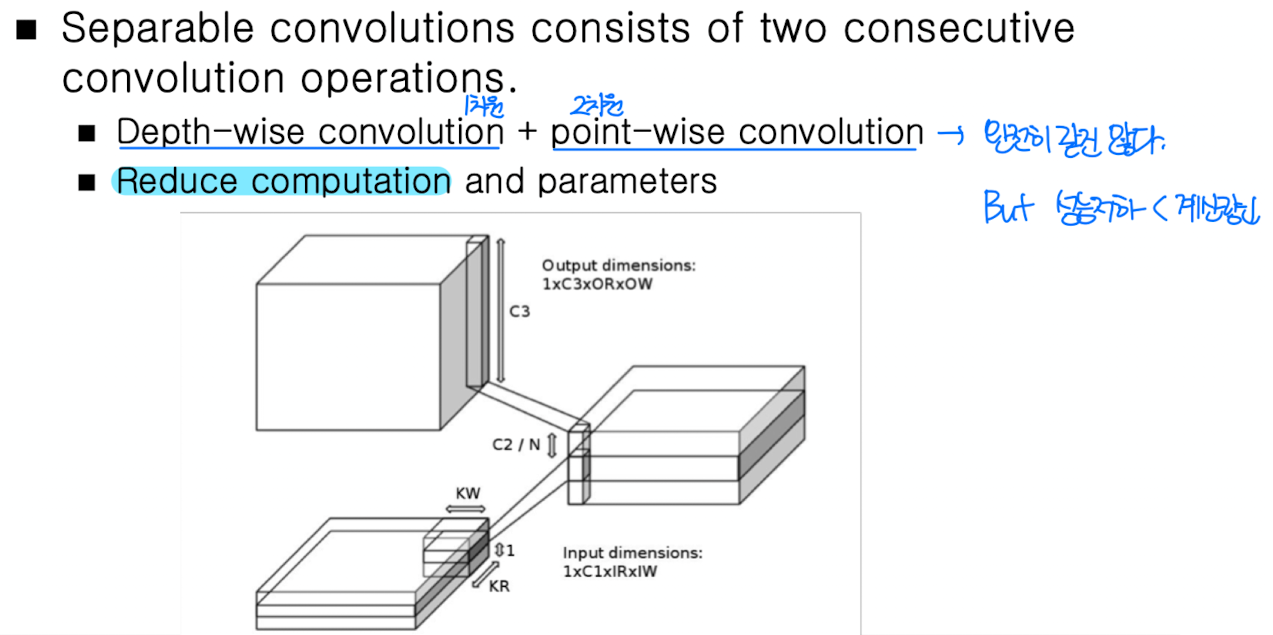

Separable Convolution

➡️ 대표적으로 Mobile net

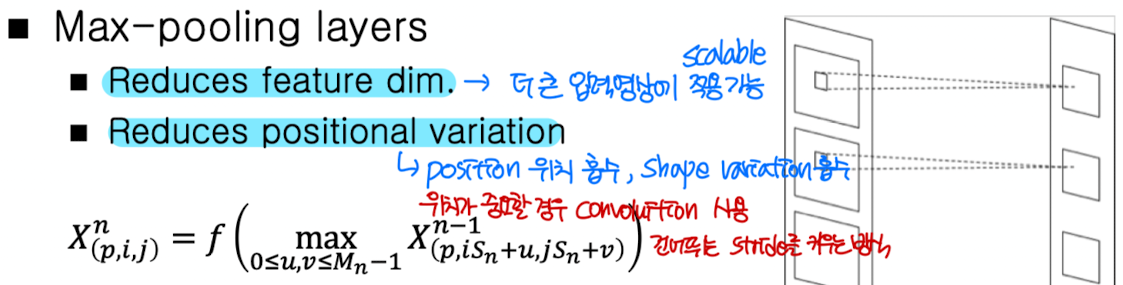

Max-Pooling Layers

➡️ in classfication, Max Pooling > Avg Pooling

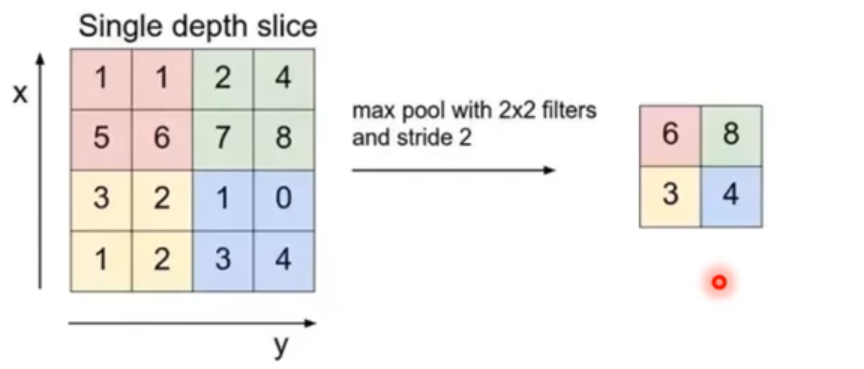

Fully-connected Layers

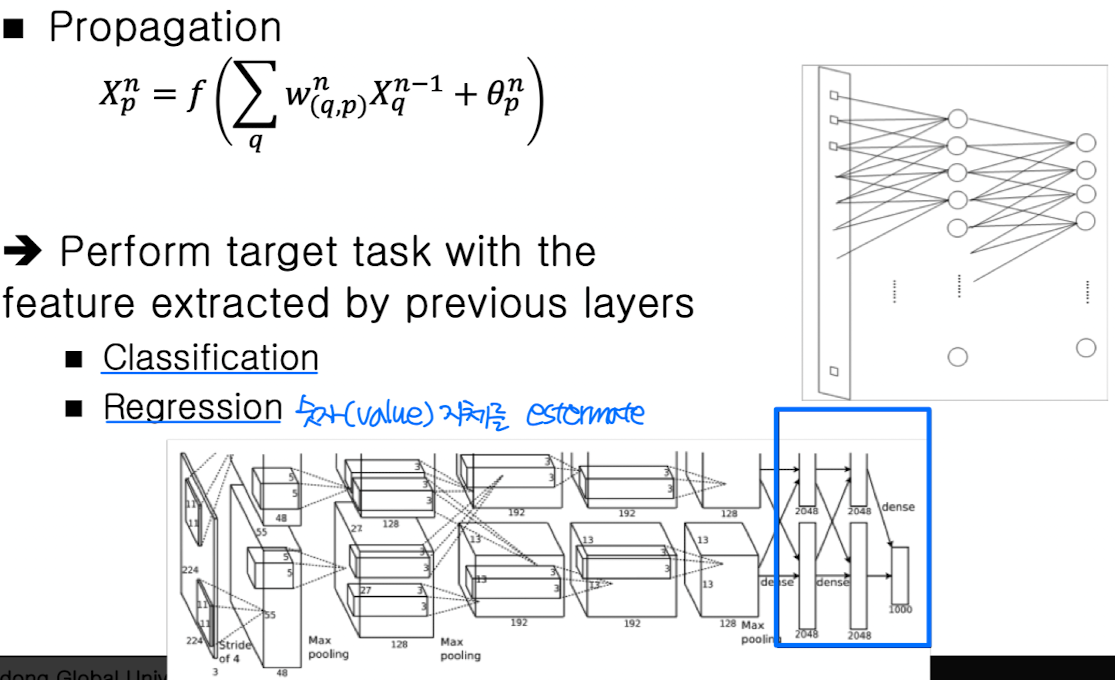

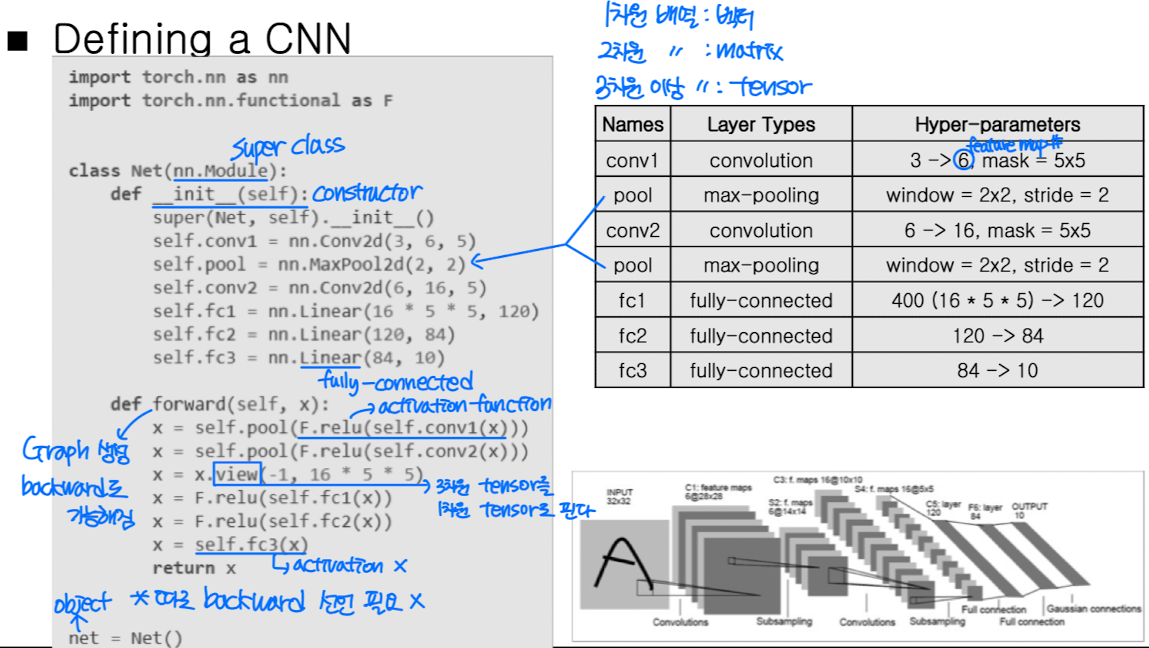

CNN in PyTorch

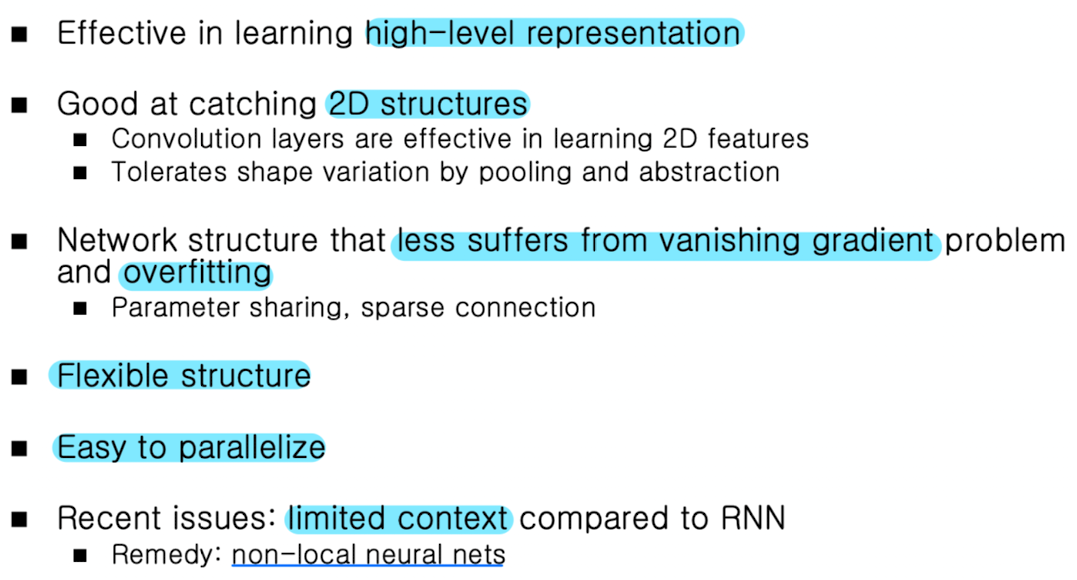

Why CNN Works Well?

Training of CNN

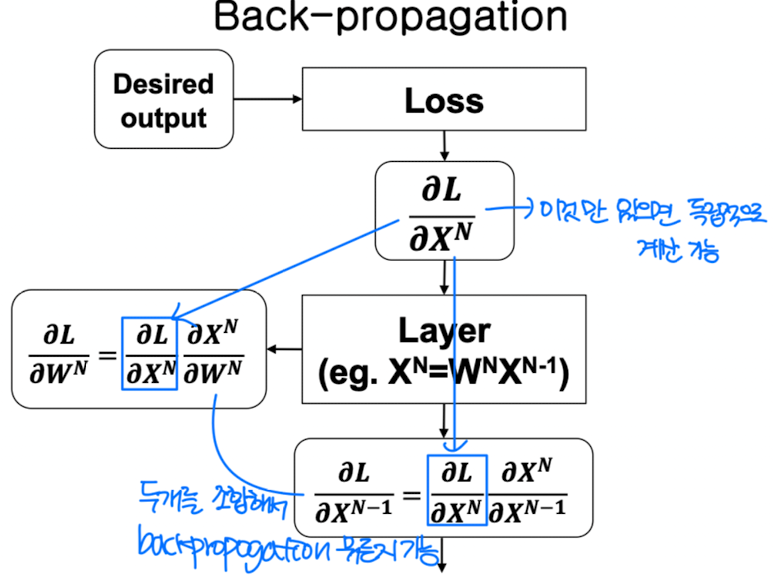

Back-Propagation

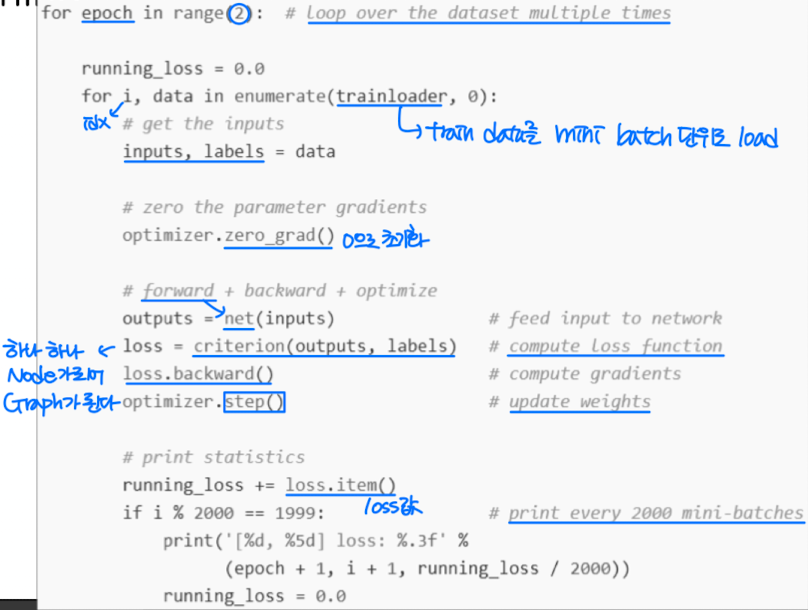

CNN in PyTorch

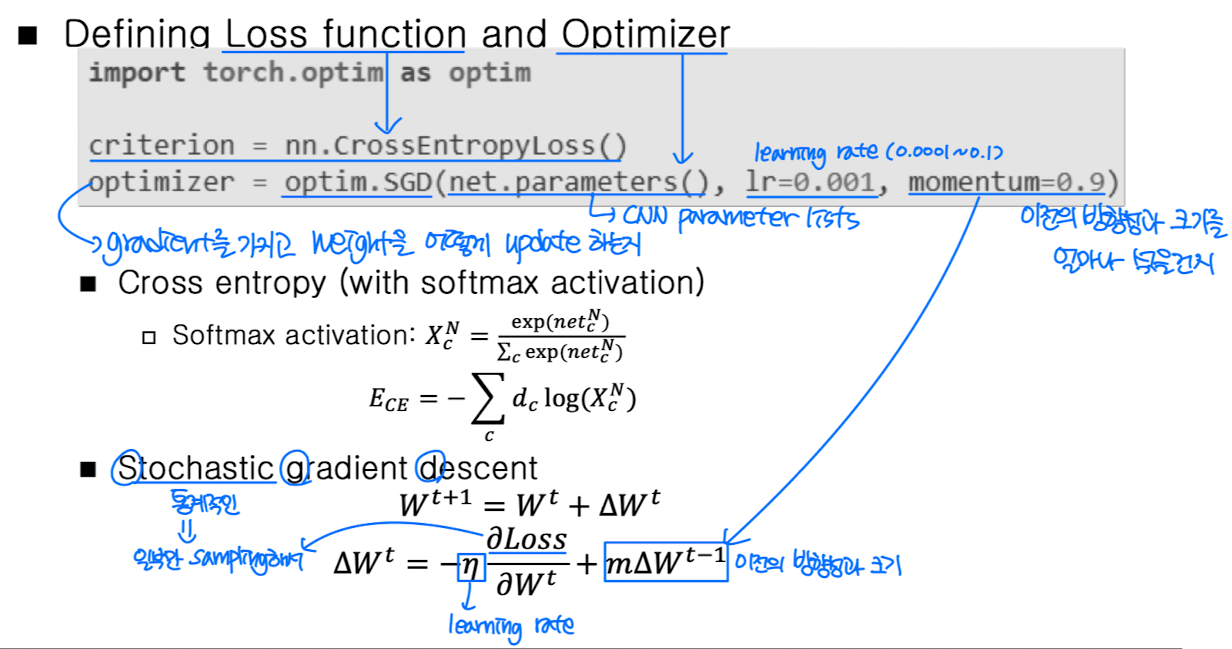

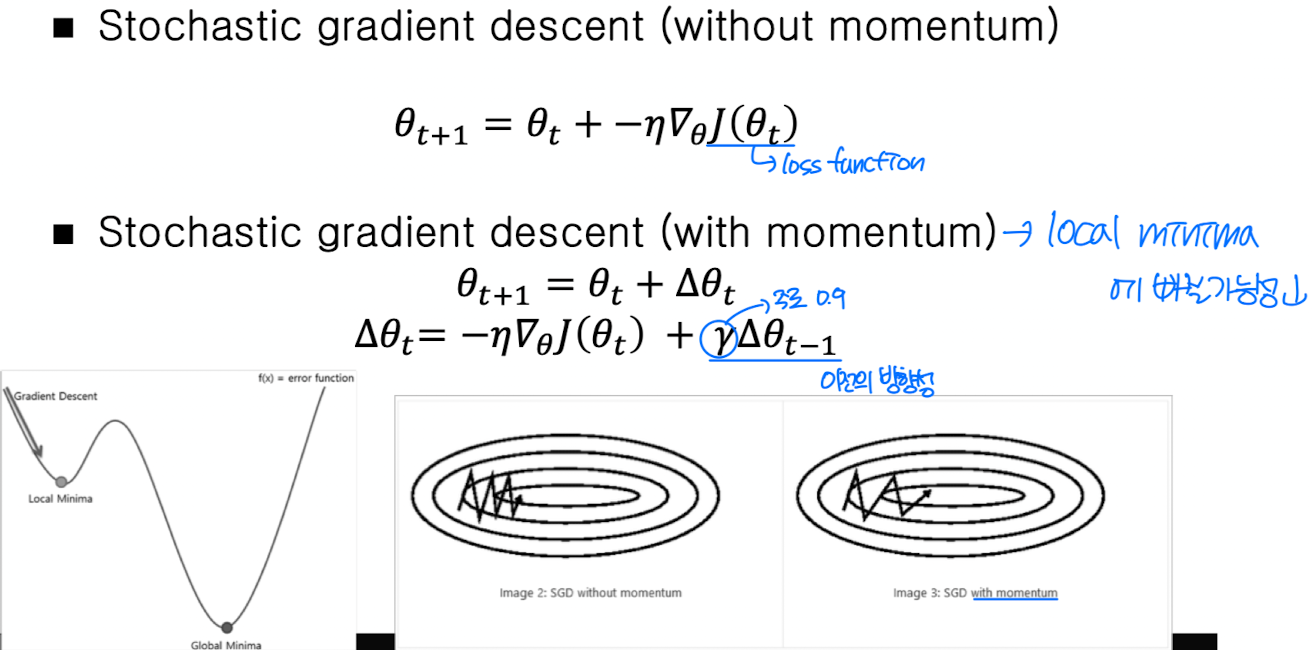

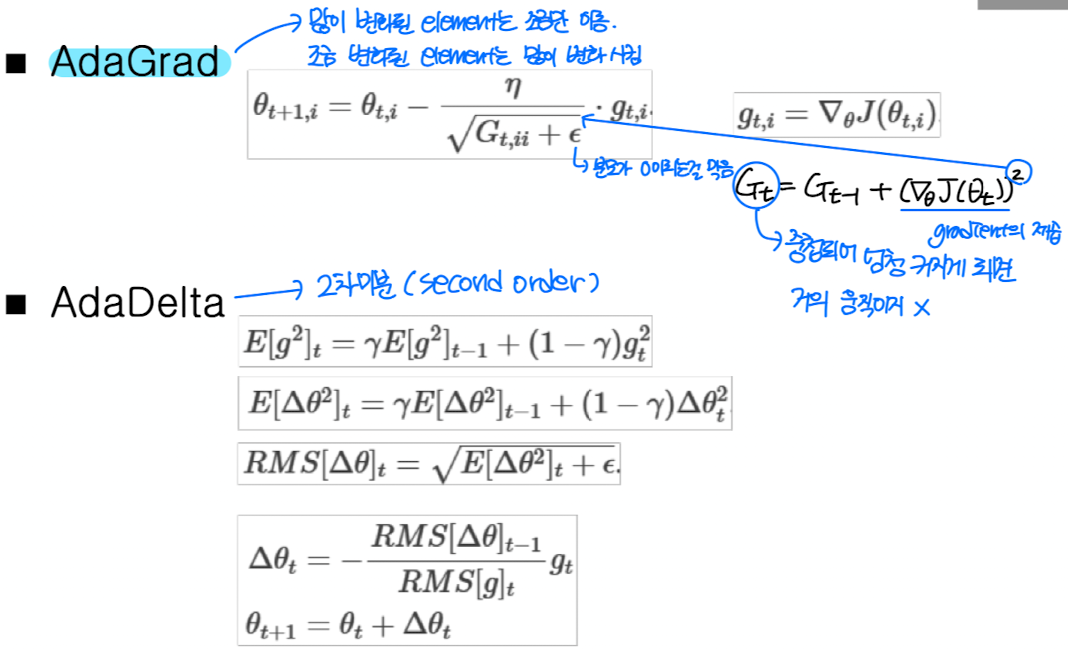

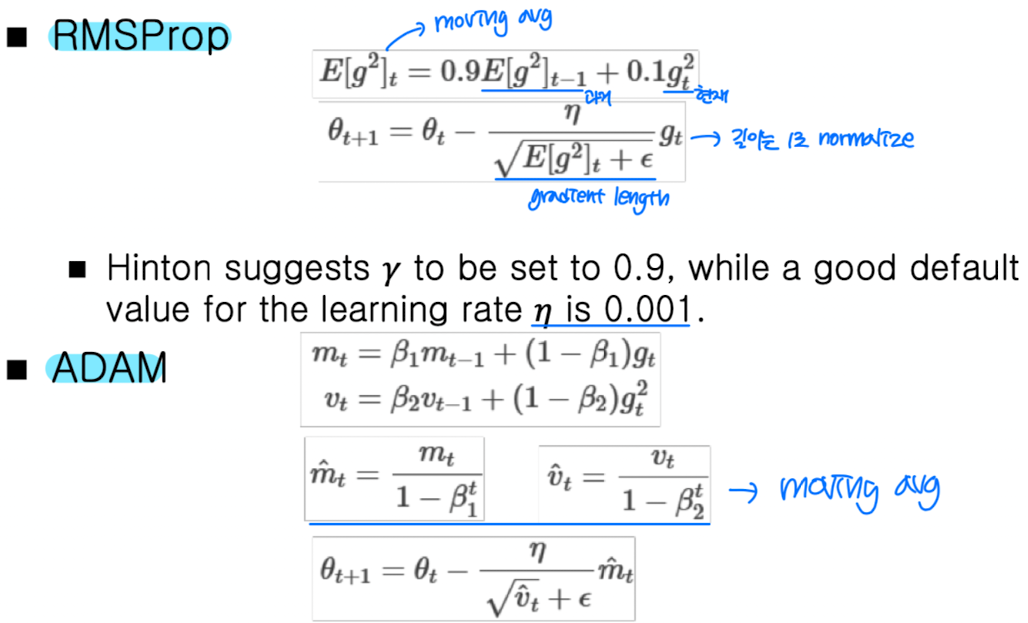

Optimization Algorithms

➡️ ADAM은 길이 뿐아니라 방향성에 대해서도 moving avg를 취함

➡️ 대부분 ADAM or RMSProp 사용

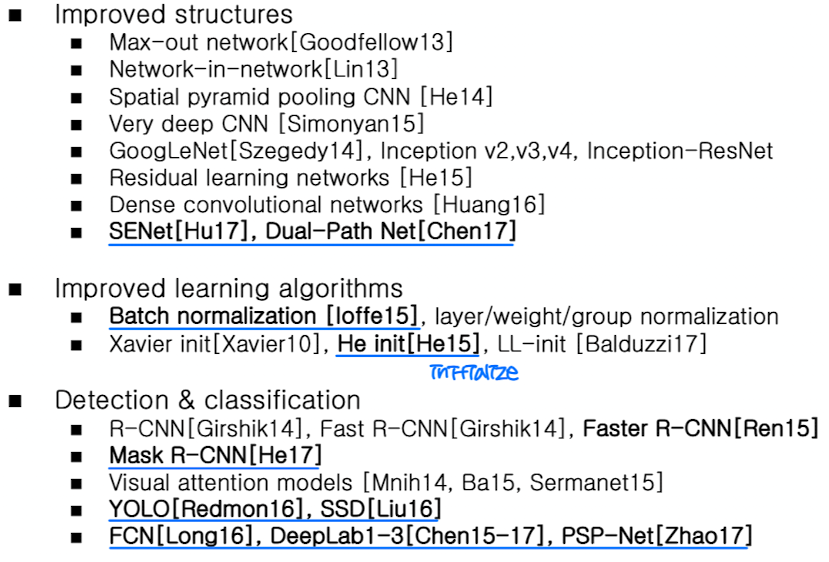

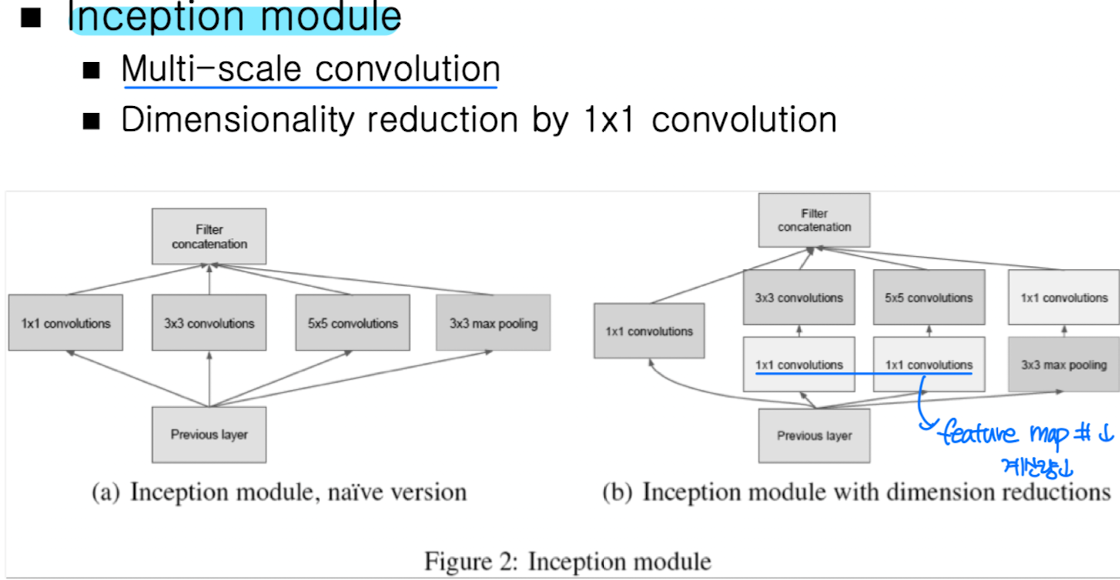

Advanced CNN Models

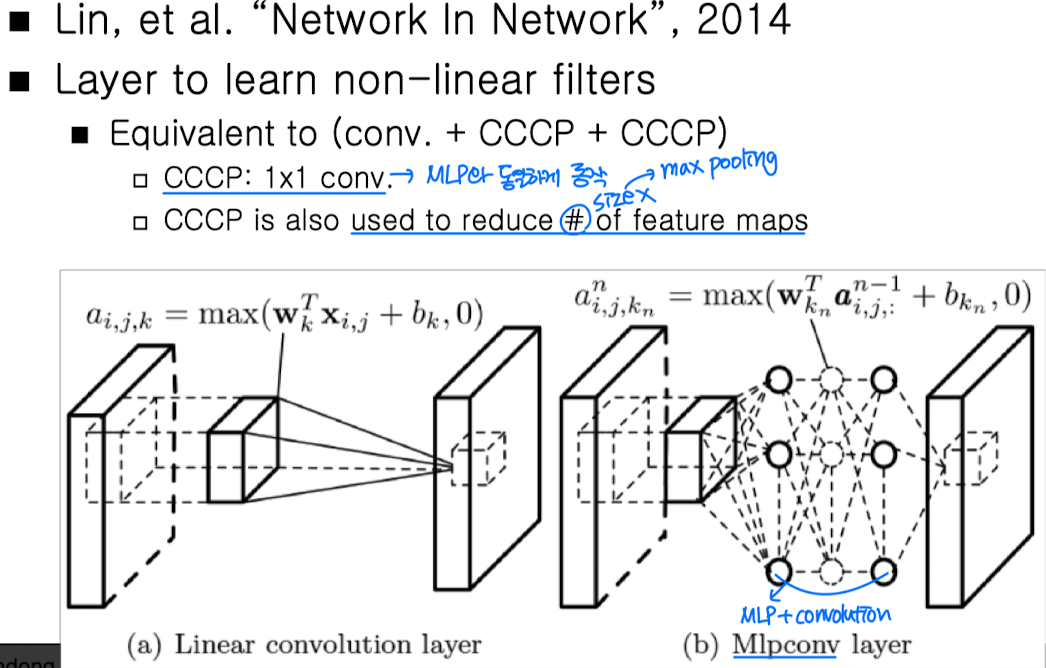

MLPconv Layer

➡️ 1x1 conv : feature maps # ⬇️

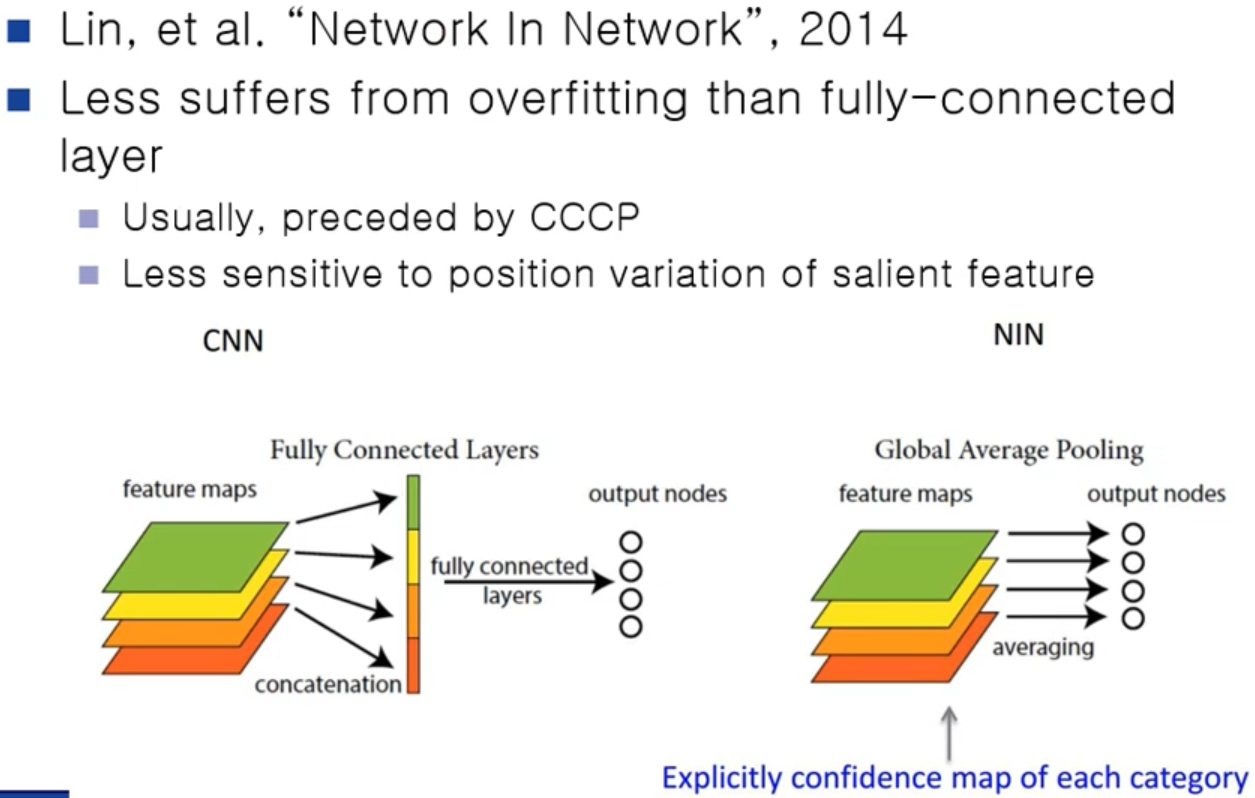

Global Average Pooling

➡️ Overfitting ⬇️

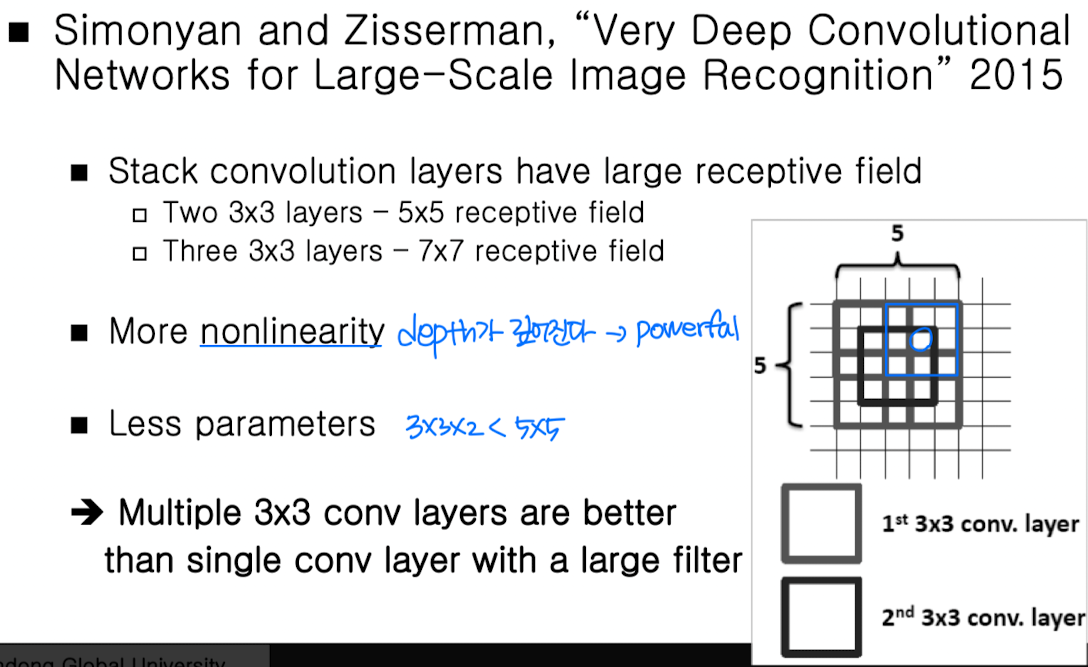

VGG Net

➡️ for Classification ( Detection, Segmentation X )

GoogLeNet

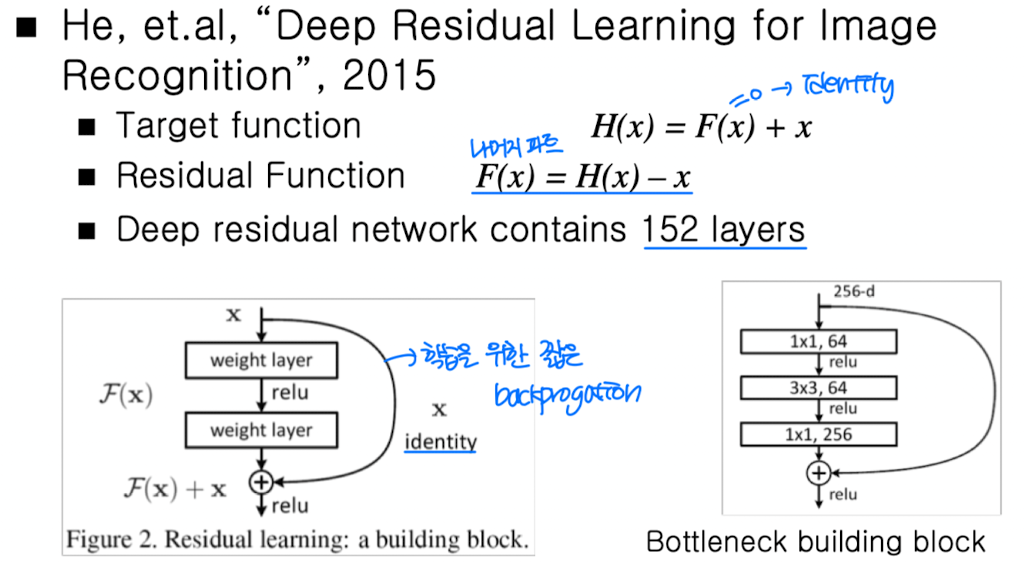

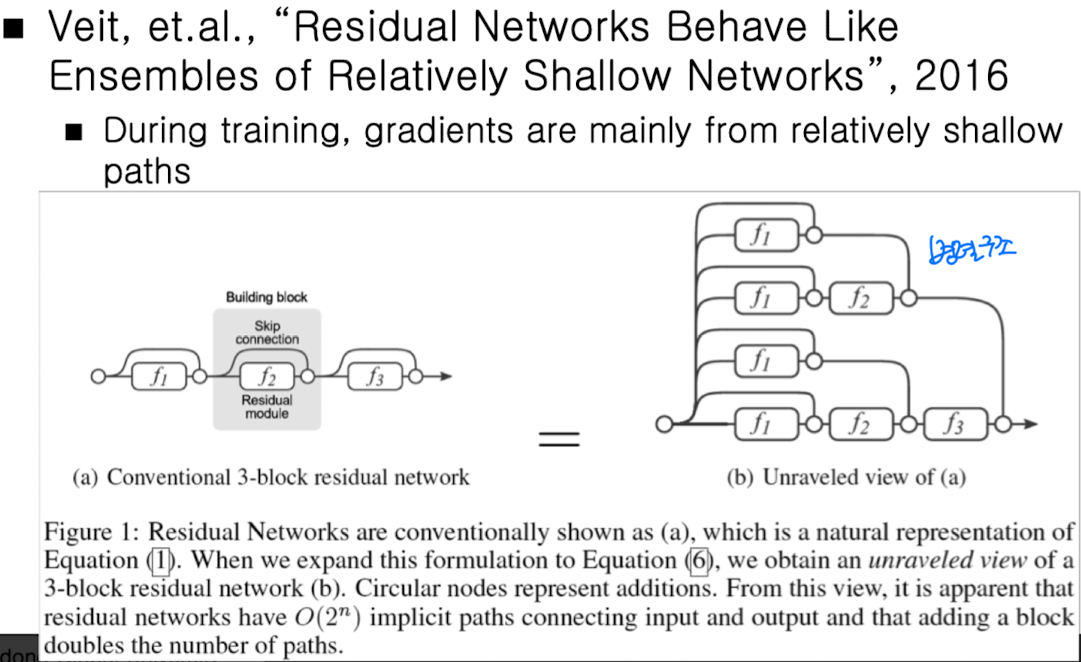

Residual Learning ( ResNet )

➡️ 성능저하 없이 Layer를 계속 쌓을 수 있음 ➡️ 다양한 길이의 Path

➡️ 다양한 길이의 Path

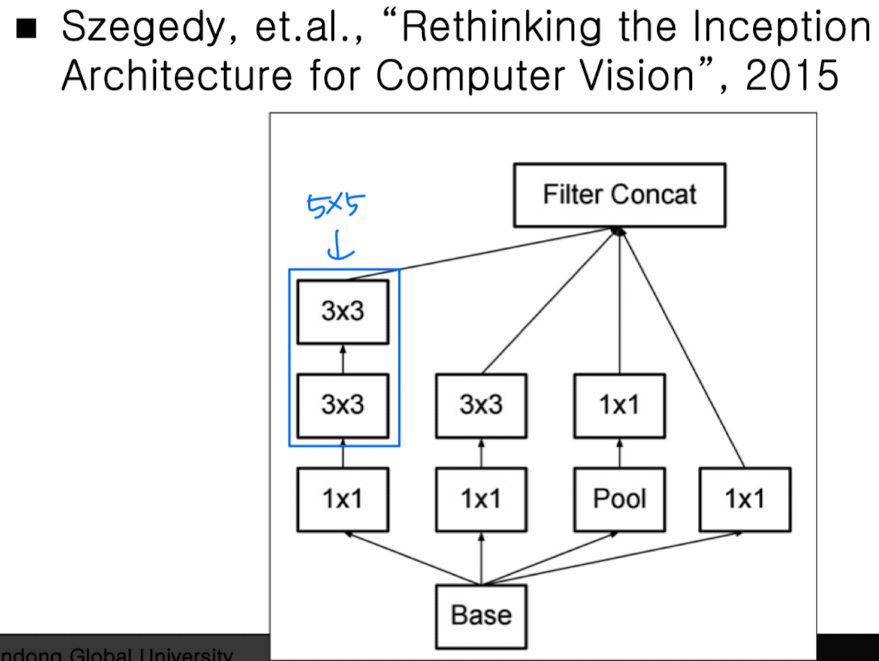

Inception v3

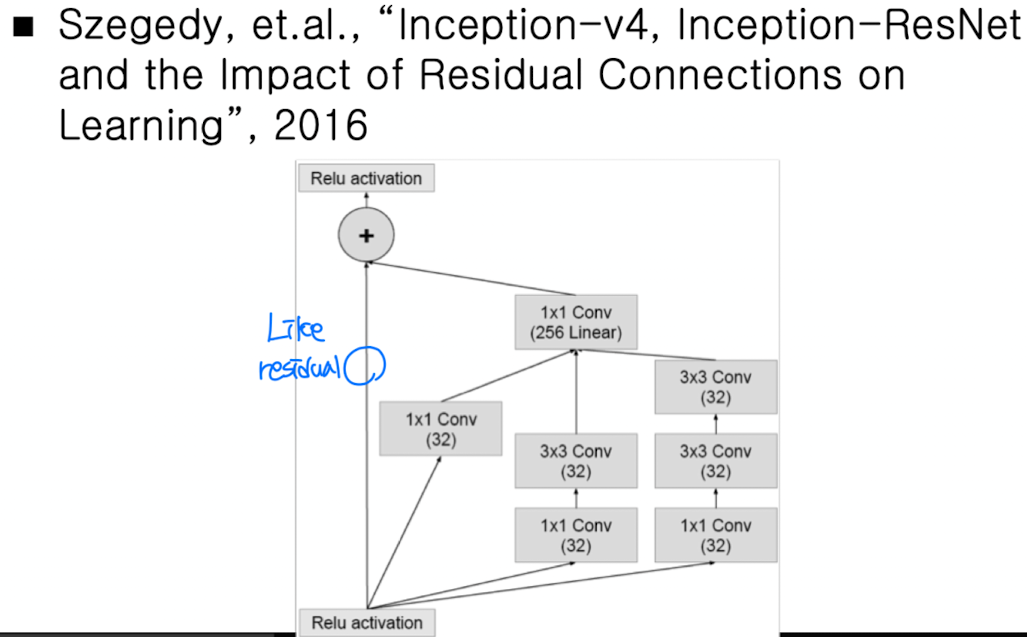

Inception-ResNet

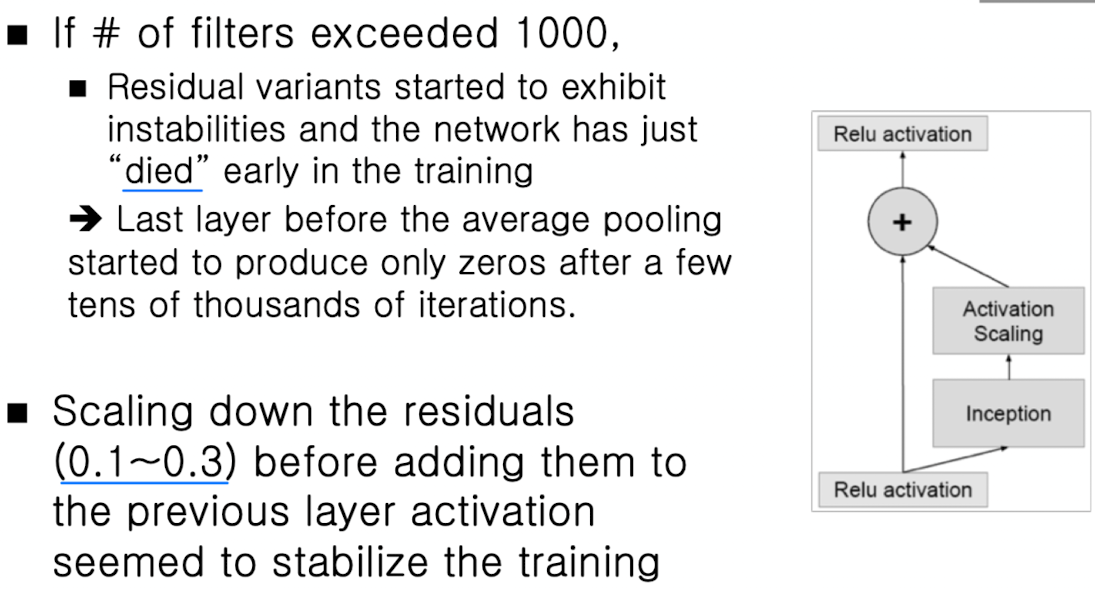

➡️ 1000개 이상일 경우 죽게되는데, Activatioin Scaling을 통해 0.1 ~ 0.3을 곱해주면 된다

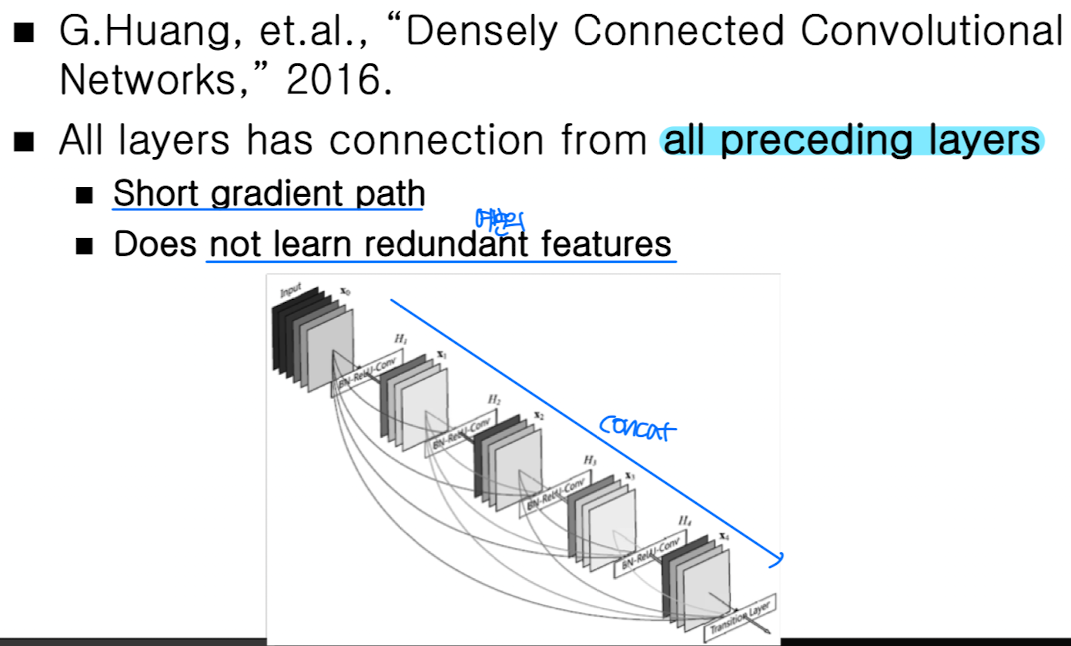

Dense Net

➡️ cf. ResNet : DenseNet은 Concat operator라서 vector의 차원이 변하지만, ResNet은 더하기 operator라서 차원 변화 X

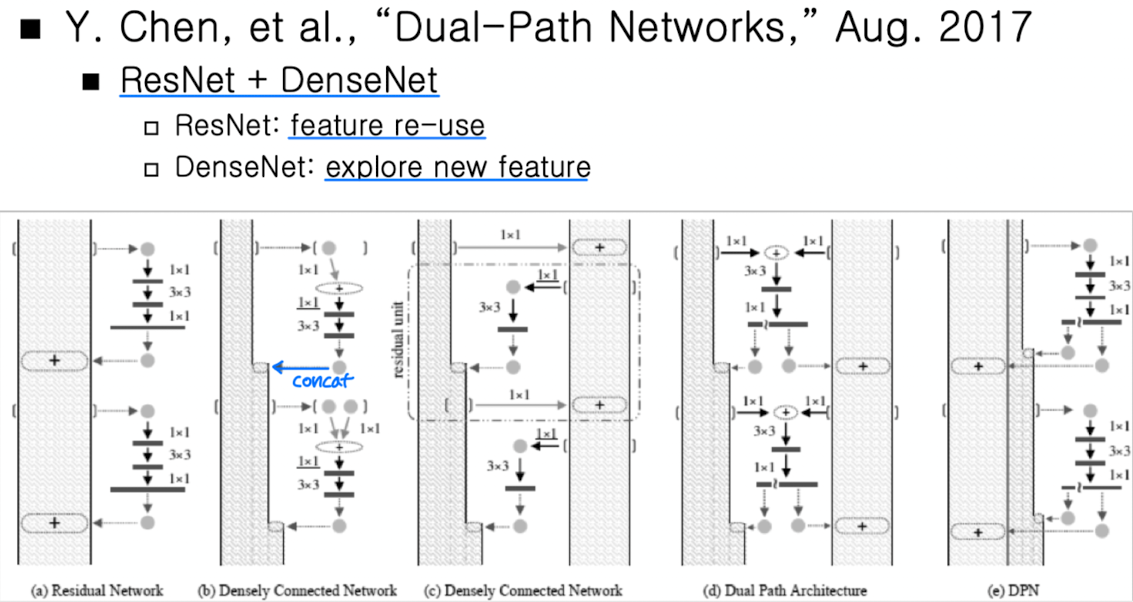

Dual-Path Networks ( DPN )

➡️ ResNet + DenseNet

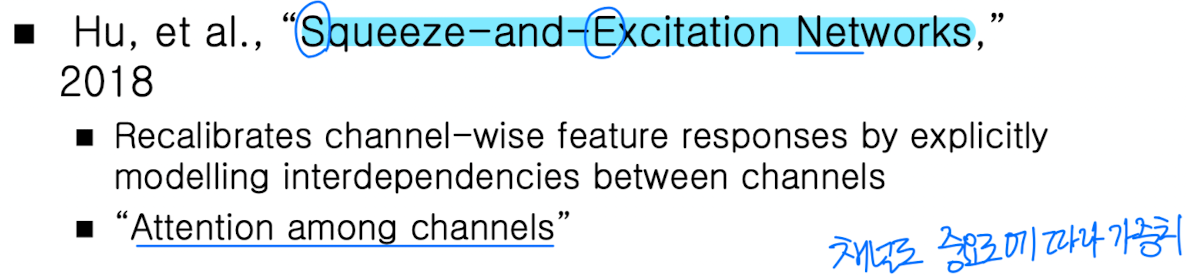

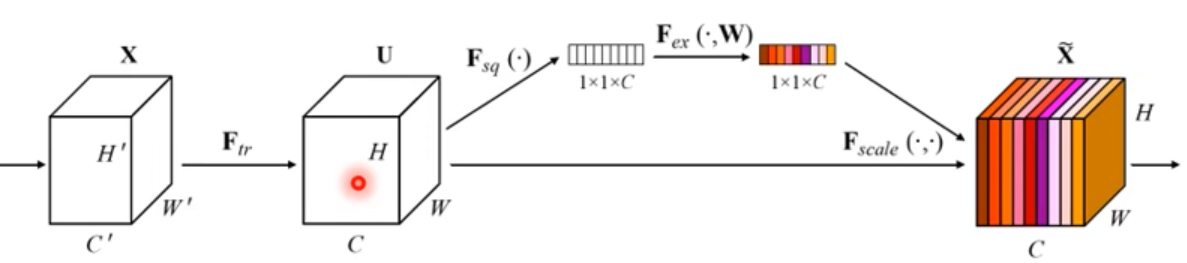

SENet

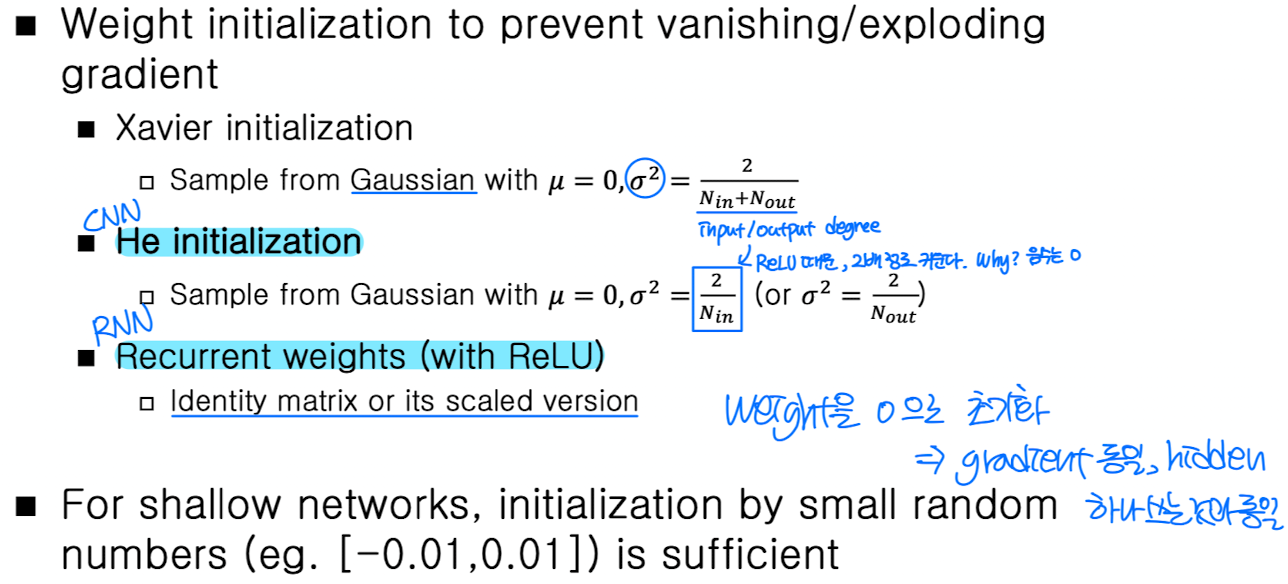

Weight Initialization

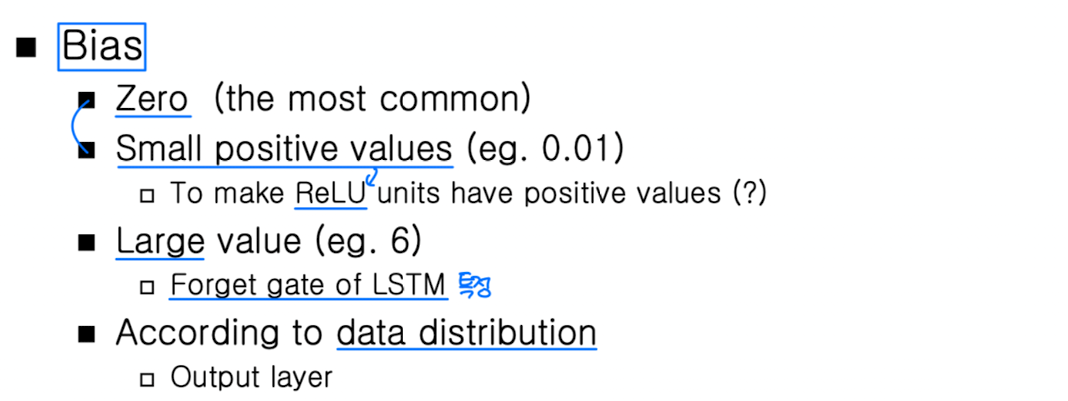

Bias Initialization

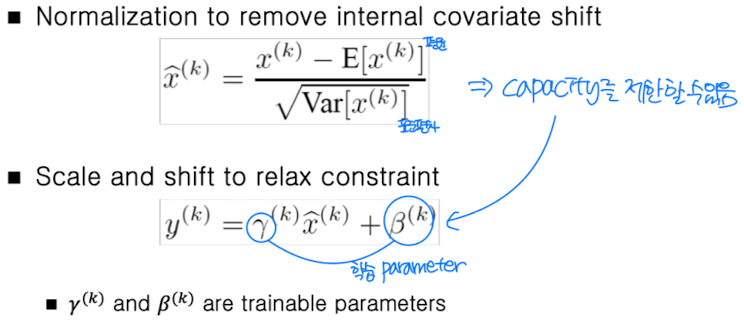

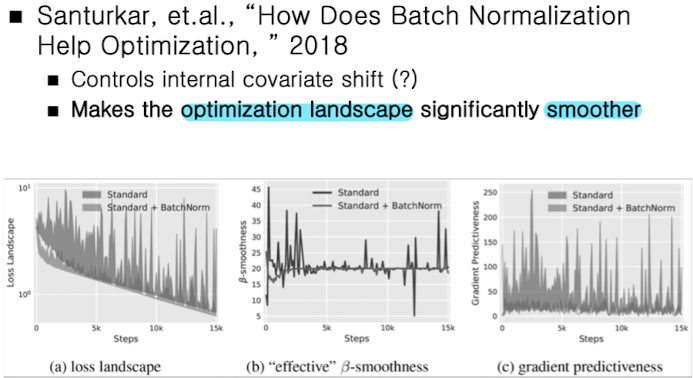

Batch Normalization

➡️ 충분한 Batch # 필요

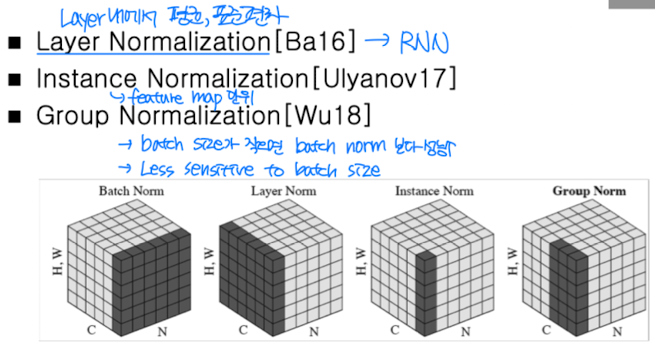

Layer / Instance / Group Normalization

➡️ Batch 확보가 어려울 때

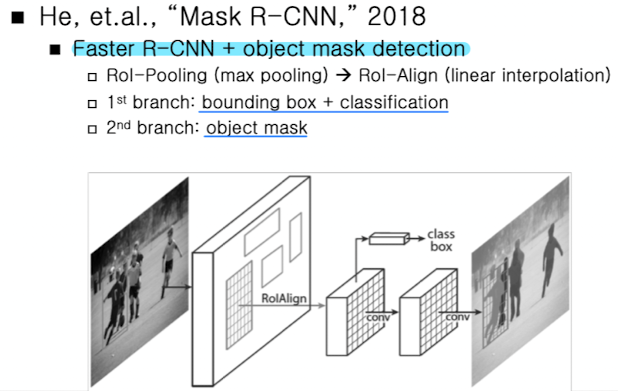

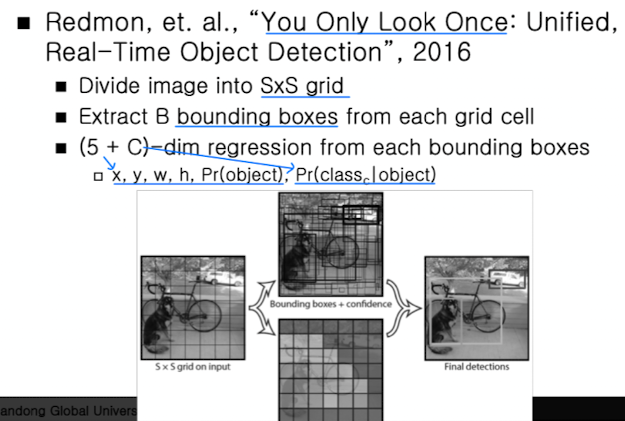

Object Detection

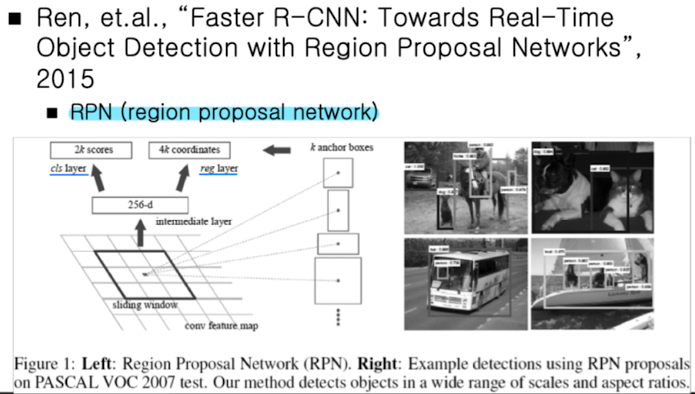

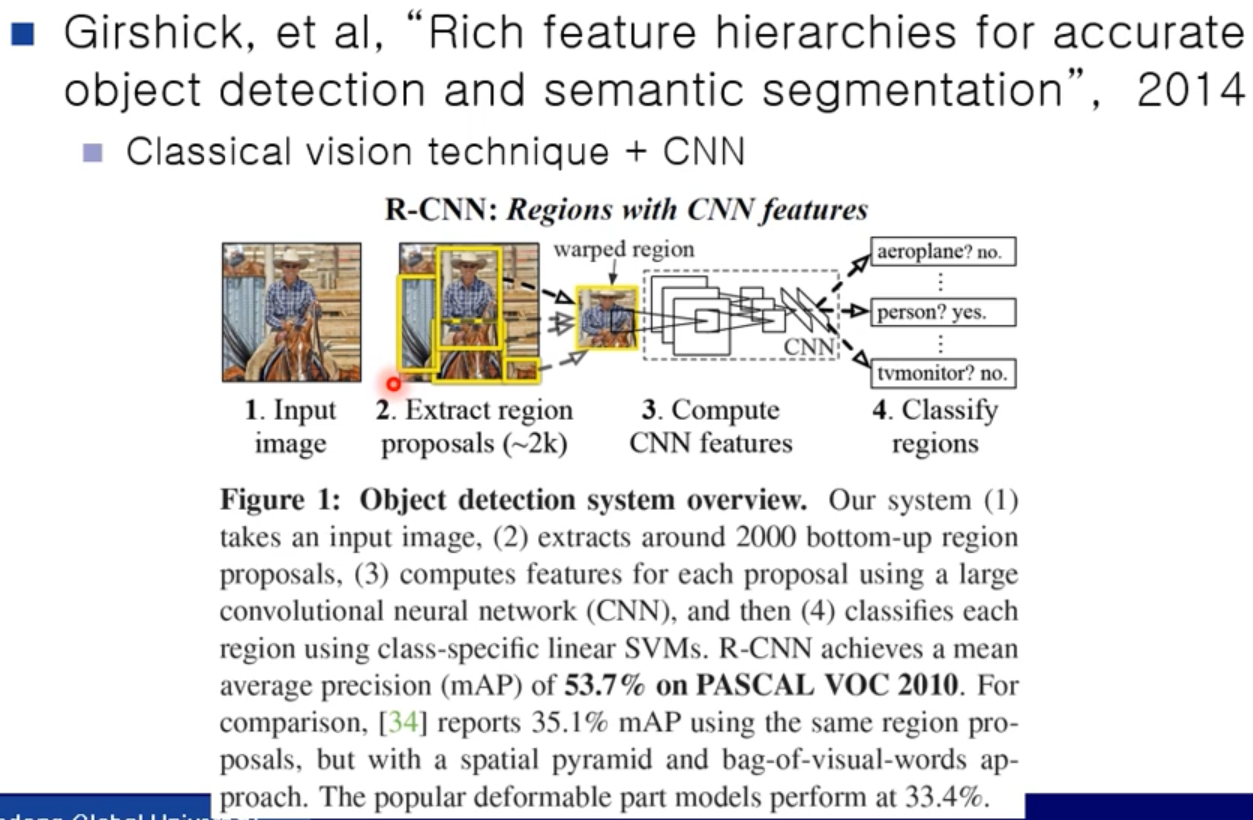

R-CNN

➡️ Classifier + Detection

➡️ 시간이 오래걸림

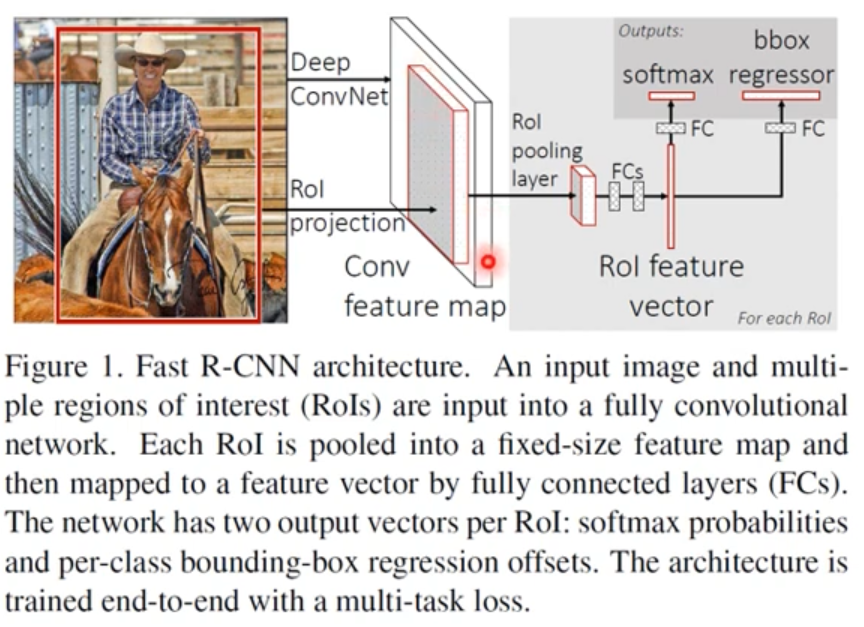

Fast R-CNN

➡️ x9 Faster than R-CNN