.png)

초보개발자가 배우는 단계에서의 포스트 글입니다. 부족한 점이 많이 있을 수 있습니다. 이해해주세요..😂😂

🚀 시작에 앞서서...

이번 시간에는 프로메테우스를 설치하고 실행해보는 시간을 갖도록 하겠습니다. 저는 AWS t2.micro를 사용해서 리눅스 환경에서 테스트를 진행했습니다.

프로메테우스 실행

1단계. 프로메테우스 다운

https://prometheus.io/download/

$ wget https://github.com/prometheus/prometheus/releases/download/v2.20.1/prometheus-2.20.1.linux-amd64.tar.gz버전은 현재 2.20.1 기준으로 진행했습니다. 참고로 wget은 웹 서버로부터 콘텐츠를 가져오는 컴퓨터 프로그램으로 이라고 보시면 됩니다.

2단계. 압축해제

$ tar zxvf prometheus-2.20.1.linux-amd64.tar.gz3단계. 이동 후 파일 내용 확인

$ cd prometheus-2.20.1.linux-amd64/

$ nano prometheus.yml# my global config

global:

scrape_interval: 10s # Set the scrape interval to every 10 seconds. Default is every 1 minute.

evaluation_interval: 10s # Evaluate rules every 10 seconds. The default is every 1 minute.

# scrape_timeout is set to the global default (10s).

# A scrape configuration containing exactly one endpoint to scrape:

# Here it's Prometheus itself.

scrape_configs:

# The job name is added as a label `job=<job_name>` to any timeseries scraped from this config.

- job_name: 'prometheus'

# metrics_path defaults to '/metrics'

# scheme defaults to 'http'.

static_configs:

- targets: ['localhost:9090']

아마 처음에는 이렇게 되어있을 겁니다.

-

global (기본적인 전역설정)

- scrape_interval : 얼마나 자주 메트릭(targets)을 수집할지 설정. 기본 1분

- evaluation_interval : 얼마나 자주 규칙(rules)을 평가할지 설정. 기본 1분

-

scrape_configs (메트릭을 수집할 엔드포인트로 여기서는 prometheus 서버 자신을 가리키는 설정을 했다. 여러개 설정이 가능하다.)

- job_name : 잡 이름 설정

- static_config : 긁어하는 방법에 대한 목표 및 파라미터 세트를 지정.

Prometheus는 이러한 대상에서 `메트릭 HTTP 엔드 포인트`를 `스크랩`하여 모니터링 대상에서 `메트릭을 수집`합니다. Prometheus는 자신에 대해 동일한 방식으로 데이터를 노출하기 때문에 자신의 상태를 긁어 모으고 모니터링 할 수도 있습니다. 자신에 대한 데이터만 수집하는 Prometheus 서버는 실제로는 그다지 유용하지 않지만 좋은 시작 예입니다.

(여기서 알 수 있는 것은 Prometheus는 메트릭을 수집하는 역할을 하는 동시에, 자신이 익스포터 역할을 병행해서 수행 할 수 있다는 점인듯 합니다.)

4단계. 실행

$ ./prometheus프로메테우스 서버를 실행하면 총 두 가지 사이트에 접근할 수 있습니다.

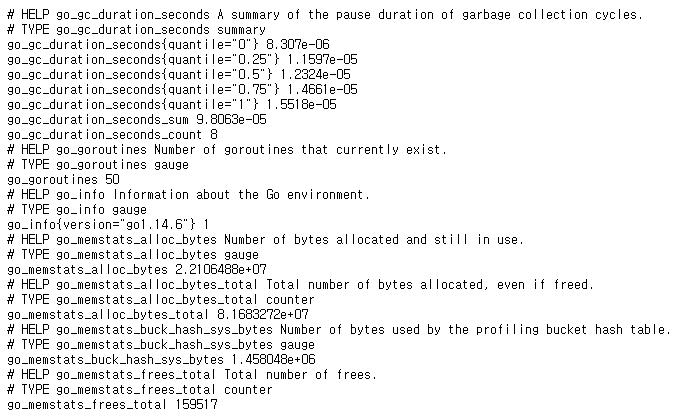

첫번째는 http://자신의ip주소:9090/metrics 입니다. 프로메테우스는 아래와 같은 메트릭을 수집하게 됩니다.

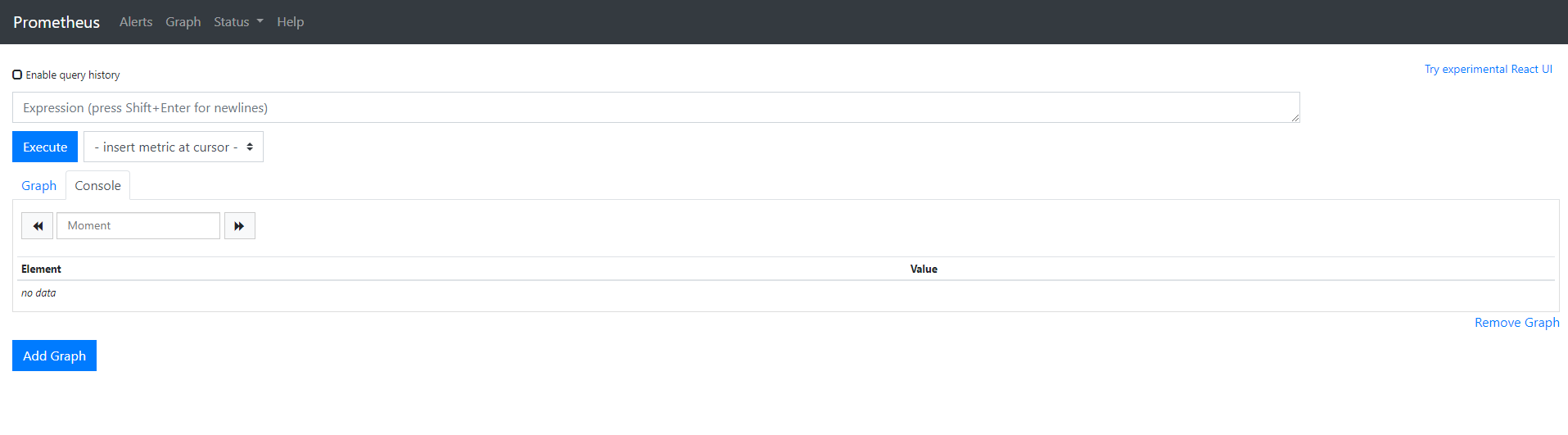

두번째로는 http://자신의ip주소:9090/ 입니다. 여기서는 PromQL을 써서 메트릭 중에서 내가 원하는 정보를 가져올 수 있습니다.

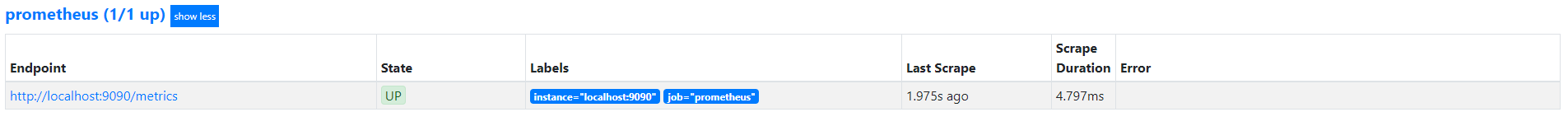

Targets 메뉴를 들어가보면 job이 prometheus이고 좀 전에 봤던 /metrics이 endpoint인 것을 알 수 있습니다.

마침

다음시간에는 메트릭에 대한 구조 설명과 구조를 이해한 다음 PromQL을 사용해보는 시간을 갖도록 하겠습니다.

참고문헌

- 프로메테우스 시작하기: https://prometheus.io/docs/prometheus/latest/getting_started/

- Finda 기술 블로그: https://medium.com/finda-tech/prometheus%EB%9E%80-cf52c9a8785f

- Outsider's Dev Stroy: https://blog.outsider.ne.kr/1254

개추