BGE embeddings for Retrieval Augmented Generation

요즘 RAG에 꽂혀버렸습니다.

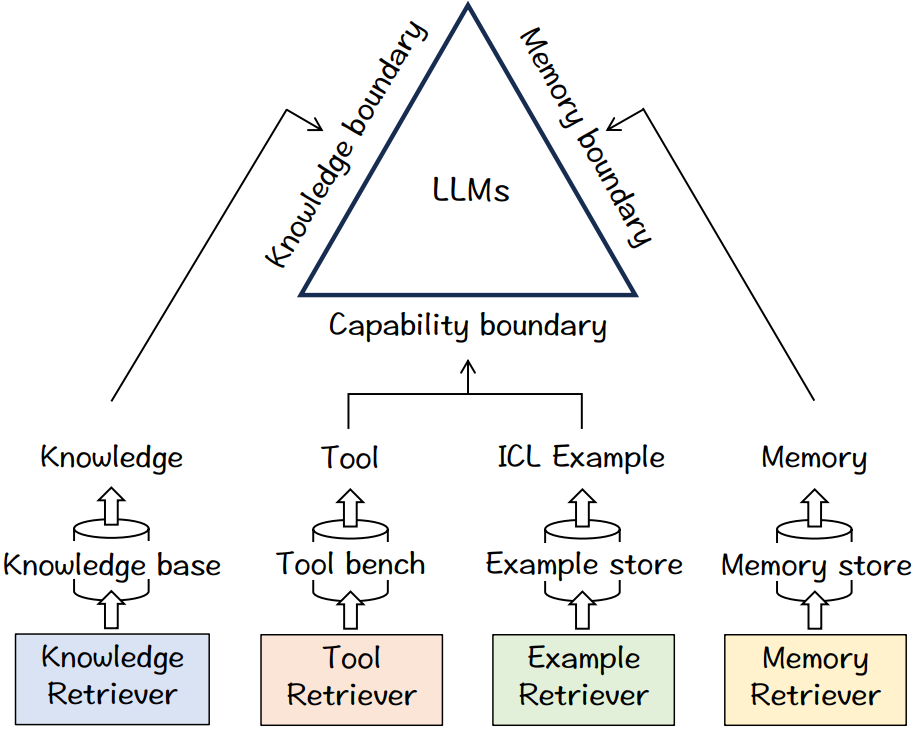

LLM은 많은 것을 바꿔놓았지만, 아직까지 풀지 못하는 문제들이 많고 그 많은 문제들의 대부분의 해답은 RAG에 있다고 (나는) 생각한다.

특히 Hallucination, 새로운 정보, Private Information 에 대해 모두 LLM에게 맡겨버리는 것은 어쩌면 LLM에게도 가혹한 일이 아닐까? 하는 생각이 든다.

1. MTEB

Text Embedding LearderBoard : https://huggingface.co/spaces/mteb/leaderboard

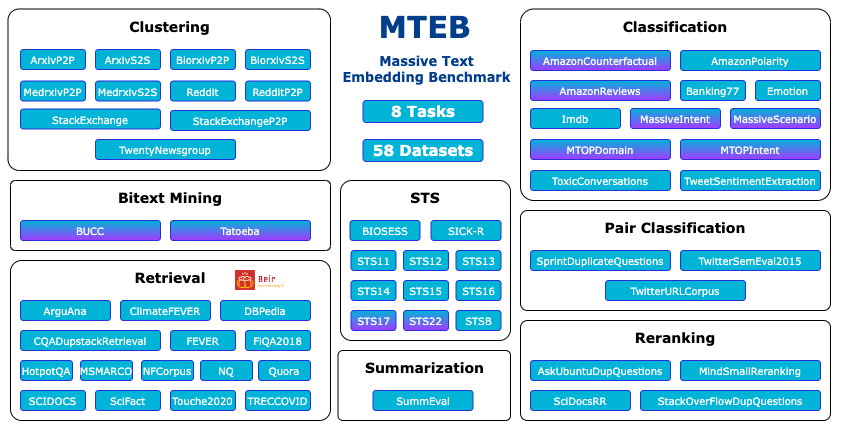

MTEB 는 다양한 embedding task들의 성능을 측정하는 벤치마크이다.

56개의 datasets과 8개의 task로 이루어져 있고, 텍스트 임베딩 답게 Multiligual Evaluation Benchmark이다.

우리가 잘 아는 Clustering 부터, STS, Summarization 까지 Embedding Vector를 활용하는 다양한 태스크로 이루어져 있다.

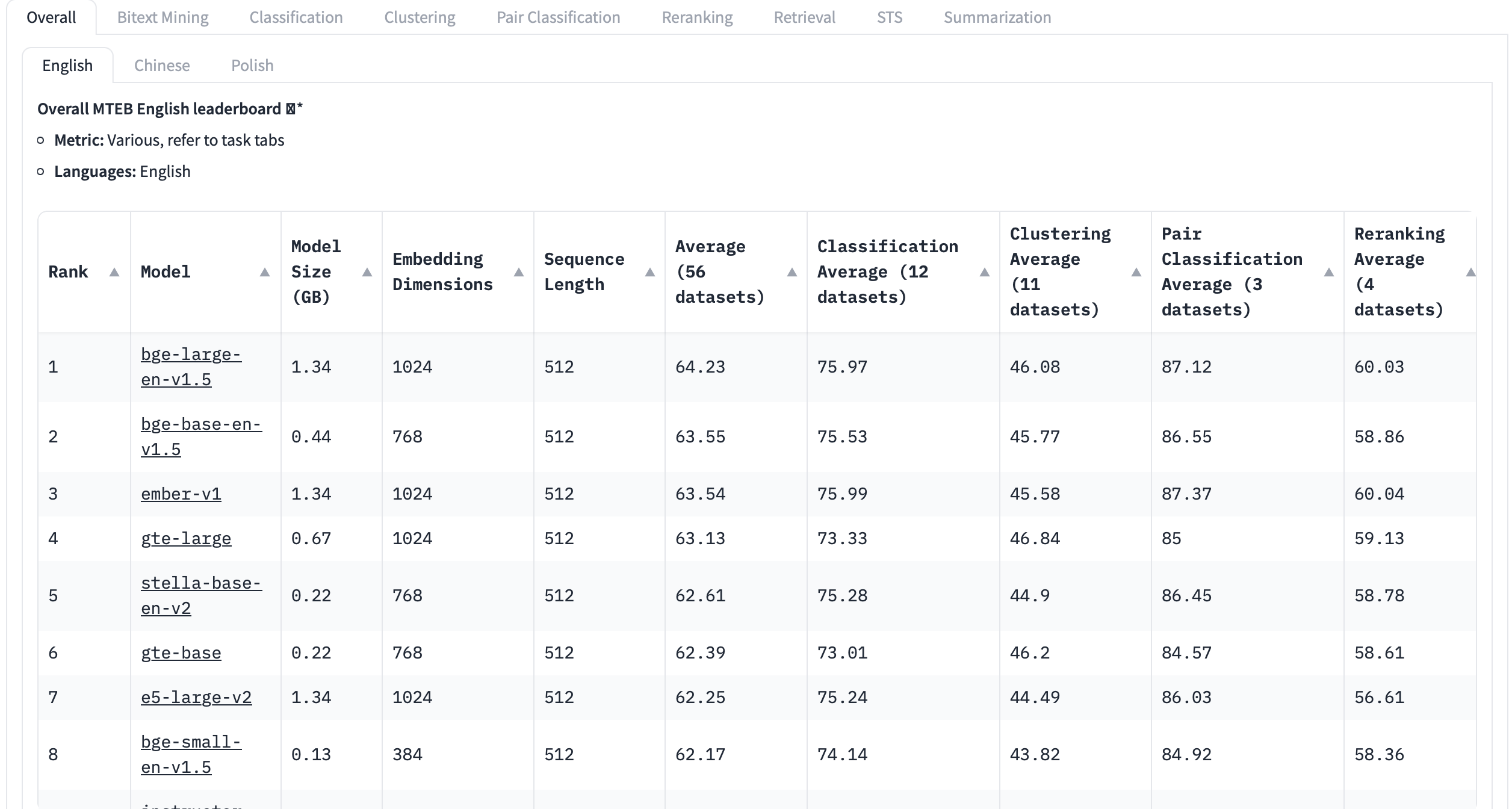

리더보드를 보면 지금 BGE 라는 놈이 씹어먹고 있는데, 이놈이 어떤 놈인지 알아보자.

2. BGE

난 처음에 BGE 가 약간 알고리즘이나 논문에서 제시하는 아키텍처 이름인줄 알았는데, BAAI General Embedding의 약자였다.

BAAI는 참고로 중국에서 가장 큰 인공지능 연구소 중 하나이다. 새삼 중국파워..

https://arxiv.org/abs/2310.07554

https://arxiv.org/pdf/2309.07597.pdf

https://github.com/FlagOpen/FlagEmbedding

C-MTP : a massive text embedding dataset curated from labeled and unlabeled Chinese corpora for training embedding models

C-TEM : a family of embedding models covering mul- tiple sizes.