로컬에서 spark로 s3서비스를 접근하는데 많은 삽질을 하여 로컬 spark 실행에 관한 내용을 남겨놓습니다.

- spark 설치

- 링크 : https://spark.apache.org/downloads.html

- 이전에 듣던 강의 자료에서 Hadoop 2.7버전을 사용하여 동일하게 사용 했는데, 3.2의 최신 버전을 사용하지 않으면 s3에 접근할 수 없었습니다..

- winutils 설치

- 위에서 설치한 Hadoop의 버전에 맞도록 winutils를 설치해줍니다.

- 링크 : https://github.com/cdarlint/winutils

- bin파일을 다운받아 Hadoop 폴더에 넣어줍니다.

- 환경설정

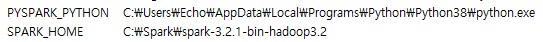

- PYSPARK_PYTHON 변수를 넣어주어야 spark가 python을 인식합니다. exe 파일 까지 경로에 넣어줍니다.

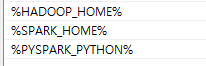

Path :

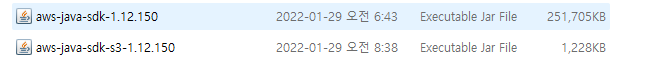

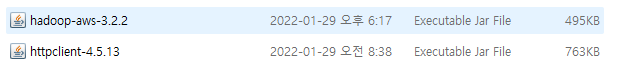

- JAR 파일 다운

- s3에 접근하기 위해 많은 JAR파일들이 필요했습니다..

- spark-default.conf 파일 수정

- pyspark를 사용하였는데, 경로 인식 때문에 파이썬 프로젝트 안에 jar파일들을 넣어버렸습니다.. 더 좋은 방법이 있을 듯 합니다.

spark.jars hadoop-aws-3.2.2.jar,aws-java-sdk-1.12.150.jar,aws-java-sdk-s3-1.12.150.jar,httpclient-4.5.13.jar

spark.driver.extraClassPath hadoop-aws-3.2.2.jar

spark.driver.extraClassPath aws-java-sdk-1.12.150.jar

spark.executor.extraClassPath hadoop-aws-3.2.2.jar

spark.executor.extraClassPath aws-java-sdk-1.12.150.jar

spark.executor.extraClassPath aws-java-sdk-s3-1.12.150.jar

spark.driver.extraClassPath aws-java-sdk-s3-1.12.150.jar

spark.executor.extraClassPath httpclient-4.5.13.jar

spark.driver.extraClassPath httpclient-4.5.13.jar

spark.hadoop.fs.s3a.aws.credentials.provider org.apache.hadoop.fs.s3a.SimpleAWSCredentialsProvider

spark.hadoop.fs.s3a.access.key access key id

spark.hadoop.fs.s3a.secret.key access key