nn.dataparrel 사용시 GPU 몰림 현상

NeRF 코드를 'model = nn.DataParallel(model).to(device)' 를 사용하여 GPU 분산처리를 시도하였다.

- 문제점

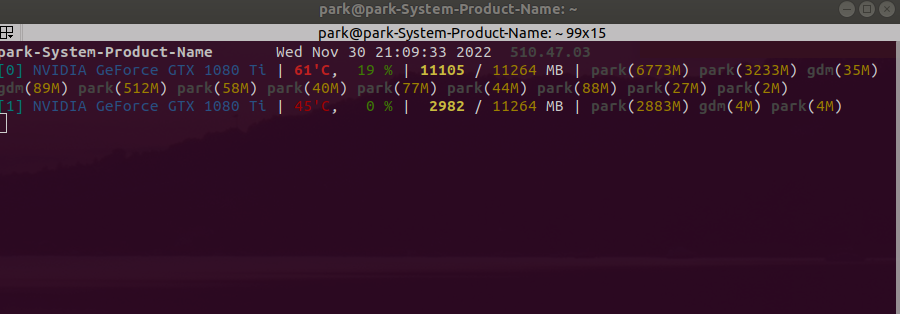

그러나 다음과 같이 한 GPU에 memory가 쏠리는 문제가 발생하였다.

모델에서 weight는 분산되서 사용될 지 몰라도, loss value의 경우 한 GPU에 몰려서 계산된다고 한다.

- 해결방법

loss value도 GPU로 병렬처리 해서 연산할 수 있다고 하는데, 해당 내용과 관련된 링크를 첨부한다.

[링크 1] - https://medium.com/daangn/pytorch-multi-gpu-%ED%95%99%EC%8A%B5-%EC%A0%9C%EB%8C%80%EB%A1%9C-%ED%95%98%EA%B8%B0-27270617936b

[링크 2] - https://aigong.tistory.com/186