- 참가 방법

- Agent의 정의

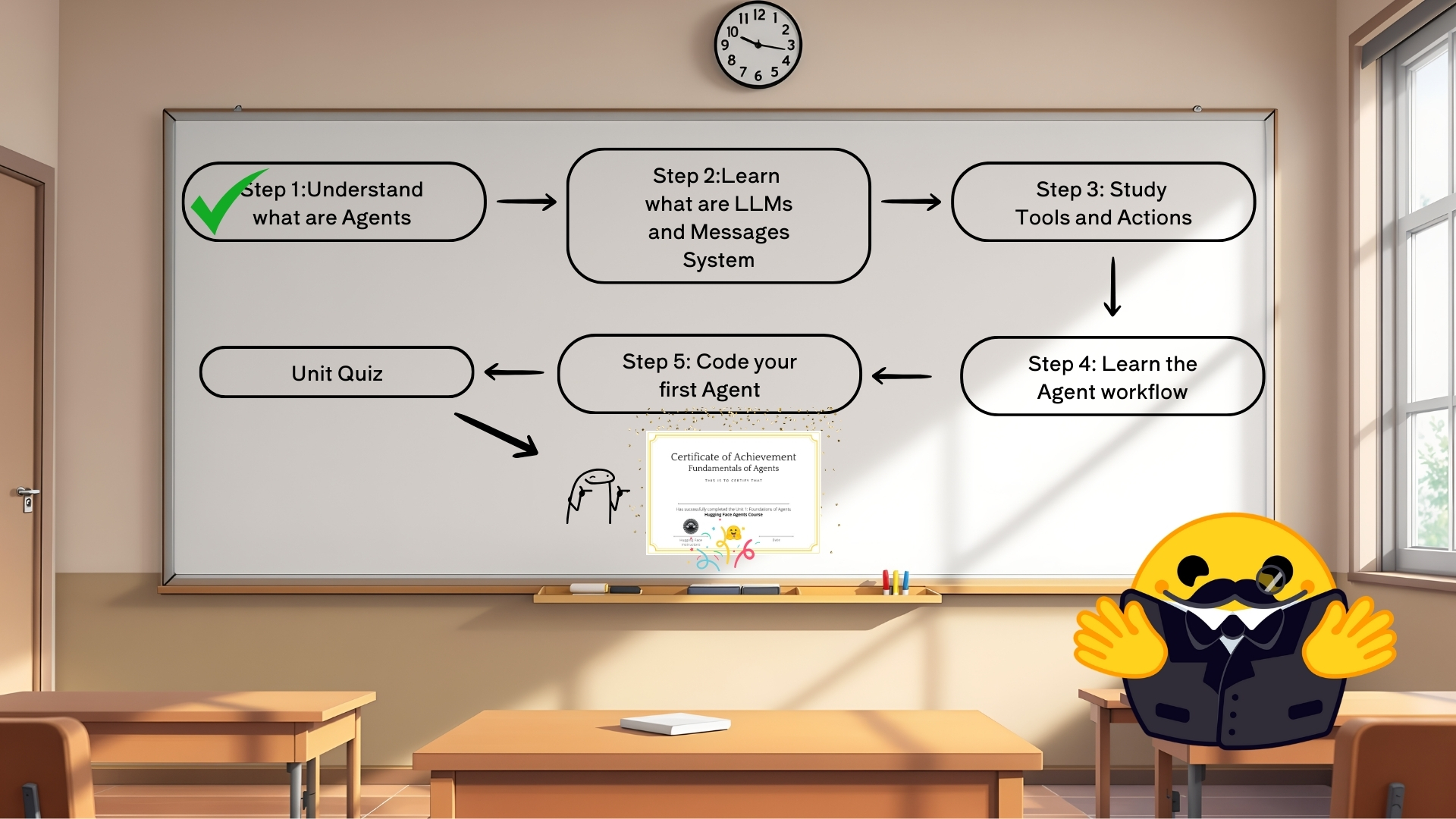

Chapter 1

Agents Course 참가 방법

Agent

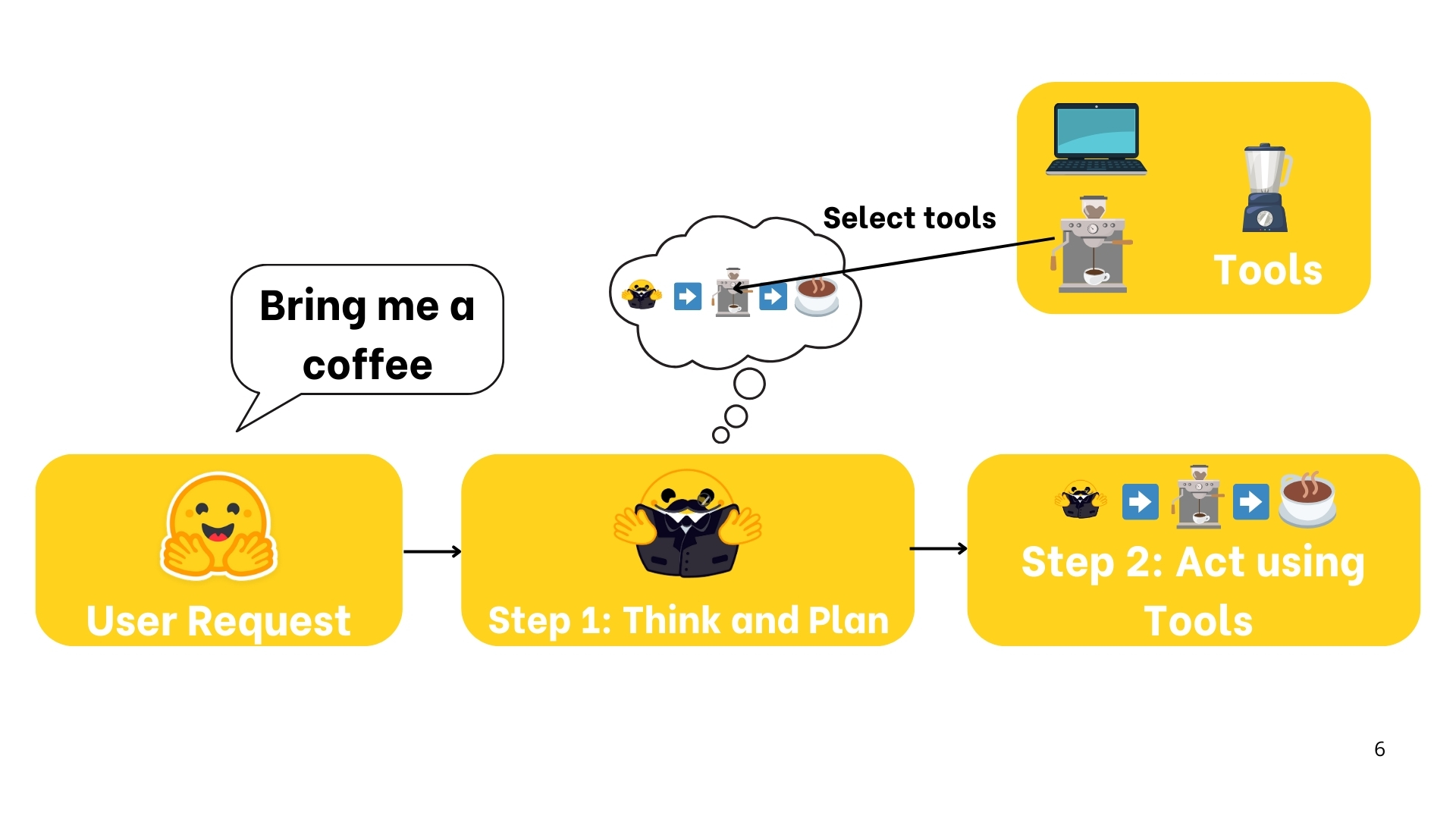

- 에이전트 정의

"에이전트는 AI모델을 활용하여 환경과 상호작용하여 사용자가 정의한 목표를 달성하는 시스템입니다. 추론, 계획 및 작업 실행(외부 도구 등을 사용)을 결합하여 작업을 수행"

- 에이전트의 구성요소

- The Brain(AI Model)

생각이 일어나는 곳.

AI모델은 추론과 계획을 처리합니다. 상황에 따라 어떤 행동을 취할지 결정합니다 - The Body(Capabilities and Tools)

에이전트가 수행할 수 있는 모든 기능

가능한 행동 범위는 에이전트가 무엇을 갖추고 있는지에 따라 달라집니다.

-

"Action은 Tools와 동일하지 않다는 점에 유의해야함. 예를들어 Action을 완료하기 위해 여러 Tools을 사용할 수 있다."

-

요약

- 에이전트는 AI모델(일반적으로 LLM)을 핵심 추론 엔진으로 사용하여 다음을 수행하는 시스템- 자연어 이해 : 인간의 지시를 의미 있는 방식으로 해석하고 대응

- 추론 및 계획 : 정보를 분석하고, 결정을 내리고, 문제를 해결하기 위한 전략을 고안

- 환경과 상호작용 : 정보를 수집하고, 조치를 취하고, 조치의 결과를 관찰

LLM

What is a Large Language Model?

- LLM은 인간 언어를 이해하고 생성하는데 뛰어난 AI모델 유형입니다.

- 오늘날 대부분의 LLM은 Transformer 아키텍처를 기반으로 구축 됩니다.

- Trasnformer아키텍처는"Attention"알고리즘을 기반으로 하는 딥 러닝 아키텍처로, 2018년 Google에서 BERT를 출시한 이후 큰 관심을 얻고 있습니다.

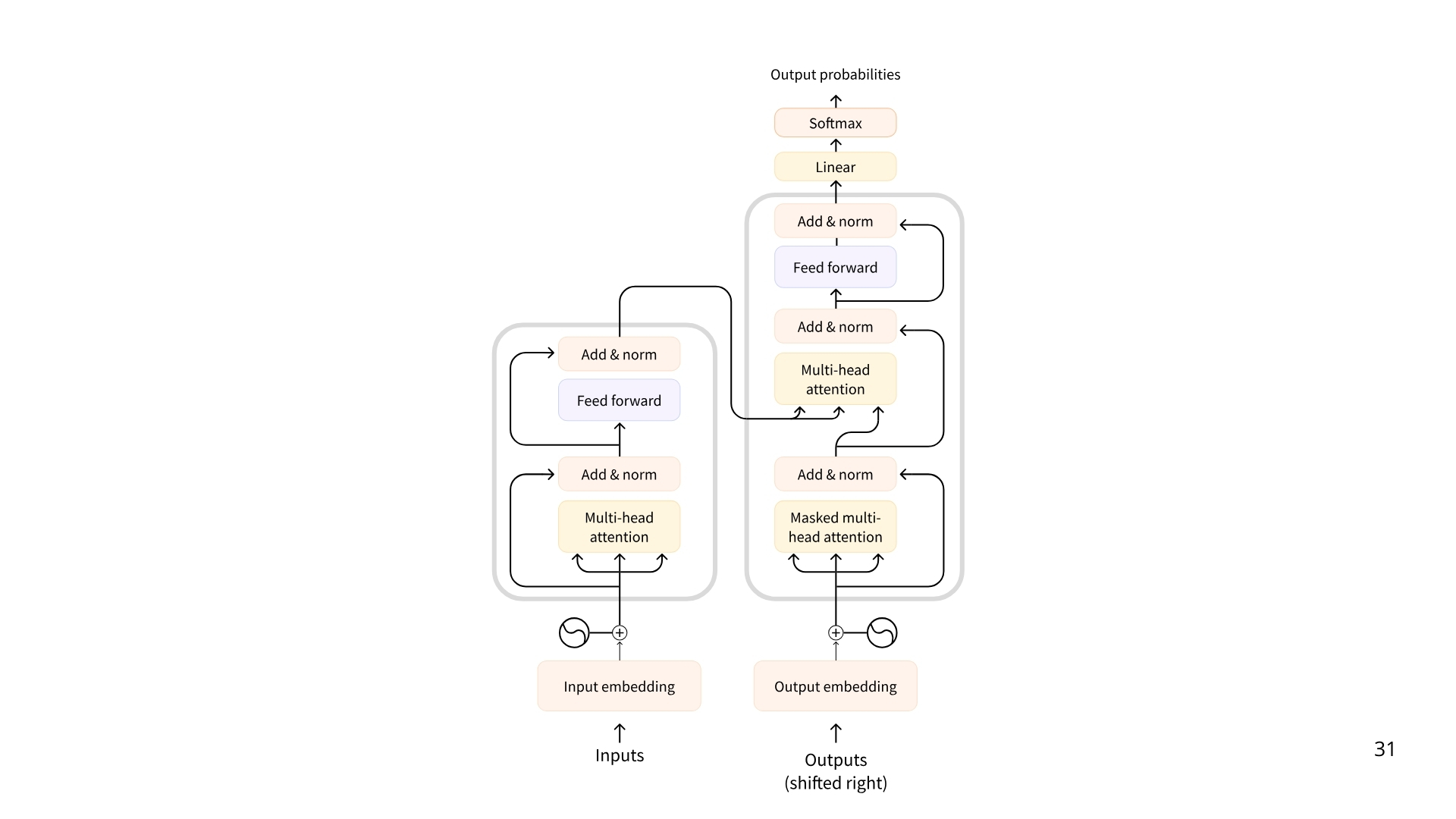

Transformer

- 트랜스 포머의 3가지 구성요소

- 인코더(Encoder)

- 인코더 기반 Transformer는 텍스트(또는 다른 데이터)를 입력으로 받아 해당 텍스트의 dense representation(or embedding)을 출력합니다.

- example : BERT

- se Cases: 텍스트 분류(Text classification), 의미 검색(semantic search), Named Entity Recognition

- Typical Size: Millions of parameters

- 디코더(Decoder)

- 디코더 기반 Transformer는 한 번에 하나의 토큰씩 새로운 토큰을 생성하여 시퀀스를 완성하는 데 중점을 둡니다 .

- Example: Llama from Meta

- Use Cases: Text generation, chatbots, code generation

- Typical Size: Billions (in the US sense, i.e., 10^9) of parameters

- Seq2Seq(인코더-디코더)

- 시퀀스-투-시퀀스 트랜스포머는 인코더와 디코더를 결합합니다 . 인코더는 먼저 입력 시퀀스를 컨텍스트 표현으로 처리한 다음 디코더는 출력 시퀀스를 생성합니다.

- Example: T5, BART,

- Use Cases: Translation, Summarization, Paraphrasing

- Typical Size: Millions of parameters

LLM은 다양한 형태로 제공됮만, LLM은 일반적으로 수십억 개의 파라미터가 있는 디코더 기반 모델 입니다. LLM의 예시는 아래와 같습니다.

| Model | Provider |

|---|---|

| Deepseek-R1 | DeepSeek |

| GPT4 | OpenAI |

| Llama 3 | Meta (Facebook AI Research) |

| SmolLM2 | Hugging Face |

| Gemma | |

| Mistral | Mistral |

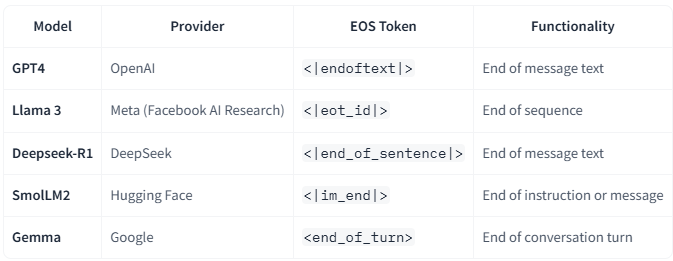

Special Token

각 llm 모델에는 고유한 특수 토큰(모델별로 상이함)이 존재함 llm은 이러한 토큰을 사용하여 생성의 구조화된 구성요소를 열고 닫는다.

ex) 종료큰(EOS)의 경우 시퀀스, 메시지 등의 시작과 끝을 나타낸다.

next token prediction

LLM은 자기회기(Auto Regressive)적 이라고도 한다. 이는 한 pass의 출력이 다음 pass의 입력이 된다는 것을 의미한다.

- 즉 LLM은 EOS에 도달 할 때까지 텍스트를 디코딩 한다.

single decoding loop

- 단일 디코딩 루프 안에서는 사용자의 입력이 토큰화(tokenized)되고 의미와 위치에 대한 정보르르 포착하는 시퀀스 표현으로 변환하게 된다.

- 이러한 표현은 모델에 입력되고, 모델은 각 토큰이 해당 어휘에 있을때 시퀀스의 다음 토큰일 가능성을 순위로 매기는 점수로 표현된다.

- 빔 검색(Beam Search)등 알고리즘 등이 존재한다.

Transformer 아키텍처의 핵심은 Attention 이다.

- "The capital of France is ..." 에서 "France"와 "capital"과 같은 단어가 가장 큰 의미를 지닌다.