- 상황: 영화 추천 시스템 서비스를 연구실 사람들과 만들기로 했다.

- 내 역할: LLM 파트와 크롤링을 담당하기로 했다. 원래 TMDb로 하려다가 IMDb가 더 잘나와서 급변경.

- 내 상황: 근데 저번주에 급 의욕이 바닥을 쳐서 급하게 벼락치기로 할 일을 하고 있다;;

- 내 감정: 제목에 쓰여있듯 크롤링이 중간에 끊길까봐 무섭다 ㅜㅜ

일단 ChatGPT한테 beautifulsoup 써서 크롤링 하는 코드 잔뜩 물어본 후에

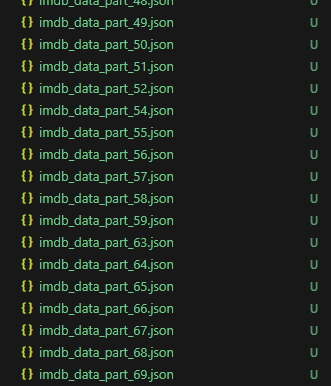

이렇게 나눠서 저장하고 있다

아 근데 이거 쌓이는 속도 보면

내 생각보다 너무 느린 것 같은데 멈출 수가 없다 ..

음 진짜 솔직히 말하면 그냥 멈췄다가 다시 실행 해주기가 귀찮다

스포일러(?) 하자면

이 잘 돌아가는 코드를 (개느리지만) 끊었다가 괜히 수정해줘야하는 게 귀찮았는데

아무리 생각해도 너무 느린 거 같아서

'개발자라면 이것도 트러블 슈팅이지' 라고 생각하며

피하지 말자 싶어서 결국 끊고 다시 했다

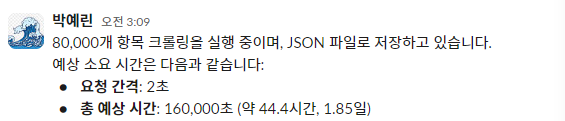

지금 10개 단위로 끊어서 저장하도록 해놨는데, item이 대략 80000개니까

그럼 거진 8000 part 까지 저장되어야 하는데 .. ㅋㅋ 이 글을 쓰고 있는 현재 part 80 까지 됐다

그럼 지금 거의 약 2시간 동안 크롤링 한게 이만큼이니까

100배하면 200시간

200시간 / 24시간 = 8.33일

아니 이게 맞나 .....

뭔가 좀 잘못된 거 같은데

time sleep을 너무 길게 줬나 ;;

# IMDb 요청 간격 (과도한 트래픽 방지)

time.sleep(5)json 합치는 건 뭐 그냥 python 코드로 자동화하면 그리 어려운 작업은 아니라고 한다. (안해봄)

로그 상으로는 잘 되고 있는데

로그 상으로는 잘 되고 있는데

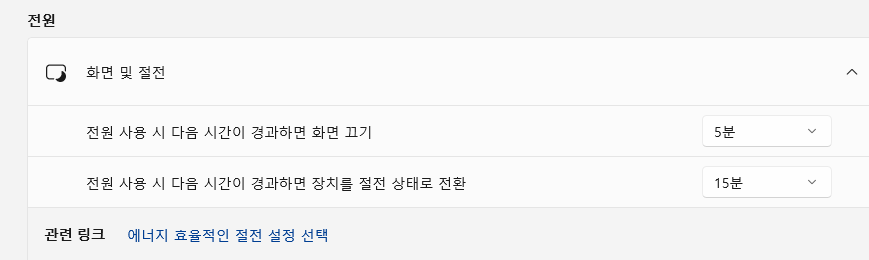

저번에 이제 컴퓨터 절전 모드 들어가서

중간에 python 실행 멈춘 적이 있어서 덜덜 떨었다

물론 그걸 고려해서 한번에 저장하는 게 아니라 일부러 10개 단위로 끊어서 저장하는 거지만

그래도 불안해서 날밤 샐 수는 없으니까

절전 그냥 싹 다 꺼줬다

절전 그냥 싹 다 꺼줬다

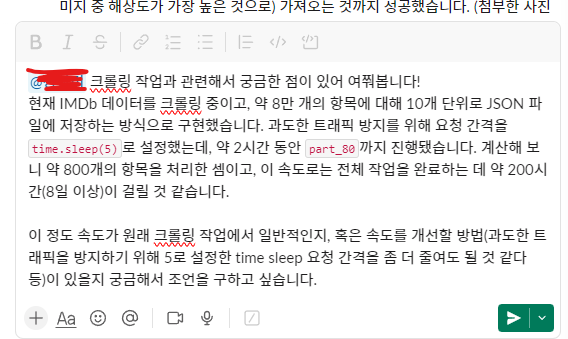

원래 이렇게 크롤링 오래 걸리는 거냐고

크롤링 해보신 분한테 여쭤봐야겠다 ;;

여쭤보려다가 아무리 생각해도 "8일 걸릴 거 같다"는 건 말이 안되는 거 같아서

조금 조사해보고 2초 간격도 충분히 안전할 거 같아서 time.sleep(2)로 땡겼다

그래 5초는 좀 아닌 거 같았다

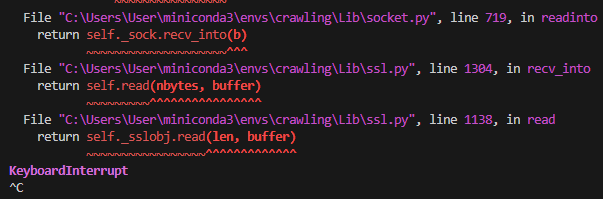

두려웠지만 키보드 인터럽트로 끊어버리고

지금이라도 고쳐야겠다 싶어서 코드 좀 수정해서

다시 돌리는데 처음에 잘 안돼서 식겁했다

울 뻔 했음

GPT가 있어서 참 다행 .. 감사 .. 고마움 .. NLP에 대한 숭배 ..

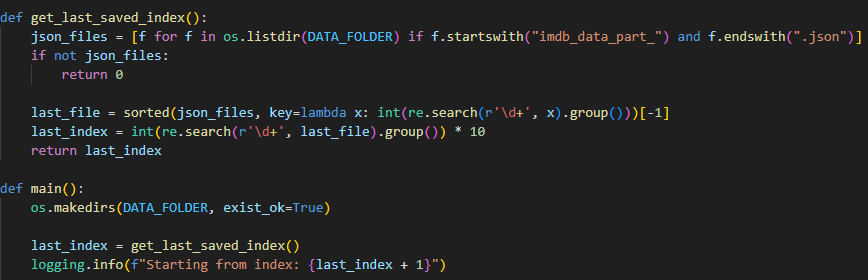

get_last_saved_index() 함수로 진행된 거 체크하고 거기서부터 다시 크롤링 시작하도록 코드 수정했다.

근데 저장되는 거 확인해보니 묘하게 내가 의도하지 않은 로직대로 돌아간다는 사실을 깨달았지만

큰 문제는 없는 것 같다 오히려 이 쪽이 나은 거 같기도 하고

크롤링 속도는 확실히 time.sleep(5) 일 때 보다는 훨씬 빨라진 것 같다.

수정한다고 날린 시간이 있지만 .. 8일보단 1.85일이 낫잖아 ^^

수정한다고 날린 시간이 있지만 .. 8일보단 1.85일이 낫잖아 ^^

이제 llm 롤플레잉 쪽을 살짝 찔러보고

크롤링 켜놓고 집가서 잠을 조금이라도 자고 오려고 한다 !!!

오랜만에 개발하니까 그냥

코드 조금 길어지니까 바로 그냥

내가 방금 짠 건데 (사실 GPT가)

바로 레거시 코드처럼 느껴진다 ... ^^

하하 역시 코드 짜는 연습도 계속 하자 특히 인공지능 쪽을 !

it works.. 라면 ok입니다~