RNN

Sequential Model

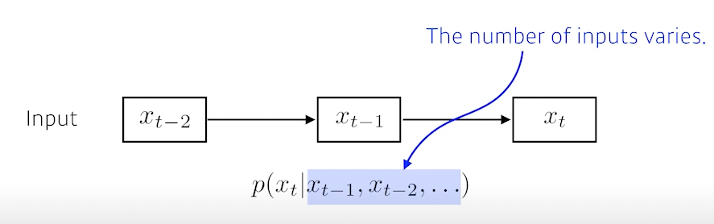

입력이 몇개 들어올 때 다음 것을 찾아보자

시점에 따라 내가 고려해야 하는 정보량이 증가한다.

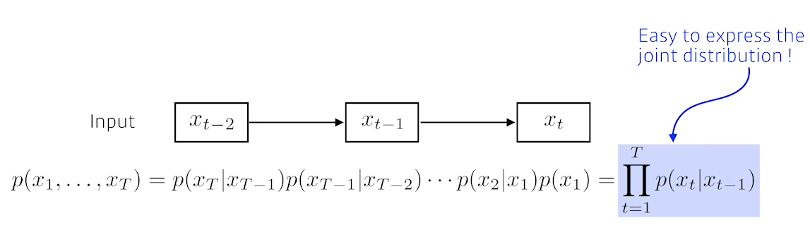

Naïve sequence model

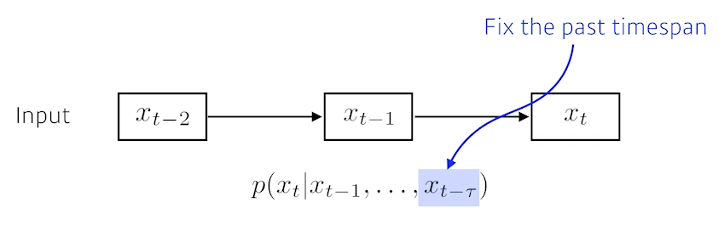

Autoregressive model

항상 과거 r개 만 보겠다./ 타임스팬의 고정

Autoregressive model 의 일종인 Markov model(1차, 2차, …..)

나는 수능 날의 성적을 볼 때 그 전날의 공부만 고려하겠다(1차 마코프)

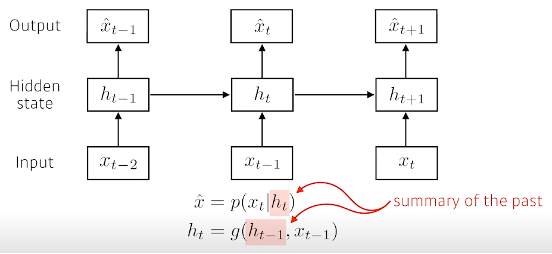

Latent autoregressive model

과거의 모든 정보를 고려할 수 없기 때문에 요약본인 hidden state 를 사용한다.

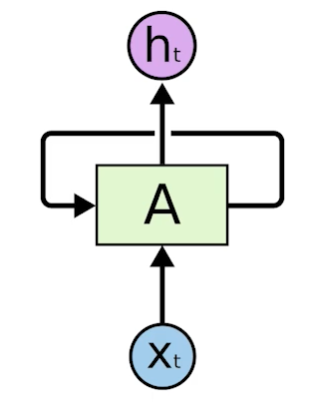

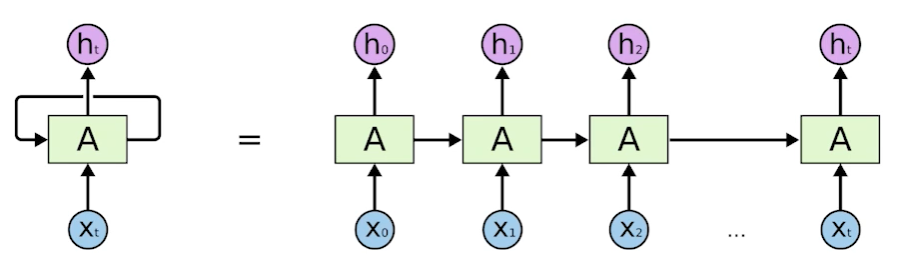

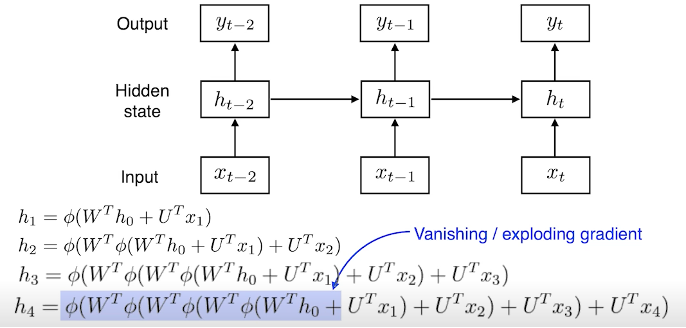

RNN

t시점에서의 정보 외에도 t-1단계에서 넘어온 cellstate또한 활용

t시점에서의 정보 외에도 t-1단계에서 넘어온 cellstate또한 활용

Vanilla RNN의 문제점

Long-term dependencies

T시점에서 가까운 시점의 정보들은 충분히 전달 되지만 오래 전 시점의 정보들은 T시점 까지 충분히 전달 되지 않는다.

Sigmoid 를 계속 통과하는데 0~1 사이의 아주 작은 값들이 계속 곱해지다보면 0에 수렴된다.

-> Vanishing Gradient Problem

ReLU 를 쓴다 해도 양수를 계속 곱하다 보면

-> Exploding Gradient Problem

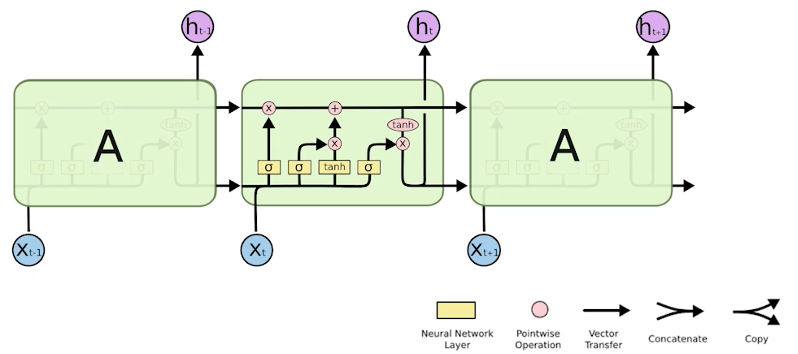

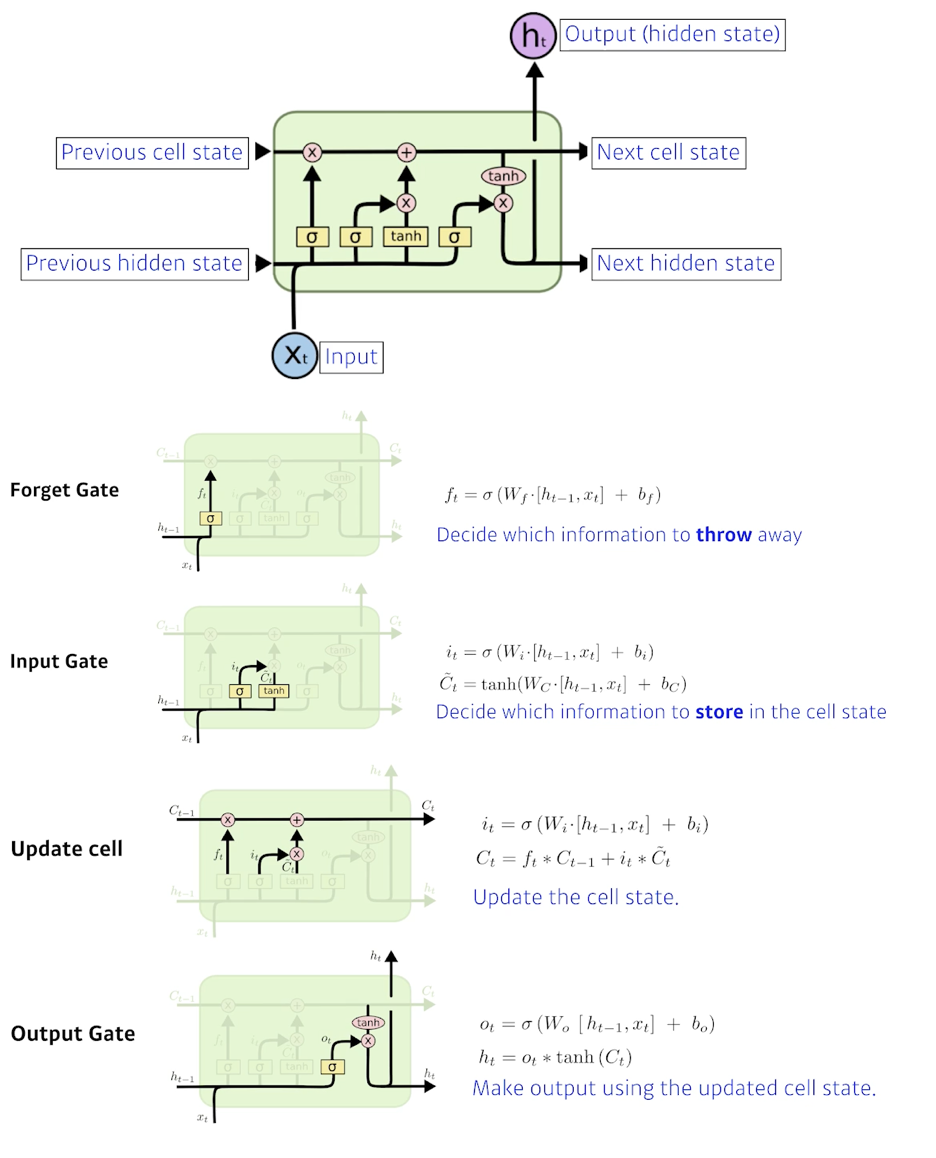

LSTM

Long Term Dependency 를 해결

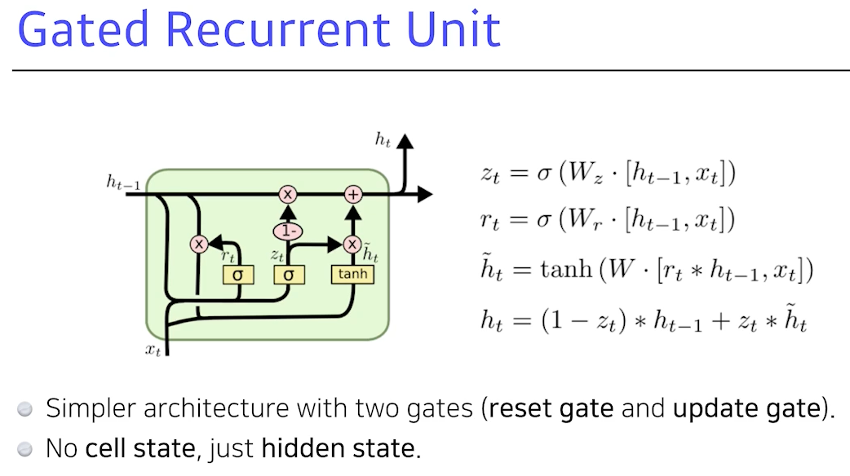

GRU