통계학 맛보기

모수가 뭐에요?

- 통계적 모델링은 적절한 가정 위에서 확률분포를 추정(inference)하는 것이 목표이며, 기계학습과 통계학이 공통적으로 추구하는 목표

- 유한한 개수의 데이터만 관찰해서 모집단의 분포를 정확하게 알아내는 것은 불가능

→ 근사적으로 확률분포 추정

- 예측모형의 목적은 분포를 정확하게 맞추는 것보다는 데이터와 추정 방법의 불확실성을 고려해서 위험 최소화하는 것 - 데이터가 특정 확률분포를 따른다고 선험적으로(a priori) 가정한 후 그 분포를 결정하는 모수(parameter) 를 추정하는 방법이 모수적(parametric) 방법론

- 특정 확률분포를 가정하지 않고 데이터에 따라 모델의 구조 및 모수의 개수가 유연하게 바뀌면 비모수적(nonparametric) 방법론이라 부름

- 기계학습의 많은 방법론은 비모수 방법론에 속함

- 모수가 없는게 아니라 모수가 무한히 많거나 데이터에 따라 바뀌는 것

확률분포 가정 예제

-

확률분포를 가정하는 방법 : 우선 히스토그램을 통해 모양 관찰

-

데이터가 2개의 값 (0, 1) 만 가지는 경우 → 베르누이 분포

-

데이터가 n 개의 이산적인 값을 가지는 경우 → 카테고리 분포

-

데이터가 [0, 1] 사이에서 값을 가지는 분포 → 베타분포

-

데이터가 0 이상의 값을 가지는 경우 → 감마분포, 로그정규분포 등

-

데이터가 (실수) 전체에서 값을 가지는 경우 → 정규분포, 라플라스분포 등

→ 연속확률분포와 이산확률분포를 관찰되는 분포에 따라 결정할 수 있음

-

-

기계적으로 확률분포를 가정 x, 데이터를 생성하는 원리를 먼저 고려하는 것이 원칙 (데이터를 관찰하고 선택해야함)

→ 어떤 확률분포로 모델링했을 때 모수 추정과 더불어 반드시 각 분포에 적절한 방법으로 검정을 해야함

데이터로 모수 추정하기

- 데이터의 확률분포를 가정했으면 모수 추정 가능

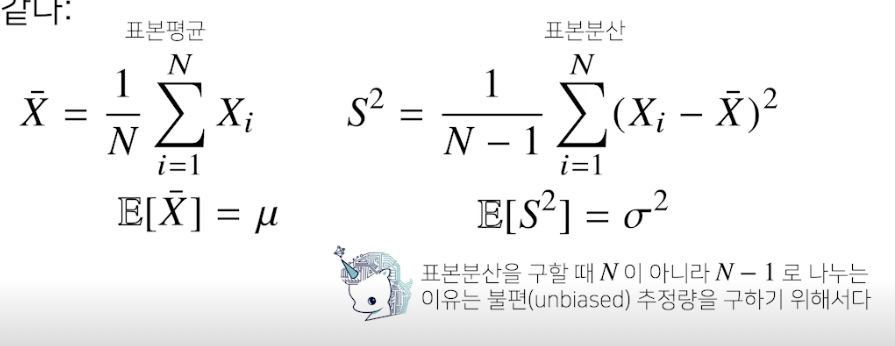

- 정규분포의 모수는 평균 와 분산 를 사용하고 이를 추정하는 통계량(statistic) 은 다음과 같음 (모집단의 평균은 , 분산은 )

- 표본 평균 : 산술평균 → 전체 데이터 평균 기대값

- 표본 분산 : (데이터 - 모평균)^2 의 산술평균 →

- 통계량의 확률분포를 표집분포(sampling distribution) 라 부르며, 특히 표본 평균의 표집분포는 N 이 커질수록 정규분포 을 따름

- 이것이 중심극한정리 (모집단의 분포가 정규분포를 따르지 않아도 성립)

- 분포에서 추출한 통계량, 표본평균의 데이터가 많을수록 분산은 0 에 가까워지고 가운데 (평균) 으로 몰림

- 이것이 중심극한정리 (모집단의 분포가 정규분포를 따르지 않아도 성립)

최대가능도 추정법

- 표본평균이나 표본분산은 중요한 통계량이지만 확률분포마다 사용하는 모수가 다르므로 적절한 통계량이 달라짐

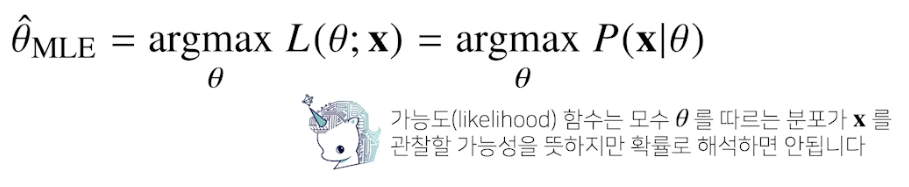

- 이론적으로 가장 가능성이 높은 모수를 추정하는 방법 중 하나는 최대가능도 추정법 (maximum likelihood estimation, MLE)

- 가능도 함수 : 주어진 데이터 x 에 대해 모수 세타를 변수로 둔 함수, 즉 데이터가 주어진 상태에서 세타를 변형시킴에 따라 값이 바뀌는 함수. 모수 세타를 따르는 분포가 데이터 x 를 관찰할 가능성 (다 더해서 1 이 안되므로 확률로 해석하면 안됨)

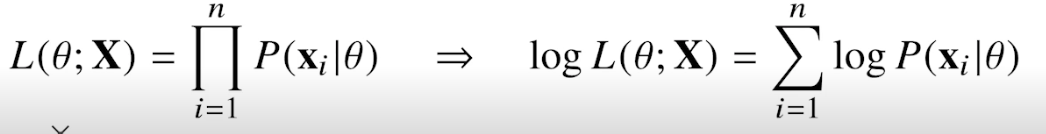

- 데이터 집합 X 가 독립적으로 추출되었을 경우 로그가능도를 최적화함

- 로그 씌우고 덧셈식으로 최적화 가능

- 독립 표본 : 서로 다른 항목의 집합에서 얻은 측정값

- 종속 표본 : 한 항목의 집합에서 얻은 측정값

- 로그 씌우고 덧셈식으로 최적화 가능

- 왜 로그가능도 사용하는가?

- 로그가능도를 최적화하는 모수 세타는 가능도를 최적화하는 MLE

- 데이터의 숫자가 적으면 상관없지만 만일 데이터의 숫자가 수억 단위가 된다면 컴퓨터의 정확도로는 가능도 계산 불가능

- 데이터가 독립이면 로그를 통해 가능도의 곱셈을 덧셈으로 바꿀 수 있음 → 컴퓨터로 연산 가능

- 경사하강법으로 가능도 최적화할 때 미분 연산을 하는데, 로그 가능도를 사용하면 이 연산량을 O() 에서 O(n) 으로 줄여줌

- 대게의 손실함수의 경우 경사하강법을 사용하므로 음의 로그가능도를 최적화

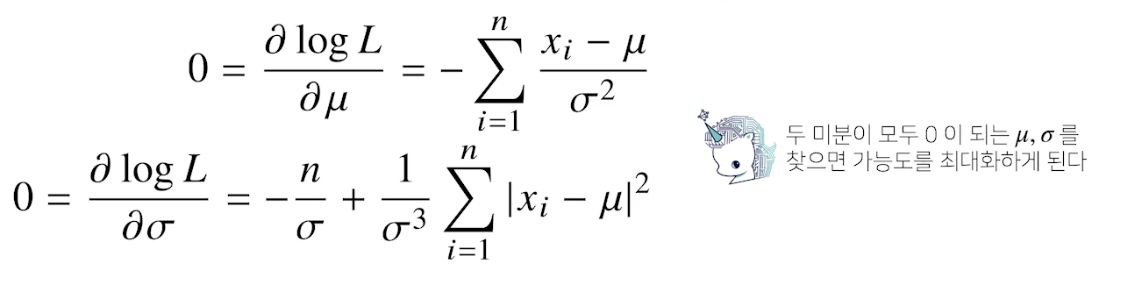

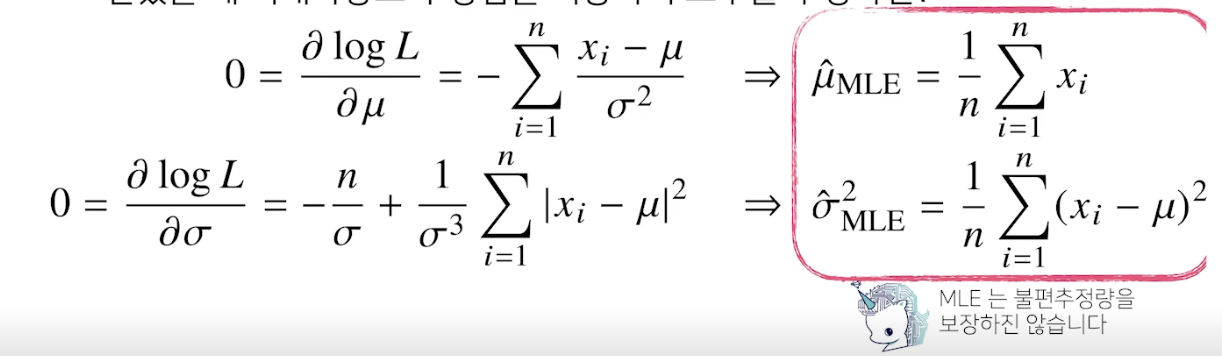

최대가능도 추정법 예제 : 정규분포

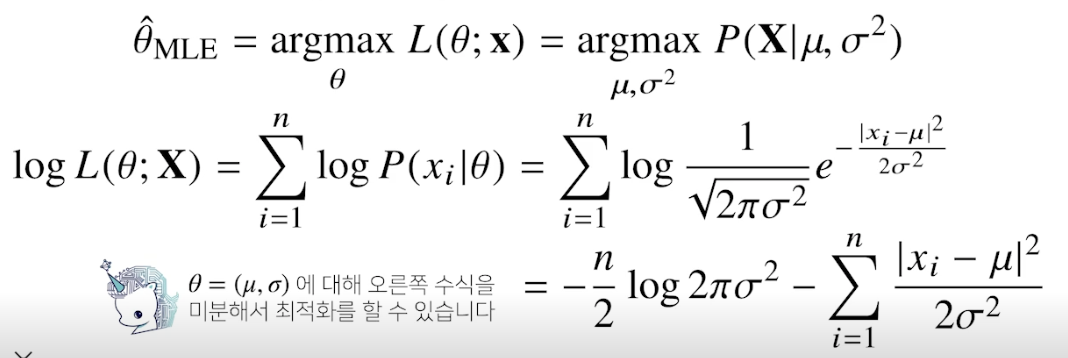

- 정규분포를 따르는 확률변수 X 로부터 독립적인 표본 {x1, ..., xn} 을 얻었을 때 최대가능도 추정법을 이용하여 모수를 추정하면?

- 주어진 데이터를 가지고 (로그) likelihood 를 최적화하는 세타를 찾아야 함

- 불편추정량을 보장하진 않지만 consistence 는 보장최대가능도 추정법 예제 : 카테고리 분포

-

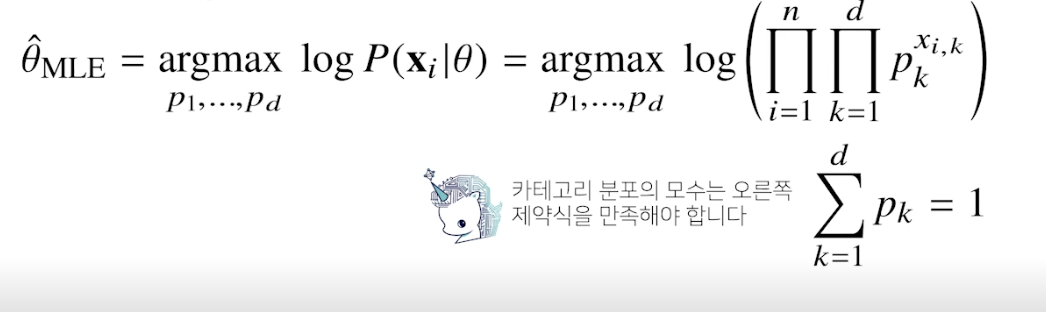

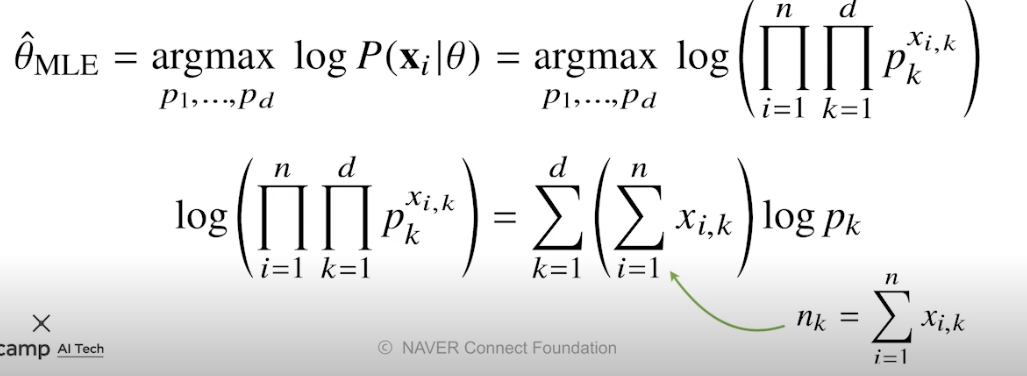

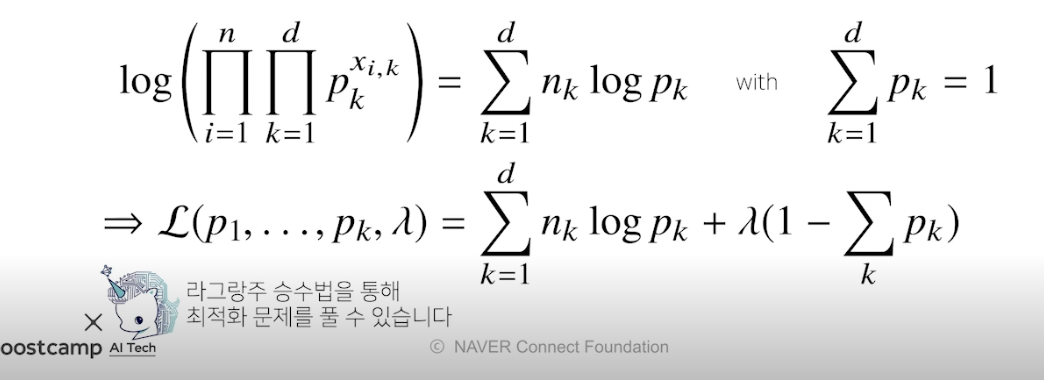

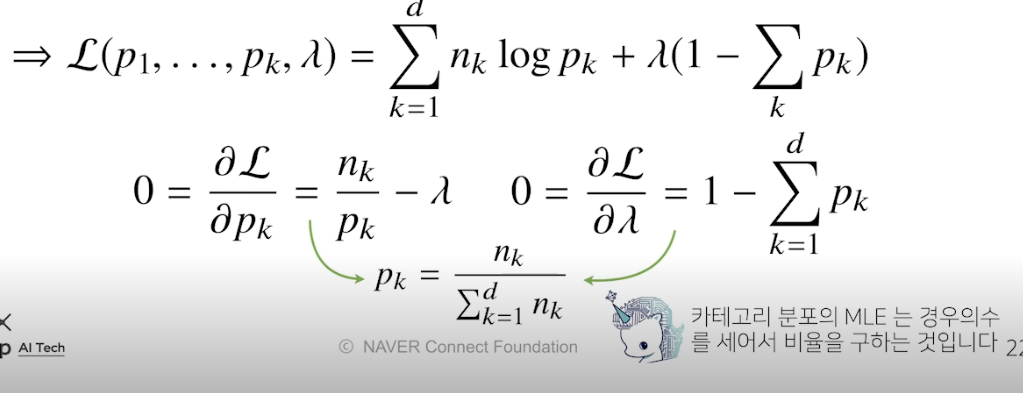

카테고리 분포 Multonoulli(x; p1, ..., pd) 를 따르는 확률변수 X 로부터 독립적인 표본 {x1, ..., xn} 까지 얻었을 때 최대가능도 추정법을 이용하여 모수를 추정하면?

(정규분포의 모수는 평균과 분산이라는 통계량인 반면, 카테고리 분포의 p 들은 1~d 차원까지 각각의 차원에서 값이 1 또는 0 이 될 확률을 의미하는 모수 → p1 ~ pd 다 더하면 1)

(Q. MLE 식에 대한 정확한 뜻을 모르겠음 → 원딜님 피피티 다시보자)

딥러닝에서 최대가능도 추정법

- 기계학습 모델 학습에서 사용

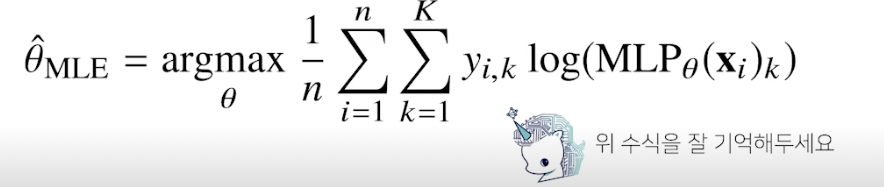

- 딥러닝 모델의 가중치를 = (W(1) , ..., W(L)) 이라 표기했을 때 분류 문제에서 소프트맥스 벡터는 카테고리분포의 모수 (p1, ..., pk) 를 모델링함

- 원핫벡터로 표현한 정답레이블 y = (y1, ..., yk) 를 관찰 데이터로 이용해 확률분포인 소프트맥스 벡터의 로그가능도 최적화 가능

확률분포의 거리 구하기

- 기계학습에서 사용되는 손실함수들은 모델이 학습하는 확률분포와 데이터에서 관찰되는 확률분포의 거리를 통해 유도

- 데이터공간에 두 개의 확률분포 P(x), Q(x) 가 있을 경우 두 확률분포 사이의 거리를 계산할 때 다음과 같은 함수들을 이용

- 총변동 거리 (Total Variation Distance, TV)

- 쿨백-라이블러 발산 (Kullback-Leibler Divergence, KL)

- 바슈타인 거리 (Wasserstein Distance)

쿨백-라이블러 발산

- 정의

- 뒷 자리 Q 를 로그의 분모로 앞자리 P 를 로그의 분자로

- 이산은 시그마, 연속은 적분

- 분해

- 두 개의 엔트로피 표현 가능

- 분류 문제에서 정답레이블을 P, 모델 예측을 Q 라 두면 최대가능도 추정법은 쿨백-라이블러 발산을 최소화하는 것과 같음

- 기계학습의 원리는 데이터로부터 확률분포 사이의 거리를 최소화하는 것과 동일

참조

BoostCamp AI Tech