m2맥북에 하둡을 설치하자

Hadoop을 접해볼 기회가 없었기에 이론공부라도 해보기 위해 Udemy Hadoop 기초강의를 듣기 시작했다

강의에서는 Virtual Machine을 설치해서 사용하지만 m2맥북에서는 잘 안되는거 같아서 터미널에 설치를 먼저 하기로 했다

1. homebrew를 이용하여 하둡을 install해준다

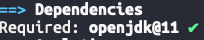

brew install hadoop자바는 8이나 11버전이 설치되어 있어야 한다

brew info hadoop위 커멘드로 확인해 봤을때 맞게 설치되어 있는지도 확인 가능하다

2. 환경변수를 수정해주어야 한다

내가 설치한 버전은 3.3.6 이지만 확인후에 설치된 버전을 넣어주자

아래의 경로에서 hadoop-env.sh 를 수정해주면 된다

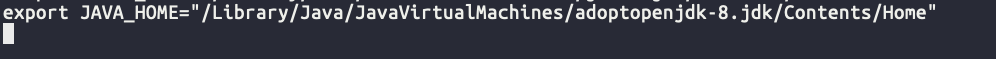

cd /opt/homebrew/Cellar/hadoop/3.3.6/libexec/etc/hadoop먼저 내 로컬의 자바 경로를 확인 후에 hadoop-env.sh 에 환경변수를 넣어주면 된다

❗️자바 버전 꼭 확인하고 넣어주자!!

8버전을 깔았는데 여러 버전이 깔려있다보니 환경변수가 8이 아닐수 있다

이거때매 삽질 오지게함

(다른 파일들도 수정해줘야 한다는 정보들이 있는데 뭐때문인지 아직 잘 모르겠다 그리고 찾는 정보마다 수정하는 내용도 좀 달라서 더 알아봐야 할거같다)

일단 아래의 파일들도 수정해준다

- core-site.xml

아래부분을 추가해주면 된다

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>- mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.application.classpath</name>

<value

>$HADOOP_MAPRED_HOME/share/hadoop/mapreduce/*:$HADOOP_MAPRED_HOME/share/hadoop/mapreduce/lib/*</value

>

</property>

</configuration>- hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>- yarn-site.xml

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.env-whitelist</name>

<value

>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_HOME,PATH,LANG,TZ,HADOOP_MAPRED_HOME</value

>

</property>

</configuration>3. ssh 설정을 해준다

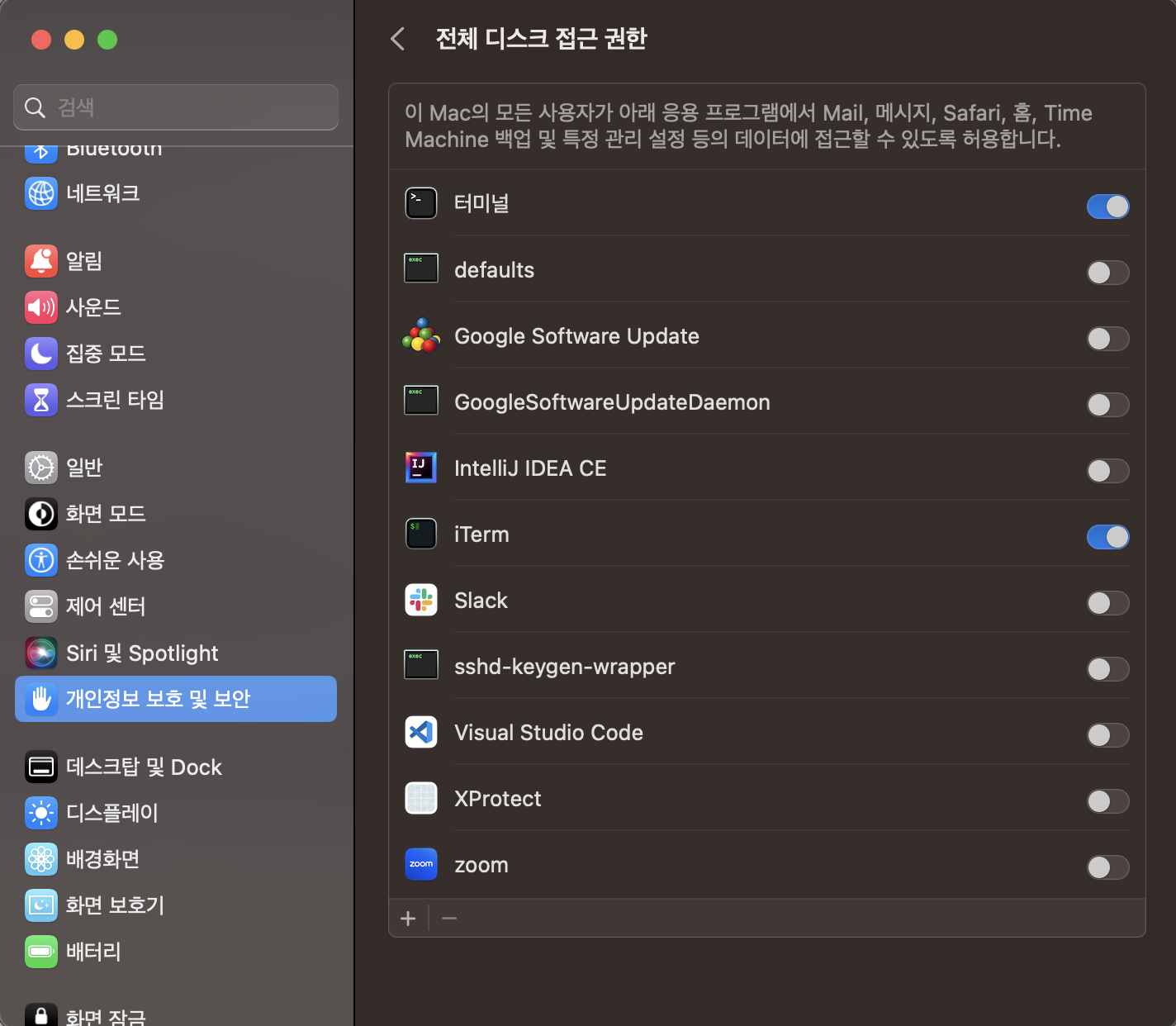

미리 되어있는 사람들도 있겠지만 나는 아무런 설정을 해둔게 없어서 ssh 부터 활성화 시켜줬다

시스템 환경설정 - 개인정보 보호 및 보안 - 전체 디스크 접근 권한 에서 터미널을 선택해서 허용해주면 된다

터미널, iTerm을 사용하므로 나는 두개 모두 허용시켜 줬다

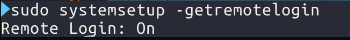

허용해준 후에 systemsetup 명령어로 on 시켜주면 된다

sudo systemsetup -setremotelogin on 후에 확인해보면 on 되어 있는것을 볼수있다

4.이제 실행을 시켜보자

먼저 로컬호스트로 접속을 하고

ssh localhost하둡 파일 시스템으로 포멧을 해야한다

cd /opt/homebrew/Cellar/hadoop/3.3.6/libexec

hdfs namenode -format그냥 실행을 했더니 "Permission denied (publickey,password,keyboard-interactive)" 에러가 떠서 ssh key 생성을 해주었다

그 다음엔 아래와 같이 실행하고 종료하면 된다

sbin/start-all.sh

sbin/start-dfs.sh

sbin/start-yarn.sh

sbin/stop-all.sh

sbin/stop-dfs.sh

sbin/stop-yarn.sh5. 상태를 확인해 보자

먼저 jps로 실행을 확인할 수 있다

정상 실행 되고 있으면 local host 에 접속해서 확인 가능하다

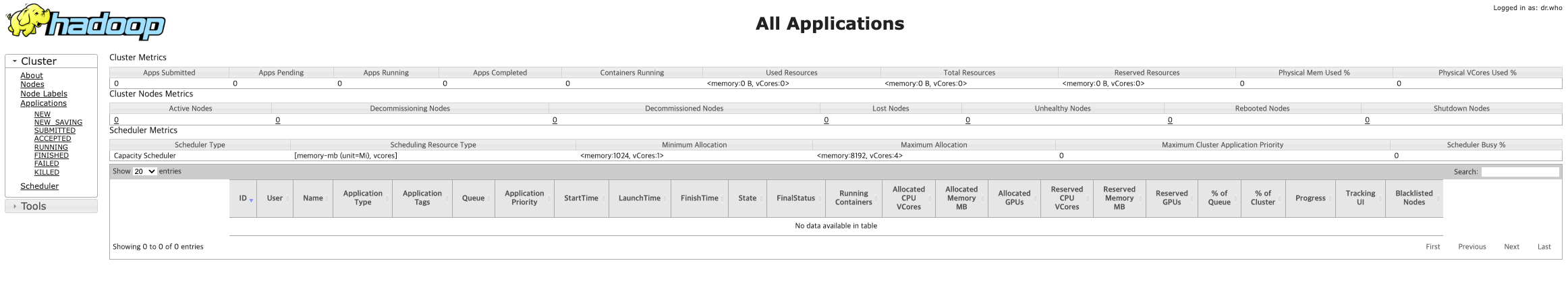

- Cluster status : http://localhost:8088

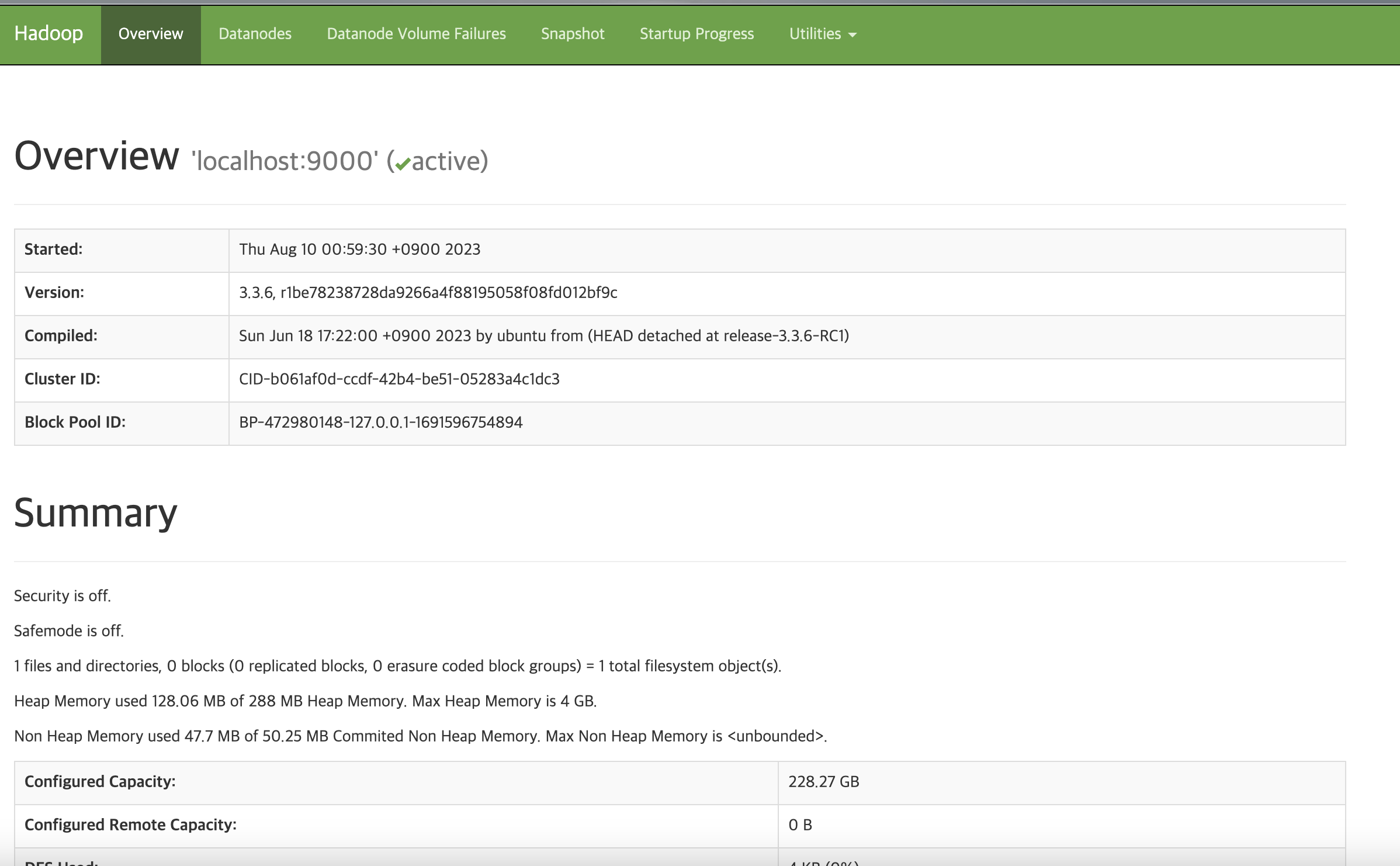

- HDFS status : http://localhost:9870

[Cluster status]

[HDFS status]

이렇게 설치 끝!!!!

설치부터 난관이다,,,,