Kafka

1.Kafka Consumer Config

한번에 가져올 수 있는 최소 데이터 사이즈지정한 크기보다 작다면 데이터가 누적될 때까지 기다림한번에 가져올 수 있는 최대 데이터 사이즈요청에 대해 응답을 기다리는 최대 시간컨슈머가 살아있는 것으로 판단하는 시간10초 안에 컨슈머가 그룹 코디네이터에게 하트비트를 보내야함

2.Apache Kafka Consumer Rebalance

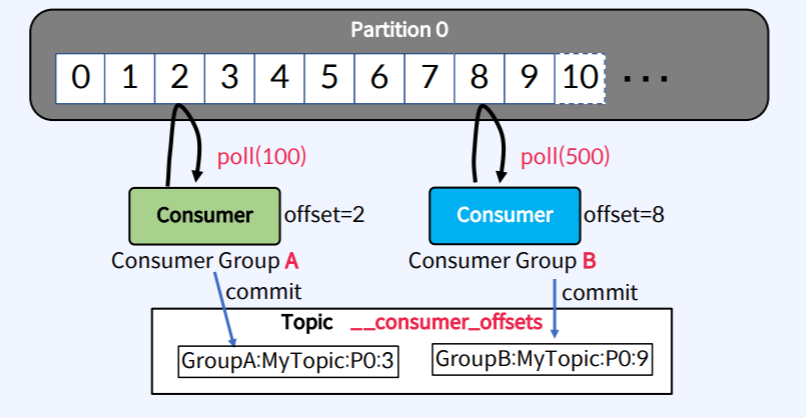

Consumer는 메시지를 가져오기 위해서 Partition에 연속적으로 Poll한다.가져온 위치를 나타내는 offset 정보를 \_\_consumer_offsets Topic에 저장하여 관리한다.동일한 group.id로 구성된 모든 Consumer들은 하나의 Cons

3.Kafka Producer 이슈 해결

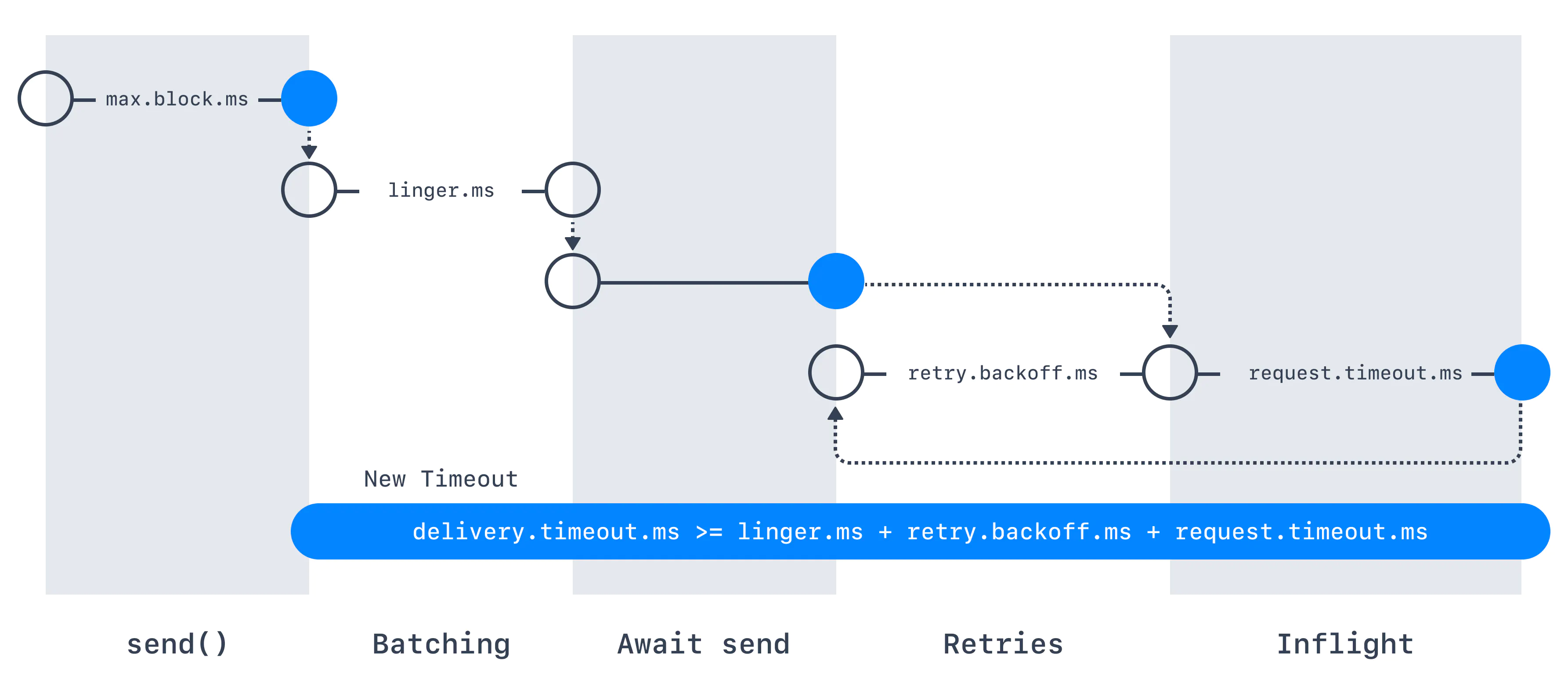

실시간 프로젝트 도중 발생했던 프로듀서 관련 이슈 해결에 대해서 적어본다.타겟 카프카로 메세지를 보내는 도중 장애를 일으키는 상황을 테스트 중 타겟 카프카 브로커가 내려갔음에도 불구하고 에러상황을 캐치못하는 상황이 발생되었다.모듈 점검을 하다보니 Producer Opt

4.Kafka Producer Config 정리

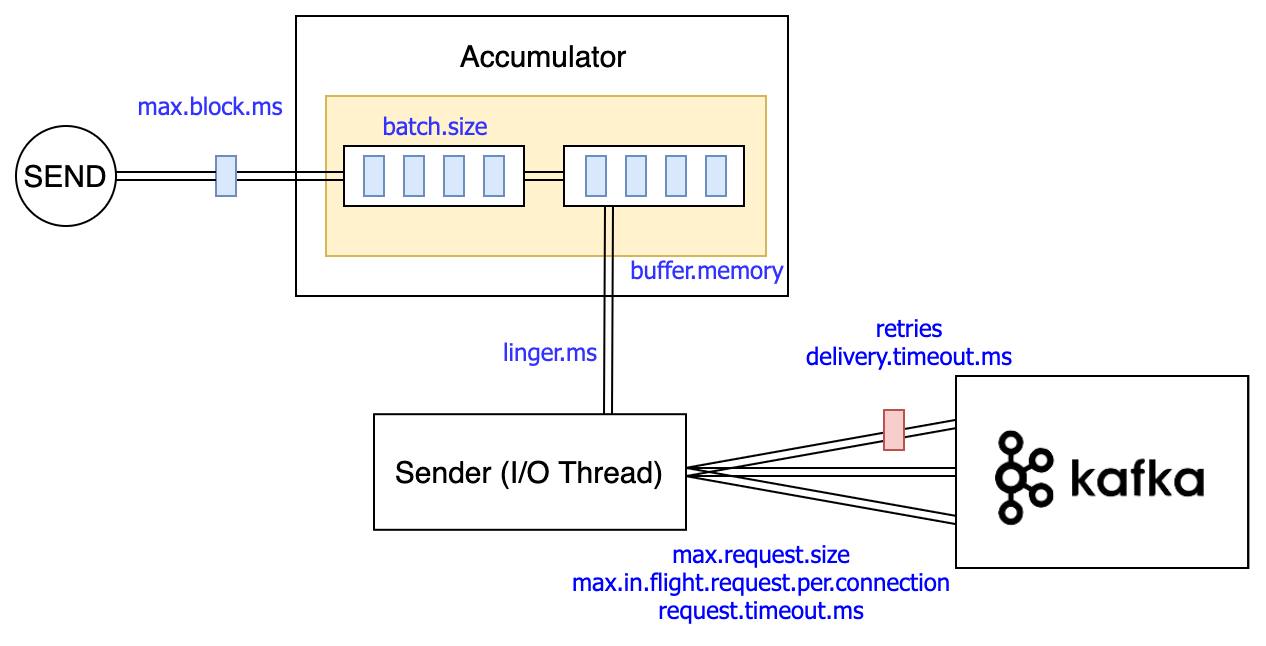

프로듀서를 사용하면서 한번 쯤 정리가 필요해보여서 적어본다.프로듀서의 경우는 레코드를 send를 할 때, 데이터를 바로 브로커로 보내는게아니라 비동기로 전송된다.그말은 버퍼에 데이터를 모아뒀다가 설정값에 따라 보내진다는 뜻이다.2가지 Accumulator / Sende

5.Kafka Connect

오랫만에 궁금했던 Kafka Connect에 대해 읽고 정리해보고자 한다. Kafka Connect는 기존 Kafka를 사용하면서 비지니스 요건에 따라 계속 생기는 Pub/Sub 개발하는데 있어 비용을 줄이고 효과적으로 관리하고자 나왔다고한다. 위 사진 예시처럼 기존에

6.AutoMQ

이것저것 검색해보다가 카프카 관련 오픈소스가 신기한게 검색되어서 남겨본다.Apache Kafka 완전 호환 오픈소스 메시징 플랫폼Apache License 2.0 기반 → 상용 환경에서도 자유롭게 사용 가능기존 Kafka의 한계(로컬 디스크 기반 스토리지, 리밸런싱 비