⚠️잠깐! 들어가기 전 초기 세팅하세요

👤 계정 만들기

sudo adduser hadoop sudo passwd hadoop👤 계정 로그인

su hadoop+) 로그아웃

exit

📥 vim 편집기 설치

sudo yum install vim⌨️ 막간을 이용한 vi 편집기 단축키 모음!

yy=> 복사

p=> 붙여넣기

x=> 삭제

i=> 삽입

dd=> 지우기

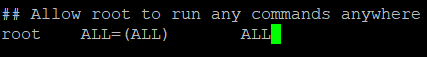

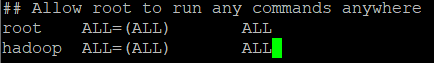

⚔️ hadoop이라는 계정에 sudo 권한 주기

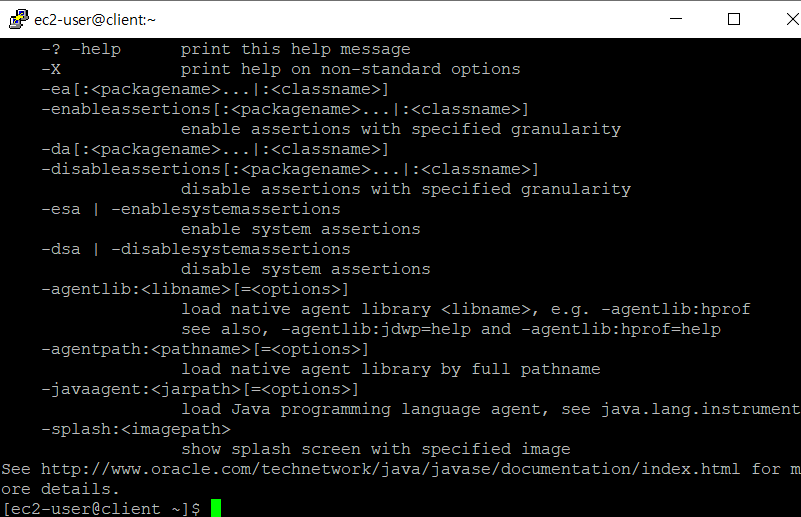

☕✅ java 잘 설치되어있는지 확인

$ java👉🏻 쳤을 때 아래 사진처럼 뭐가 막 나오면 OK

❗ 설치 잘 안되었다면?

sudo yum installl net-tools sudo yum install vim wget -y sudo dnf install java-1.8.0-openjdk ant -y

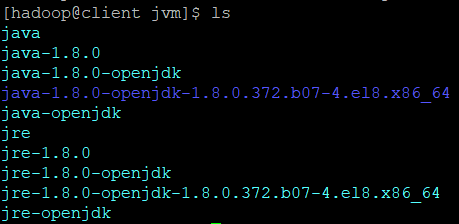

📁 java 폴더로 이동

$ cd /usr/lib/jvm✅ java 폴더에 openjdk(무료버전, 오픈소스)가 잘 들어있나 확인

$ ls

=> 이렇게 나오면 OK

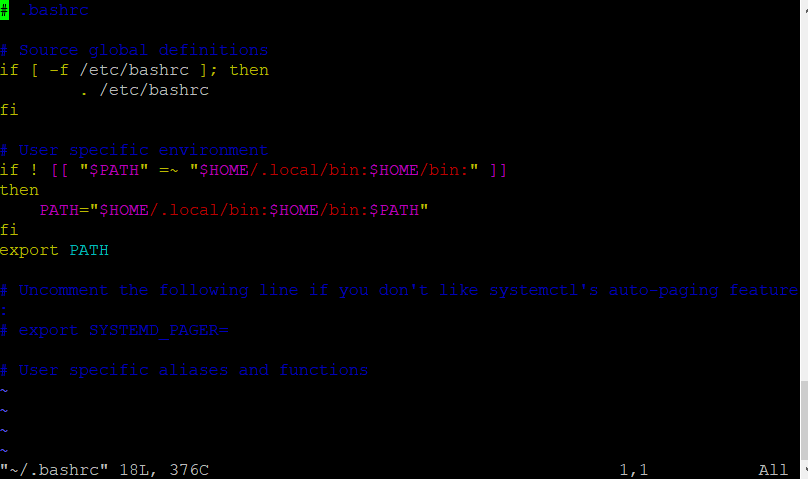

🦸🏻 bashrc와 환경변수

- bashrc => 환경변수를 등록하는 곳

$ vim ~/.bashrc

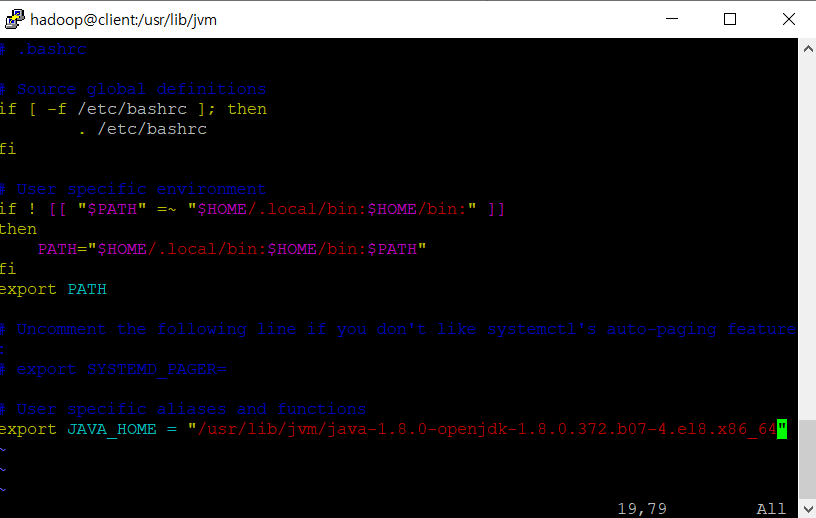

👉🏻 vim 편집기로 들어간 환경변수에 아래 코드 입력하여 JAVA_HOME 이라는 환경변수 등록 후 저장하고 나오기(wq)

$ export JAVA_HOME="/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.372.b07-4.el8.x86_64"

☑️ bashrc에 환경변수 업데이트 및 확인

- source: 갱신하겠다

지금 bashrc에 등록한 환경변수를 업데이트 하겠다(앞으로 사용하겠다)

$ source ~/.bashrc잘 되었는지 확인

$ echo $JAVA_HOME👉🏻 변수명 앞에 달러 표시($) 있으면 환경변수라는 뜻

🐘 hadoop을 이용하기 위해, 우리는 4 개의 컴퓨터(EC2 인스턴스)를 만들 것임.

💻 먼저, 하나의 컴퓨터에 대한 이미지를 만들고 나머지 세 개에 복제하는 방식으로 만들 것임.

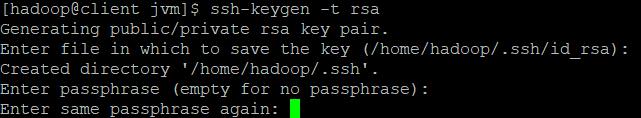

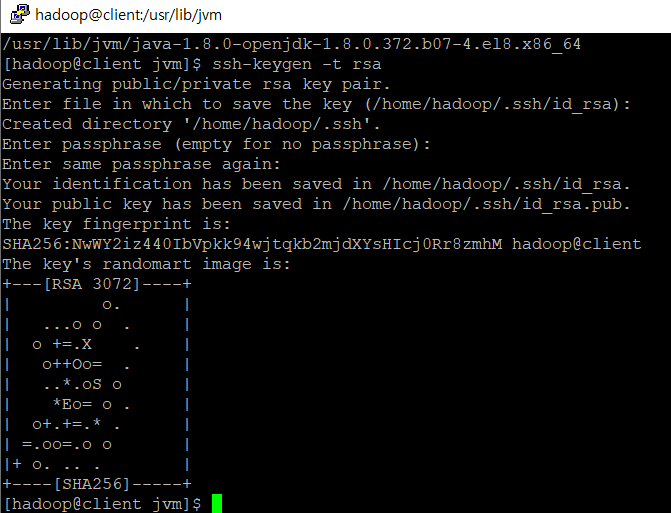

🔐hadoop 보안키

- ssh-keygen: 비밀번호 안물어보고 접속하게 하는 것

$ ssh-keygen -t rsa

=> enter enter 누르면 됨

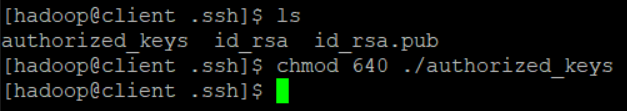

$ cd ~/.ssh

$ cat id_rsa.pub >> authorized_keys

$ chmod 640 ./authorized_keys

📥 python 3.9 설치

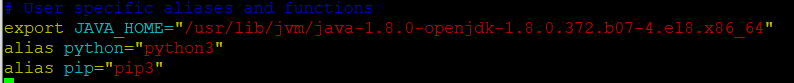

$ sudo yum install python39📝 명령어 약어 설정하기

- 아까 열었던 bashrc 파일 마지막 줄에 약어 설정하기

$ vim ~/.bashrc

# 편집기 열리면 맨 아랫줄에 아래 두 줄 코드 입력

alias python="python3"

alias pip="pip3"

- vim 편집기 다 저장하고 나왔으면 source로 업데이트

$ source ~/.bashrc📥하둡 설치하기(공식사이트꺼)

- 다운받기

$ cd ~

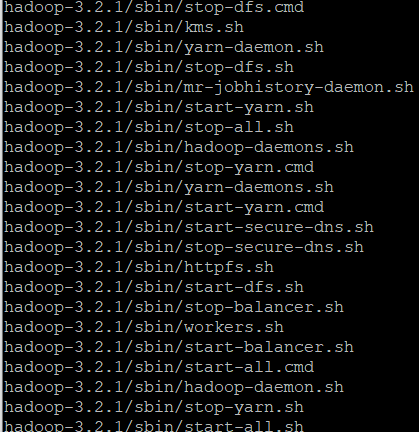

wget https://archive.apache.org/dist/hadoop/common/hadoop-3.2.1/hadoop-3.2.1.tar.gztar파일 압축 풀기

$ tar xvzf hadoop-3.2.1.tar.gz

👉🏻 무지막지하게 나옴.

👉🏻 안보고 싶으면 v 옵션 빼면 됨

💬 이름 바꾸기

이름 바꾸는 명령어 없음. 새로운 이름의 파일에 이동시키기 방식

$ mv ./hadoop-3.2.1 ./hadoop🔐(개인)키 만든거 이동시키기

$ cd ~/.ssh

$ cat id_rsa

$ vim id_rsavi 편집기로 열리는 키 내용을 전체 복사한 뒤, 메모장에 붙여넣고 확장자 .pem으로 저장

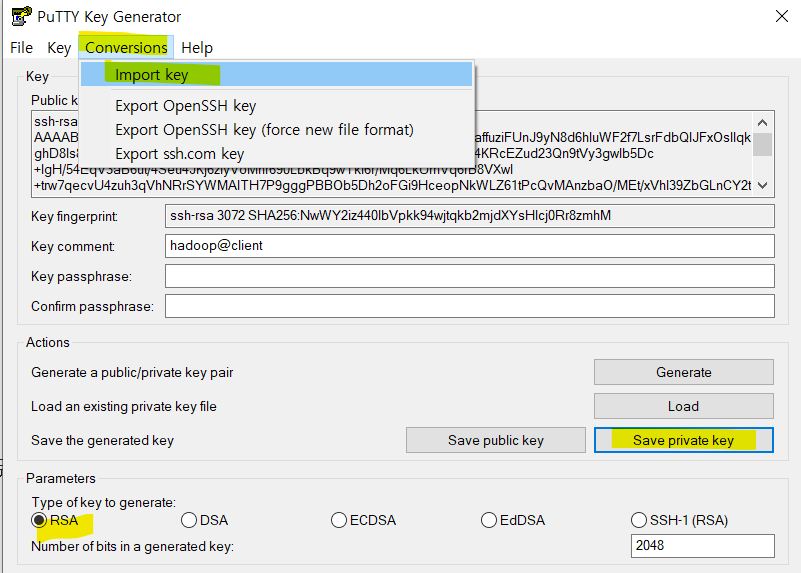

🔄puttygen pem->ppk 변환

아까 저장한 .pem 파일 import해서 save private key 버튼 눌러 .ppk 생성

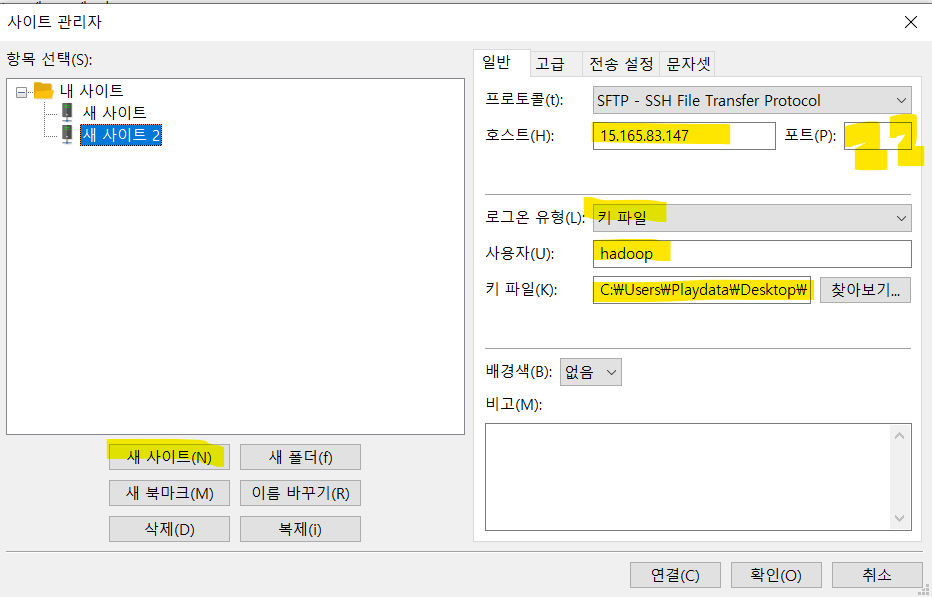

❤️ filezilla에 hadoop계정으로 빈둡 EC2 접속하기

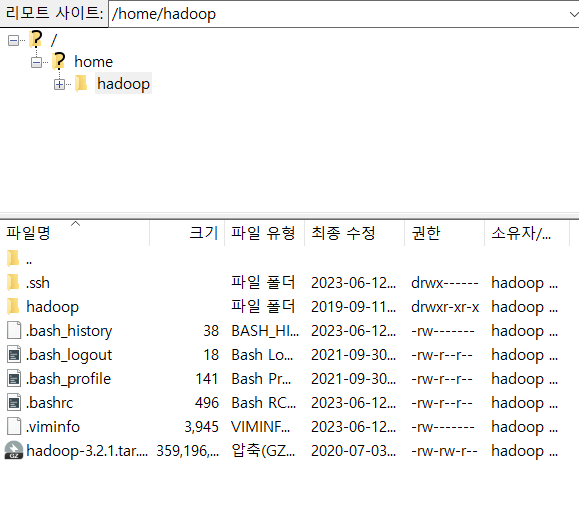

아까 위에서 만든 hadoop.ppk 파일로 접속

=> 연결 잘 되면 아까 putty에서 다운받았던 파일 잘 보임 OK