Chapter 7. Caching

(해석 또는 이해가 잘못된 부분이 있다면 댓글로 편하게 알려주세요.)

❤️ 원문 번역 ❤️

Preface

Web caches are HTTP devices that automatically keep copies of popular documents. When a web request arrives at a cache, if a local “cached” copy is available, the document is served from the local storage instead of from the origin server. Caches have the following benefits:

• Caches reduce redundant data transfers, saving you money in network charges.

• Caches reduce network bottlenecks. Pages load faster without more bandwidth.

• Caches reduce demand on origin servers. Servers reply faster and avoid overload.

• Caches reduce distance delays, because pages load slower from farther away.

-

웹 캐시는 자주 접근되는 문서의 사본을 자동으로 저장하는 HTTP 디바이스입니다.

-

웹 요청이 캐시에 도달했을 때 캐싱되어 있는 사본을 이용할 수 있다면 origin 서버 대신 로컬 저장소에서 문서를 전달합니다.

-

캐시는 다음과 같은 이점을 지니고 있습니다.

- 캐시는 중복 데이터의 이동을 감소시키고 네트워크 요금을 절약합니다.

- 캐시는 네트워크 병목 현상을 줄입니다. 페이지가 추가적인 대역폭을 소모하지 않고 빠르게 로드됩니다.

- 캐시는 origin 서버에 대한 의존을 줄입니다. 서버는 더 빠르게 응답할 수 있고 과부하를 피할 수 있습니다.

- 캐시는 거리 지연을 줄입니다. 멀리 위치한 서버에서 페이지를 로드하는 것이 더 느리기 때문입니다.

In this chapter, we explain how caches improve performance and reduce cost, how to measure their effectiveness, and where to place caches to maximize impact. We also explain how HTTP keeps cached copies fresh and how caches interact with other caches and servers.

-

이번 챕터에서는 캐시가 성능을 향상시키고 비용을 줄이는 방법과 캐시의 효율성을 측정한 방법을 설명합니다. 그리고 효과를 극대화하기 위해 캐시를 어디에 두어야 하는지 등에 대해 설명합니다.

-

HTTP가 캐싱된 사본을 원본처럼 유지하는 방법, 한 캐시가 다른 캐시나 서버와 상호작용하는 방법에 대해서도 설명합니다.

Redundant Data Transfers

When multiple clients access a popular origin server page, the server transmits the same document multiple times, once to each client. The same bytes travel across the network over and over again. These redundant data transfers eat up expensive network bandwidth, slow down transfers, and overload web servers. With caches, the cache keeps a copy of the first server response. Subsequent requests can be fulfilled from the cached copy, reducing wasteful, duplicate traffic to and from origin servers.

-

여러 명의 클라이언트가 origin 서버의 인기 있는 페이지에 접근하고자 할 때, 서버는 각 클라이언트에게 하나씩 동일한 문서를 여러 번 전송하게 됩니다.

-

동일한 바이트가 네트워크를 따라 전송되고 또 전송됩니다.

-

이렇게 중복된 데이터는 많은 양의 네트워크 대역폭을 소모하고 전송 속도를 느리게 하며, 웹 서버를 과부하 시킵니다.

-

캐시를 사용하면 첫 번째 서버 응답의 사본을 저장합니다.

-

후속 요청은 캐싱된 사본으로 충족할 수 있으므로, origin 서버에 드나드는 낭비되고 중복되는 트래픽을 줄일 수 있습니다.

Bandwidth Bottlenecks

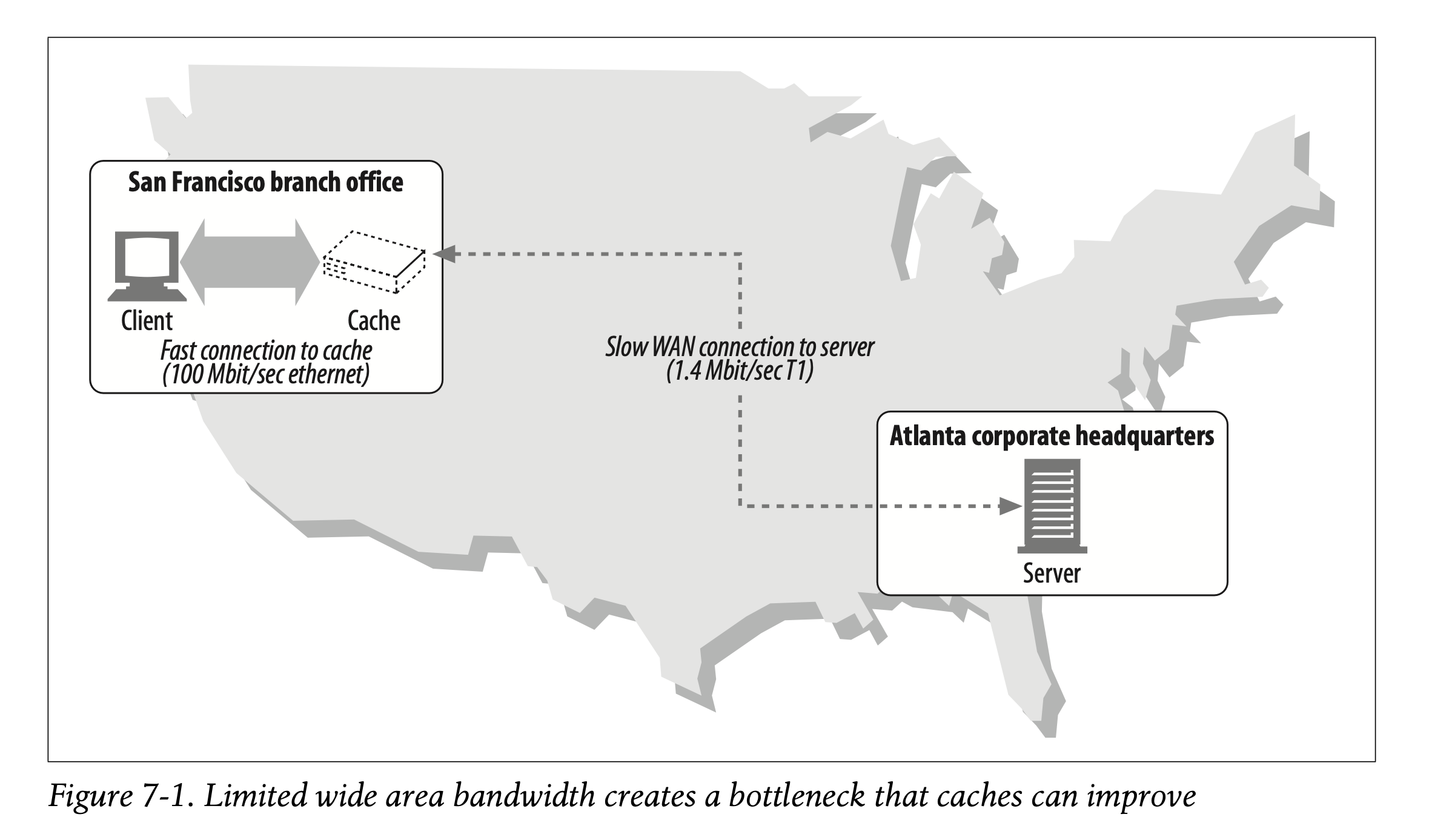

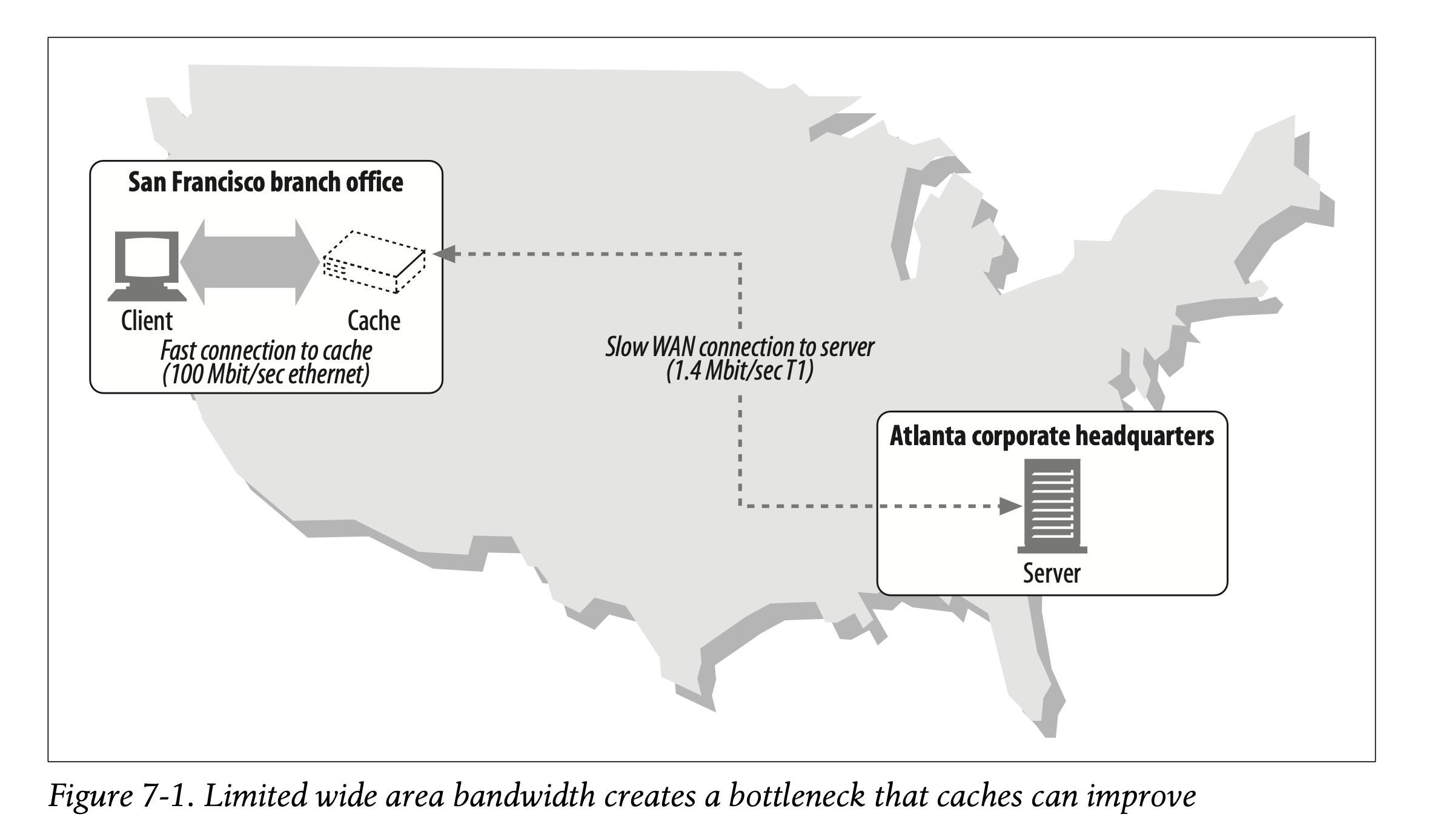

Caches also can reduce network bottlenecks. Many networks provide more bandwidth to local network clients than to remote servers (Figure 7-1). Clients access servers at the speed of the slowest network on the way. If a client gets a copy from a cache on a fast LAN, caching can boost performance—especially for larger documents.

-

캐시는 네트워크 병목을 줄일 수도 있습니다.

-

많은 네트워크는 원격 서버보다 로컬 네트워크 클라이언트에게 더 많은 대역폭을 제공하고 있습니다. (Figure 7-1)

-

클라이언트는 가장 느린 네트워크의 속도로 서버에 접근합니다.

-

만약 클라이언트가 빠른 LAN에 위치한 캐시를 통해 사본을 가져올 수 있다면, 캐싱은 성능을 향상시킬 수 있습니다. 특히 큰 문서를 가져온다면 더욱 그렇습니다.

In Figure 7-1, it might take 30 seconds for a user in the San Francisco branch of Joe’s Hardware, Inc. to download a 5-MB inventory file from the Atlanta headquarters, across the 1.4-Mbps T1 Internet connection. If the document was cached in the San Francisco office, a local user might be able to get the same document in less than a second across the Ethernet connection.

-

Figure 7-1에 따르면, Joe's Hardware의 San Francisco 지점에 있는 유저는 1.4Mbps Atlanta 본사에서 T1 인터넷 연결을 통해 5MB 인벤토리 파일을 다운로드 받는 데 30초가 소요됩니다.

-

만약 문서가 San Francisco 오피스에 캐시되어 있다면, 로컬 사용자는 이더넷 연결을 통해 동일한 문서를 적은 시간 내에 불러올 수 있습니다.

Table 7-1 shows how bandwidth affects transfer time for a few different network speeds and a few different sizes of documents. Bandwidth causes noticeable delays for larger documents, and the speed difference between different network types is dramatic. *A56-Kbps modem would take 749 seconds(over 12minutes) to transfer a 5-MB file that could be transported in under a second across a fast Ethernet LAN.

-

Table 7-1은 대역폭이 서로 다른 네트워크 속도와 문서의 크기에 따라 전송 시간에 어떻게 영향을 미치는지를 나타냅니다.

-

대역폭으로 인해 크기가 큰 문서는 확연한 지연을 유발하고, 서로 다른 네트워크간 속도 차이가 크게 발생하게 됩니다.

-

A56-Kbps 모뎀은 5MB 파일을 전송하는 데 749초(약 12분)가 걸립니다. 속도가 빠른 이더넷 LAN에서는 1초도 걸리지 않는 파일입니다.

🧡 요약 정리 🧡

Advantages of Caching

- 중복 데이터 전송 감소

- 네트워크 대역폭 소모 감소

- 웹 서버 과부하 감소

- 전송 속도 증가

- 네트워크 병목 감소

- 로컬 네트워크 대역폭 > 원격 서버 대역폭

- LAN에서 문서를 가져오는 것이 유리

💛 감상 💛

- 4월 말에 잠적한 이후로 네 달을 쉬다가 다시 돌아왔습니다. 마냥 쉰 건 아니고, 학기 중에는 학업과 스터디에 조금 더 집중을 했습니다. 그렇게 TIL의 존재는 까마득하게 잊고 있다가... 최근에 프로젝트를 같이 하고 있는 팀원 분들이랑 술을 마셨는데, 제 Velog를 슬쩍 구경했다고 하시더라고요 ㅋㅋㅋㅋ 지금도 보고 계실지도 모릅니다. 뭔가뭔가 너무 부끄러운 거예요. 작심삼일 일기장을 들킨 느낌이라 🤣 그래서 다시 TIL을 써보기로 했습니다. 예전만큼 자주는 못 쓰겠지만 안 하는 것보다는 나으니까요! 제 좌우명이 작심삼일도 100번이면 300일을 공부한다거든요. 멈추더라도 다시 시작할 줄 아는 사람이 될 겁니다.