Model : Macbook Pro - M3 Pro

OS : MacOS Sequoia 15.2

RAM : 18G

Storage : 512G

모든 실행 코드는 위 환경에서 진행되었습니다.

요즘 DeepSeek 때문에 난리더군요,,, 경량화(양자화 + 지식증류)로 학습비용이 저렴한 모델이라고 합니다. 보통 이런건 코드 = 자산 이라 대기업에서는 공개를 꺼려하는데 여기는 쿨하게 오픈소스 + 가중치까지 공개했습니다. 그래서 해당 모델을 파인 튜닝하거나 더 발전시킨 모델이 나오지 싶습니다.

그래서 이걸 로컬에서 한 번 돌려보고자 합니다.

로컬로 돌리면 물론 아래 제약사항이 생깁니다.

- GPU가 있어야한다. (스펙이 고성능이면 더 좋음)

- 불편하다. (터미널 기반으로 작동되는듯함)

- 파일첨부 안됨.

- 대화 기록 안됨.

하지만 장점도 있습니다.

- 보안 이슈 해결 (민감정보 유출 방지)

- 인터넷 제한 X

이 정도 장단점이 있습니다.

이제 DeepSeek R1 모델을 로컬에서 구축해보겠습니다.

ollama 설치

해당 페이지에 접속하시고 Download 버튼을 누릅니다.

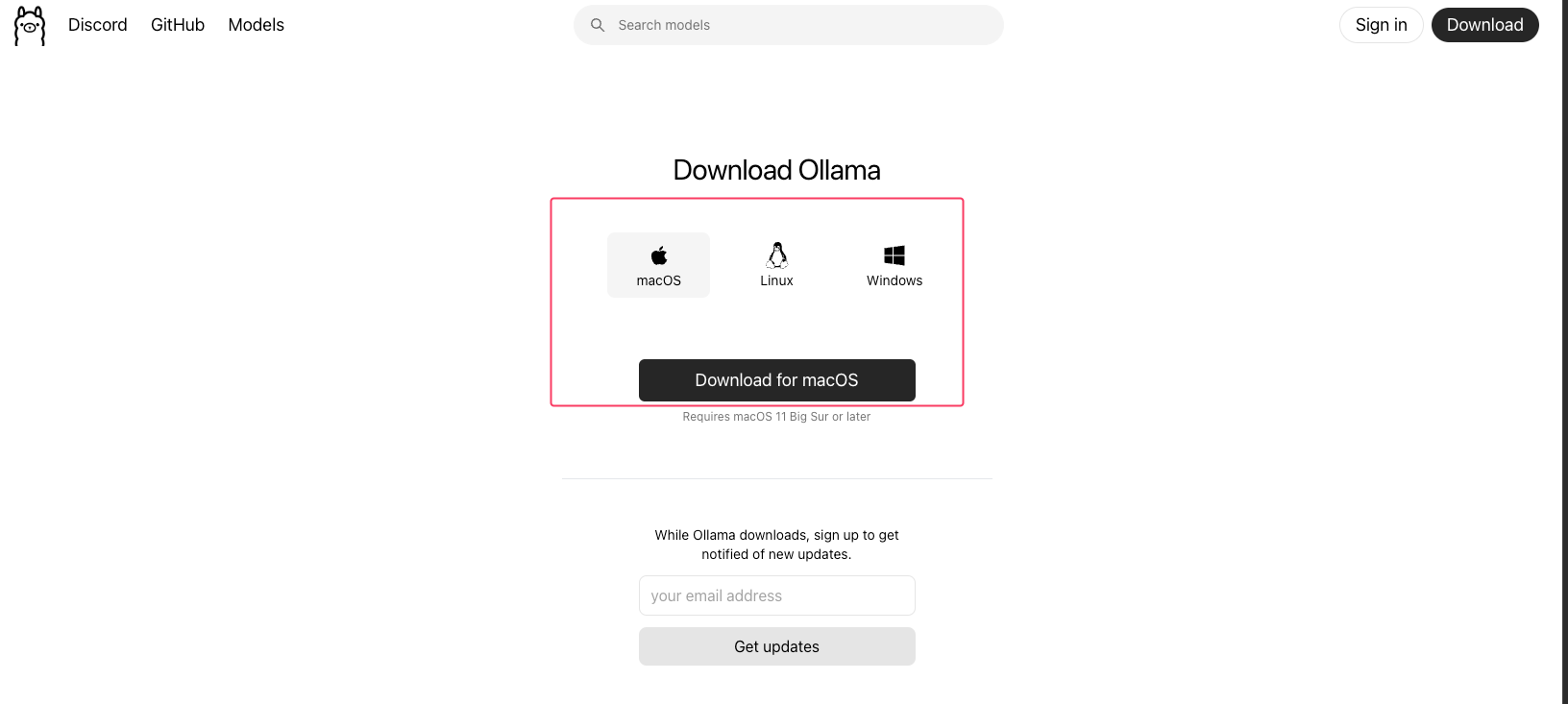

본인의 운영체제제 맞는 파일을 다운로드 한 후 설치해줍니다.

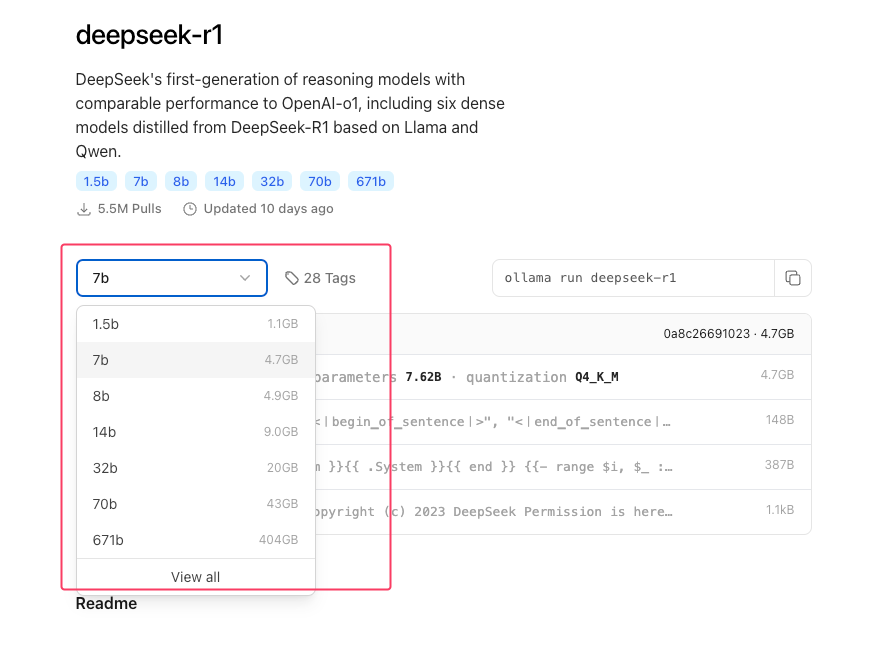

이제 ollama를 설치했다면 제가 원하는 언어 모델인 DeepSeek R1을 찾아서 설치해봅시다.

1.5b ~ 671b까지 다양한 크기의 언어 모델이 있습니다. 본인 PC의 VRAM크기에 맞게 다운로드 받아주시면 됩니다. 저는 14b를 사용해도 렉 없이 정상작동 되었습니다.

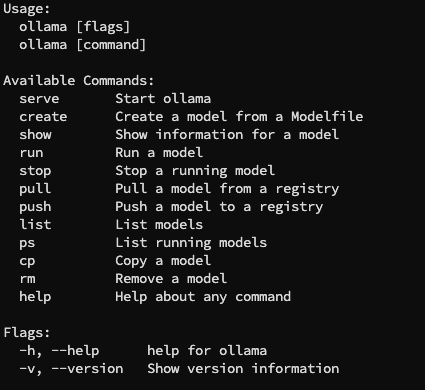

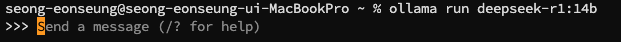

ollama 실행

ollama run deepseek-r1:14b본인의 로컬 터미널에 찾은 모델을 다운로드 받아주면 자동으로 대화환경이 실행됩니다.

모델 크기에 따라 다운로드 시간은 상이하며, 한 15분정도 걸리는 것 같습니다.

혹시나 모델을 잘못 다운로드 받았거나 삭제하고 싶다면

ollama rm deepseek-r1:14brm 명령어를 사용해주면 됩니다.

그외 다른 커맨드는 위 이미지를 참고하시면 될 것 같습니다.

설치가 정상적으로 되었다면 아래와 같이 대화창이 나올 것입니다.

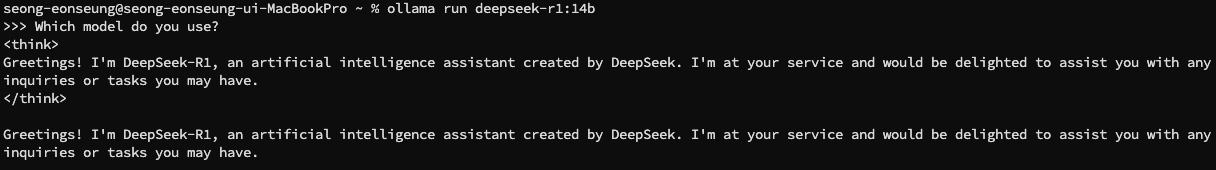

이제 텍스트를 입력하고 답변이 나오는지 출력해보겠습니다.

DeepSeek 모델이 중국어, 영어 위주로 학습이 되었다보니,,,, 한국어는 영 답변이 시원치 않습니다. 한자도 섞여서 출력이 되는 현상도 종종 보이고,, 가벼운 모델이다보니 좋은 성능을 기대하긴 어려웠네요..

무슨 모델 사용했는지 물어보니 잘 대답을 해주네요. 영어는 그래도 답변을 잘해주는 것 같습니다.

여기까지가 DeepSeek 모델을 로컬에서 실행하는 방법이었습니다.

생각보다 굉장히 쉽게 ollama를 통해 잘 구현되어 있어서 UI 환경은 스스로 만들어써도 될 것 같습니다. 물론 툴이 나와있겠지만, 개발하려면 한 번쯤은 삽질해봐도 좋지 않을까 하는 생각입니다.

아래는 공식 깃허브 계정과 관련 Paper입니다.

DeepSeek 깃허브 계정

https://github.com/deepseek-ai

V3 Technical Report

https://arxiv.org/abs/2412.19437

R1 논문

https://arxiv.org/abs/2501.12948