'SK AI 서밋 2024'는 2024년 11월 4일부터 5일까지 서울 코엑스에서 개최된 대규모 인공지능 행사로, 국내외 AI 석학과 기업가들이 참여하여 AI 시대의 공존 방안을 논의하고 생태계 강화 방안을 모색했습니다.

이틀의 서밋 일정 동안, Day 1은 기술적 기반(인프라와 반도체)과 생태계 강화에 초점을 맞추어 "AI 혁신의 뼈대"를 구축하려는 논의였다면, Day 2는 이를 바탕으로 "AI의 활용과 확장"을 논의하며 개인화 및 국가 전략으로의 연결을 탐구했습니다.

Day 1 주요 컨셉 및 주제 정의

-

Key-Concept: "AI 생태계와 인프라의 혁신: 기술, 협력, 그리고 지속 가능성" -

Day 1은 AI 기술의 발전을 위한 인프라와 생태계의 혁신, 글로벌 협력 방안에 중점을 두고 논의되었습니다. 특히 AI 인프라 구축, 반도체 기술, 에너지 자원 활용, 그리고 Generative AI의 잠재력이 핵심적으로 다뤄졌습니다.

-

핵심 키워드:

- AI 생태계 강화

- 반도체 및 AI 인프라

- 지속 가능 에너지 활용

- Generative AI

- 글로벌 협력

Day 2 주요 컨셉 및 주제 정의

-

Key-Concept: "AI의 개인화와 글로벌화: K-AI 생태계, 신사업, 그리고 정책 방향" -

Day 2는 AI 기술의 개인화 서비스, K-AI 생태계의 글로벌화, 그리고 국가 전략과 정책 방향에 대한 논의가 이루어졌습니다. 특히 AI 에이전트 기술, 통신사 중심 생태계, 그리고 대한민국의 AI 경쟁력 강화가 주요 화두였습니다. -

핵심 키워드:

- AI 에이전트 기술

- K-AI 생태계 글로벌화

- 디지털 신경망

- 정책 및 국가 경쟁력

- 신사업 기회

본 포스트는 Day 1 오후 세션 발표 주제 정리를 목적으로 작성되었습니다.

Day 1 오후 발표 주제 정리

5. AI의 미래

- 발표자: Rani Borkar (Microsoft CVP)

- 내용: Microsoft의 관점에서 본 AI 기술의 미래.

6. AI의 실현: GenAI의 잠재력을 발휘하고 더 건강한 생태계를 구축하기 위한 로드맵

- 발표자: Kai Fu Lee (Sinovation Ventures, Rhymes AI 회장)

- 내용: GenAI의 발전 가능성과 이를 통해 건강한 AI 생태계 구축 방안 제시.

7. AI Infra 구축 시장의 현황과 전망**

- 발표자: Mark Adams (Penguin Solutions CEO)

- 내용: AI 인프라 구축의 현황 및 미래 전망.

8. 오픈 모델과 GPUs As-A-Service로 AI를 제어하라

- 발표자: Stephen Balaban (Lambda CEO)

- 내용: 오픈 모델 및 GPU 서비스 모델을 통한 AI 제어 방안.

9. 패널토의: AI 시대 Infrastructure의 현재와 미래

- 참여자: 유영상 (SK텔레콤 CEO), Mark Adams (Penguin Solutions CEO), Stephen Balaban (Lambda CEO), 오혜연 (KAIST 교수, Moderator)

- 내용: AI 인프라의 발전 현황과 미래 방향에 대한 패널 토의.

10. 첨단 원자력 에너지로 AI 구동하기

- 발표자: Chris Levesque (TerraPower CEO)

- 내용: 원자력 에너지를 통한 AI 구동 및 지속 가능한 에너지 전략.

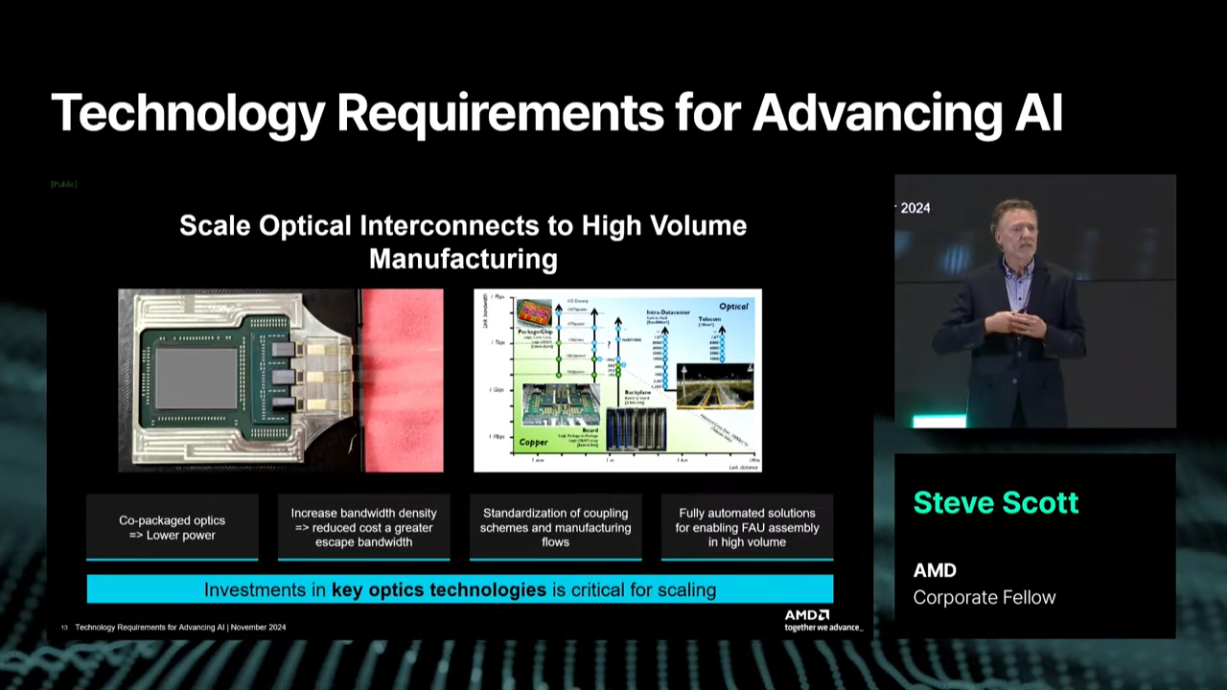

11. AI 발전을 위한 기술적 요구사항

- 발표자: Steve Scott (AMD Corporate Fellow)

- 내용: AI 기술 발전을 위한 반도체와 기타 기술적 요구사항 논의.

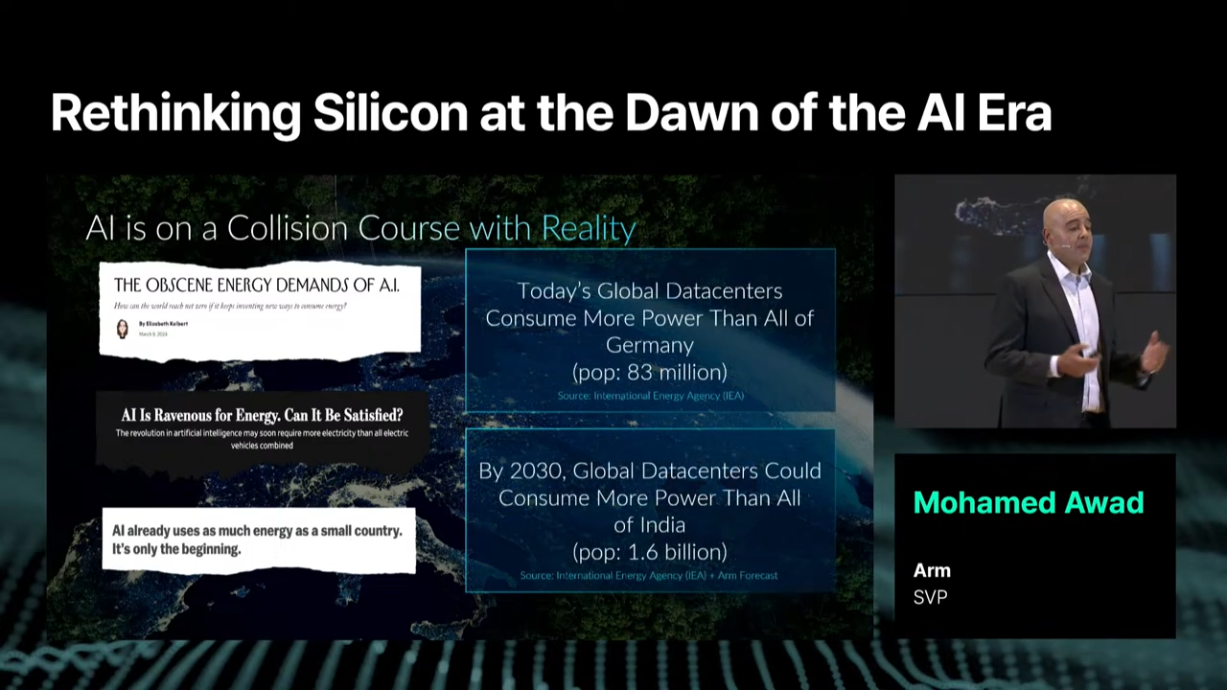

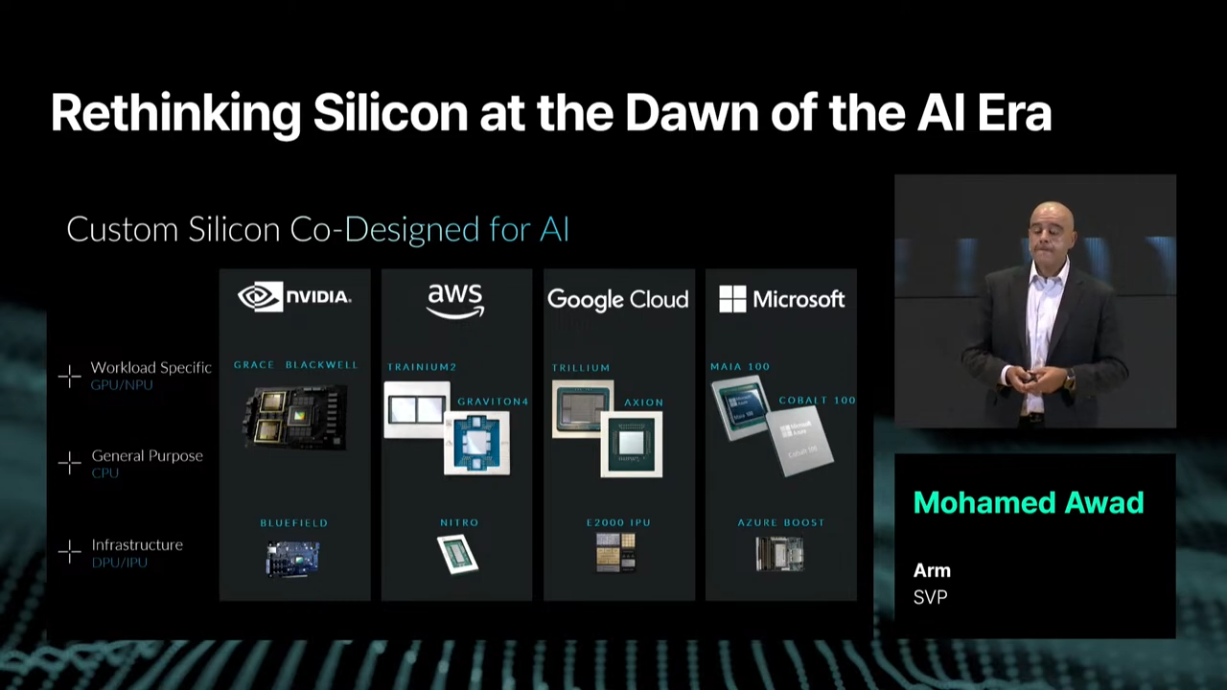

12. Rethinking Silicon at the Dawn of the AI Era

- 발표자: Mohamed Awad (Arm SVP)

- 내용: AI 시대에 맞춰 실리콘 반도체 기술의 재구성 필요성.

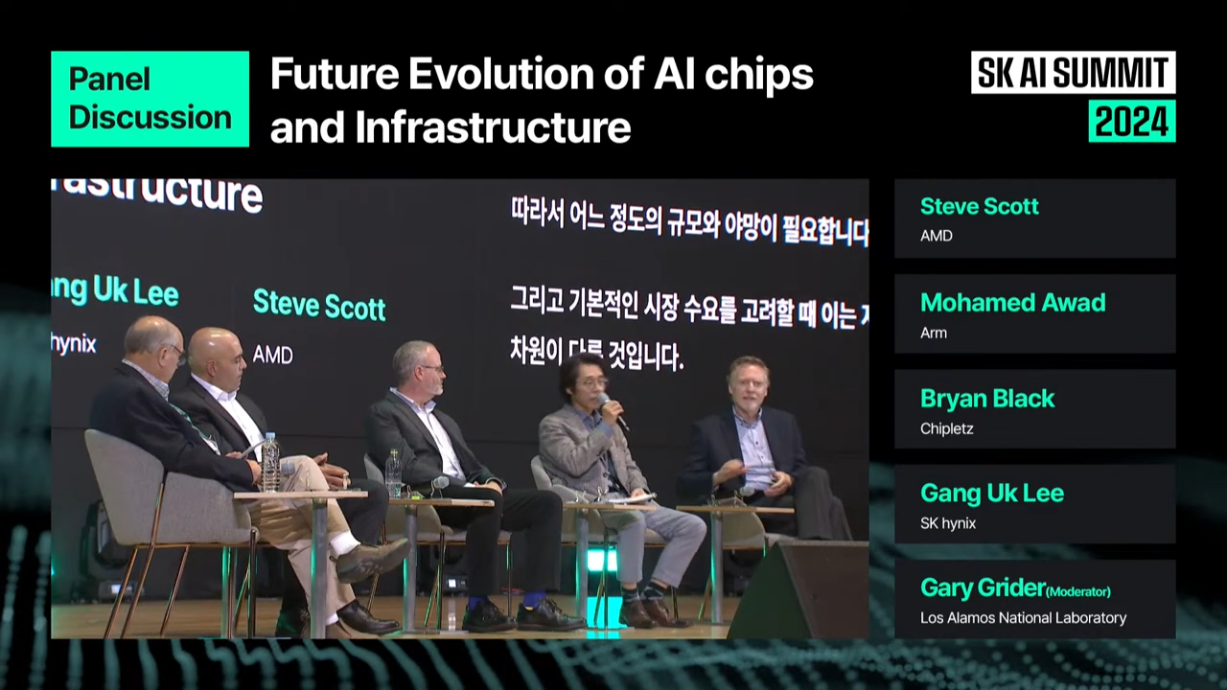

13. 패널토의: AI 반도체와 인프라의 진화

- 참여자: Steve Scott (AMD Corporate Fellow), Mohamed Awad (Arm SVP), Bryan Black (Chipletz CEO & Chairman), 이강욱 (SK하이닉스 부사장), Gary Grider (Los Alamos National Laboratory, HPC Division Leader, Moderator)

- 내용: AI 반도체 기술의 진화와 인프라의 발전 방향.

14. Perplexity의 AI 검색으로 더욱 탐구적이고 효율적인 세상 만들기

- 발표자: Aravind Srinivas (Perplexity 공동창립자, CEO)

- 내용: Perplexity의 AI 검색 기술로 정보 탐구와 효율성을 높이는 방안.

5. AI의 미래

- 발표자: Rani Borkar (Microsoft CVP)

- 내용: Microsoft의 관점에서 본 AI 기술의 미래.

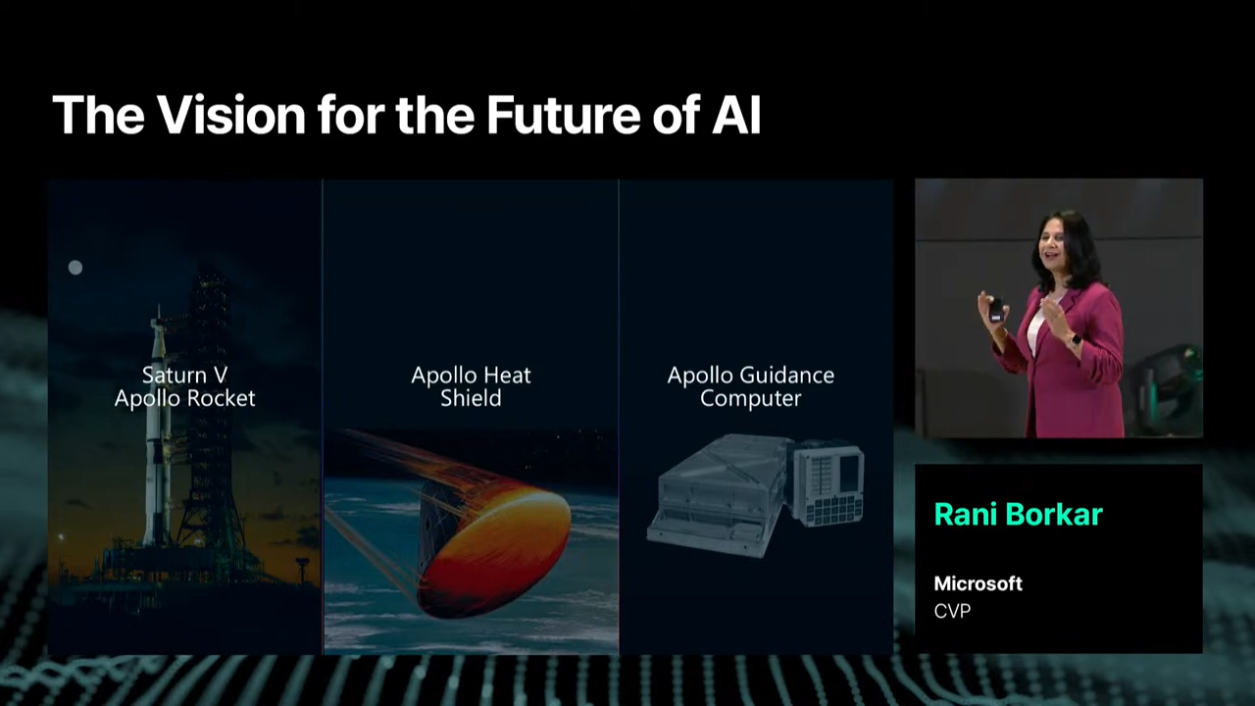

1. 아폴로 프로그램과 Era of AI

-

1962년, 존 F. 케네디 대통령은 "우리는 달에 가기로 선택했다"라는 선언으로 아폴로 프로그램을 시작했습니다. 이 야심찬 프로젝트는 단순히 달에 가는 것을 넘어서 다양한 산업에서 혁신적인 기술 발전을 요구했습니다.

-

로켓 과학, 재료 공학, 컴퓨팅 기술의 전례 없는 도약은 아폴로 프로그램을 가능하게 했습니다. 이 모든 과정은 40만 명의 인력이 협력하고, 대학과 기업이 위험을 감수하며, 불가능에 도전하는 자세를 통해 이루어졌습니다. 그 결과, 아폴로는 단순한 우주 탐사의 성공을 넘어 전 세계에 경제적, 기술적 유산을 남겼습니다.

- 오늘날의 AI 시대는 아폴로 프로그램과 놀라운 유사점을 보입니다. AI 역시 여러 산업의 협력, 대규모 투자, 그리고 인간의 창의적 도전 정신을 요구합니다.

- 아폴로가 새로운 기술의 문을 열었듯이, AI는 인류의 새로운 기술적 경계를 열 것으로 기대됩니다.

- AI 인프라는 이 혁신의 핵심이며, 이를 통해 인류는 또 다른 미지의 영역으로 나아가고 있습니다.

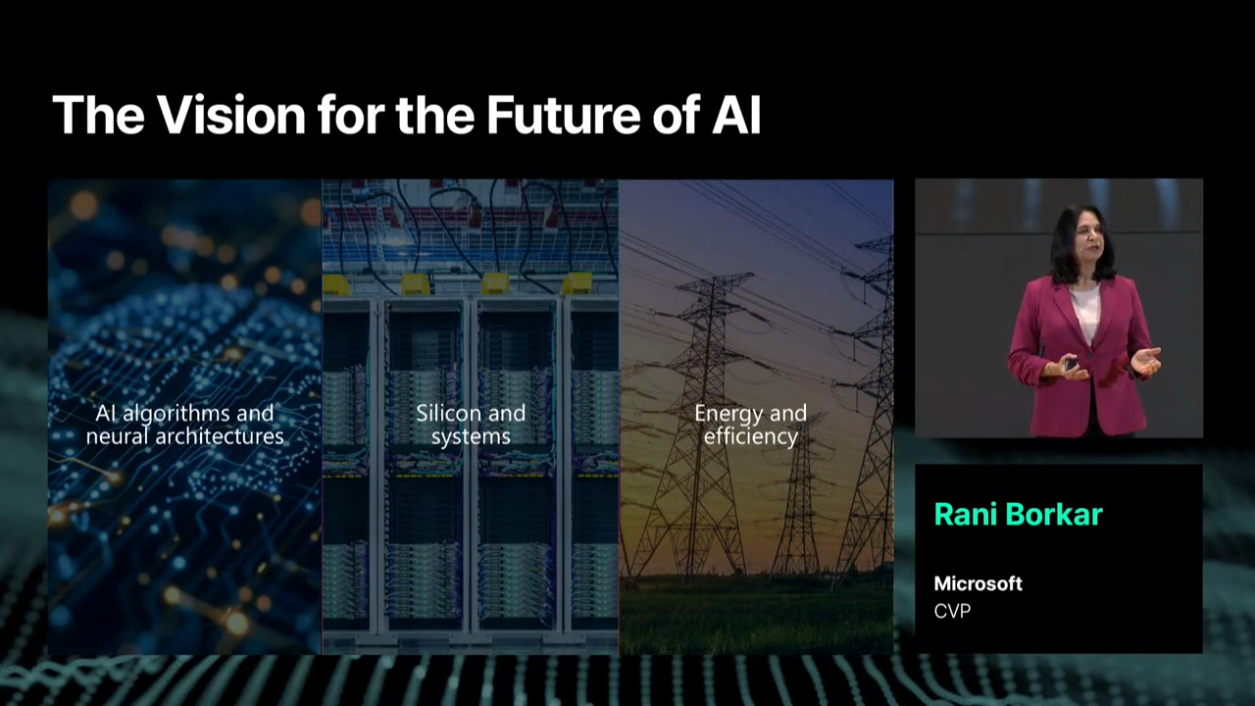

2. AI 인프라 구축을 위한 세 가지 핵심 요구사항

AI 시대는 인류가 새로운 기술적 경계를 탐험하는 중요한 전환점에 서 있습니다. 이는 아폴로 프로그램과 마찬가지로 대규모 투자, 산업 간 협력, 인간의 인내와 창의력이 필요한 시대입니다.

이러한 획기적인 AI 인프라를 제공하기 위해선 단순한 컴퓨팅 성능의 향상을 넘어, AI 모델과 뉴럴 아키텍처를 지원할 수 있는 최첨단 하드웨어, 시스템, 그리고 지속 가능한 설계 방식이 필요합니다.

이러한 혁신을 위해서는 세 가지 필수 조건이 있습니다:

-

속도: 속도는 더 빠르고 효율적인 기술 개발을 통해 AI 혁신을 가속화하는 것을 의미합니다.

-

규모(스케일): 규모는 용량을 확장하며 품질을 유지하고, 미래의 요구를 미리 준비하는 것을 목표로 합니다.

-

지속 가능성: 지속 가능성은 환경적, 에너지적 영향을 최소화하면서 AI 기술을 효율적으로 활용하는 데 초점을 맞춥니다.

2.1. 속도의 중요성

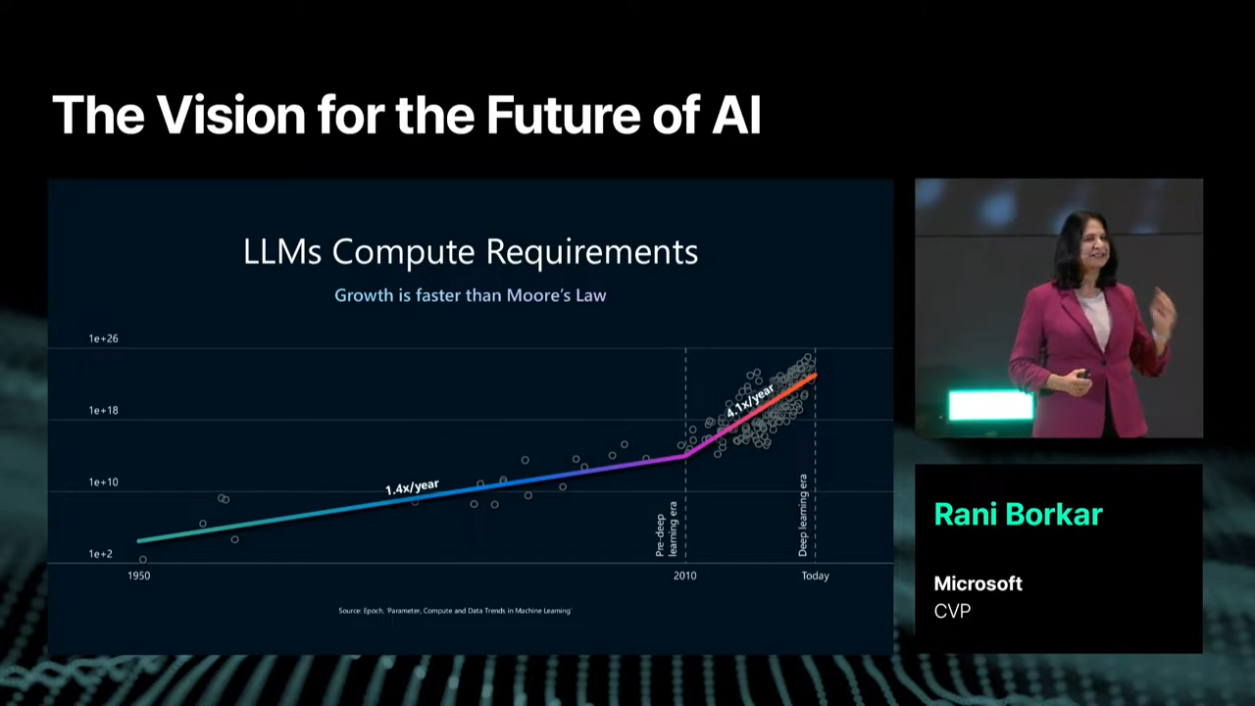

AI의 발전 속도는 놀랍습니다. 6개월마다 AI 모델의 성능이 두 배로 증가하는데, 이는 2년마다 성능이 두 배로 증가한다는 무어의 법칙보다 4배 빠른 속도입니다.

💡 무어의 법칙(Moore’s Law)이란?

무어의 법칙은 1965년 인텔의 공동 창업자인고든 무어(Gordon Moore)가 제시한 개념으로, “집적 회로(Integrated Circuit)에 포함되는 트랜지스터의 수는 약 2년마다 두 배로 증가하며, 이에 따라 컴퓨팅 성능도 두 배로 향상된다”는 법칙입니다.

- 이는 반도체 산업과 컴퓨터 기술 발전을 설명하는 데 널리 사용되며, 현대 기술 발전의 속도를 상징하는 중요한 원칙으로 자리 잡았습니다.

- 쉽게 말하면, 무어의 법칙은 컴퓨터 칩의 성능(즉, 트랜지스터 수)이 일정한 시간 간격(대략 2년마다) 동안 2배로 증가한다고 관찰된 경험에 의한 법칙입니다.

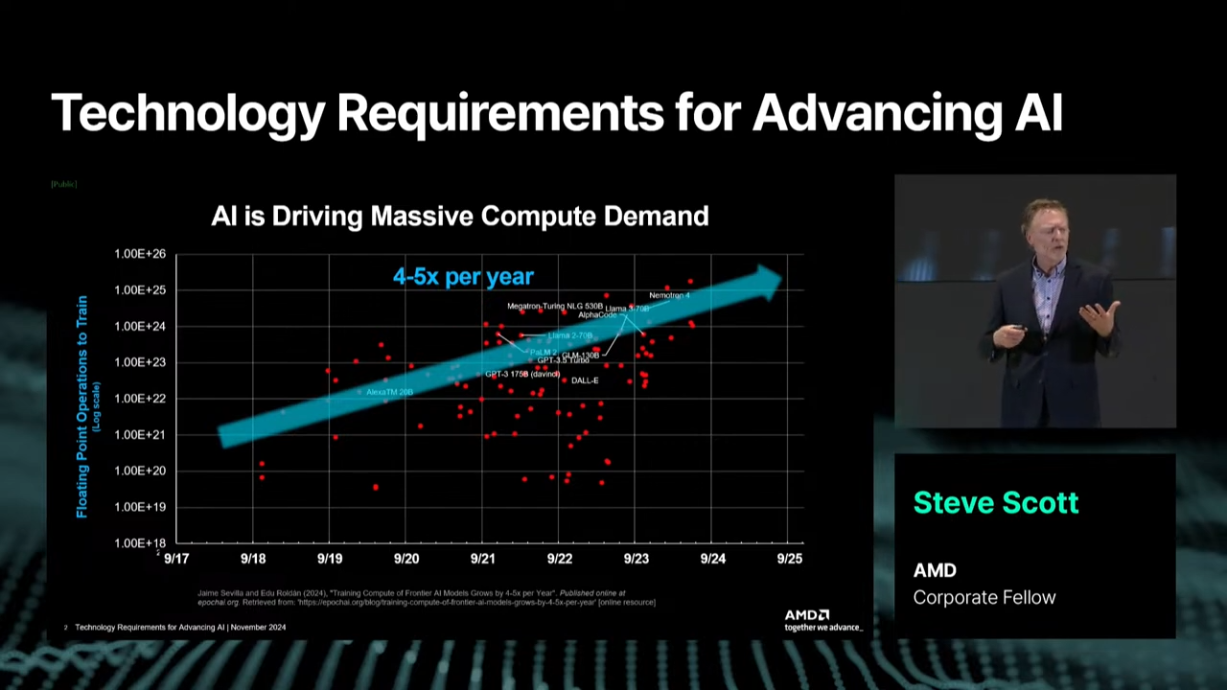

💡 AI와 무어의 법칙의 관계

AI 기술의 발전 속도는 이제 무어의 법칙을 능가하고 있다고 얘기하고 있습니다. 위 그래프에서 알 수 있듯이, AI 모델의 컴퓨팅 요구사항은 딥 러닝 시대(Deep Learning Era)에 들어서면서 연간 약 4배씩 증가하고 있습니다.

- 이는 무어의 법칙(2년마다 두 배)과 비교하면 매우 가파른 성장세입니다.

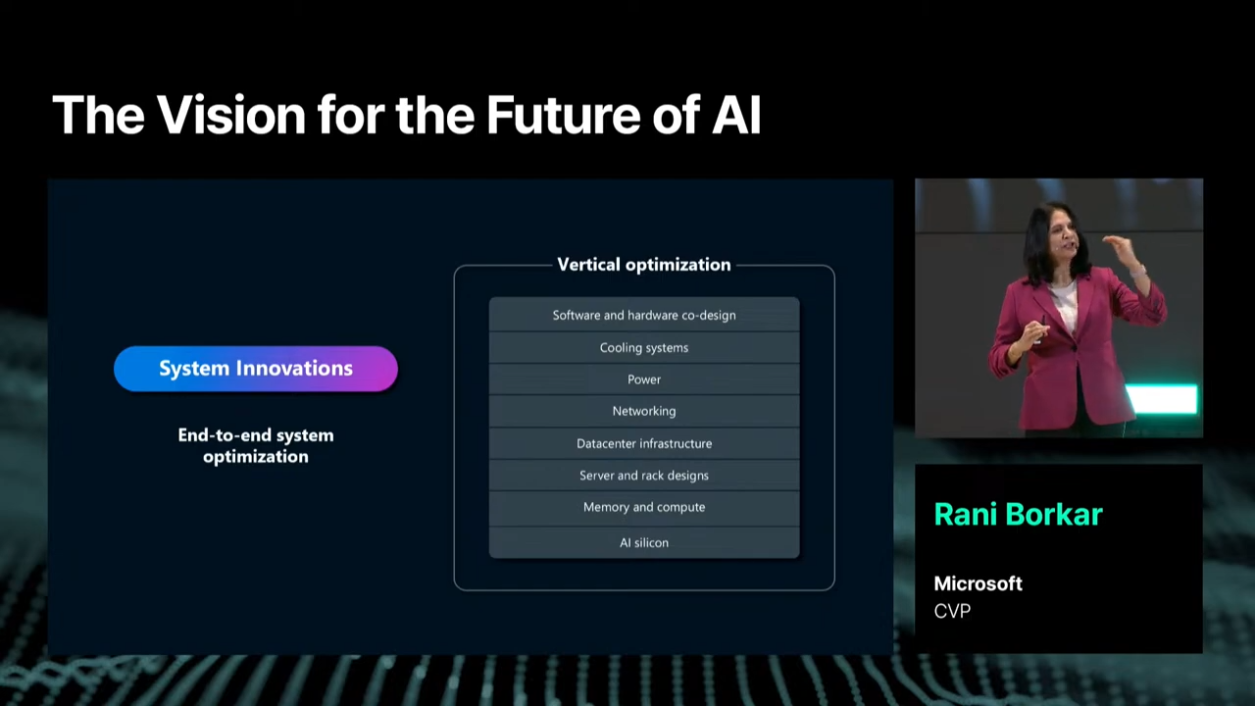

하지만 이런 속도에 하드웨어와 인프라가 따라가지 못하는 현실이 큰 과제로 남아 있습니다. 이를 해결하기 위해서는 모든 레벨에서의 End-to-End 최적화와 지속적인 혁신이 필요합니다.

예를 들어, 메모리 산업에서는 기존에 10~15%의 성능 향상이 일반적이었지만, AI 시대에는 이보다 훨씬 큰 도약이 요구됩니다.

- 그런 의미에서 고대역폭 메모리(HBM)와 같은 차세대 기술이 이런 도약을 가능하게 하는 열쇠입니다.

- 이를 통해 AI 모델의 성능을 극대화하고 고객의 요구에 부합하는 기술적 솔루션을 제공할 수 있습니다.

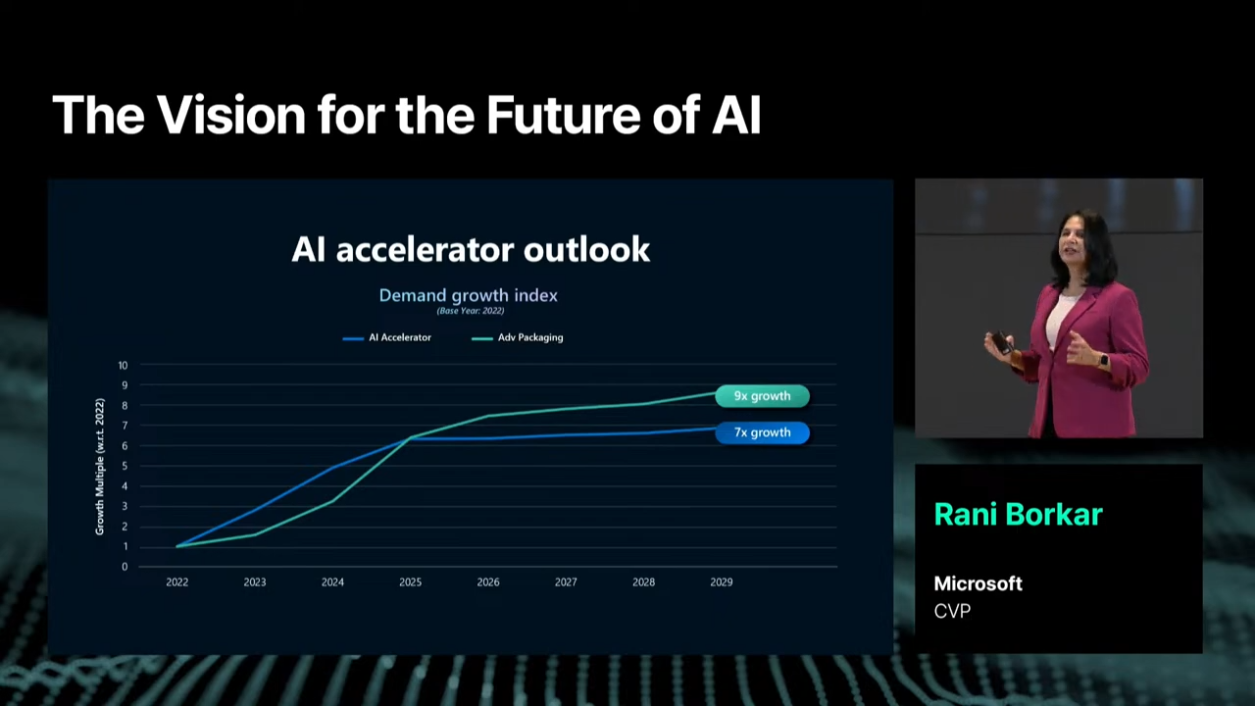

2.2. 규모(스케일)의 중요성

AI가 성공적으로 확장되기 위해서는 미래를 예측하고 이에 대비한 투자가 필수적입니다.

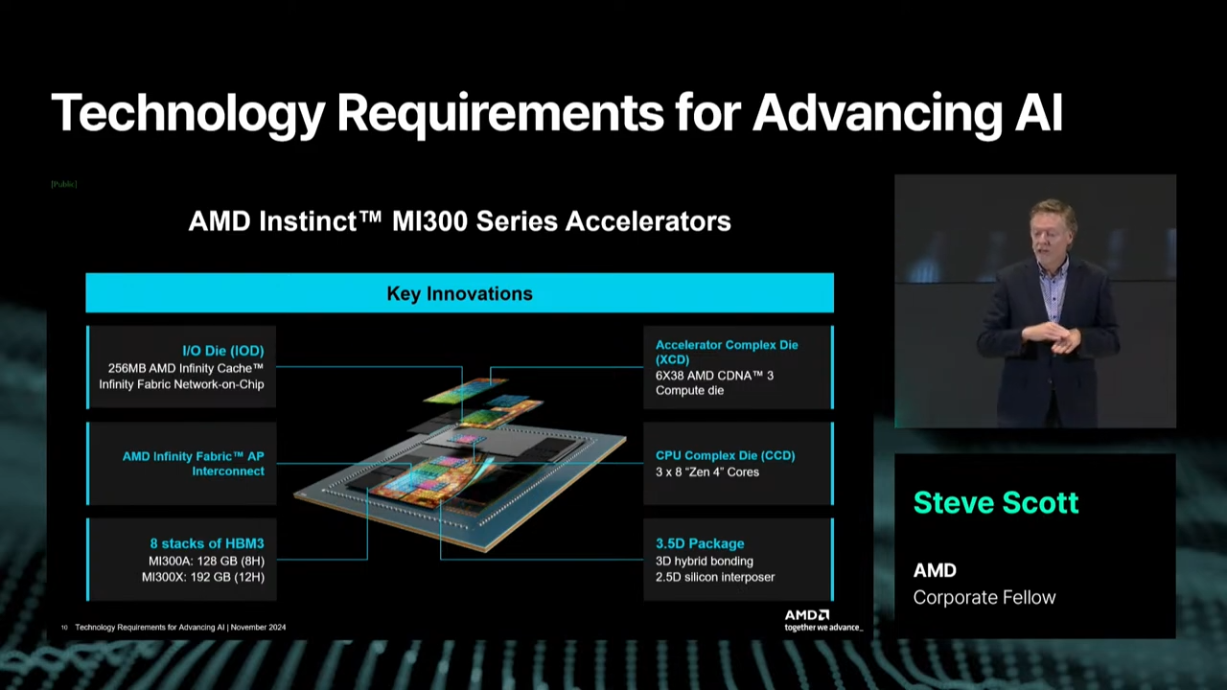

AI 가속기(GPU, TPU, NPU 등)는 모델의 발전과 함께 더 높은 처리 성능, 메모리 용량, 네트워크 효율성을 요구합니다.- 이를 지원하기 위해 첨단 패키징 기술과 새로운 기술적 접근법에 대한 투자가 필요합니다.

SK하이닉스의 경우, 고대역폭 메모리(HBM) 분야에서 품질과 용량을 확장하며 이러한 요구를 충족시키고 있습니다.

- 이러한 확장은 단순히 생산량을 늘리는 것이 아니라 품질을 유지하며 빠른 성장 곡선을 따라가는 것을 목표로 합니다.

- AI 컴퓨팅의 확장은 데이터 센터 내 다양한 요소들이 동기화되고, 한계를 넘어서도록 설계되어야 한다는 점을 강조합니다.

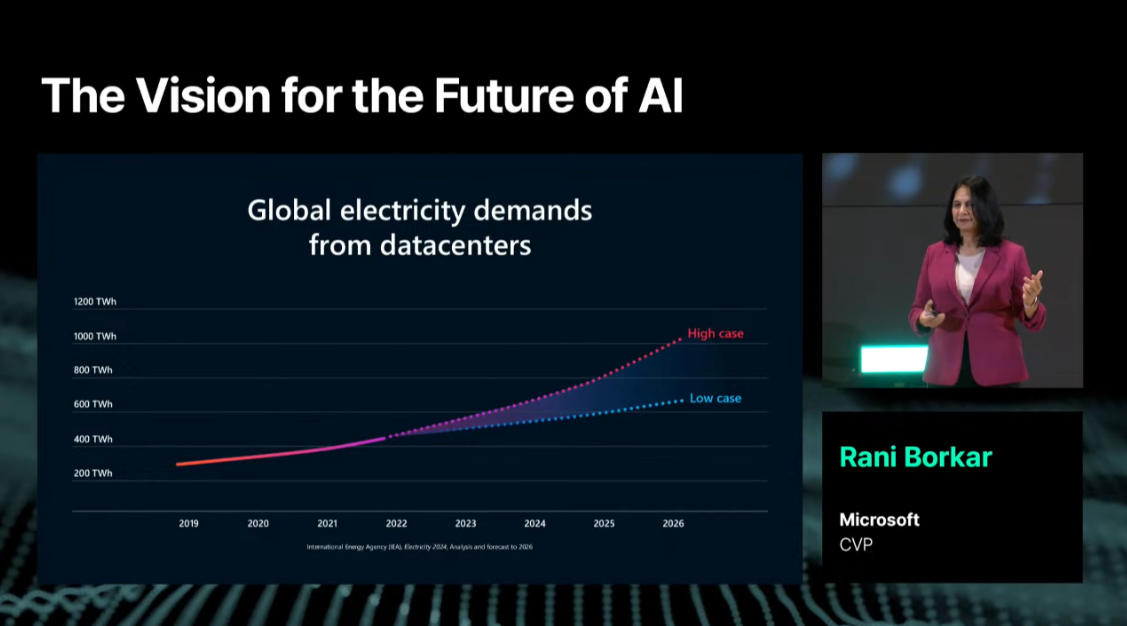

2.3. 지속 가능성의 중요성

AI 시대의 또 다른 핵심 요구사항은 지속 가능성입니다. 글로벌 데이터 센터의 전력 수요는 2022년에서 2026년 사이 두 배 이상 증가할 것으로 예상됩니다. 이는 대부분 AI로 인한 에너지 소비 증가에 기인합니다.

- 이러한 상황 속에서 마이크로소프트는 2030년까지 탄소 네거티브 기업이 되겠다는 목표를 세웠습니다.

- 이를 달성하기 위해 에너지 효율성을 고려한 제품 설계와 혁신적인 냉각 기술(ex. 액체냉각시스템)을 도입하고 있습니다.

3. 미래 전망

AI 시대는 새로운 기회와 도전을 제공합니다. 이는 아폴로 시대가 새로운 기술적 경계를 열었던 것과 유사합니다.

- 속도, 규모, 지속 가능성이라는 세 가지 핵심 요소를 극복한다면 AI는 의료, 교육, 산업 자동화 등 다양한 분야에서 혁신적인 변화를 이끌 것입니다.

- AI의 발전은 단순히 기술의 문제가 아니라 인간의 창의력과 협력의 힘을 필요로 합니다.

- 다양한 산업의 협력과 인간의 도전 정신은 AI가 새로운 탐험을 가능하게 하는 원동력이 될 것입니다.

- 우리가 이 여정을 어떻게 준비하고 실행하느냐에 따라, AI는 인류의 새로운 도약을 이끄는 촉매제가 될 것입니다.

(후기) 가볍게 듣기 좋은 AI의 미래에 대한 이야기와, 현 시점의 중요성을 아폴로 달 탐사에 비유하여

속도,규모,지속 가능성이라는 키워드의 발전이 필요하다고 잘 서술한 것 같습니다. 😎

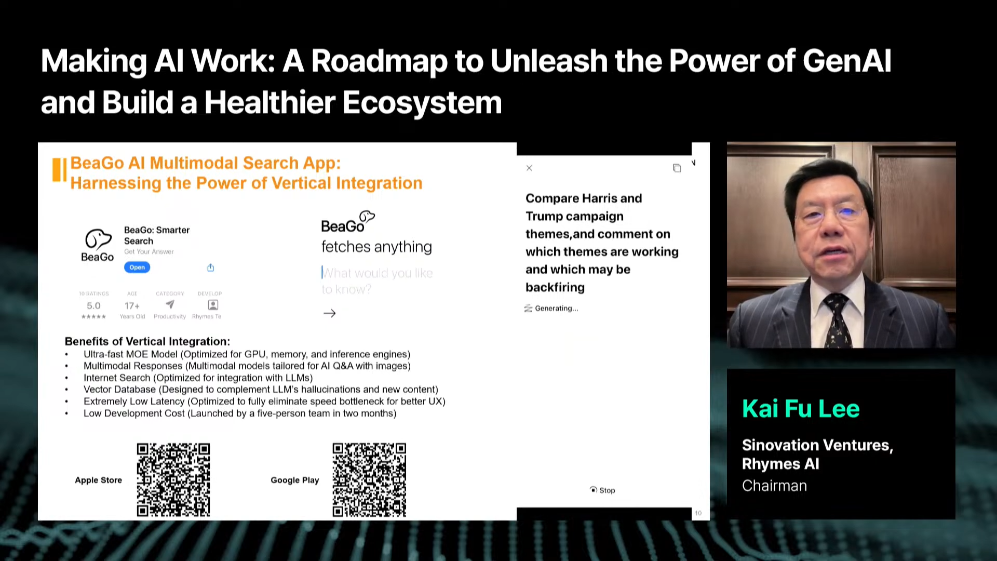

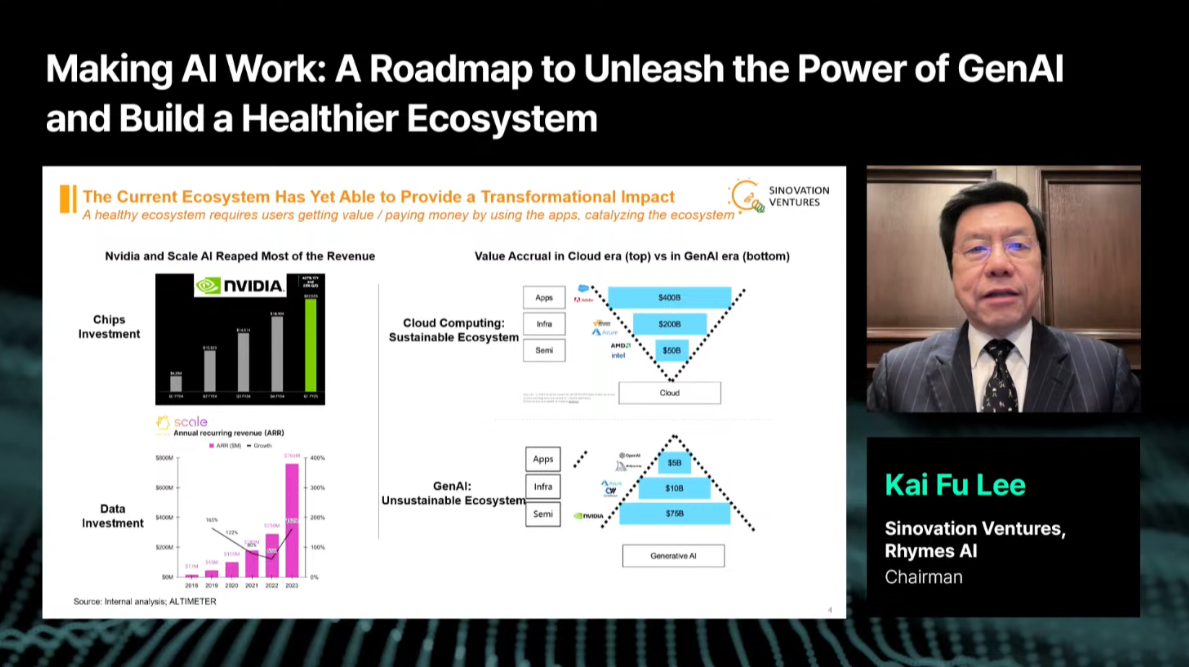

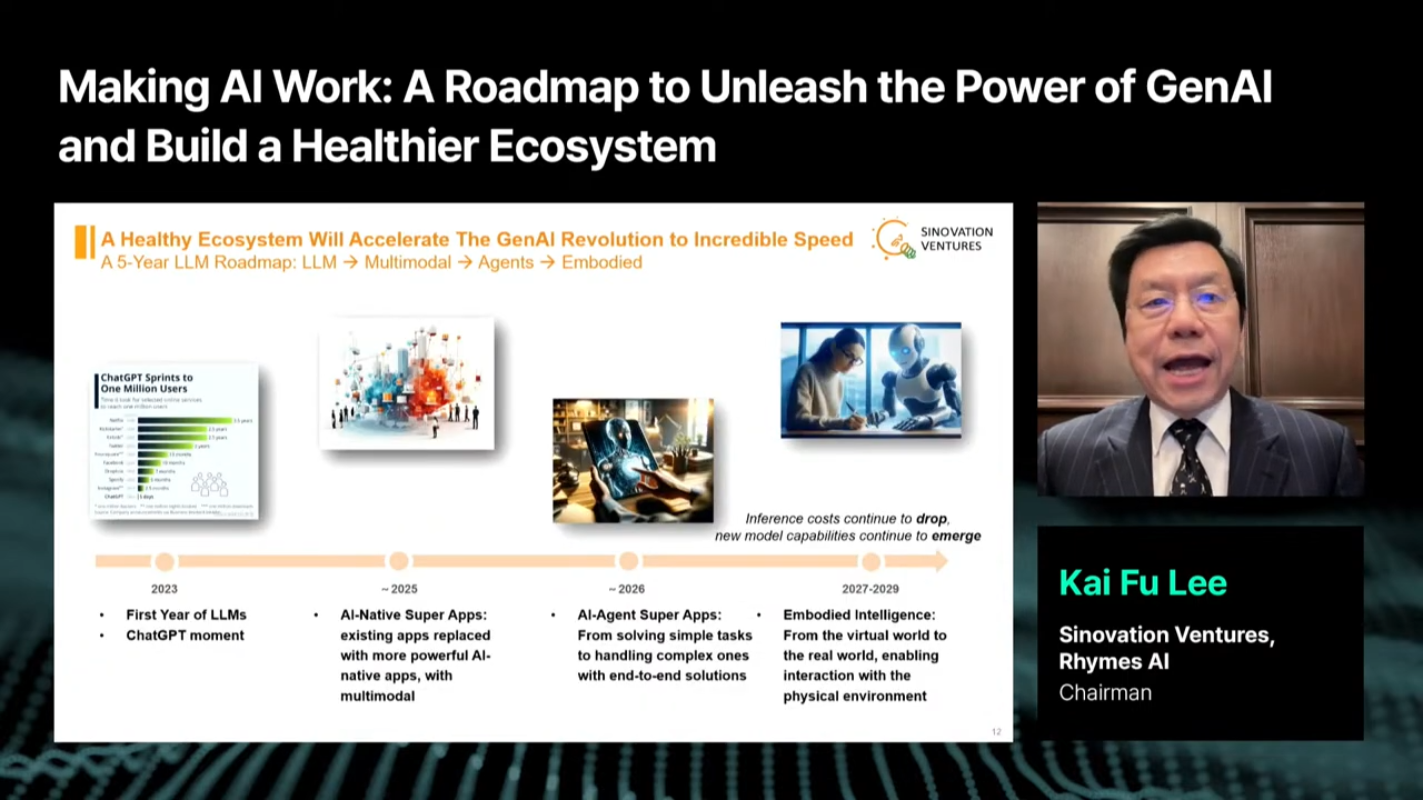

6. AI의 실현: GenAI의 잠재력을 발휘하고 더 건강한 생태계를 구축하기 위한 로드맵

- 발표자: Kai Fu Lee (Sinovation Ventures, Rhymes AI 회장)

- 영어 제목: Making AI Work: A Roadmap to Unleash GenAI and Build a Healthier Ecosystem

- 내용: GenAI의 발전 가능성과 이를 통해 건강한 AI 생태계 구축 방안 제시.

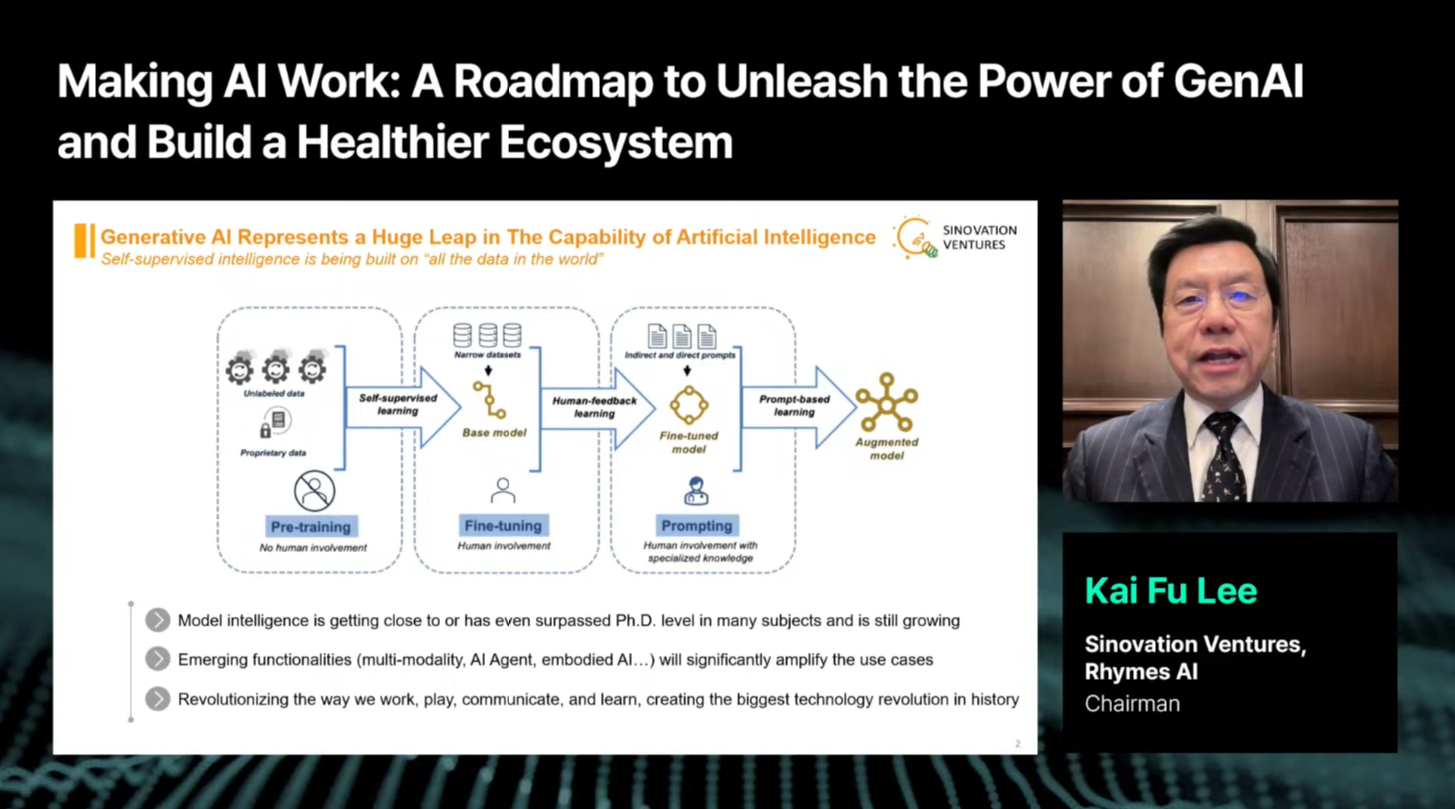

1. 생성형 AI: 새로운 혁명의 중심

생성형 AI는 "기계의 뇌"라 불릴 정도로 빠르게 발전하고 있습니다.

- 단순한 텍스트 생성에서 멀티모달 모델(예: 텍스트, 이미지, 비디오를 동시에 처리하는 모델)로 확장 중.

- 앞으로 2~5년 안에 완전히 새로운 세상을 만들어낼 잠재력을 가지고 있음.

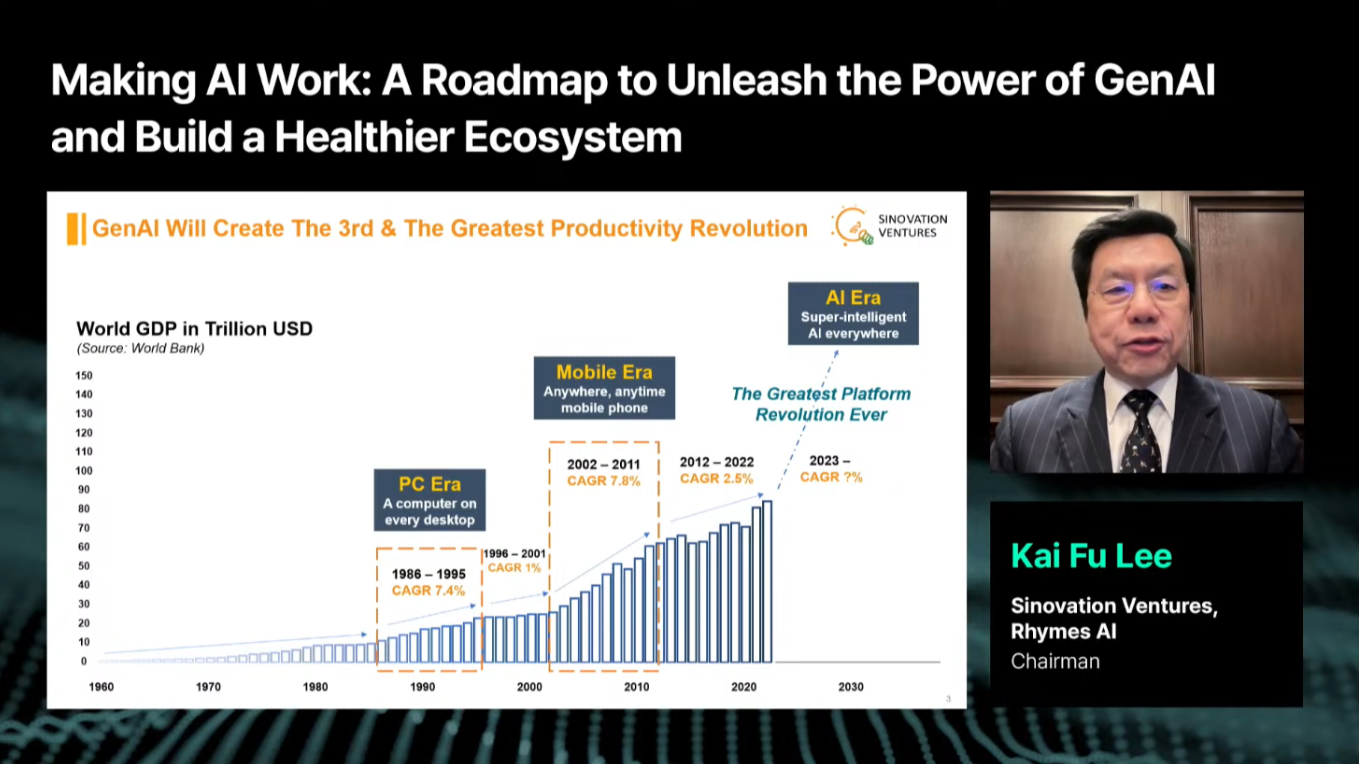

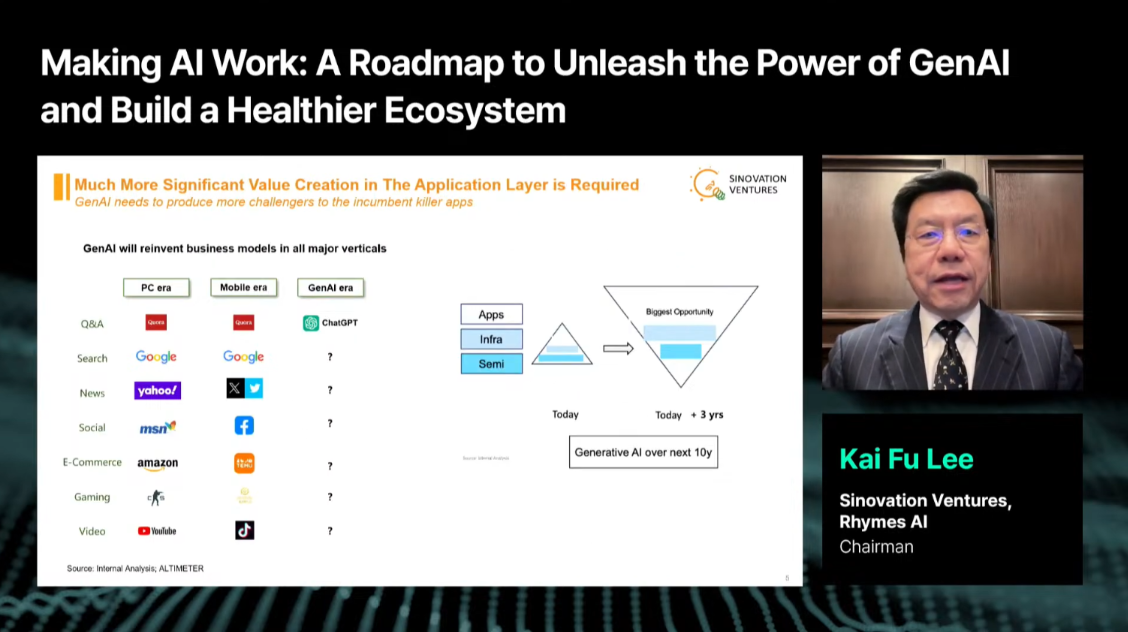

Kai Fu Lee(이하 카플리) 회장은 생성형 AI가 기존 PC 및 모바일 혁명과 유사하게 세계 경제에 기하급수적인 영향을 미칠 것이라고 강조했습니다.

- 예전에 PC와 모바일 혁명이 각각 생산성과 연결성을 증대시킴.

- AI는 초지능(Super Intelligence)을 모든 앱과 플랫폼에 통합하여 지금까지 상상하지 못했던 가능성을 열어줄 것임.

2. AI 생태계의 과제와 기회

AI의 발전을 위해서는 생태계 전반에 걸친 발전이 중요합니다.

- 현재의 AI 생태계는 반도체, 플랫폼, 애플리케이션 계층으로 나뉘어 있지만, 카플리 회장은 애플리케이션(앱)이 가장 중요한 역할을 해야 한다고 역설했습니다.

- 애플리케이션(앱)이는 사용자와 직접 연결되며, 실제로 가치를 창출하는 부분이기 때문입니다.

예를 들어, 과거 PC에서 모바일 시대로 넘어갈때, TikTok, Uber 같은 앱들이 등장하면서 이전에는 불가능했던 사용자 경험을 가능하게 만들었습니다.

- 카플리 회장은 AI에서도 동일한 흐름이 이어질 것이라고 이야기했습니다.

- AI 기반 앱이 멀티모달 소셜 플랫폼, 로컬 이커머스, 생산성 앱 등 다양한 분야에서 혁신을 이끌 것이라는 전망이라고 봤습니다.

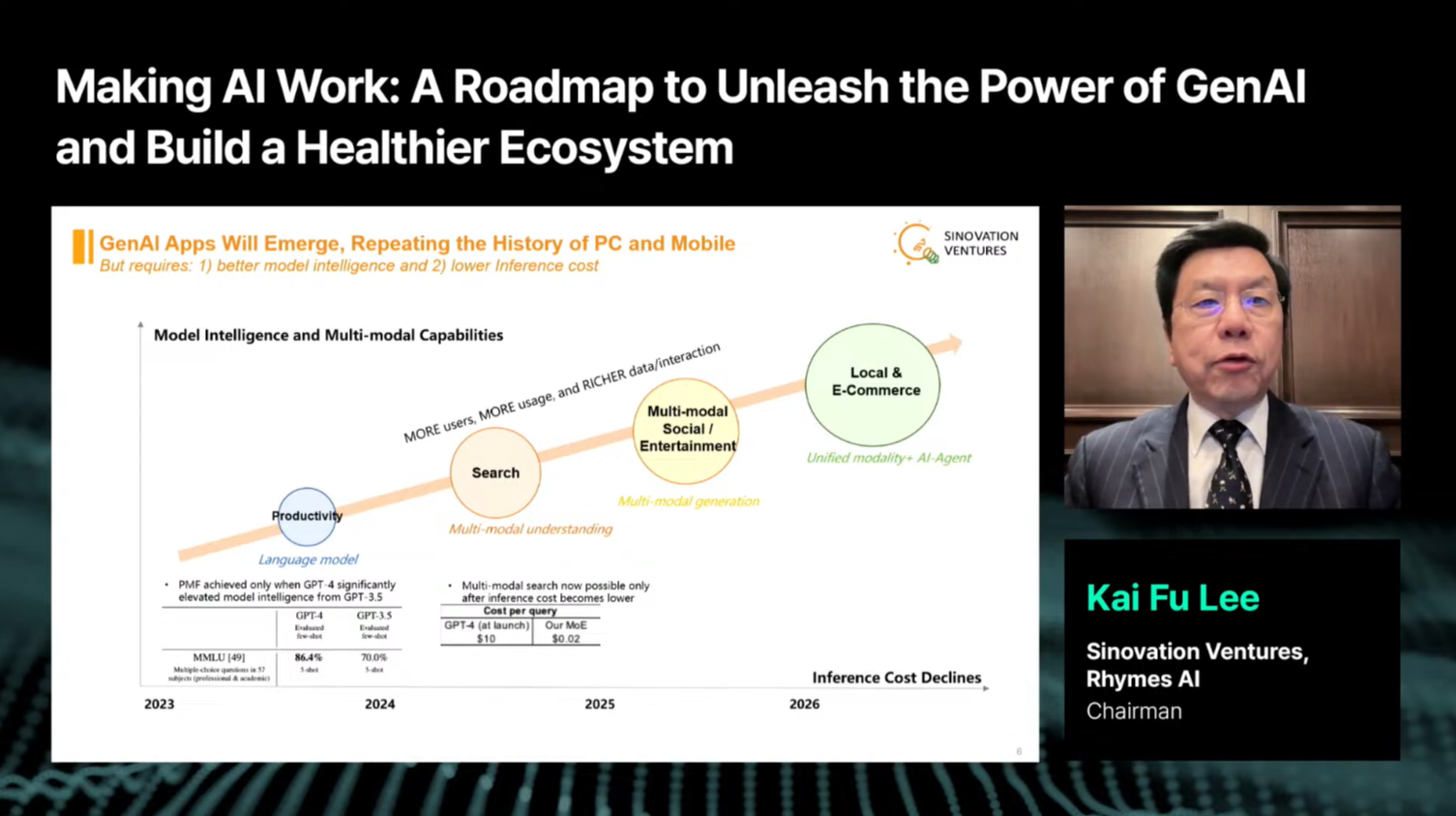

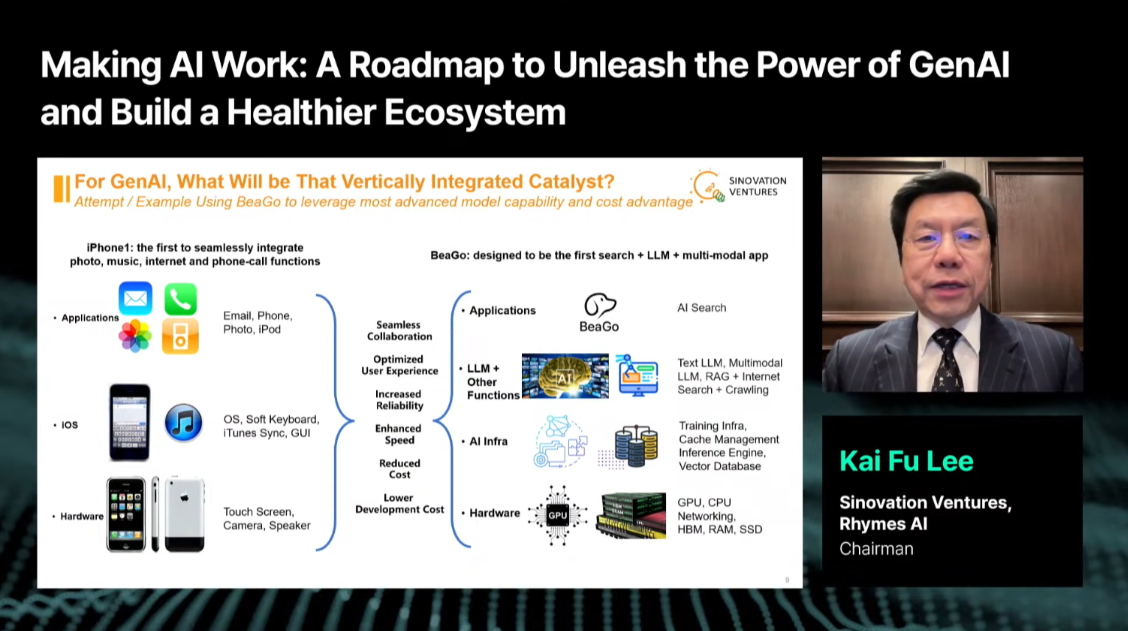

3. AI 네이티브 앱의 부상

AI 네이티브 앱이란 AI 기술을 핵심으로 하여 설계된 애플리케이션입니다. 그러면서 하나의 사례로 Rhymes Technology 사에서 개발하는 BeaGo를 소개합니다.

🦮 BeaGo

BeaGo는 AI 기반의 스마트 검색 애플리케이션입니다. 이 앱은 AI 네이티브 앱으로, 고급 인공지능 기술을 활용하여 사용자의 검색 경험을 향상시키는 데 중점을 두고 있습니다.

카플리는 회장은, 이를 우버와 같은 모바일 네이티브 앱에 비유하며, AI 네이티브 앱의 주요 특징을 아래와 같이 정의했습니다.

-

AI가 없으면 앱이 작동하지 않는다: AI는 이 앱의 필수 구성 요소로, AI 없이 서비스가 불가능한 구조를 가집니다.

-

자연어 인터페이스: 음성이나 텍스트로 사용자와 소통하며, 사용자 경험을 크게 향상시킵니다.

-

AI 중심의 자동화: 사용자의 요구를 예측하고 해결책을 제공하며, 클릭이나 추가 입력 없이도 작업을 수행합니다.

이러한 AI 네이티브 앱이 사용자의 생산성을 극대화하고, 기존의 앱 사용 방식을 혁신할 것이라고 설명했습니다.

4. AI 혁명의 다음 단계

카플리 회장은 이 AI 네이티브 앱이 AI 에이전트와 같은 더 진보된 형태로 발전할 것을 기대한다고 말했습니다.

- AI 에이전트는 사용자 일상에 깊숙이 침투하여 개인화된 작업을 자동으로 처리하고, 더 나아가 물리적 세계와도 상호작용하는 단계로 나아갈 것입니다.

- 예를 들어, AI 에이전트는 사용자가 일일이 선택하지 않아도 쇼핑 목록을 분석하고 필요한 물품을 자동으로 구매해 시간을 절약할 것입니다.

- 또한, 자율주행 자동차와 같은 인바디 로봇은 물리적 데이터를 수집하고 이를 바탕으로 우리의 삶을 개선할 혁신적인 도구로 자리 잡을 것입니다.

🤷♂️ AI 네이티브 앱과 AI 에이전트 무슨 차이일까?

AI 네이티브 앱: AI 네이티브 앱은 AI를 핵심 기반 기술로 삼아 설계된 앱입니다. 이 앱은 AI 없이는 작동할 수 없는 구조를 가지며, 사용자와의 상호작용, 데이터 처리, 결과 제공 등이 모두 AI 기술에 의존합니다.

AI 에이전트: AI 에이전트는 사용자의 목표 달성을 위해 스스로 문제를 정의하고 해결하는 독립적인 실행체입니다. 단순히 사용자 명령에 반응하는 수준을 넘어, 능동적으로 작업을 수행하고, 사용자의 개입 없이 복잡한 문제를 해결할 수 있습니다.

AI 네이티브 앱과 AI 에이전트 정리

| 특성 | AI 네이티브 앱 | AI 에이전트 |

|---|---|---|

| 목적 | 특정 기능 제공 (예: 텍스트 생성, 이미지 편집) | 사용자 목표 달성 (예: 자동화된 문제 해결) |

| 작동 방식 | 사용자가 명령 → AI가 결과 제공 | 사용자의 목적을 이해 → 문제를 스스로 정의하고 해결 |

| 자동화 수준 | 제한적 자동화 (특정 작업에 국한됨) | 완전 자동화 (복잡한 작업도 스스로 처리) |

| 자율성 | 낮음 (사용자 명령이 필요) | 높음 (사용자 명령 없이도 작업 수행) |

| 예시 | ChatGPT, Copilot, AI 기반 사진 편집 앱 | 자율주행 시스템, AI 개인 비서, 자동화 에이전트 |

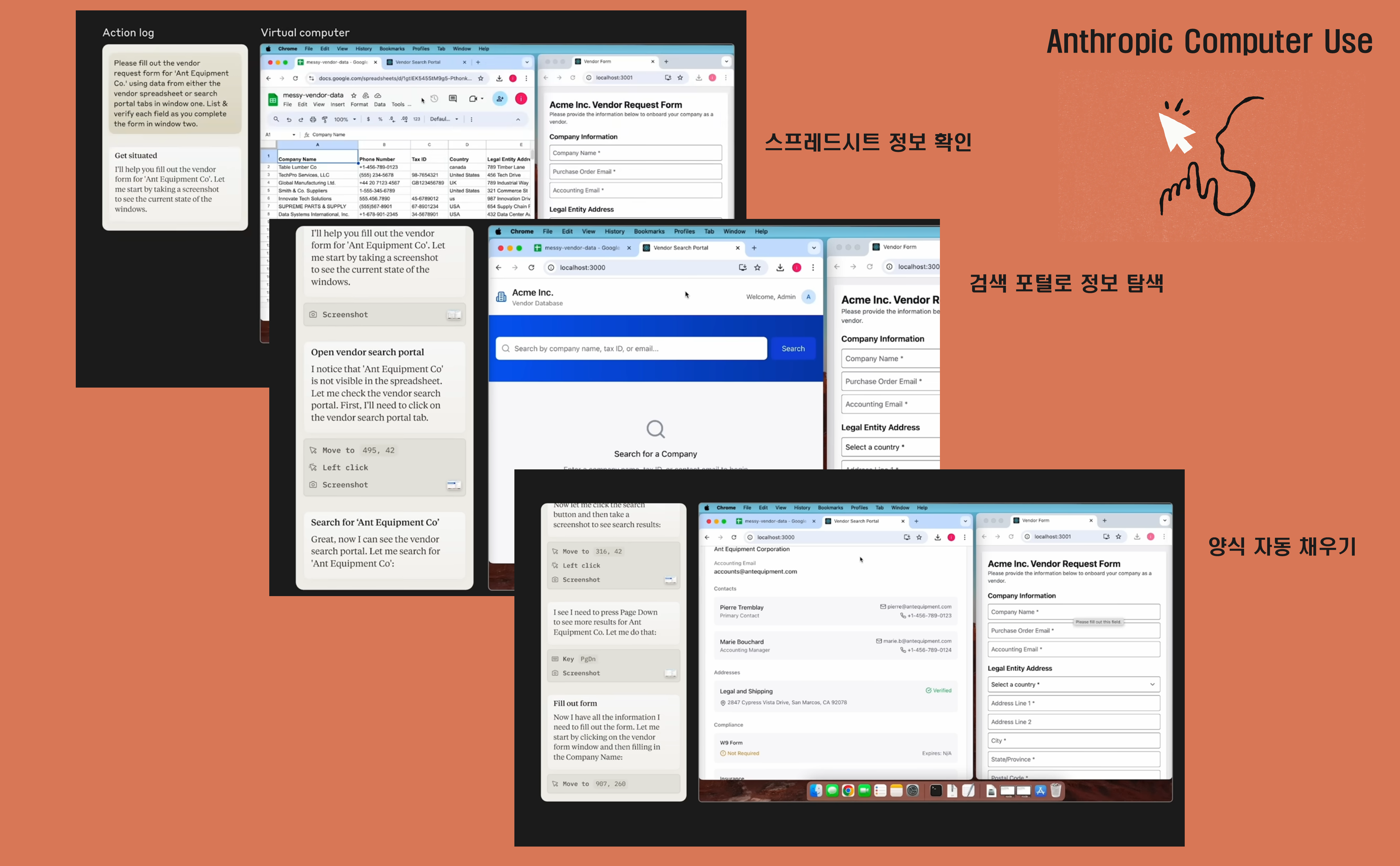

(개인 의견) 벌써 AI Agent를 도입하려는 시도는 다양하게 이루어지고 있다고 생각합니다. 아직 완전한 상용화 단계는 아니지만, 주목할 만한 시도들은 이루어지고 있습니다. 대표적으로 Antropic 사의 Computer use를 예로 들 수 있겠습니다.

👀 Anthropic의 Computer use

- Anthropic은 최근 Claude 3.5 Sonnet 모델을 통해 AI가 컴퓨터를 직접 제어할 수 있는 기능을 선보였습니다. 주요 특징은 다음과 같습니다:

- 일반적인 컴퓨터 사용 능력: 키보드 입력, 마우스 클릭 등을 통해 다양한 애플리케이션을 사용할 수 있습니다.

- 웹 브라우징: 인터넷 검색, 웹사이트 탐색 등이 가능합니다.

- 프로그래밍 지원: Visual Studio Code 등의 개발 환경을 사용하여 코딩 작업을 수행할 수 있습니다.

- 일정 관리: 캘린더 앱을 통해 일정을 추가하고 관리할 수 있습니다.

- 아래 그림은 Demo 이미지를 캡쳐해서 정리한 그림입니다. 다음 그림에서

Action log창에서 요청사항을 컴퓨터(AI)가 주어진 작업을 수행(클릭, 조회, 검색 등)하는 것을 확인할 수 있습니다.

Source: Claude | Computer use for automating operations

5. 앞으로의 AI 발전 시점

카플리 CEO는 AI 기술 발전의 주요 시점을 다음과 같이 제시했습니다.

- 2023년: LLM의 원년 - ChatGPT와 같은 대규모 언어 모델(LLM)이 본격적으로 상용화되었습니다.

- 2025년: AI 네이티브 앱의 시대 - 기존 앱이 AI와 멀티모달 기능을 통합하여 더욱 강력한 사용성을 제공할 것입니다.

- 2026년: AI 에이전트의 부상 - 사용자를 깊이 이해하고, 복잡한 작업까지 처리하는 AI 에이전트가 보편화될 것입니다.

- 2027년: 인바디 로봇의 확산 - 로봇과 AI 기술이 결합하여 물리적 세계에서 실질적인 작업을 수행할 것입니다.

이 모든 과정은 AI가 단순한 도구에서 벗어나, 우리의 삶을 총체적으로 개선하는 중심 기술로 자리잡는 전환점이 될 것입니다.

(후기) 연구적인 측면 뿐만 아니라, 어플리케이션, 즉 실제 산업에서 어떻게 쓰일지, 그리고 유저에게 어떻게 접근해야하는지가 중요해지는 시대가 오는 거 같습니다 😎

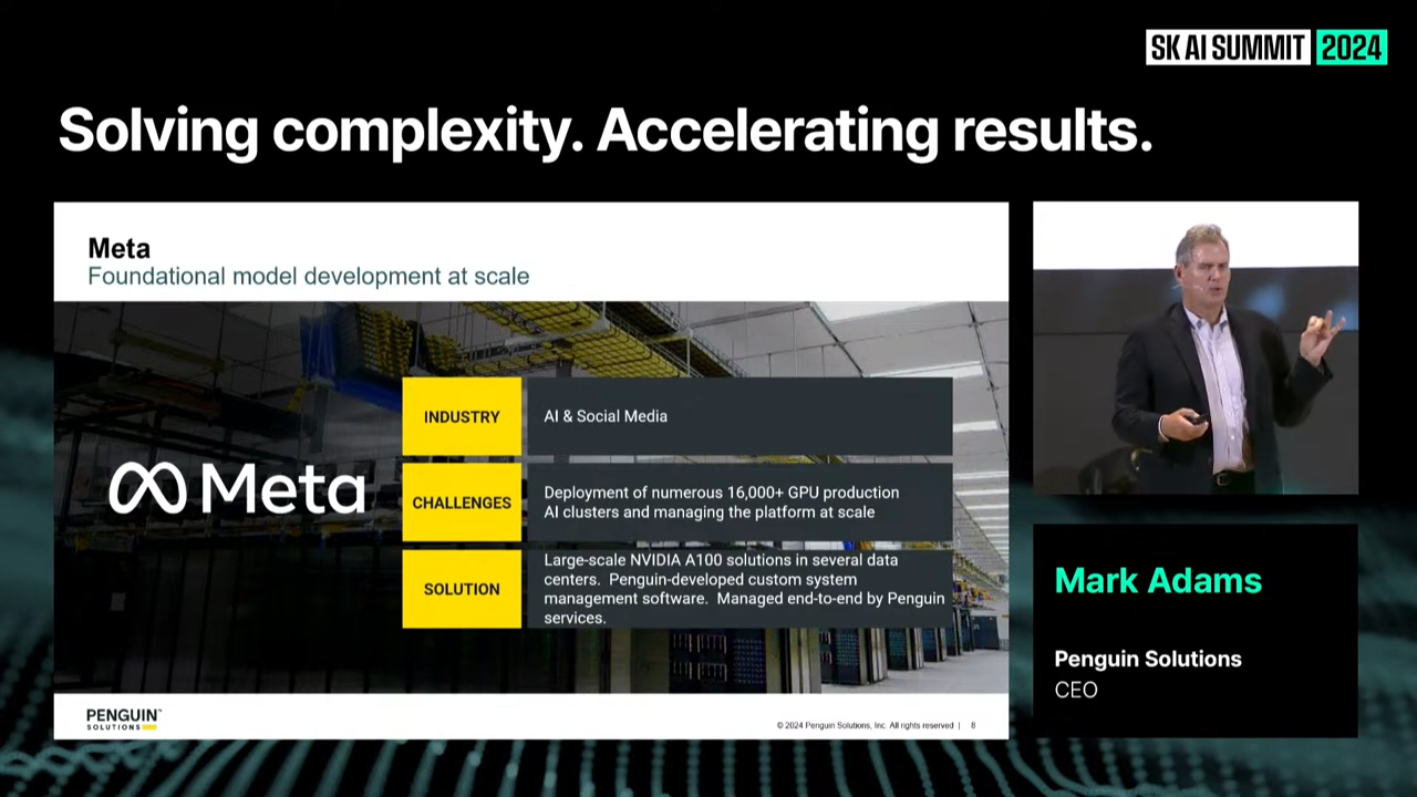

7. AI Infra 구축 시장의 현황과 전망

- 발표자: Mark Adams (Penguin Solutions CEO)

- 영어 제목: AI Infra Market: Current Status and Outlook

- 내용: AI 인프라 구축의 현황 및 미래 전망.

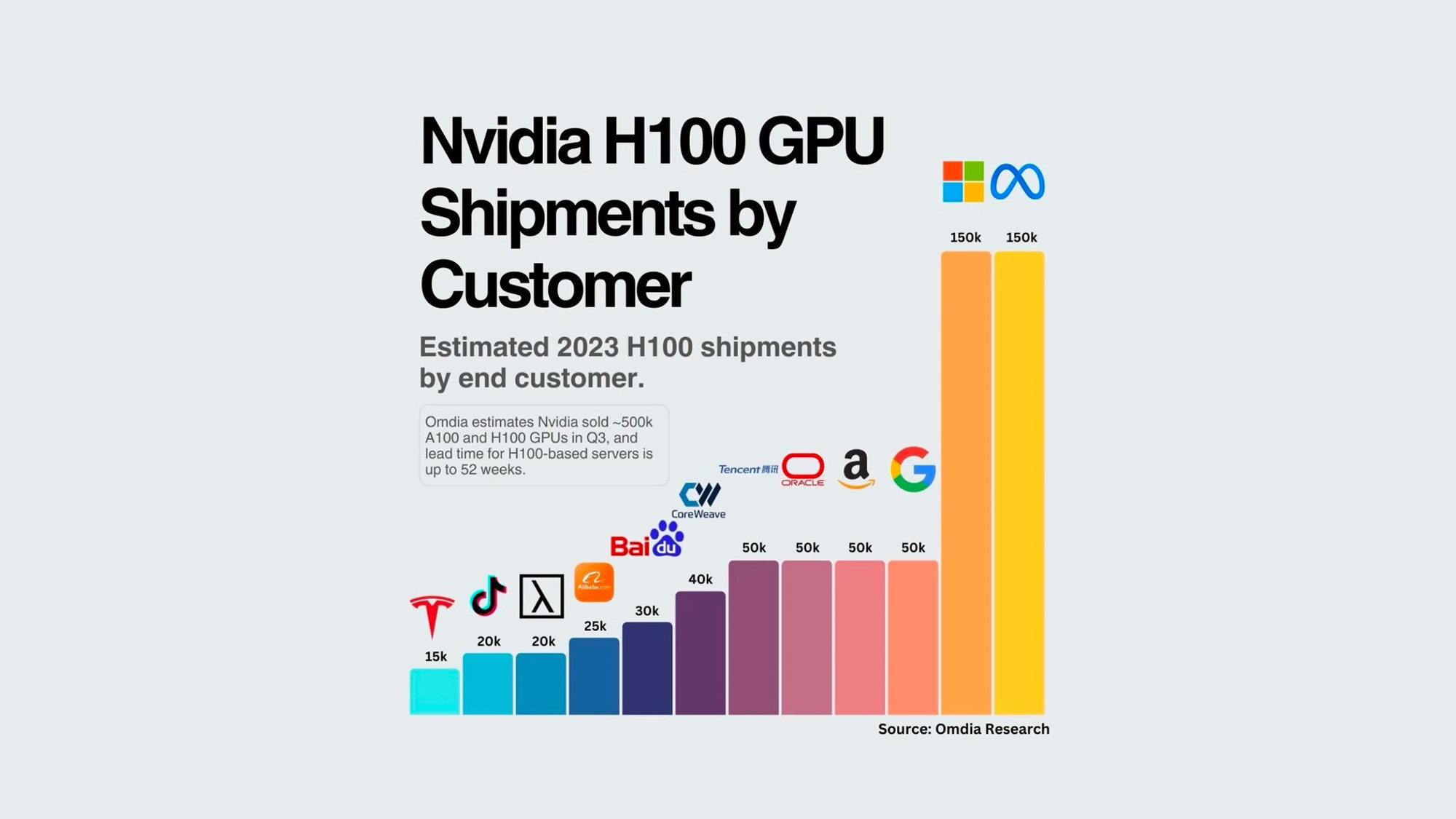

1. 2023년, GPU 부족의 시대

2023년은 “GPU 세일의 시대”라고 불릴 정도로 GPU에 대한 수요가 폭발적으로 증가했습니다. 아마존, 구글, 메타, 마이크로소프트 같은 하이퍼스케일 기업들은 엄청난 규모로 GPU를 필요로 했지만, 공급 부족으로 인해 원하는 만큼 확보하기 어려운 상황이었습니다. 이러한 제약은 GPU뿐만 아니라 AI를 위한 전체 데이터센터 인프라에도 영향을 미쳤습니다.

출처 : 2023 엔비디아(NVIDIA)의 최우수 고객은 누구일까

이러한 상황에서 중소형 기업이나 클라우드 서비스 프로바이더들도 AI에 발을 들이고 싶어 했지만, 여전히 막대한 비용과 복잡한 요구 사항이 걸림돌로 작용했습니다. GPU 배치와 데이터센터 구축이 AI 트레이닝을 위한 필수 조건이 되면서 기업들은 AI 도입의 실질적인 ROI(Return on Investment)를 고민하기 시작했습니다.

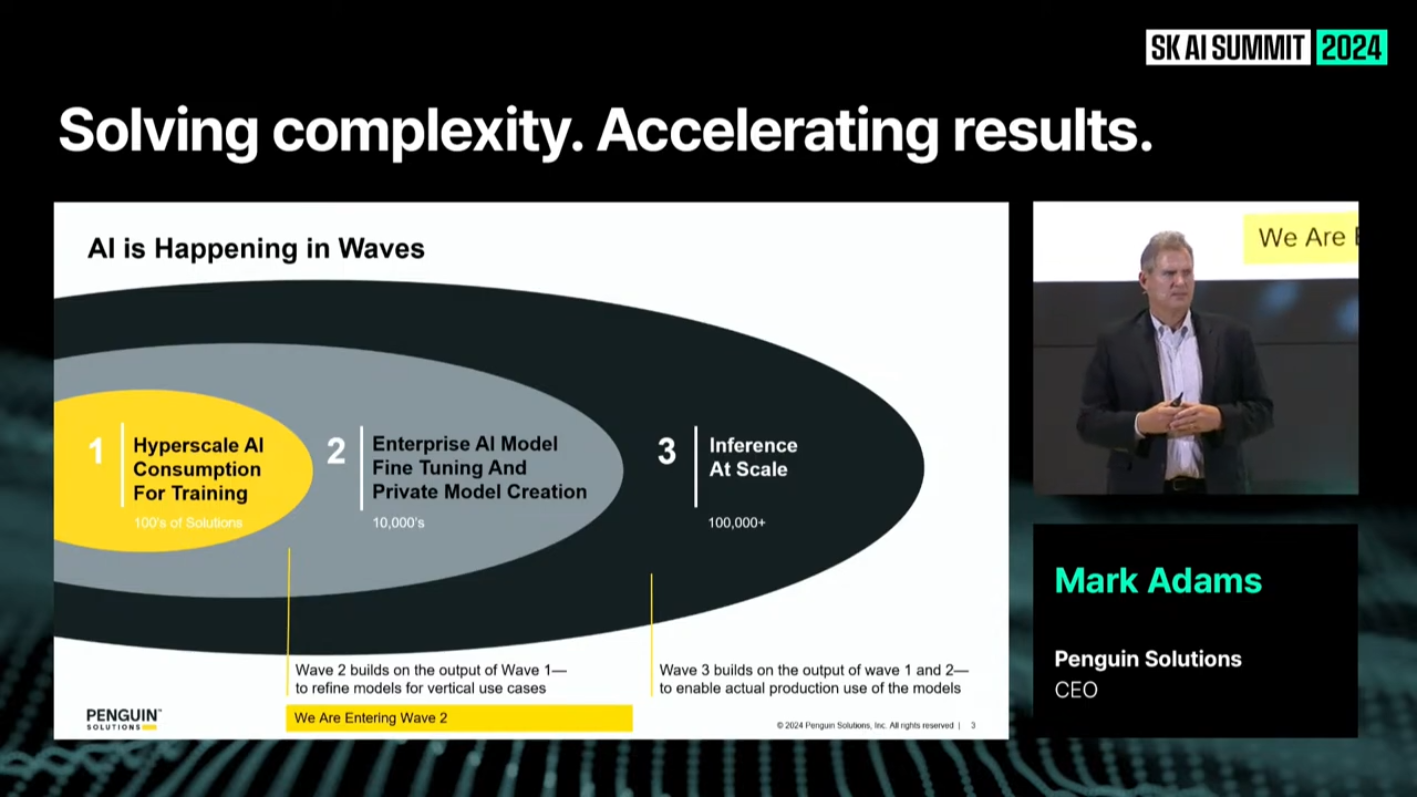

위 이미지는 기업들이 AI를 도입하는 과정이 단순히 GPU를 활용하는 것을 넘어, 점진적인 발전 단계를 거친다는 점을 강조합니다.

- 현재는 AI 트레이닝에서 맞춤형 모델 개발로 넘어가는 과도기(

Wave 2)이며, 곧 추론과 실제 비즈니스 적용(Wave 3)으로 확대될 것입니다.

wave1: Hyperscale-AI Consumption For Training, 하이퍼스케일 기업들이 대규모 AI 트레이닝을 위해 GPU와 데이터센터를 활용하는 초기 단계.wave2: Enterprise AI Model Fine Tuning And Private Model Cration, 기업들이 맞춤형 AI 모델을 개발하고, 특정 산업에 적합하게 미세 조정(Fine-Tuning)하는 확장 단계.wave3: Inference At Scale, AI 모델이 대규모 프로덕션 환경에서 추론(Inference)으로 실제 비즈니스에 활용되는 완성 단계.

2. AI 도입: 초기 단계에서 프로덕션까지

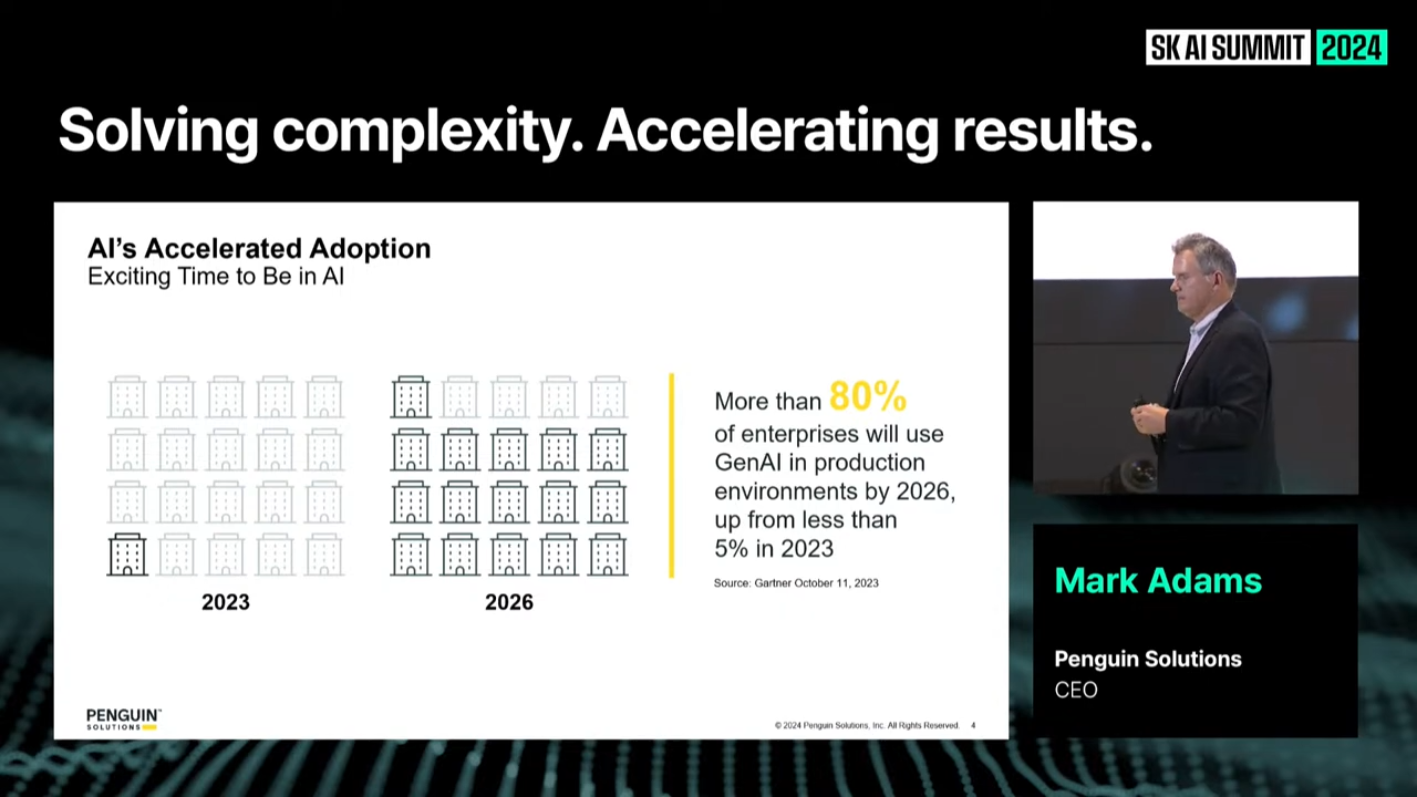

아래 이미지를 통해, 현재(2023년, 장표 기준)의 현실과 미래(2026년)의 예상 수치 간 괴리를 명확히 보여줍니다.

-

현재 AI를 프로덕션 환경에 도입한 기업이 5%에 불과한 상황에서, 3년 만에 그 숫자가 80%로 급격히 증가할 것으로 전망하고 있습니다.

-

이는 다음과 같은 의미를 가집니다:

- 현재와 미래의 격차: 지금 AI 도입이 극히 제한적이지만, 앞으로 대부분의 기업이 AI를 비즈니스 핵심으로 통합할 것이라는 급격한 변화가 예상됩니다.

- 준비와 실행의 차이: 많은 기업들이 AI 도입을 계획하고 있지만, 현재는 파일럿 단계나 인프라 구축 초기 단계에 머물러 있어, 실질적인 실행과 ROI 창출까지 가는 데 시간이 걸리고 있다는 점을 드러냅니다.

- 도전 과제:

- AI를 도입하고 확장하는 데 필요한 인프라 투자(데이터센터, GPU 등)와 기술적 역량 부족이 현재의 저조한 도입률의 원인일 수 있습니다.

- 예상 수치(80%)에 도달하려면 기업들이 인프라와 프로세스를 신속히 정비해야 한다는 것을 의미합니다.

- 기회와 위험:

- AI 도입에 성공하는 기업들은 빠르게 경쟁력을 확보하고 시장을 선점할 가능성이 높습니다.

- 반면, 이러한 괴리를 해소하지 못한 기업들은 AI를 제대로 활용하지 못해 경쟁에서 뒤처질 위험이 큽니다.

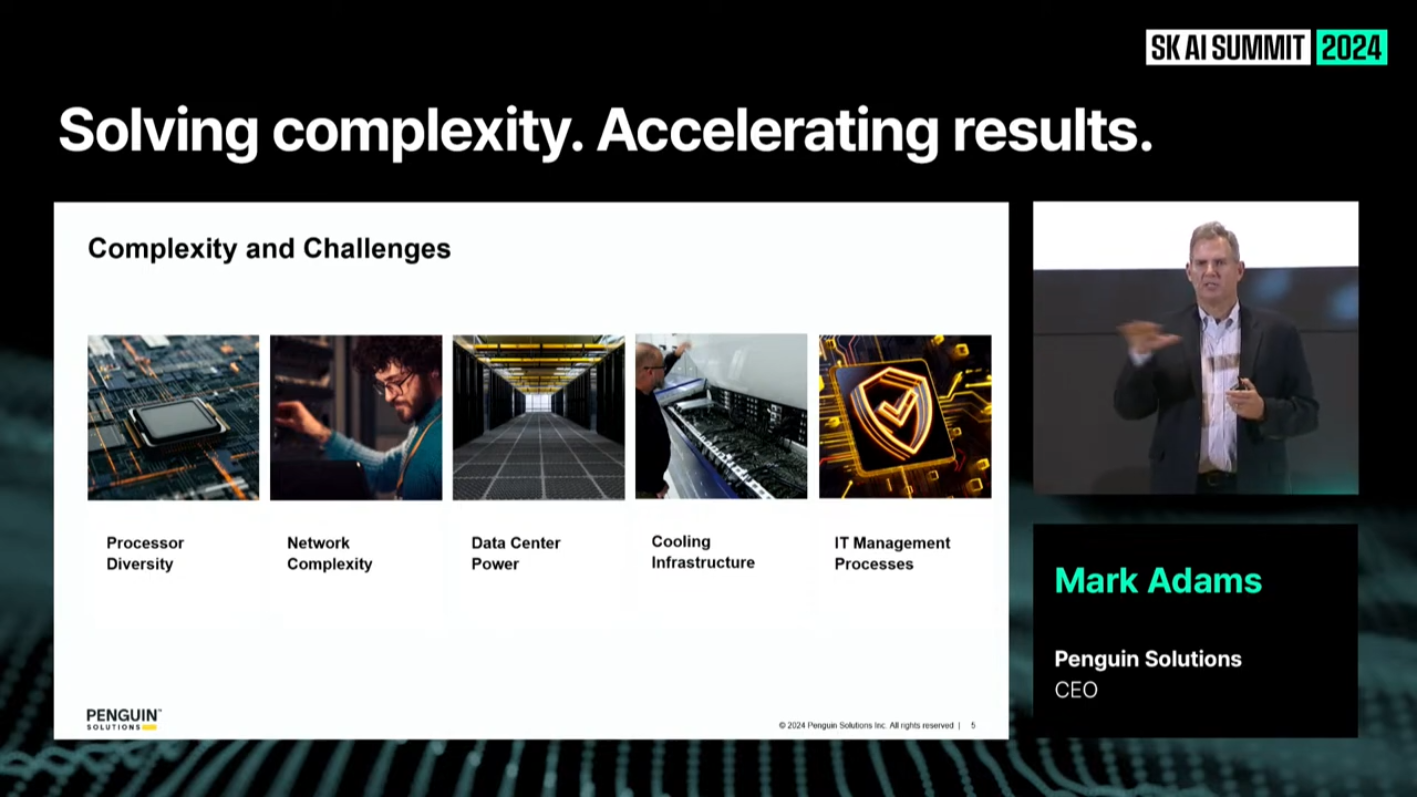

3. 데이터센터의 지속적인 발전과 복잡성의 증가

AI 데이터센터는 하드웨어와 소프트웨어의 통합적인 최적화를 요구합니다. 오늘날 데이터센터는 단순히 CPU 중심의 구조가 아닌, GPU와 HBM(High Bandwidth Memory)을 활용해 복잡한 워크로드를 처리하는 방향으로 변화하고 있습니다.

-

하지만 데이터센터의 복잡성은 하드웨어 성능 문제뿐만 아니라, 냉각 시스템과 같은 물리적 인프라 문제로도 이어지고 있습니다.

-

특히, AI 트레이닝 과정에서 발생하는 엄청난 열을 관리하기 위해 기존 공기 냉각(Air Cooling) 방식에서 오일 냉각(Oil-Based Cooling) 방식으로 전환하는 사례가 늘고 있습니다.

이는 단순히 효율성을 높이는 것을 넘어, 데이터센터의 안정성과 신뢰성을 보장하기 위한 필수 요소로 자리 잡았습니다.

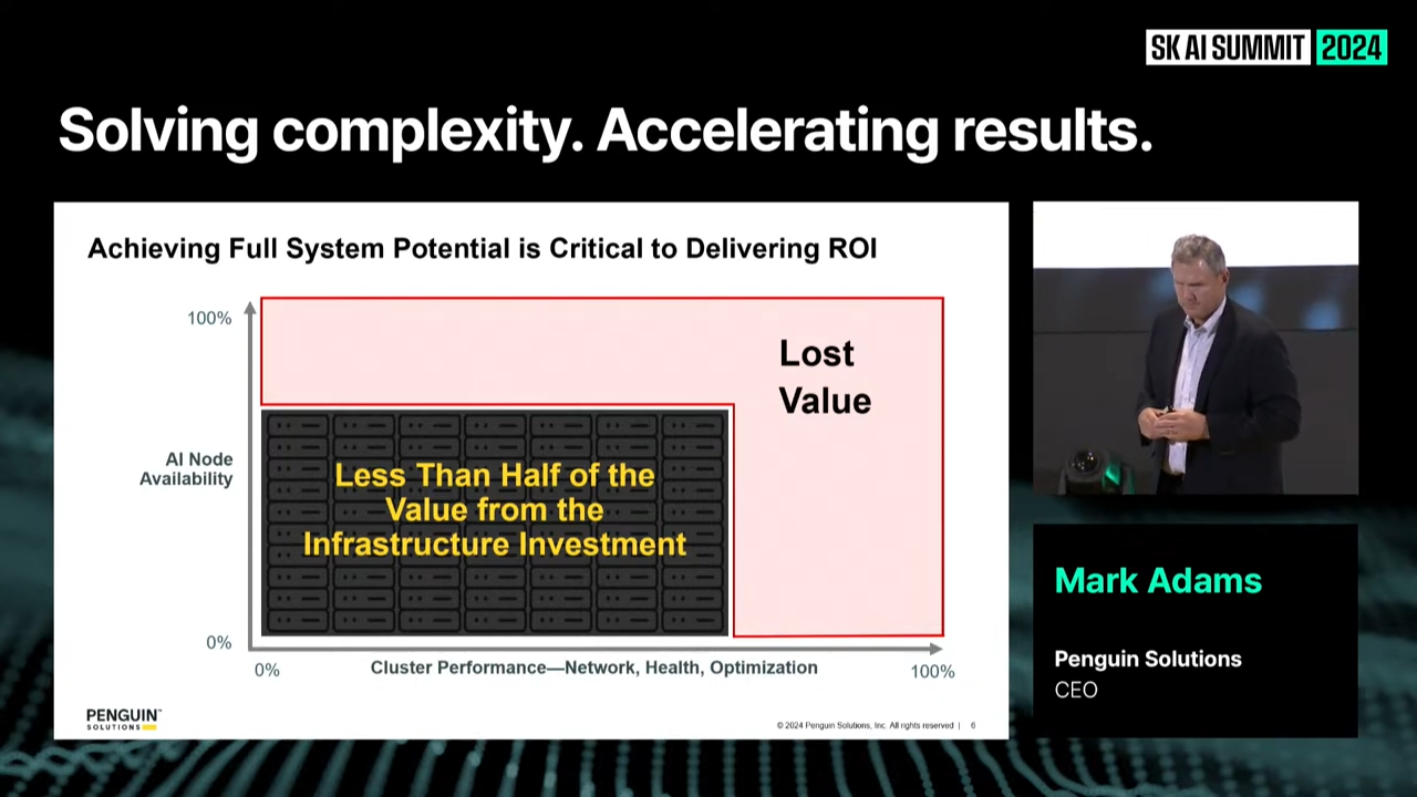

4. 복잡성 해결을 위한 최적화 전략

AI 인프라를 성공적으로 운영하려면 복잡성을 관리하고 최적화해야 합니다. GPU의 신뢰성은 약 70% 수준으로 평가되며, 네트워킹 및 최적화 문제까지 포함하면 전체 클러스터 퍼포먼스의 신뢰도는 더욱 낮아질 수 있습니다.

-

위 그림은 기업이 AI 인프라를 최대한 활용하지 못해 발생하는 Lost Value(손실된 가치)를 시각화한 것입니다.

- 가로축은 클러스터 성능(네트워크, 최적화 상태 등), 세로축은 AI 노드 가용성(Availability)을 나타냅니다.

- 현재 대부분의 AI 인프라는 제대로 최적화되지 않아, 투자한 인프라의 50% 미만의 가치를 실현하고 있는 상태임을 보여줍니다.

-

마크 아담스 CEO는 기업이 AI 인프라의 전체 잠재력을 실현하지 못하면 ROI를 충분히 확보할 수 없다는 점을 강조합니다.

Penguin Solutions는 이를 해결하기 위해 AI 인프라 전반에서 성과를 최적화하고, 데이터센터의 성능을 최대한 끌어올리는 데 주력하고 있습니다.

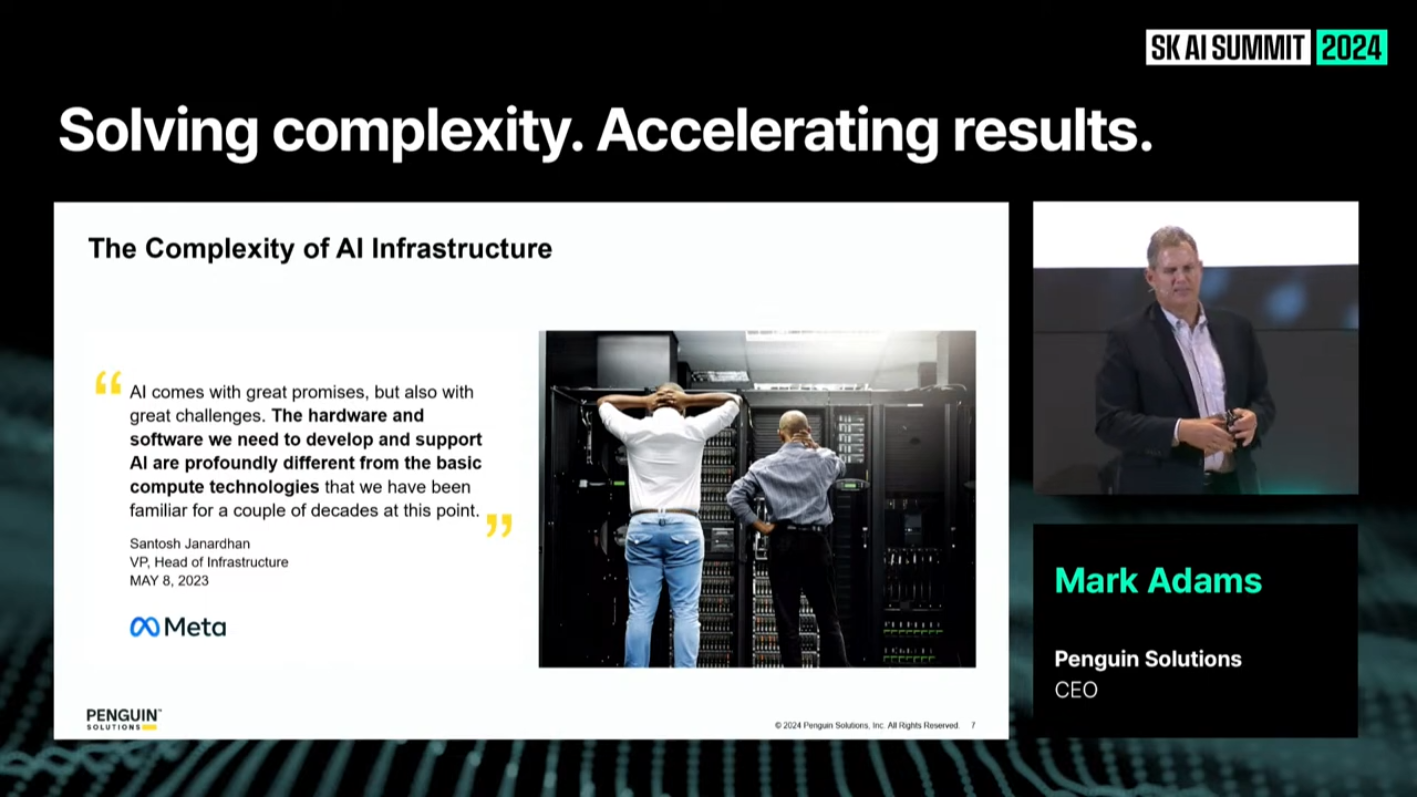

- 위 이미지는 AI 인프라 구축 및 운영에서 직면하는 복잡성을 보여줍니다.

- Meta의 VP, Santosh Janardhan의 발언을 인용하며, "AI 인프라가 기존의 컴퓨터 기술과는 근본적으로 다르다는 점"을 강조합니다.

- Meta도 이러한 점을 인지하고, 훨씬 더 규모가 작지만 이러한 AI 인프라에 강한 펭귄 솔루션에 도움을 요청한 이유가 여기에 있다고 이야기합니다.

- AI 인프라의 복잡성은 하드웨어(예: GPU, 메모리)뿐만 아니라 소프트웨어(예: 최적화, 관리 도구)에서도 새로운 접근 방식을 요구합니다.

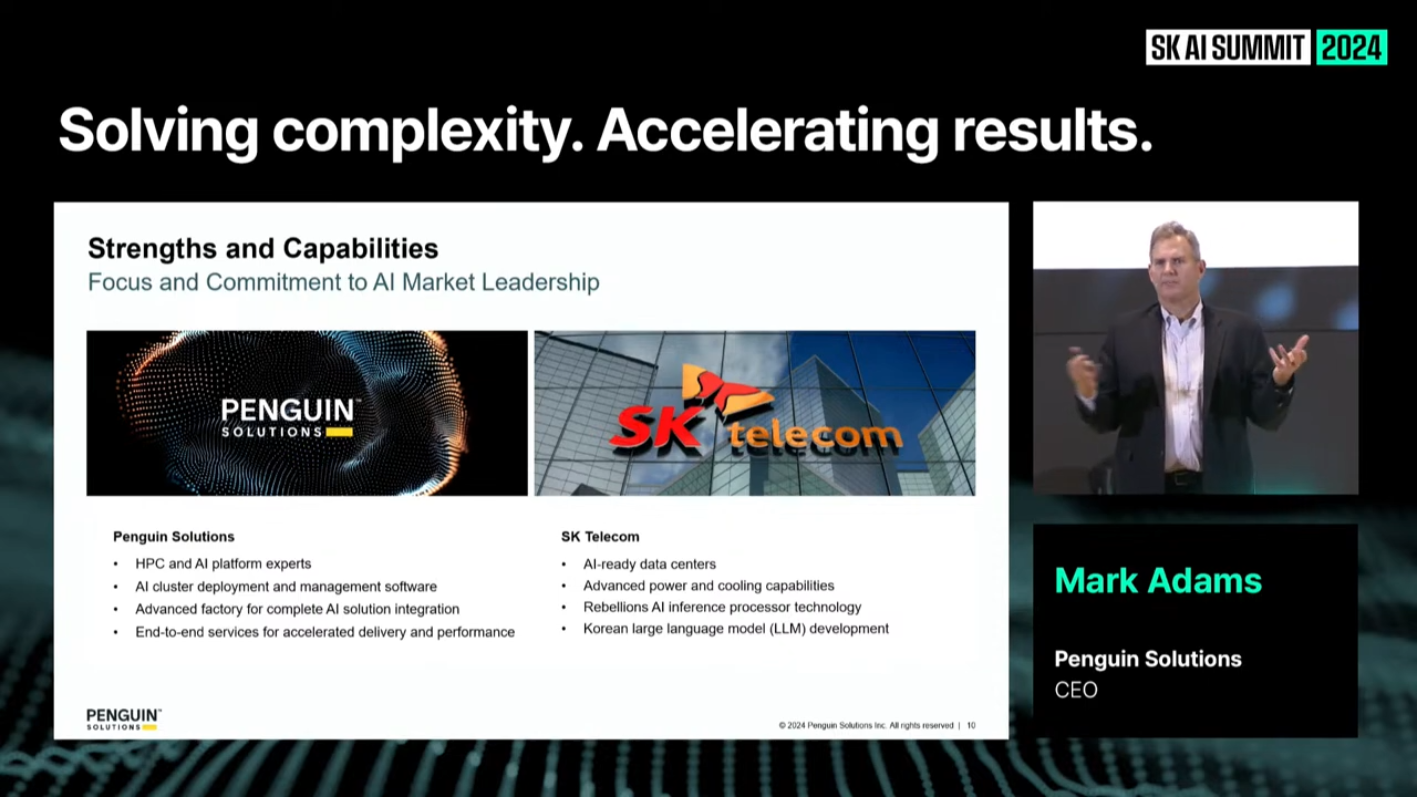

5. SK텔레콤과의 협업: 미래를 위한 전략적 파트너십

Penguin Solutions는 SK텔레콤과의 협력을 통해 AI 인프라의 최적화와 성능 향상에 새로운 기준을 제시하고 있습니다.

-

SK텔레콤은 HBM 기술을 포함한 메모리, 네트워킹, 반도체, 소프트웨어 기술에서 선두를 달리고 있으며, 이를 기반으로 고객에게 최상의 서비스를 제공합니다.

-

Penguin Solutions는 SK텔레콤과의 협력을 통해 AI 인프라의 생산성과 신뢰성을 향상시키고, 이를 통해 고객들에게 실질적인 가치를 제공하고자 합니다.

(후기) Penguin Solutions는 AI 인프라를 관리하고 최적화하는 복잡성을 해결하고, AI 인프라의 신뢰성과 성능을 극대화함으로써 고객들에게 가치를 제공합니다. 기업들은 이러한 흐름에 발맞추어 AI를 활용해 경쟁력을 강화하고, 더 나아가 고객 중심의 혁신을 이루어야 할 것입니다. 본 강연에서는 이러한 AI 시대를 준비하고 활용하기 위한 전략적 통찰을 제공하고 있습니다.

8. 오픈 모델과 GPUs As-A-Service로 AI를 제어하라

- 발표자: Stephen Balaban (Lambda CEO)

- 영어 제목: Take Control of AI with Open Models and GPUs As-A-Service(GPUaaS)

- 내용: 오픈 모델 및 GPU 서비스 모델을 통한 AI 제어 방안.

1. 람다의 시작과 GPU 혁명

람다(Lambda)는 2012년에 설립되어 초기에는 이미지 및 얼굴 인식 소프트웨어 개발에 중점을 두었습니다.

-

당시 AI 개발은 주로 수작업 소프트웨어와 기초적인 패턴 인식 기술에 의존했으나, 스티븐 발라반 CEO는 GPU 기반 뉴럴 네트워크로의 전환이 AI 개발의 새로운 시대를 열었다고 강조했습니다.

-

이 전환은 클라우드 기반 GPU 컴퓨팅의 확산과 맞물려 AI 연구 및 활용의 범위를 크게 확장시켰습니다. 스티븐 CEO은 모든 AI 개발자가 고성능 컴퓨팅 자원을 쉽게 활용할 수 있는 환경, 즉 "AI 개발자 클라우드"를 조성하는 것이 람다의 핵심 비전임을 소개하며 이러한 목표를 향해 나아가고 있음을 밝혔습니다.

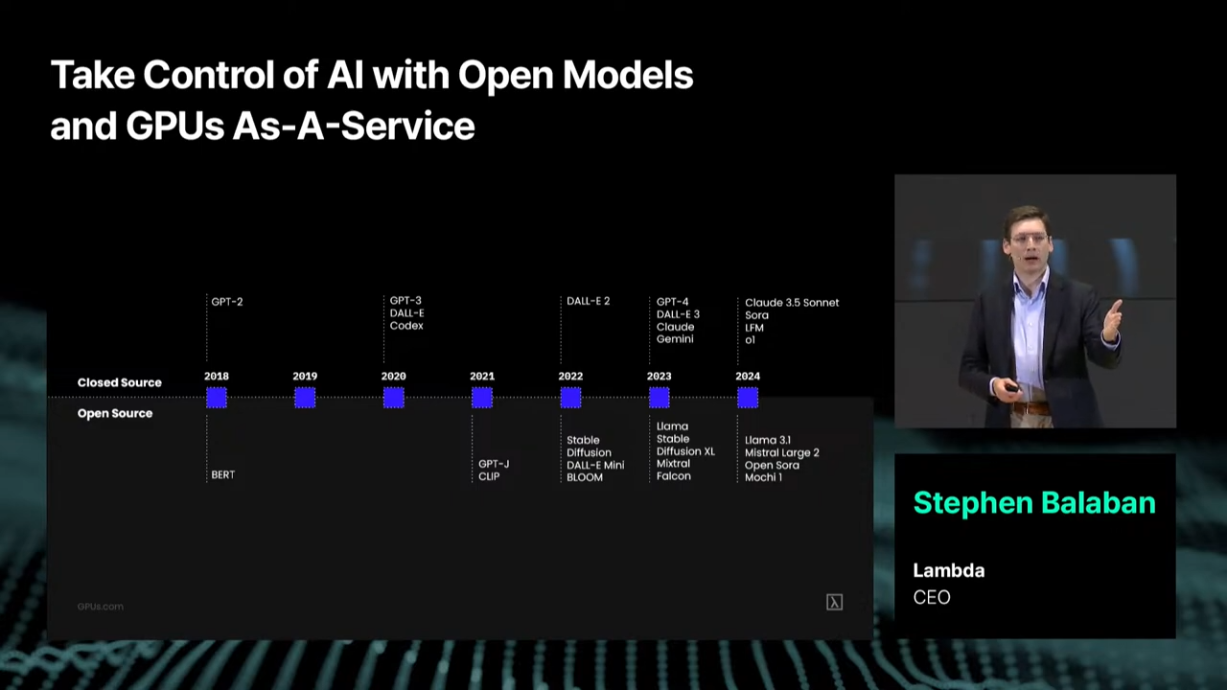

2. 오픈 소스 모델의 성장과 변화

최근 몇 년간 오픈 소스 AI 모델의 수와 품질이 비약적으로 성장하고 있습니다.

- GPT-2에서 시작해 GPT-3, DALL-E, Codex 등으로 진화한 독점적인 AI 모델들뿐만 아니라, 이를 모방하거나 대체할 수 있는 오픈 소스 모델이 등장하며 기술 격차를 좁혀가고 있습니다.

- 스티븐은 특히 독점 모델의 기능과 성능에 도전하는 오픈 소스 모델들이 빠르게 성장하고 있으며, 개발자들에게 다양한 선택지를 제공한다고 설명했습니다.

- 이로 인해 기업들은 특정 기술에 종속되지 않고 자신만의 커스터마이징된 모델을 개발할 수 있는 자유를 얻게 되었습니다.

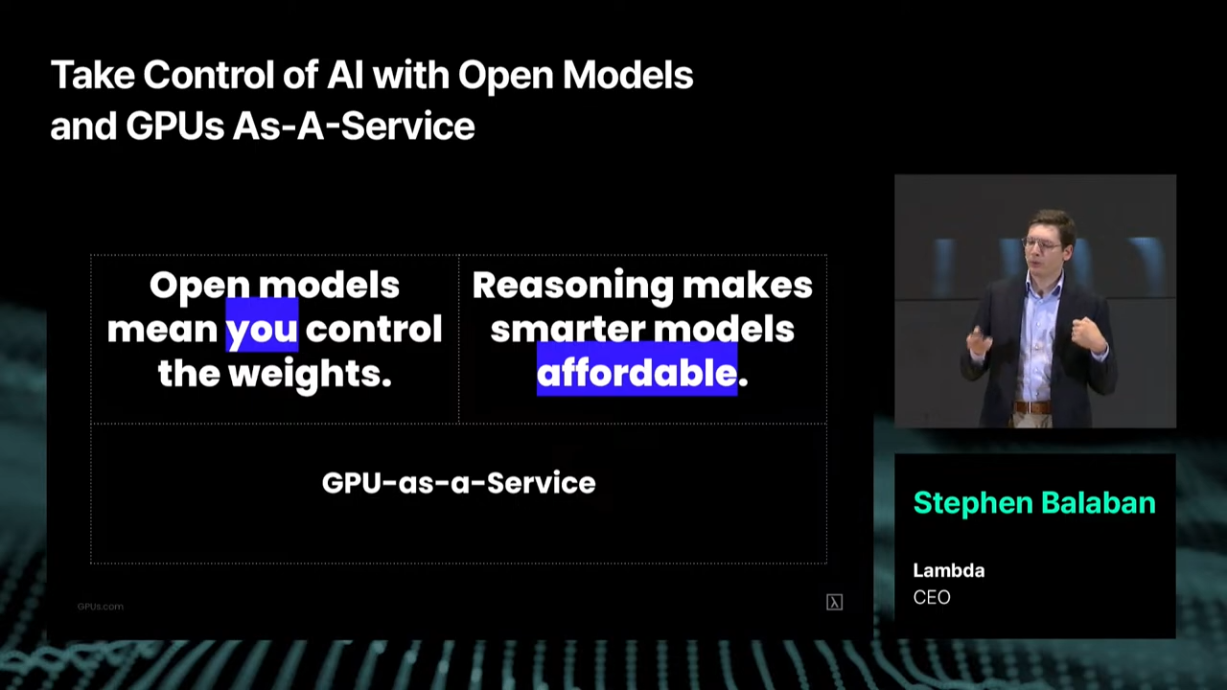

3. 오픈 소스와 GPUaaS의 장점

-

저렴한 고성능 연산 자원 => GPUaaS

-

GPUaaS(GPU-as-a-Service)는 고성능 GPU를 클라우드 기반으로 대여하는 서비스로, 초기 비용 없이 고가의 GPU를 활용할 수 있게 합니다.

-

경제적 접근성: 발표에서는 GPU 비용이 $120M에서 $1.2B로 10배 상승하는 사례를 언급하며, GPUaaS가 이러한 고비용 문제를 해결할 수 있는 핵심 솔루션임을 보여줍니다. -

스케일링 가능성: 필요에 따라 연산 자원을 쉽게 확장하거나 축소할 수 있어, 다양한 규모의 AI 프로젝트를 실행할 수 있습니다.

-

-

오픈 모델을 활용한 통제 가능성 => You control the weights

-

슬라이드에는 "Open models mean you control the weights"라는 문구가 등장하며, 이는 오픈 소스 모델이 개발자들에게 모델 내부의 가중치(weight)와 데이터 흐름을 완전히 제어할 수 있는 자유를 준다는 점을 강조합니다.

-

데이터 주권: 데이터가 특정 독점 플랫폼에 의존하지 않고, 사용자가 원하는 대로 모델을 커스터마이즈할 수 있습니다. 이는 기업과 개인이 데이터 보안을 강화하고 현지화된 AI 솔루션을 개발하는 데 유리합니다.

-

-

경제적 이점: 오픈 소스 모델을 활용하면 라이선스 비용 없이 고성능 AI 모델을 구축할 수 있으며, GPUaaS와 같은 저렴한 연산 자원과 결합하면 비용 효율성이 극대화됩니다. -

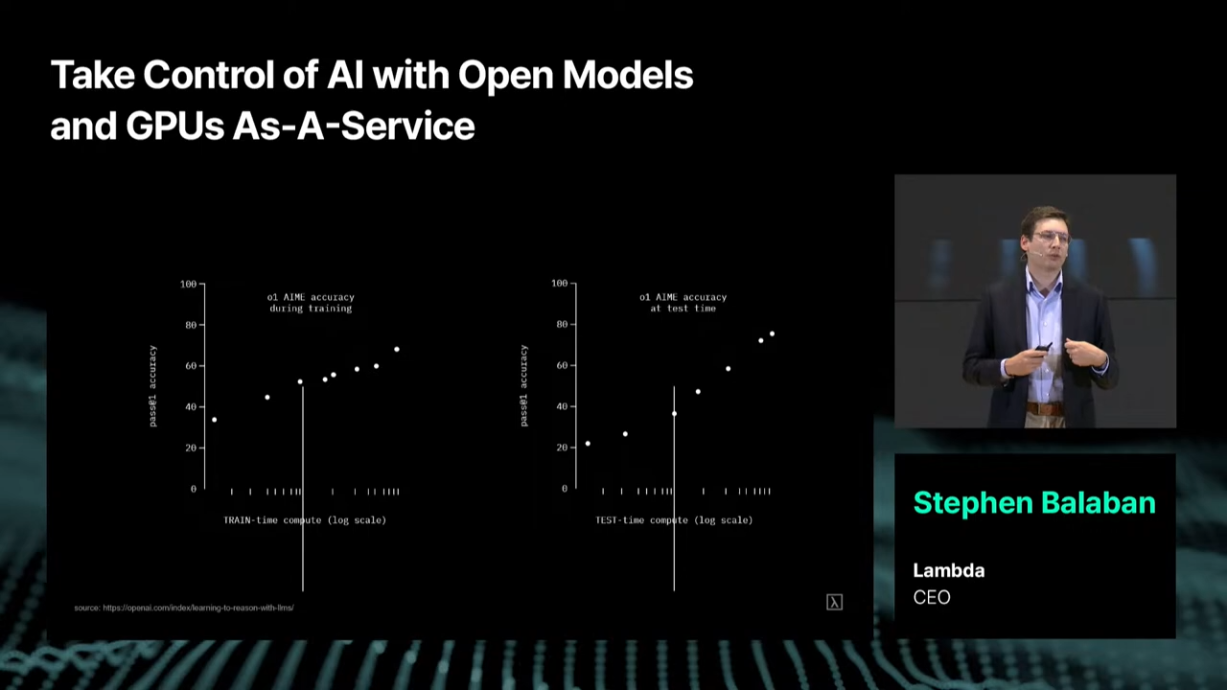

추론(inference) 중심의 비용 절감 효과 => Reasoning makes smarter models affordable

-

슬라이드에서는 "Reasoning makes smarter models affordable"라는 문구가 강조되었는데, 이는 추론을 활용한 AI 모델이 고품질의 결과를 저렴하게 제공할 수 있음을 나타냅니다.

-

훈련 대비 추론의 비용 효율성: 슬라이드에서 훈련(Train) 시간과 테스트(Test) 시간 동안의 정확도 변화를 보여주는 그래프가 있습니다. 이 그래프는 훈련에 더 많은 자원을 투입하지 않아도, 효율적인 추론이 가능하다면 AI 모델의 성능을 극대화할 수 있음을 시사합니다.

-

현실적인 예시: 슬라이드에 언급된 것처럼, 단순한 문제(예: 레시피 생성)는 추론만으로도 효과적으로 해결할 수 있습니다. 반면에, 복잡한 문제(예: 대규모 코드 설계)에서도 스마트한 추론이 비용을 절감하면서 높은 품질을 유지하게 합니다.

😵 좀 정리를 해보자면 GPUaaS를 통해 아래를 추구하는 것 같다

- 훈련 비용 절감과 추론 환경 통합:

- GPUaaS를 활용하면 고비용의 GPU를 구매하지 않고도 훈련을 실행할 수 있으며, 훈련 후에는 같은 환경에서 추론 작업까지 실행 가능합니다. 즉, GPUaaS는 훈련과 추론 모두를 지원할 수 있는 유연한 옵션을 제공합니다.

- 추론에 GPU가 필요할 때:

- 추론 단계에서는 이미 훈련된 모델이 새로운 데이터를 처리하고 결과를 내놓기 때문에, 훈련 단계만큼의 연산 자원이 필요하지 않습니다. 즉, 모델의 복잡성과 데이터의 크기에 따라 다르지만, 일반적으로 훈련보다 적은 GPU 리소스로도 충분히 수행 가능합니다.

- (개인의견) 람다는 좀 더 후자 쪽에 포커싱을 하고 있는 것으로 보입니다.

4. SK와의 파트너십 및 한국에서의 AI 클러스터 구축

람다는 SK와의 파트너십을 통해 한국에서 대규모 GPU 클러스터를 구축하고, 이를 통해 오픈 모델 생태계를 확장하는 데 집중하고 있다고 덧붙였습니다.

- 스티븐은 이 협업이 한국의 AI 기술 개발에 중요한 역할을 할 것이라고 확신하며, 람다가 제공하는 GPUaaS와 AI 모델 호스팅 서비스가 한국 기업들에게 큰 기회를 제공할 것이라고 언급했습니다.

(후기) 스티븐 발라반 CEO의 발표는 오픈 소스와 GPUaaS의 활용을 통해 AI 개발 환경이 어떻게 진화하고 있는지를 명확히 보여주었습니다. 오픈 소스 모델의 확산과 GPUaaS를 통해 누구나 AI 기술을 개발하고 활용할 수 있는 도구와 환경을 제공하는 것을 비즈니스 목표로 삼고 있다고 설명했습니다. 개인적으로 다른 GPU 제공 서비스들과 어떤 차별점이 있을지 궁금하네요 🤔

9. 패널토의: AI 시대 Infrastructure의 현재와 미래

- 내용: AI 인프라의 발전 현황과 미래 방향에 대한 패널 토의.

- 참여자:

- 유영상 (SK텔레콤 CEO)

- Mark Adams (Penguin Solutions CEO)

- Stephen Balaban (Lambda CEO)

- 오혜연 교수 (KAIST, Moderator)

1. AI 시대의 중심, Infrastructure의 중요성

4차 산업혁명의 중심에 있는 AI 기술의 발전은 산업 전반에 걸쳐 거대한 변화를 이끌고 있습니다. 그 변화의 기반이 되는 AI Infrastructure의 중요성은 날로 커지고 있습니다.

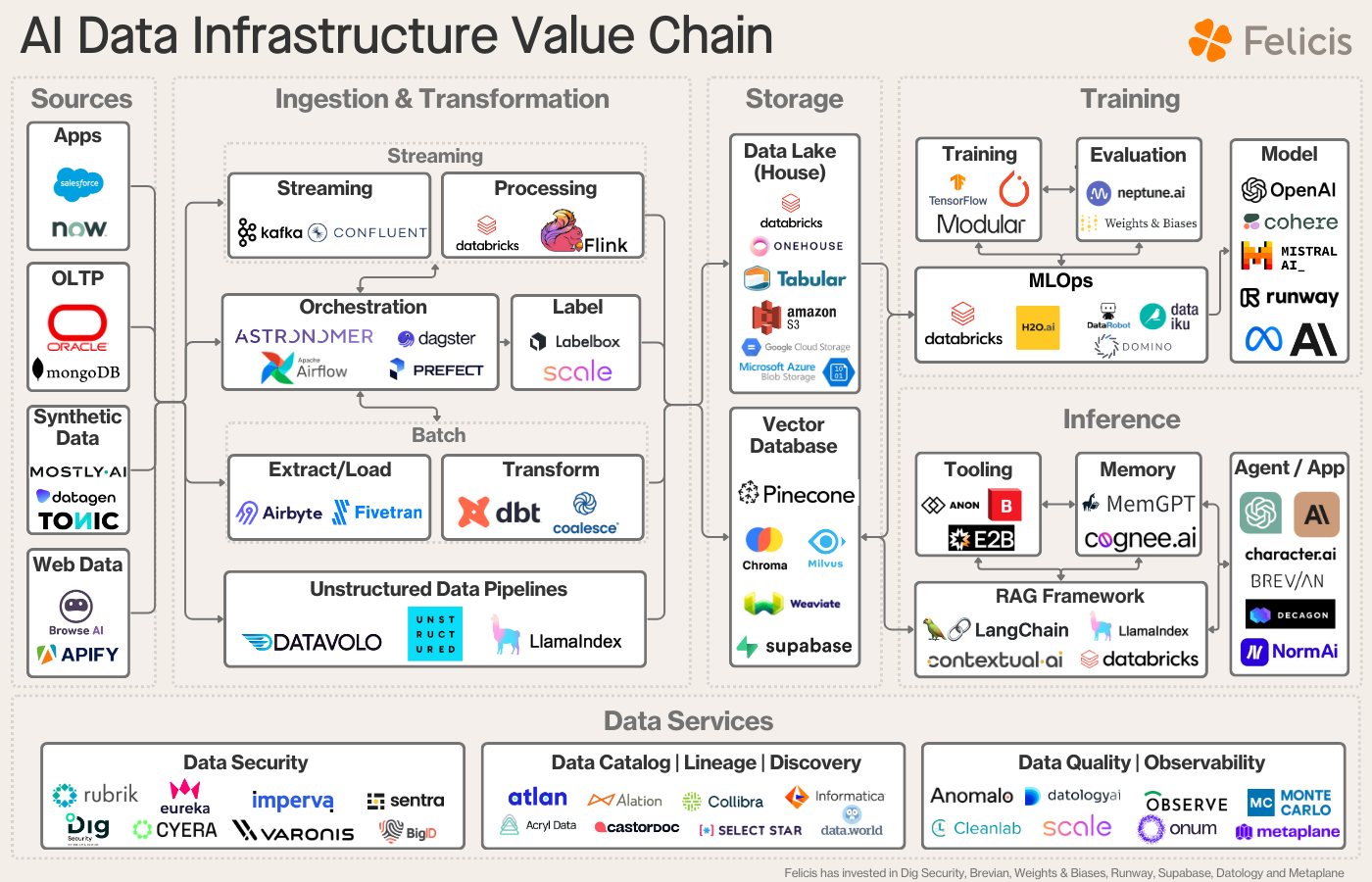

💡 AI Infrastructure란?

AI Infrastructure는 단순히 하드웨어나 소프트웨어 스택을 넘어서, AI를 가능하게 하는 모든 기술적 생태계를 포함합니다. 이는 데이터에서 시작해, AI 모델 훈련 및 배포, 운영까지 전 과정을 아우르며, 기업과 조직이 AI 애플리케이션을 성공적으로 구현하도록 돕는 모든 도구, 플랫폼, 프로세스를 포함합니다.

- 결론적으로, AI Infrastructure의 범위는 기술적 스택, 운영 프로세스, 그리고 도메인 특화된 솔루션을 아우르는 AI 개발 및 운영의 모든 면을 포함한다고 할 수 있습니다.

이미지출처ㅣ https://www.felicis.com/insight/ai-data-infrastructure

이번 패널은 오혜연 KAIST 교수의 사회로 진행되었으며, SK텔레콤의 유영상 CEO, Penguin Solutions의 Mark Adams CEO, 그리고 Lambda의 Stephen Balaban CEO가 참석했습니다.

2. AI 데이터센터의 등장과 주요 변화

패널토론의 첫 번째 주제는 AI 데이터센터의 등장과 전통적인 데이터센터와의 차이였습니다.

-

람다의 스티븐 발라반 CEO는 GPU 호스팅 데이터센터가 2017년부터 본격화되었으며, 전통적인 데이터센터 대비 최신 AI 데이터센터는

전력 소모,냉각 방식, 그리고서버 밀도면에서 큰 변화를 보였다고 설명했습니다.- 예를 들어, 과거 데이터센터는 렉당 2~5KW의 전력을 요구했던 반면, AI 데이터센터는 최대 30KW까지 필요하며 이를 충족하기 위해 액체 냉각과 같은 기술이 도입되고 있다고 덧붙였습니다.

-

펭귄 솔루션의 마크 아담스 CEO는 AI 데이터센터의 기술적 요구와 변화 속도가 과거 닷컴 시대의 버블과는 다르다고 지적했습니다. AI는 실질적인 수요와 기술적 요구를 기반으로 빠르게 성장하고 있으며, 냉각 기술과 전력 수급의 발전이 이를 뒷받침하고 있다고 설명했습니다.

3. 통신사의 역할과 기회

AI 데이터센터는 전통적인 통신사에도 새로운 기회와 과제를 동시에 제공하고 있습니다.

- SK텔레콤 유영상 CEO는 통신사가 이미 데이터센터 사업을 운영하고 있으며, AI 데이터센터로의 전환은 새로운 비즈니스 모델을 열 수 있는 기회라고 말했습니다.

- 특히 SK텔레콤은 기존의 콜로케이션 사업을 넘어 GPUaaS(GPU as a Service)와 같은 새로운 서비스를 통해 더 큰 가치를 창출하고자 한다고 이야기했습니다.

❓ 콜로케이션 사업은 데이터센터를 운영하는 방식 중 하나로, 데이터센터 운영자가 물리적인 공간(랙, 전력, 냉각 등)을 제공하고, 고객이 직접 자신의 서버 및 네트워크 장비를 설치하여 사용하는 형태를 의미합니다.

- 이 비즈니스 모델은 데이터센터의 기본적인 인프라(공간, 전력, 냉각, 보안 등)를 관리하지만, 서버 하드웨어와 소프트웨어의 운영은 고객이 책임지는 방식입니다.

4. 글로벌 AI 데이터센터 수요와 파트너십의 중요성

AI 데이터센터 수요는 전 세계적으로 폭발적으로 증가하고 있으며, 정부와 기업이 협력해 인프라 확충에 나서고 있습니다.

-

특히, 스티븐 발라반 CEO는 데이터센터 규모가 과거보다 100배 이상 커지고 있으며, 이러한 상황에서 기업과 정부 간 파트너십이 필수적이라고 설명했습니다. (=> 하나의 기업이 더이상 전부 커버하기 힘든 영역임)

-

마크 아담스 CEO 역시 파트너십의 중요성을 강조하며, AI 인프라 공급 과정에서 모든 기업이 각각의 강점을 살려 협력해야 한다고 말했습니다.

- 그는 SK텔레콤이 메모리, 에너지, 네트워크 기술에서 글로벌 선두 기업으로서 AI 인프라 확장에 중요한 역할을 하고 있음을 높이 평가했습니다.

5. AI 인프라 산업의 전략과 인재 확보

패널에서는 AI 데이터센터 산업에서 성공하기 위한 전략과 인재 확보 방안에 대한 논의도 이루어졌습니다.

-

(인프라 산업의 전략) 람다의 스티븐 CEO는 높은 가동률과 합리적인 가격을 유지하는 것이 AI 클라우드 서비스의 핵심이라고 설명하며, AI 시대에도 기본적인 비즈니스 원칙이 변하지 않는다고 덧붙였습니다.

-

(인재 확보 전략) 마크 아담스 CEO는 인재 확보에 있어 단순히 특정 기술 경험이 많은 사람보다 독립적인 사고와 위험 감수 능력을 갖춘 인재를 육성하고 동기를 부여하는 것이 중요하다고 말했습니다.

6. 환경 문제와 AI 인프라의 지속 가능성

-

유영상 CEO는 AI 데이터센터 구축에서 발생하는 전력 수급 문제와 탄소 중립과 같은 환경적 도전을 해결하기 위해 분산 에너지, LNG 발전, 원전, 그리고 소규모 모듈식 원자로(SMR) 등의 대안을 고려해야 한다고 강조했습니다.

-

또한, 유영상 CEO는 이를 해결하기 위해 AI 데이터센터를 수도권 외 지역으로 분산시키는 정책적 노력이 필요하다고 주장했습니다. 또한, 재생 에너지와 원자력 발전을 통해 넷제로(Net Zero) 목표를 달성하려는 노력이 중요하다고 덧붙였습니다.

7. SK텔레콤의 AI 인프라 전략과 G3 비전

유영상 CEO는 SK텔레콤이 AI 인프라에서 통신망의 강점을 활용하여 새로운 가치를 창출할 수 있다고 강조했습니다.

- 특히, 5G와 6G 네트워크가 AI 데이터센터와 결합해 데이터 전송뿐만 아니라 실시간 추론까지 가능하도록 발전해야 한다고 말했습니다.

- 그는 이러한 AI 인프라 전략이 대한민국을 AI 인프라 강국(G3)으로 도약시키는 핵심이 될 것이라고 밝혔습니다.

(후기) 이번 패널토론에서는 AI 시대 인프라의 현재와 미래를 이끄는 주요 기업과 인프라의 역할, 그리고 글로벌 파트너십의 중요성이 논의되었습니다. AI 데이터센터는 단순한 기술적 인프라를 넘어 AI 생태계의 핵심으로 자리 잡고 있으며, SK텔레콤과 같은 통신사는 AI 데이터센터 시장에서의 기회를 적극 활용하고 있다는 인식을 주었습니다.

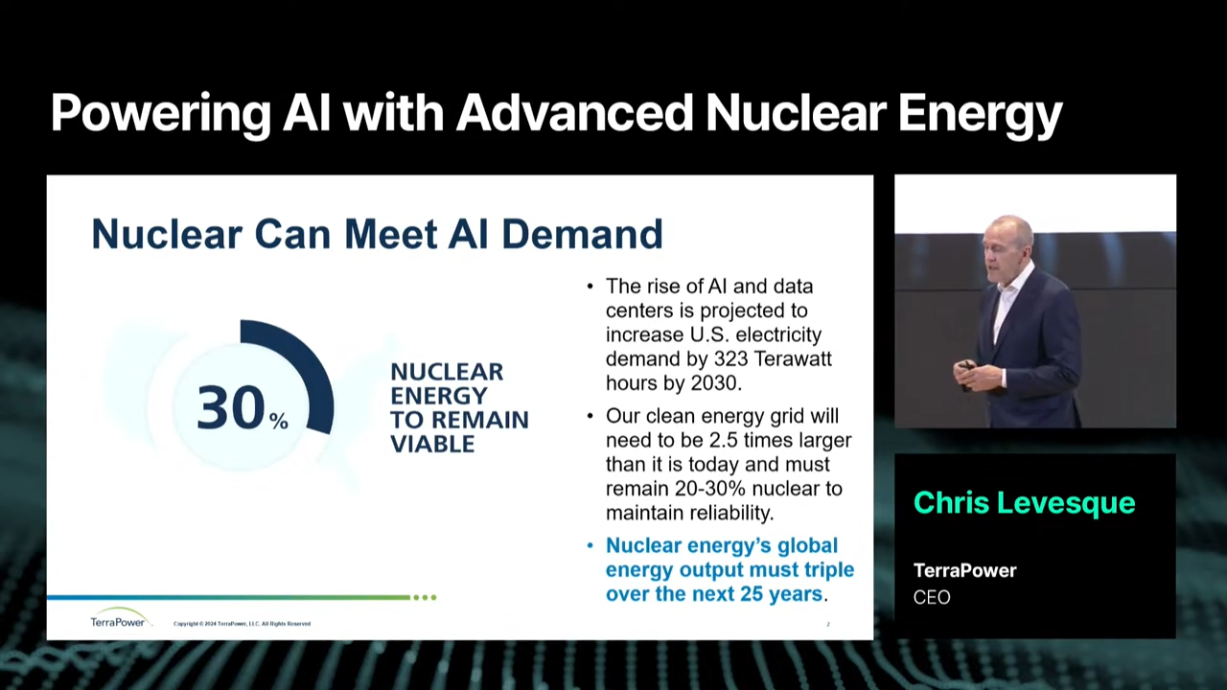

10. 첨단 원자력 에너지로 AI 구동하기

- 발표자: Chris Levesque (TerraPower CEO)

- 내용: 원자력 에너지를 통한 AI 구동 및 지속 가능한 에너지 전략.

1. 빌 게이츠와 TerraPower: 에너지 혁명을 이끄는 첨단 원자력 기술

2050년, 전 세계의 전력 수요는 2.5배로 증가할 것이라는 전망이 있습니다.

- AI 기술의 발전과 이에 따른 데이터 센터, 전기차, 재생 에너지 기반의 전력 소비가 늘어남에 따라 에너지 전환의 필요성은 더욱 대두되고 있습니다.

뿐만 아니라 기존 석탄 발전소의 대규모 퇴역과 함께, 안정적이고 지속 가능한 에너지를 제공할 새로운 대안이 필요해졌습니다.

- 이 문제를 해결하기 위해 등장한 혁신적인 솔루션이 바로 TerraPower의 첨단 원자력 기술입니다.

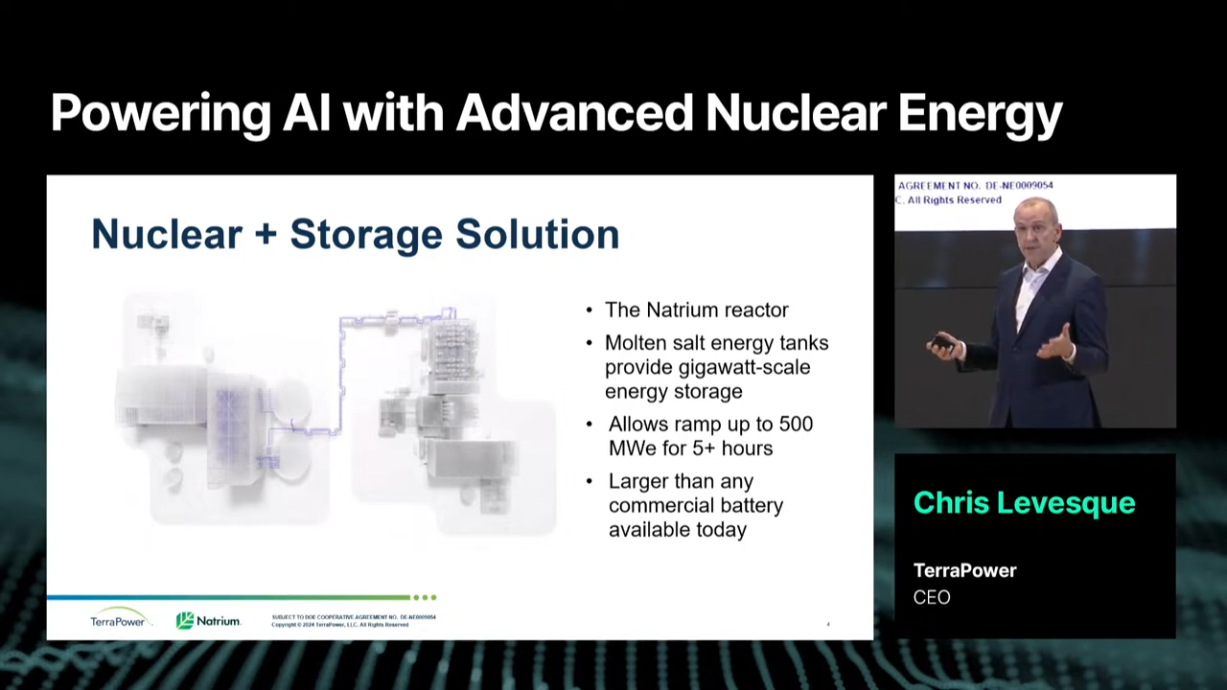

2. Natrium 원자로: 미래 에너지의 게임 체인저

Chris Levesque CEO는 Natrium 원자로 기술을 미래 에너지 전환을 위한 혁신적인 원자력 발전 시스템으로 소개합니다.

- TerraPower가 개발한 이 기술은 단순히 경제성과 유연성을 제공하는 것을 넘어 기존 원자력 발전소와 재생 에너지의 단점을 보완하며 에너지 저장과 관리에 있어서 새로운 기준을 제시합니다.

-

용융염 에너지 저장 시스템

- Natrium 원자로는 Molten Salt Energy Storage(용융염 에너지 저장) 방식을 도입하여 기존 원자로보다 훨씬 더 유연한 에너지 생산 및 저장을 가능하게 합니다.

- 이 시스템은 기가와트(GW)급 규모의 에너지를 저장할 수 있으며, 전력 수요가 피크를 찍는 시간대에 5시간 이상 동안 최대 500MWe(메가와트 전력)의 에너지를 안정적으로 공급할 수 있습니다.

- 이는 현재 상용화된 모든 배터리 시스템보다 훨씬 더 큰 저장 용량을 제공합니다.

-

에너지 디스패치(Dispatch) 유연성

- 기존 원자로는 일정 수준의 전력을 지속적으로 생산해야 했던 반면, Natrium 원자로는 수요 변화에 따라 발전량을 즉각적으로 조정할 수 있습니다.

- 예를 들어, 낮 동안 태양광 에너지가 풍부하게 생성되는 경우에는 원자로의 출력을 줄이고, 밤이나 흐린 날씨처럼 태양광 발전이 줄어드는 상황에서는 출력을 늘릴 수 있습니다. 이를 통해 재생 에너지와의 조화를 극대화할 수 있습니다.

-

효율적 인프라 활용

- Natrium 원자로는 퇴역한 석탄 발전소 부지에서 기존의 냉각망, 송전 계통, 그리고 기타 기반 시설을 그대로 사용할 수 있습니다. 이는 건설 비용을 낮추고 기존 인프라를 재활용할 수 있는 큰 장점을 제공합니다.

- 석탄 발전소에서 근무했던 인력도 Natrium 원자로의 운영 및 관리 업무에 재배치가 가능하여, 지역 경제에 긍정적인 영향을 미칩니다.

3. AI와 원자력: 에너지 혁신의 결합

Chris Levesque CEO는 Natrium 원자로가 AI와의 결합으로 더욱 혁신적인 발전을 가져올 수 있다고 설명했습니다. AI는 다음과 같은 방식으로 원자로의 효율성을 높이는 데 기여할 수 있습니다.

-

실시간 수요 예측

- AI 기반 전력 관리 시스템은 전력 수요를 실시간으로 분석하고, 원자로의 출력을 최적화합니다.

-

예방적 유지보수

- AI는 원자로의 데이터를 모니터링하고, 이상 징후를 조기에 감지하여 유지보수 비용을 줄이고 운영 안정성을 높입니다.

-

재생 에너지 통합

- AI는 태양광 및 풍력 발전의 변동성을 분석하여, Natrium 원자로가 필요한 시점에만 출력을 늘리거나 줄이는 방식으로 재생 에너지와의 통합을 돕습니다.

4. 퇴역 석탄 발전소와 원자력의 공존

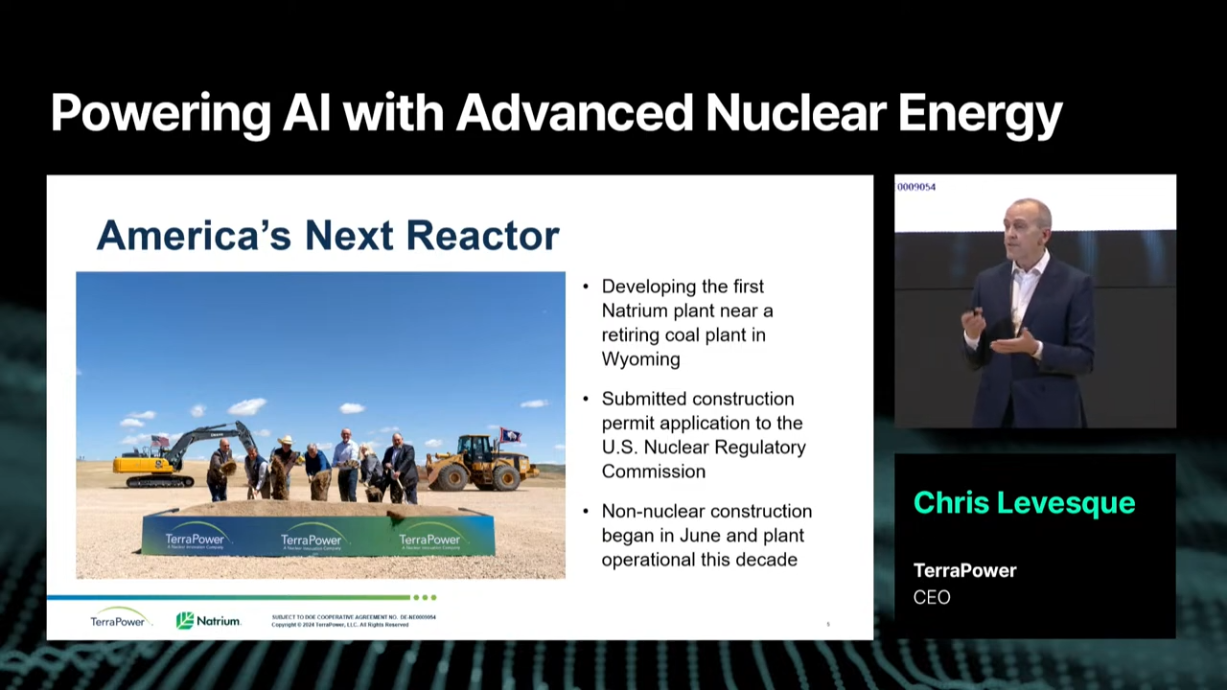

TerraPower는 퇴역한 석탄 발전소를 활용해 새로운 원자력 발전소를 건설하고 있습니다.

- 석탄 발전소에서 근무했던 숙련된 인력을 새로운 원자로로 전환시키고, 기존의 인프라를 재활용함으로써 경제적, 환경적 이점을 극대화하고 있습니다.

- 이러한 접근은 지속 가능한 에너지 전환의 대표적인 사례로 주목받고 있습니다.

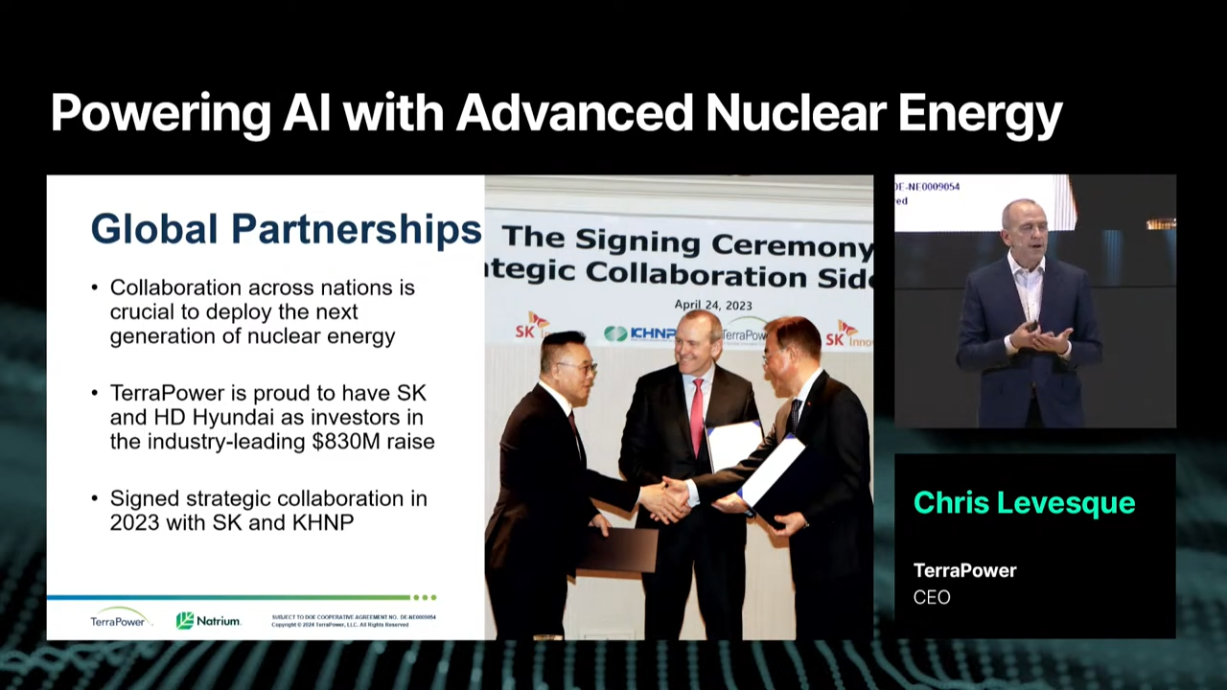

5. 한국과 TerraPower의 협력

한국의 한수원, HD현대, SK 등 여러 기업은 TerraPower와 협력하여 첨단 원자력 발전 기술을 전 세계적으로 확산시키고 있습니다.

- TerraPower는 한국의 우수한 공급망, 기술력, 그리고 시장 확대 능력을 활용해 글로벌 에너지 문제를 해결하는 데 중점을 두고 있습니다.

- 한국은 앞으로도 새로운 원자로 개발 및 상용화를 통해 국제 에너지 시장에서 중요한 역할을 할 것입니다.

(후기) 첨단 원자력 발전을 AI에 도입한다는 개념을 이번 SK-Summit에서 처음 알게되었는데요. Chris Levesque CEO는 이 기술이 전 세계적인 전력 수요 증가에 대응할 중요한 솔루션이 될 것임을 확신하며, 특히 한국과의 협력을 통해 글로벌 에너지 문제를 해결하는 데 중요한 역할을 하기를 기대한다고 밝혔습니다. 앞으로 제대로만 유통/공급이 된다면 AI에 드는 수많은 전력 니즈를 충족해줄 수도 있겠다라는 생각이 들었습니다😋

11. AI 발전을 위한 기술적 요구사항

- 발표자: Steve Scott (AMD Corporate Fellow)

- 내용: AI 기술 발전을 위한 반도체와 기타 기술적 요구사항 논의.

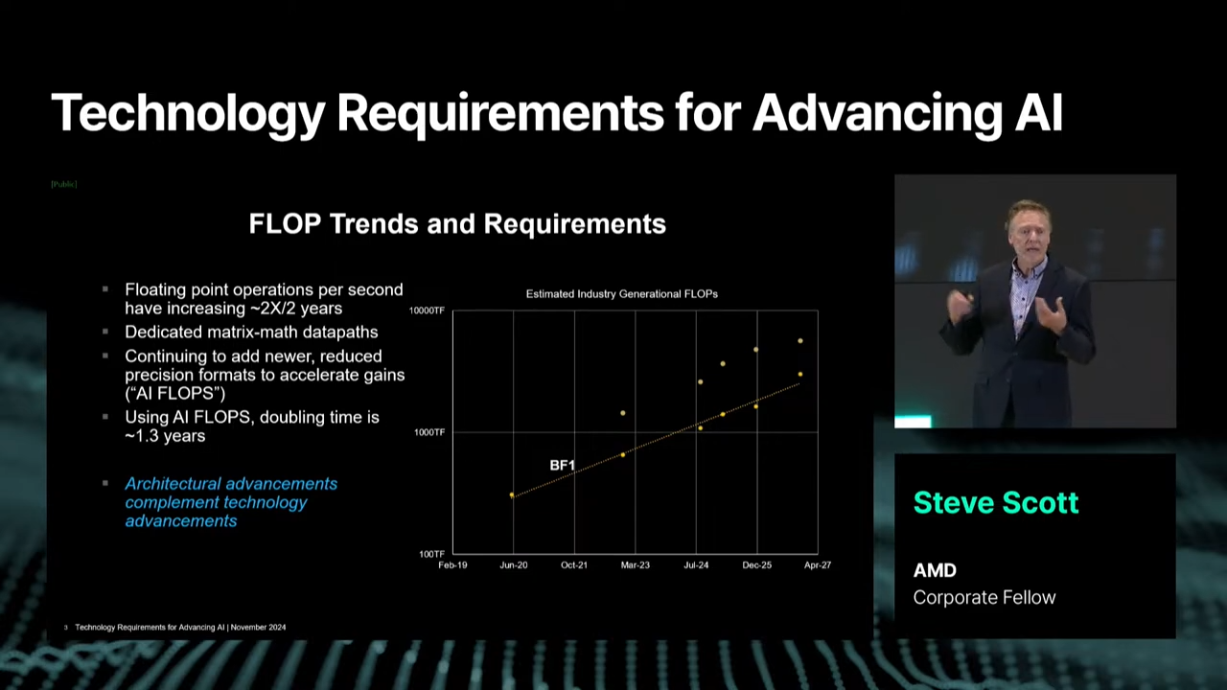

1. AI 연산의 폭발적인 성장

AI 기술은 매년 혁신의 속도를 더해가고 있습니다.

- 특히 2010년대부터 이미지 및 비전 모델의 연산 요구가 두 배씩 증가해 오다가, 최근 거대 언어 모델과 생성형 AI가 등장하면서 매년 4~5배로 성장 속도가 빨라졌습니다.

이러한 모델들은 뛰어난 성능을 제공하지만, 이로 인해 필요한 파라미터 수와 학습 에너지가 폭발적으로 증가하고 있습니다.

- 이 성장은 현재로선 끝이 보이지 않으며, 앞으로도 계속될 것으로 보입니다.

하지만 문제는 기본 기술의 발전 속도가 이러한 요구를 따라잡지 못한다는 점입니다.

- 기술적 한계를 극복하지 못하면 AI 모델의 성능과 효율성은 제한될 수밖에 없습니다.

2. AI 연산의 기본 기술: 효율적 데이터와 에너지 관리

AI 기술의 핵심은 데이터와 연산 효율성을 높이는 것입니다. AMD는 이를 위해 다양한 혁신적인 접근을 제시합니다.

2.1. 데이터 타입 최적화와 연산 효율성

AI 연산 성능의 핵심은 데이터 처리의 정밀도와 효율성을 조율하는 것입니다. AMD는 기존의 연산 데이터 타입(64비트)을 점차 간소화하여 16비트, 심지어 4비트 블록 메트릭스 데이터 타입을 도입하고 있습니다.

- 이러한 축소는 데이터의 크기를 줄임과 동시에 연산 속도를 향상시켜, AI FLOPs(초당 부동소수점 연산)의 성능을 평균 1.3년마다 두 배씩 증가시키고 있습니다.

- 하지만, 데이터 타입의 간소화와 최적화에도 불구하고, 급격히 증가하는 AI 연산 요구를 완전히 충족하기에는 여전히 기술적 도전이 남아 있습니다.

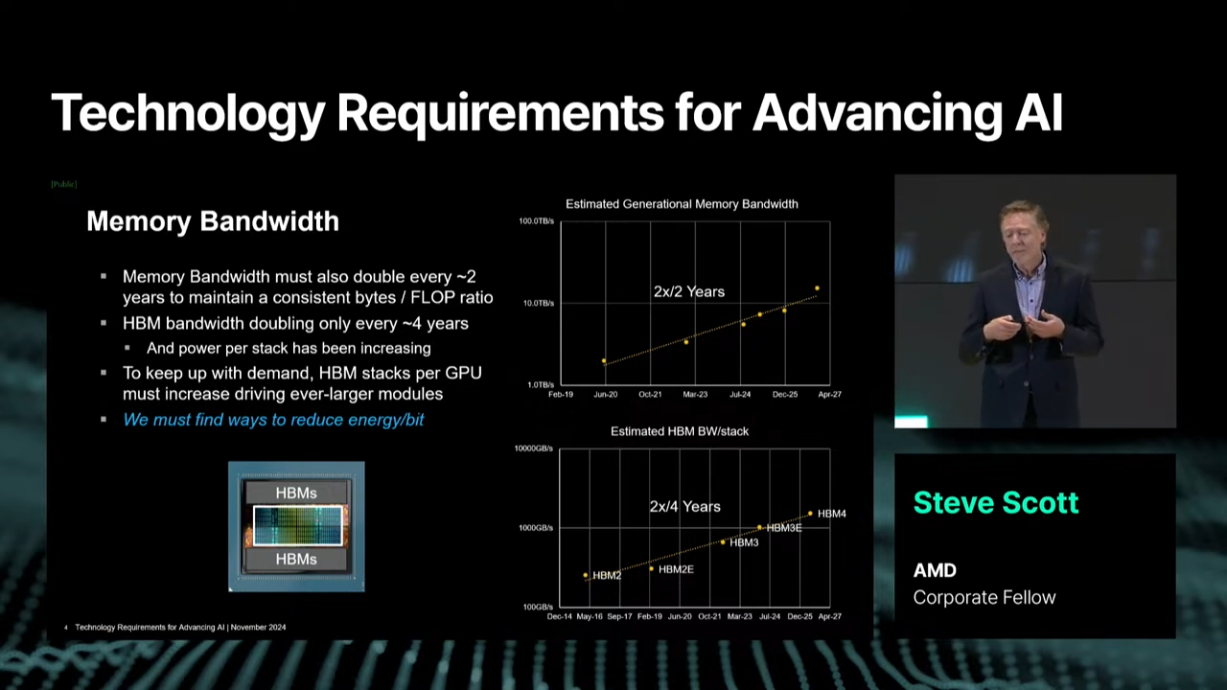

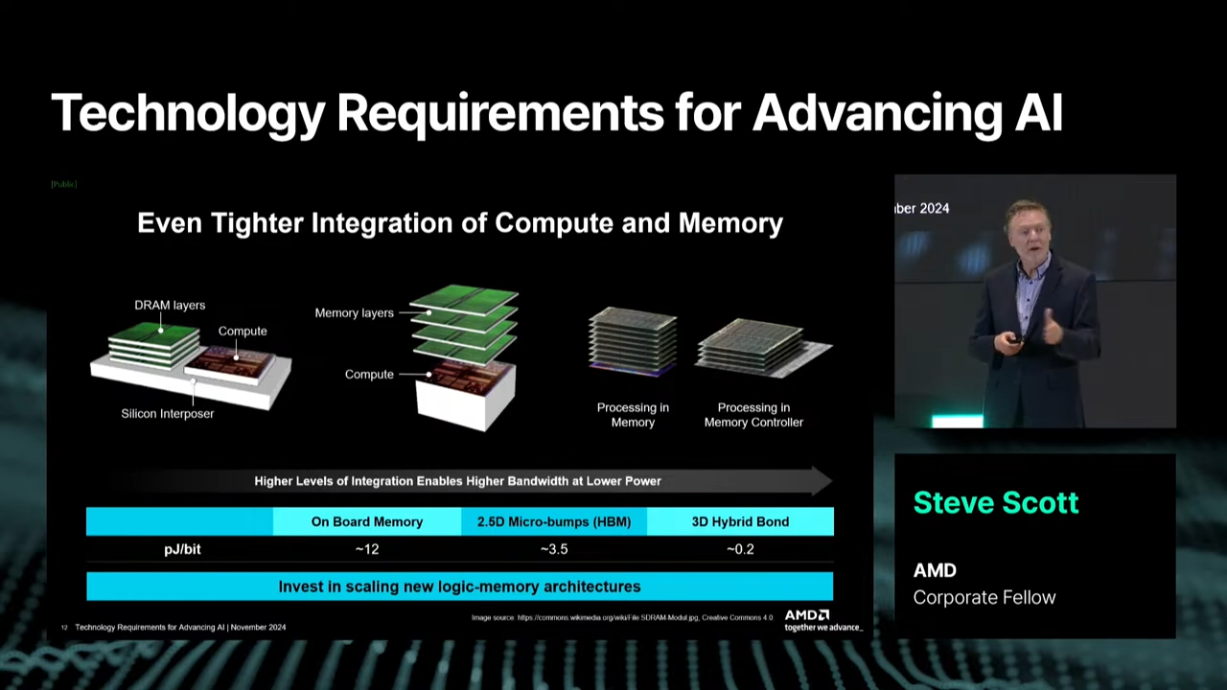

2.2. 메모리 대역폭과 에너지 소비 문제

AI 연산에서는 데이터가 이동하는 과정에서 막대한 에너지가 소비됩니다.

AMD는 이를 극복하기 위해 데이터 로컬리티(Data Locality)를 최대화하고, 데이터 이동을 줄이는 방식으로 접근하고 있습니다.

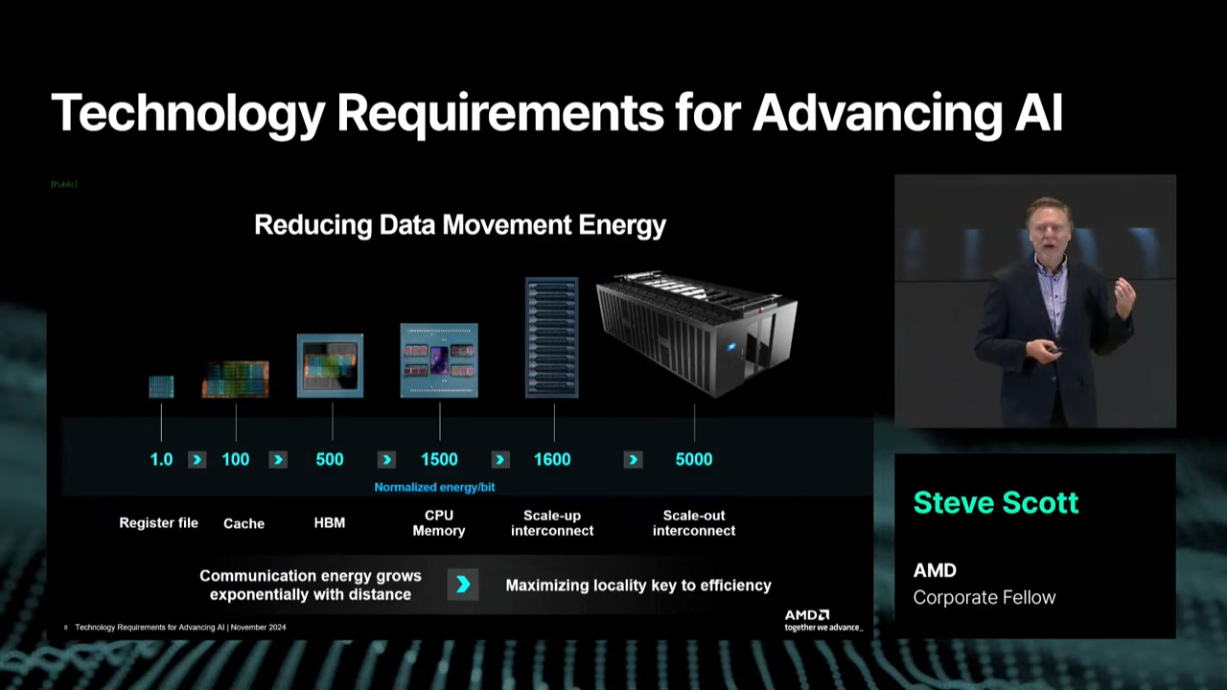

다음은 데이터 이동 단계에서 에너지 소비가 증가하는 예시입니다:

GPU 레지스터 파일에서 데이터 이동: 에너지 소비 기준을 1로 설정.캐시로 이동: 에너지 소비가 100배 증가.HBM(High Bandwidth Memory)으로 이동: 에너지 소비가 500배 증가.인터커넥트를 통한 데이터 이동: 소비량은 기하급수적으로 늘어납니다.

이를 해결하기 위해 AMD는 더 많은 데이터를 단일 SoC(System on Chip) 내에서 처리할 수 있도록 설계를 최적화하고 있습니다.

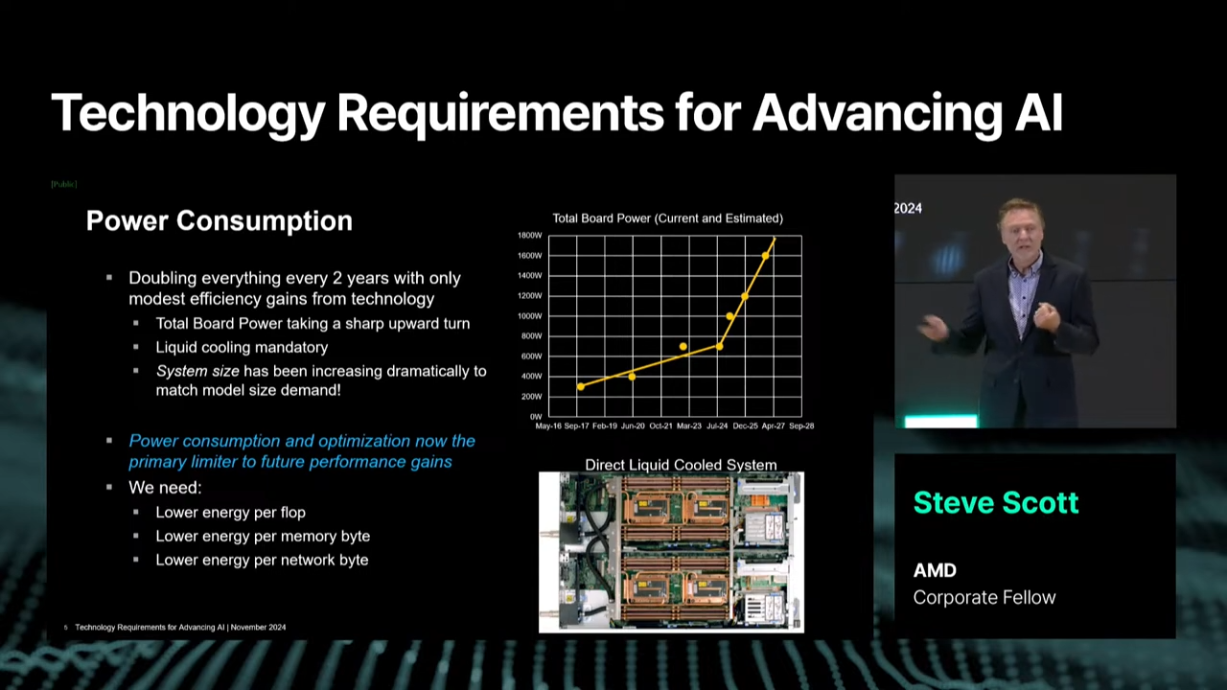

2.3. 전력 소비의 급증과 관리

AI 연산 성능의 발전은 전력 소비의 폭발적인 증가를 가져왔습니다.

특히 GPU와 메모리 간의 데이터 이동은 전력 소모의 주요 원인으로 작용하며, 데이터센터 전체에서 전력을 효율적으로 관리하지 않으면 지속 가능한 AI 기술 개발이 어려워질 수 있습니다.

- AMD는 이와 같은 전력 문제를 해결하기 위해 데이터센터 전반에 걸친 통합적이고 효율적인 접근 방식을 제안하고 있습니다.

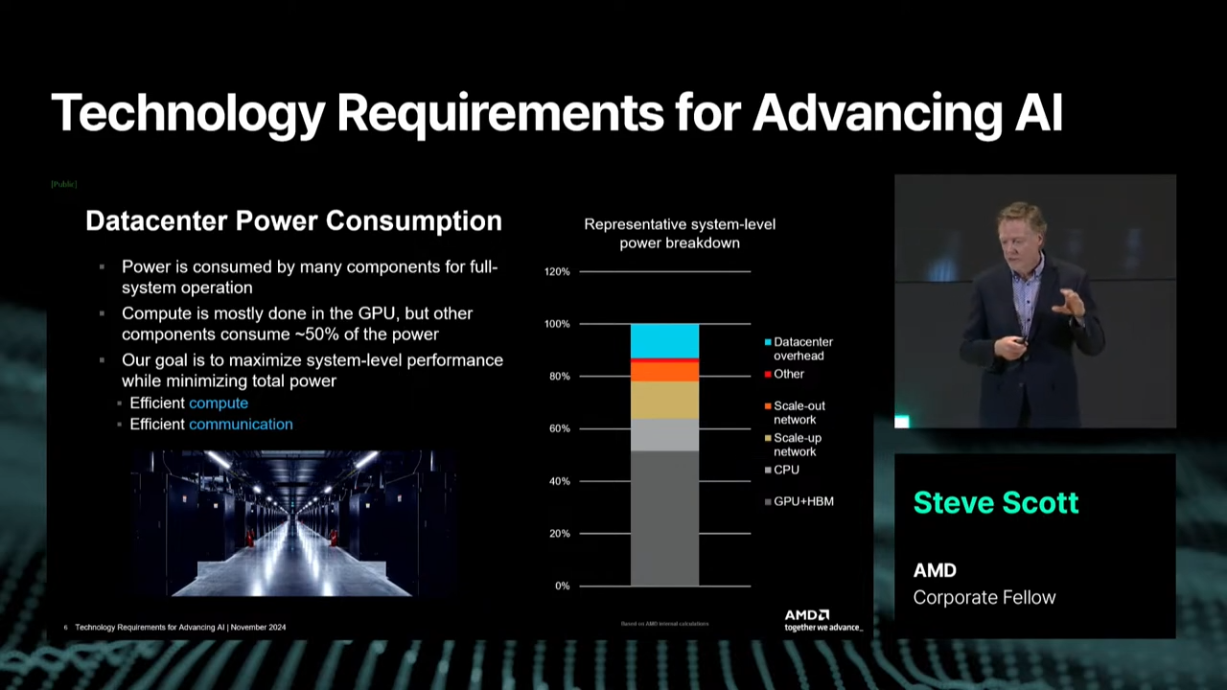

2.3.1 데이터센터에서의 전력 소비 구조

AMD의 분석에 따르면, 데이터센터의 전력 소비는 GPU와 메모리가 차지하는 비중이 약 50%에 그칩니다.

나머지 전력 소비는 CPU, 네트워크 통신, 데이터센터 오버헤드(냉각 및 전력 관리) 등 다양한 구성 요소에서 발생합니다. 이 데이터는 데이터센터의 전력 관리가 GPU 및 HBM의 최적화만으로는 해결될 수 없음을 보여줍니다.

GPU와 HBM: 50%CPU 및 네트워크 통신: 30%데이터센터 오버헤드: 20%

따라서 AMD는 GPU, CPU, 네트워크, 냉각 시스템 등 데이터센터 전체의 전력 효율성을 개선하는 통합적인 설계가 필요하다고 주장합니다.

2.3.2 데이터 이동 에너지 최적화

데이터 이동은 AI 연산에서 가장 큰 전력 소비를 유발하는 요소 중 하나입니다.

데이터가 이동하는 거리가 길수록 더 많은 에너지가 소모되며, 이를 줄이는 것이 AI 연산 효율성을 높이는 핵심 과제입니다.

-

데이터 이동 단계별 에너지 소비:

- GPU 내부 레지스터 → 캐시: 에너지 소비가 100배 증가.

- 캐시 → HBM(High Bandwidth Memory): 에너지 소비가 500배 증가.

- HBM → 인터커넥트(Network): 에너지 소비가 기하급수적으로 증가.

- 네트워크를 통한 리모트 노드와의 데이터 이동: 최악의 에너지 효율.

-

AMD의 접근법:

- 데이터 로컬리티 강화: 데이터를 이동시키는 대신, 연산이 데이터 가까이에서 이루어지도록 설계를 개선합니다.

- 이는 단일 SoC(System on Chip)에 더 많은 데이터를 통합하고, 연산 과정을 SoC 내부에서 처리하는 방식으로 구현됩니다.

-

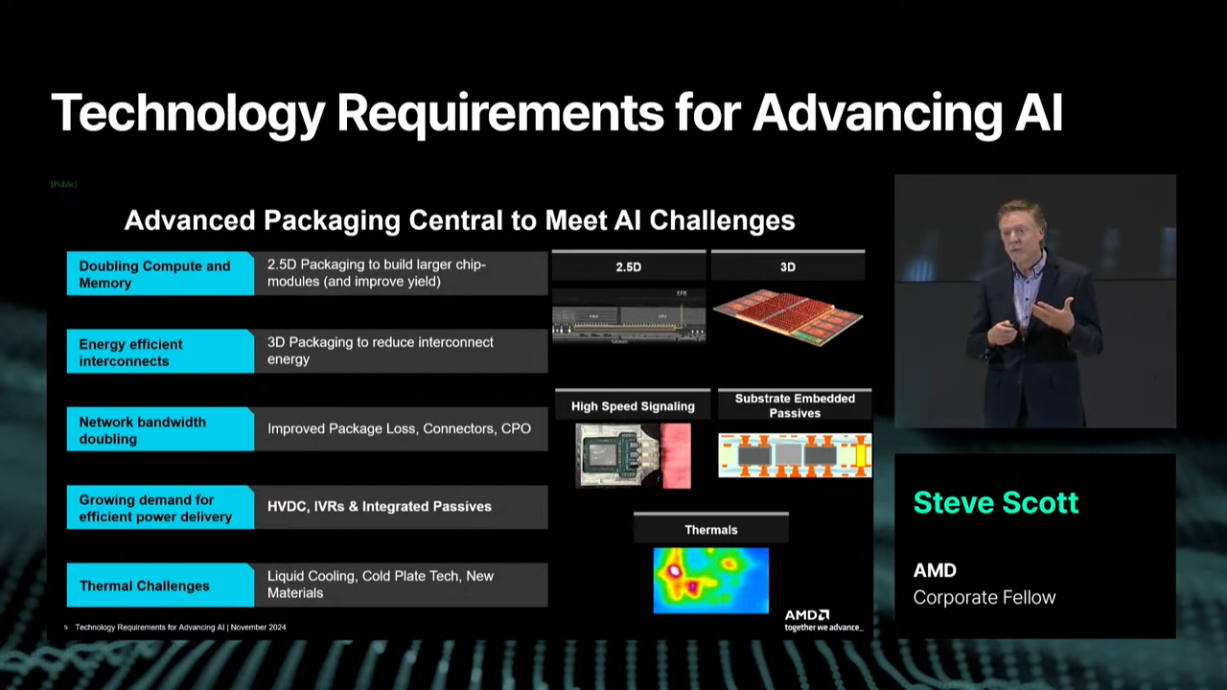

첨단 패키징 기술: 2.5D 및 3D 패키징 기술을 활용하여 데이터를 수직적으로 처리함으로써 수평 데이터 이동에서 발생하는 에너지 소비를 최소화합니다.

-

비트당 에너지 소비 절감: 데이터 전송 및 이동에서 비트당 소모되는 에너지를 줄이는 혁신 기술을 적용합니다.

- 이를 통해 데이터 이동의 전체 에너지 비용을 줄이고, 시스템의 효율성을 높입니다.

2.3.3 전력 효율적인 시스템 설계

AMD는 데이터센터의 전력 소비를 줄이기 위해 GPU와 HBM을 포함한 데이터센터의 모든 구성 요소를 아우르는 통합적인 설계를 추진하고 있습니다.

-

냉각 시스템 혁신

데이터센터 냉각에서 발생하는 에너지를 줄이기 위해 액체 냉각(Liquid Cooling) 기술이 도입되고 있습니다.- 공냉 대비 높은 효율성을 제공하며, 고성능 GPU의 열 문제를 효과적으로 해결할 수 있습니다.

-

통합 전력 관리

데이터센터의 모든 구성 요소(CPU, 네트워크, 냉각 시스템 등)에서 발생하는 전력 소비를 모니터링하고, 이를 최적화하는 시스템 설계가 요구됩니다. -

광학 기술의 도입

네트워크 통신에서 발생하는 전력 소비를 줄이기 위해 광학 기술(Optical Technology)이 점차 중요해지고 있습니다.- 이는 고속 데이터 전송을 가능하게 하며, 전력 소모를 기존 전기적 통신보다 크게 줄일 수 있습니다.

3. 첨단 패키징 기술의 중요성

AI 연산의 한계를 돌파하기 위해서는 첨단 패키징 기술이 필수적입니다. AMD는 AI 시스템의 성능을 극대화하고 데이터 이동으로 발생하는 에너지 소비를 줄이기 위해 2.5D 및 3D 패키징 기술을 적극적으로 활용하고 있습니다.

-

수직적 데이터 이동의 효율성

데이터를 수직적으로 이동시켜 수평 이동보다 더 높은 효율성을 제공합니다. 이는 데이터 이동에 드는 전력 소모를 줄이는 데 중요한 역할을 합니다. -

3D 스태킹 기술

데이터 대역폭을 높이고 에너지 효율성을 크게 향상시킵니다. 특히 데이터 로컬리티를 강화하여 SoC(System on Chip) 내부에서 더 많은 데이터를 처리할 수 있도록 설계됩니다.

3.1 첨단 패키징과 데이터 로컬리티 강화

2.5D 및 3D 패키징 기술은 단순히 데이터를 이동시키는 방식을 넘어, 데이터 로컬리티를 극대화합니다. SoC 내부에서 더 많은 데이터를 처리할 수 있도록 하여 데이터 이동 경로를 단축합니다.

이는 다음과 같은 이점을 제공합니다:

-

더 높은 데이터 대역폭 확보

수직적 데이터 이동을 통해 HBM(High Bandwidth Memory) 대역폭을 활용하며, 수평적 데이터 전송의 비효율성을 줄입니다. -

전력 소비 절감

패키징 기술을 활용하면 데이터 이동으로 인해 발생하는 에너지 손실을 줄일 수 있습니다.

3.2 네트워크 대역폭 최적화

첨단 패키징 기술의 또 다른 중요한 역할은 네트워크 대역폭을 최적화하는 것입니다. 데이터센터 내부에서 데이터를 이동할 때, 네트워크 대역폭이 중요한 병목 지점이 됩니다.

AMD는 다음과 같은 방식으로 문제를 해결하고 있습니다:

-

전기적 손실 최소화

패키지 설계에서 전기적 손실을 줄이는 소재 및 설계를 채택하여 데이터 전송 효율을 높입니다. -

네트워크 내 데이터 이동 최적화

네트워크 데이터 전송을 줄이고 로컬 데이터를 최대한 활용하여 전력 소모를 줄입니다.

3.3 광학 기술과 데이터 이동의 미래

데이터 이동은 AI 연산에서 가장 큰 에너지 소비 요인 중 하나입니다. 특히, 데이터가 GPU 레지스터에서 캐시, HBM, 네트워크를 통해 리모트 노드로 이동할수록 소비 전력은 기하급수적으로 증가합니다.

⚡️ 기존 전기적 데이터 전송 기술(동선 기반)의 문제

1.거리 제약: 전기적 신호는 전송 거리가 길어질수록 신호 감쇠와 전력 소모가 커집니다.

2.대역폭 한계: 데이터 전송량이 증가하면 더 높은 대역폭이 필요하지만, 전기적 인터커넥트로 이를 감당하기 어려워집니다.

3.발열 문제: 대량의 데이터를 전송할수록 전기적 전송선로에서 발열이 증가해 냉각 비용과 전력 소비가 커집니다.

☀️ 광학 기술이 데이터 이동 문제를 해결할 수 있는 이유

1.긴 거리에서도 효율적: 빛은 전기적 신호와 달리 긴 거리를 전송할 때 신호 감쇠가 거의 없습니다. 이를 통해 데이터센터 간, 또는 데이터센터 내에서 GPU와 다른 노드 간의 장거리 데이터 전송이 가능해집니다.

2.더 높은 대역폭 제공: 광학 기술은 기존 전기적 인터커넥트보다 훨씬 높은 데이터 전송 대역폭을 제공합니다. 이는 AI 연산에서 증가하는 데이터 처리량을 지원하는 데 필수적입니다.

3.낮은 전력 소모: 전기적 인터커넥트는 데이터 전송 속도가 빨라질수록 전력 소비가 급격히 증가하는 반면, 광학 기술은 빛을 사용해 데이터를 전송하므로 비트당 전력 소모를 크게 줄일 수 있습니다.

AMD는 데이터 이동 문제를 해결하고 AI 시스템의 에너지 효율성을 높이기 위해 광학 기술(Optical Technology)을 활용하고 있습니다.

구체적으로 다음과 같은 전략을 제시합니다:

-

Co-packaged Optics:

- 칩과 광학 모듈을 함께 패키징하여 데이터 이동 경로를 최소화하고 전력 소모를 줄입니다.

-

표준화된 설계:

- 광학 기술을 대량으로 제조하고 상용화하기 위해 인터커넥트의 표준화 및 제조 공정을 자동화합니다.

-

광학 대역폭 활용:

- 광학 기술의 높은 대역폭을 통해 데이터 이동 병목을 해소하고, 더 큰 데이터 처리량을 지원합니다.

4. AI 컴퓨팅의 통합 설계 접근법

AMD는 AI 컴퓨팅의 미래를 위해 하드웨어와 소프트웨어의 통합 설계를 강조합니다.

이는 다음과 같은 방식으로 이루어집니다:

-

계층적 설계

실리콘, 보드, 데이터센터 수준에서 모든 계층을 통합적으로 설계하여 효율성을 극대화합니다. -

전력 소비와 성능의 균형

성능 향상과 에너지 효율성 간의 균형을 맞추기 위해 데이터 이동, 냉각 기술, 광학 기술을 최적화합니다.

5. 업계 협력

AI 기술의 지속 가능한 발전과 확장은 단독 기업의 노력만으로 이루어질 수 없습니다. AMD는 업계 간 협력이 AI 기술 생태계의 발전을 가속화하고, 현재의 기술적 한계를 극복하는 핵심 요소라고 강조합니다.

이를 통해 에너지 효율성, 성능, 비용 절감 등의 문제를 해결할 수 있습니다.

5.1. 업계 협력이 필요한 이유

-

복잡한 기술 문제 해결

- AI 기술은 연산 성능, 데이터 이동 효율성, 전력 관리 등 다양한 분야에서 고도화된 기술적 요구를 가지고 있습니다.

- 특히, 광학 기술, 첨단 패키징 기술, 냉각 기술 등의 혁신은 단일 기업이 모든 문제를 해결하기에 과도한 비용과 자원을 요구합니다.

-

표준화의 필요성

- AI 하드웨어와 소프트웨어의 상호 운용성을 보장하려면 업계 전반의 표준화가 필수적입니다.

- 표준화된 인터페이스와 프로토콜은 기술 개발 속도를 높이고, 생태계 전반의 협업을 강화합니다.

-

비용 절감 및 대량 생산 가능성

- 광학 기술과 같은 고난이도 기술은 초기 개발 비용이 높고 대량 생산이 어렵습니다. 협력을 통해 제조 공정을 표준화하고, 생산을 자동화하면 이러한 문제를 완화할 수 있습니다.

-

빠른 혁신 주기

- AI 기술은 빠른 속도로 발전하고 있으며, 기업들이 협력하지 않으면 변화하는 기술적 요구에 적시에 대응하기 어렵습니다.

5.2. AMD의 협력 전략

-

개방형 에코시스템 구축

- AMD는 표준화된 인터페이스와 개방형 에코시스템을 통해 다양한 기업과의 협력을 장려하고 있습니다.

- 이는 하드웨어, 소프트웨어, 데이터센터 설계 전반에서 상호 운용성을 극대화하고, 생태계의 확장을 돕습니다.

-

광학 기술에서의 협력

- AMD는 광학 기술을 대량 생산하고 상용화하기 위해 업계 표준을 수립하고, 자동화된 제조 공정을 도입하고자 합니다.

- 이는 비용을 줄이고, 고성능 데이터센터의 요구를 충족할 수 있는 기술 개발을 가속화합니다.

-

냉각 기술에서의 협력

- 고성능 GPU와 데이터센터의 냉각 문제를 해결하기 위해 액체 냉각(Liquid Cooling) 기술 도입에 대한 협력을 확대하고 있습니다.

- 이 기술은 데이터센터 운영 비용을 줄이고 전력 소비를 크게 절감할 수 있습니다.

-

AI 소프트웨어와 알고리즘 설계 협력

- AMD는 AI 소프트웨어 개발 기업과 협력하여 하드웨어와 소프트웨어 간의 최적화를 도모합니다.

- 이를 통해 하드웨어가 알고리즘의 연산 요구를 충족하도록 설계되고, 에너지 효율성도 높아질 수 있습니다.

12. Rethinking Silicon at the Dawn of the AI Era

- 발표자: Mohamed Awad (Arm SVP)

- 내용: AI 시대에 맞춰 실리콘 반도체 기술의 재구성 필요성.

1. AI의 도전 과제: 연산 능력과 에너지 문제

AI 모델이 발전하면서 연산 성능과 에너지 소비 문제는 점점 심각해지고 있습니다.

- 예를 들어, GPT-3에서 GPT-4로의 전환 과정에서 파라미터 수가 수백억 개에서 수조 개로 폭발적으로 증가했습니다.

- 이처럼 AI 모델이 고도화될수록 더 많은 연산 능력과 에너지가 요구되며, 이러한 증가 추세는 계속될 전망입니다.

현재 데이터센터는 막대한 전력을 소비하고 있으며, 글로벌 데이터센터의 전력 소비량은 이미 독일 국가 전체의 전력 사용량을 넘어섰습니다. 😅

- 2030년이 되면 인도 전체 전력 소비량에 맞먹을 것으로 예상됩니다.

- 이 같은 상황에서 1GW(기가와트)급 AI 데이터센터의 건설은 필수적이지만, 이는 일반 가정에 전력을 공급할 수준의 막대한 전력을 소모하게 됩니다.

- 따라서 AI의 미래를 위해서는 에너지 효율성과 지속 가능성 문제가 시급히 해결되어야 합니다.

2. AI를 위한 에너지 효율적 설계: ARM의 철학

ARM은 35년 전 창립 초기부터 에너지 효율성을 핵심 철학으로 삼아왔습니다. 창립 초기, ARM은 초저전력 설계 덕분에 배터리로도 구동이 가능한 프로세서를 선보였고, 이 철학은 오늘날까지 이어지고 있습니다.

-

ARM 기반의 아키텍처는 전력 효율성을 극대화하며, 전 세계적으로 3천억 개 이상의 기기에 활용되고 있습니다.

-

이와 같은 설계 철학 덕분에 ARM은 에너지 효율성 문제 해결의 선두에 서 있으며, 스마트폰, 모바일 기기, 데이터센터 등 다양한 분야에서 활발히 활용되고 있습니다.

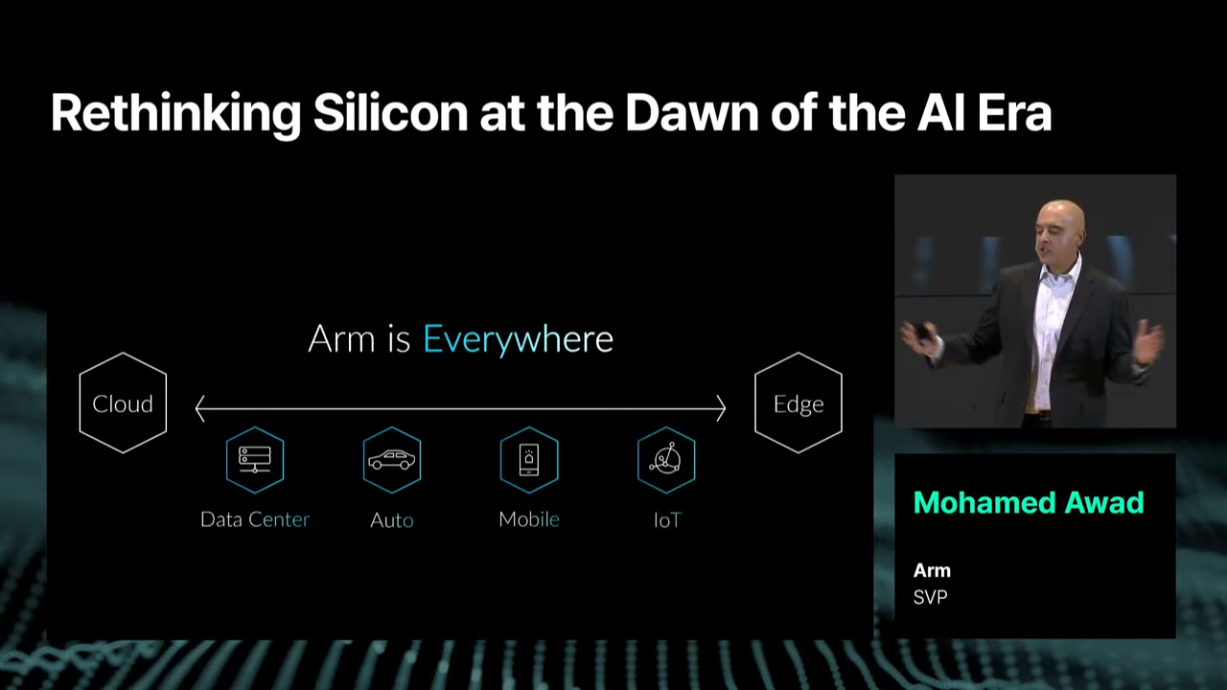

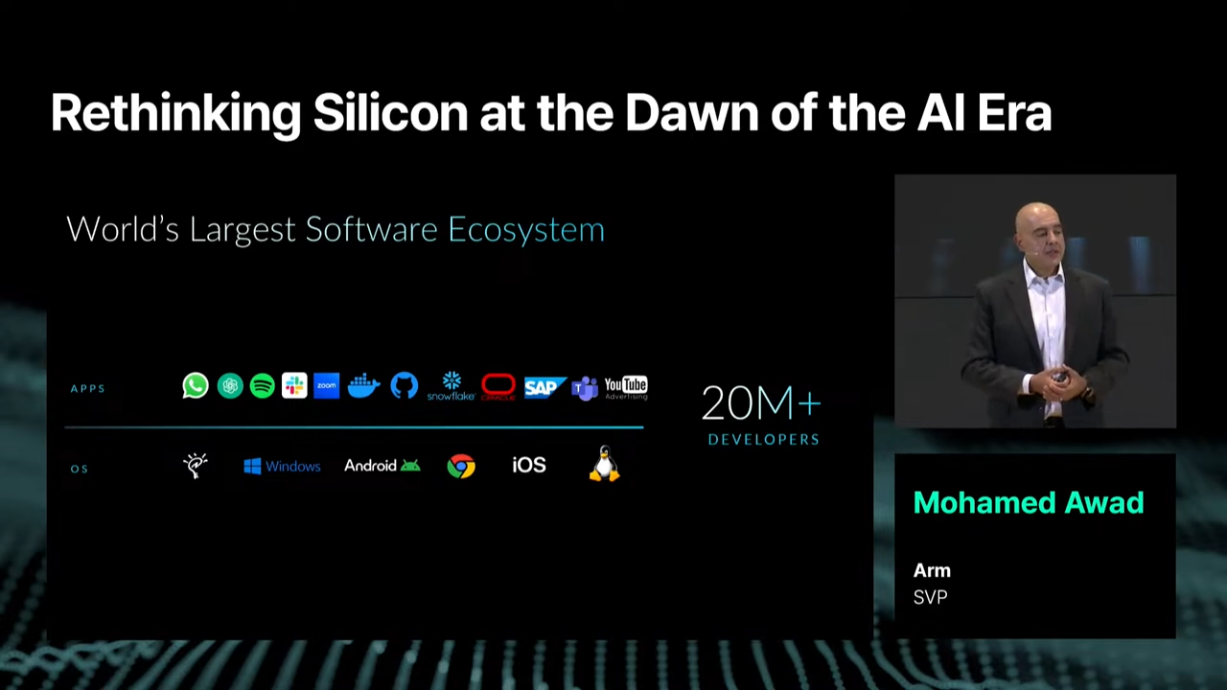

3. ARM이 어디에나 있다: ARM 생태계의 확장성

ARM은 클라우드부터 엣지까지, 전 세계 어디서나 찾아볼 수 있는 기술로 자리 잡았습니다. ARM의 아키텍처는 데이터센터, 자동차, 모바일 기기, IoT(사물인터넷) 등 다양한 분야에서 핵심적인 역할을 하고 있습니다. ARM 생태계는 그 폭넓은 적용성과 유연성을 기반으로 여러 산업군에서 새로운 가능성을 열어주고 있습니다.

ARM은 자동차 분야에서는 자율주행 시스템과 차량 내 센서 네트워크를 지원하며, 모바일 기기에서는 배터리 효율성과 고성능을 동시에 제공하고 있습니다. IoT와 같은 엣지 장치에서는 초저전력 설계를 통해 배터리 수명을 연장시키는 데 기여하고 있습니다. 이처럼 ARM은 다양한 기기와 서비스의 중심에 자리하며 혁신을 주도하고 있습니다.

ARM은 AI 데이터센터 혁신에서 중요한 역할을 하고 있으며, 이는 세계 최대 규모의 소프트웨어와 하드웨어 협력 네트워크를 통해 가능해졌습니다. ARM 생태계는 데이터센터를 효율적으로 설계하고 최적화할 수 있도록 다양한 파트너와 협력하며, 하이퍼스케일러(예: NVIDIA, 구글, 마이크로소프트)와의 통합적 접근 방식을 채택하고 있습니다.

4. ARM 생태계와 데이터센터 혁신

ARM은 AI 데이터센터 혁신에서 중요한 역할을 하고 있으며, 이는 세계 최대 규모의 소프트웨어와 하드웨어 협력 네트워크를 통해 가능해졌습니다. ARM 생태계는 데이터센터를 효율적으로 설계하고 최적화할 수 있도록 다양한 파트너와 협력하며, 하이퍼스케일러(예: NVIDIA, 구글, 마이크로소프트)와의 통합적 접근 방식을 채택하고 있습니다.

4.1. 데이터센터 혁신

데이터센터 혁신은 AI의 대규모 연산 수요와 에너지 문제를 해결하기 위해 ARM과 주요 기업들이 협력하여 실현되고 있습니다.

- 예를 들어, NVIDIA의 GPU와 CPU를 통합한 시스템 설계는 데이터 전송 비용과 전력 소비를 대폭 줄이는 데 성공했습니다.

- 이와 같은 맞춤형 실리콘 설계는 데이터센터에서 에너지 효율성을 극대화하며, AI 모델의 고도화된 연산 요구를 충족시킬 수 있도록 돕습니다.

ARM은 단순히 하드웨어 제공자에 그치지 않고, 데이터센터의 전력 효율성과 성능 최적화를 위한 시스템 접근 방식을 채택하여 소프트웨어 생태계와 통합적 혁신을 이끌어가고 있습니다.

4.2. ARM 생태계

ARM 생태계는 클라우드에서 엣지까지 모든 컴퓨팅 영역에 걸쳐 확장되고 있습니다.

- 2천만 명 이상의 개발자가 ARM 아키텍처를 기반으로 새로운 애플리케이션과 시스템을 개발하며, 이러한 협업은 하드웨어와 소프트웨어의 선순환 구조를 이루고 있습니다.

이 생태계는 단순한 플랫폼을 넘어 AI와 데이터 처리 기술의 발전을 가속화하며, 다양한 산업 분야에서 새로운 가능성을 열어줍니다.

- ARM의 지속적인 투자와 개발자 커뮤니티의 확장은 생태계를 더욱 강력하게 만들고 있으며, 하드웨어와 소프트웨어의 동반 성장을 촉진하고 있습니다.

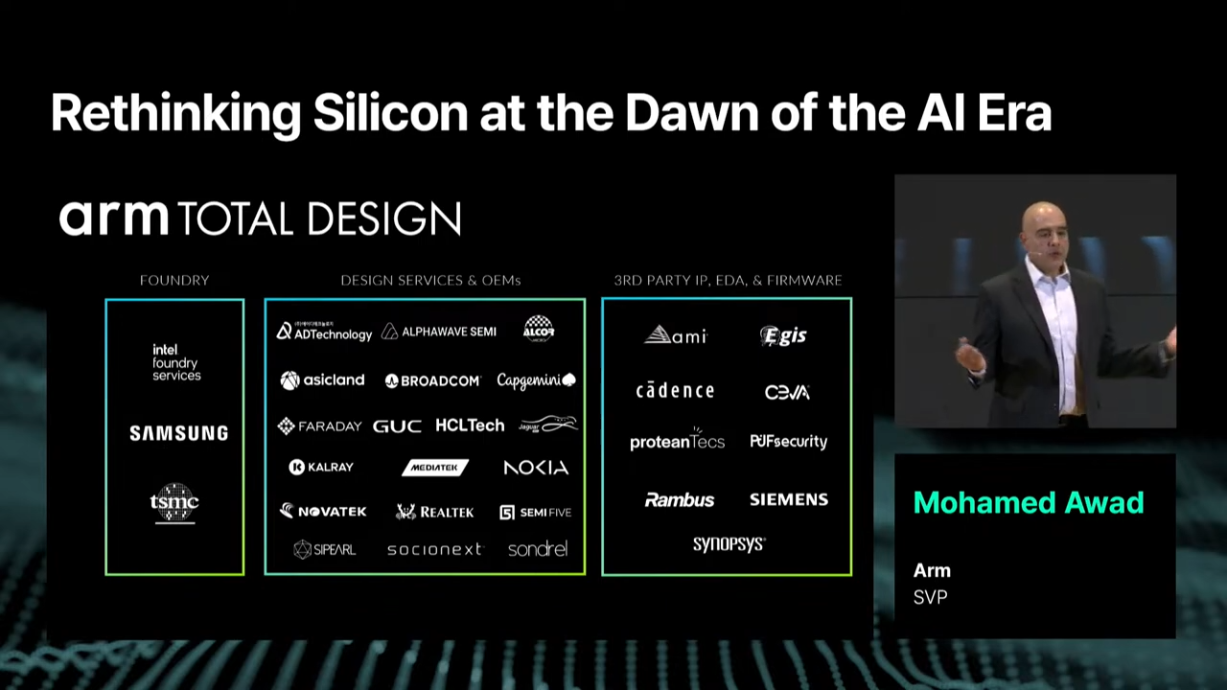

5. ARM Total Design: 협력의 새로운 패러다임

AI 생태계 내에서 협력을 강화하기 위해 ARM은 ARM Total Design이라는 플랫폼을 선보였습니다.

- 이 플랫폼은 서드파티 IP, 디자인 서비스, OEM(주문자 상표 부착 생산), 파운드리 등 다양한 파트너사를 통합하여 최적화된 솔루션을 제공합니다.

이를 통해 ARM은 파트너들이 고성능 AI 시스템을 더욱 효율적으로 설계할 수 있도록 돕고 있으며, 하드웨어 및 소프트웨어 생태계를 아우르는 전반적인 기술 혁신을 촉진하고 있습니다.

(후기) 많은 세션들이 공통적으로 AI와 협력, 생태계 등을 키워드로 잡고 있는 것이 인상적이었습니다. ARM 역시 ARM Total Design이라는 협력 플랫폼을 통해 AI 생태계에서의 생존 전략을 펼치고 있는 것이 인상적이었습니다.

13. 패널토의: AI 반도체와 인프라의 진화

- 참여자: Steve Scott (AMD Corporate Fellow), Mohamed Awad (Arm SVP), Bryan Black (Chipletz CEO & Chairman), 이강욱 (SK하이닉스 부사장), Gary Grider (Los Alamos National Laboratory, HPC Division Leader, Moderator)

- 내용: AI 반도체 기술의 진화와 인프라의 발전 방향.

1. 미래 AI 칩과 인프라의 진화: 전문가 패널 토론

AI 기술이 발전하면서, 이를 뒷받침하는 AI 칩과 인프라가 점점 더 중요해지고 있습니다. 이번 블로그에서는 최근 열린 패널 토론에서 논의된 AI 칩의 발전 방향과 기술적 과제를 정리해보겠습니다.

- 이 패널에는 AMD의 Steve Scott, ARM의 Mohamed Awad, Chipletz의 Bryan Black, SK하이닉스의 이강옥 부사장이 참여했으며, Los Alamos National Laboratory의 Gary Grider가 진행을 맡았습니다.

2. AI 칩의 현재와 미래 전망

패널은 AI 칩의 발전이 우리의 일상과 산업 전반에 미치는 영향에 대해 이야기를 나눴습니다. AMD의 Steve Scott는 AI가 기존 슈퍼컴퓨터와 비교할 수 없을 정도로 큰 규모와 영향력을 가지고 있다고 강조했습니다.

-

AI의 추론과 훈련에 필요한 연산 자원과 메모리 대역폭이 과거보다 기하급수적으로 증가하면서, 이를 지원하기 위한 데이터 센터와 하드웨어 기술의 혁신이 필수적이라는 점이 논의되었습니다.

-

SK하이닉스의 이강옥 부사장은 반도체 패키징 기술이 AI 발전의 핵심이며, 특히 HBM(High Bandwidth Memory) 기술이 중요하다고 말했습니다. 그는 AI가 새로운 비즈니스 기회를 창출할 뿐 아니라 전통적인 산업 혁신에도 기여하고 있다고 강조했습니다.

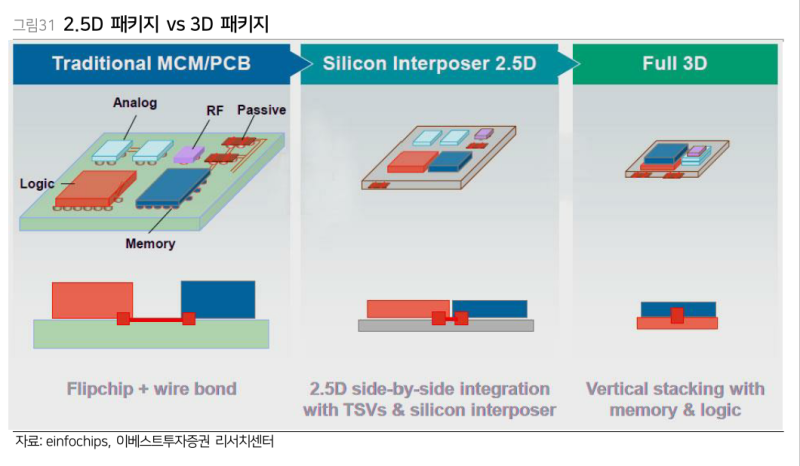

3. 2.5D와 3D 패키징의 차이와 미래

Bryan Black은 2.5D와 3D 패키징 기술의 차이를 설명하며, 두 기술이 각각 다른 문제를 해결한다고 언급했습니다.

- 2.5D 패키징: 실리콘 인터포저를 사용하여 칩 간 신호 전달을 최적화합니다. 이 방식은 열 관리를 비교적 용이하게 하며, 고성능 컴퓨팅과 AI 가속기에 적합합니다.

- 3D 패키징: 칩을 수직으로 쌓아 더 높은 집적도를 제공합니다. 그러나 열 관리의 복잡성과 비용이 높다는 단점이 있습니다.

이미지 출처 ㅣ 이베스트 투자증권 리서치센터

이강옥 부사장은 HBM과 같은 3D 기술이 AI 모델의 성장에 대응하기 위한 핵심이지만, 패키징 기술의 추가적인 혁신이 필요하다고 강조했습니다.

- 특히 유리 기판과 같은 새로운 소재가 미래의 가능성을 열어줄 것으로 전망했습니다.

4. GPU와 가속기, 그리고 추론 아키텍처

Steve Scott와 Mohamed Awad는 AI 모델의 추론과 훈련에서 GPU와 가속기의 역할을 논의했습니다.

- Scott은 클라우드 환경에서는 GPU가 훈련과 추론 모두에 적합하지만, 엣지 디바이스에서는 더 경량화된 저전력 가속기가 필요하다고 설명했습니다.

Mohamed Awad는 "GPU"라는 용어가 너무 일반화되어 있다고 지적하며, 특정 작업에 최적화된 가속기의 필요성을 강조했습니다.

- 특히 모바일 기기와 같은 엣지 환경에서는 추론을 위한 가속기가 다양해질 것이라고 덧붙였습니다.

5. 전력 소모와 냉각: AI 인프라의 최대 과제

AI 인프라에서 전력 소모와 냉각 문제는 중요한 도전 과제로 떠오르고 있습니다.

-

Mohamed Awad는 데이터 센터가 과거보다 더 복잡한 방식으로 설계되고 있으며, 각각의 구성 요소 간 최적화가 필요하다고 언급했습니다. 그는 냉각 기술과 전력 효율성을 개선하기 위한 다양한 접근이 필요하다고 강조했습니다.

-

Steve Scott는 데이터 전송 비용을 줄이는 것이 메모리와 전력 효율성을 높이는 핵심이라고 덧붙였습니다. 그는 메모리를 효율적으로 관리하는 기술이 AI 인프라의 중요한 역할을 할 것이라고 강조했습니다.

6. 칩렛 기술과 Co-디자인의 중요성

Bryan Black은 칩렛(Chiplet) 기술의 잠재력을 논의하며, 무어의 법칙의 한계를 극복하기 위한 대안으로 칩렛이 주목받고 있다고 말했습니다. 그는 칩 간 인터페이스 비용이 존재하지만, 모듈화와 재사용 가능성, 에너지 효율성에서 큰 이점을 제공한다고 설명했습니다.

Mohamed Awad는 칩렛 기술이 경제성과 맞춤형 실리콘 설계를 지원하며, 이를 통해 다양한 애플리케이션의 요구를 충족시킬 수 있다고 강조했습니다. 그는 이러한 기술이 향후 AI 칩의 발전에 필수적이라고 덧붙였습니다.

7. 협업과 혁신을 통한 AI 기술 발전

패널들은 AI 기술 발전을 위해 업계와 정부 간 협력이 중요하다고 입을 모았습니다. Steve Scott는 오픈 하드웨어와 오픈 소프트웨어, 그리고 협력을 통해 모든 이들이 혜택을 얻는 생태계를 구축해야 한다고 강조했습니다. 또한, AI의 발전 속도를 따라잡기 위해 다양한 기업들이 협력하며 혁신적인 솔루션을 개발해야 한다고 말했습니다.

Mohamed Awad는 AI의 잠재력을 실현하기 위해서는 생태계 전반에서 실패를 두려워하지 않고 도전해야 한다고 제안했습니다.

(후기) 이번 패널 토론은 AI 칩과 인프라의 발전 방향을 논의하며, 기술적 과제와 협력의 중요성을 강조했습니다.

반도체쪽 지식이 부족해서 힘들었지만...ㅎ지속적인 혁신과 협력을 통해 더 나은 미래를 만들어가야 한다는 것을 강조했습니다.

14. Perplexity의 AI 검색으로 더욱 탐구적이고 효율적인 세상 만들기

- 발표자: Aravind Srinivas (Perplexity 공동창립자, CEO)

- 내용: Perplexity의 AI 검색 기술로 정보 탐구와 효율성을 높이는 방안.

장시간의 세미나로 지쳐가던 찰나에 드디어 기다리던 Perplexity의 CEO의 마지막 세션이라 꾹 참고 달려보았습니다 🔥🔥

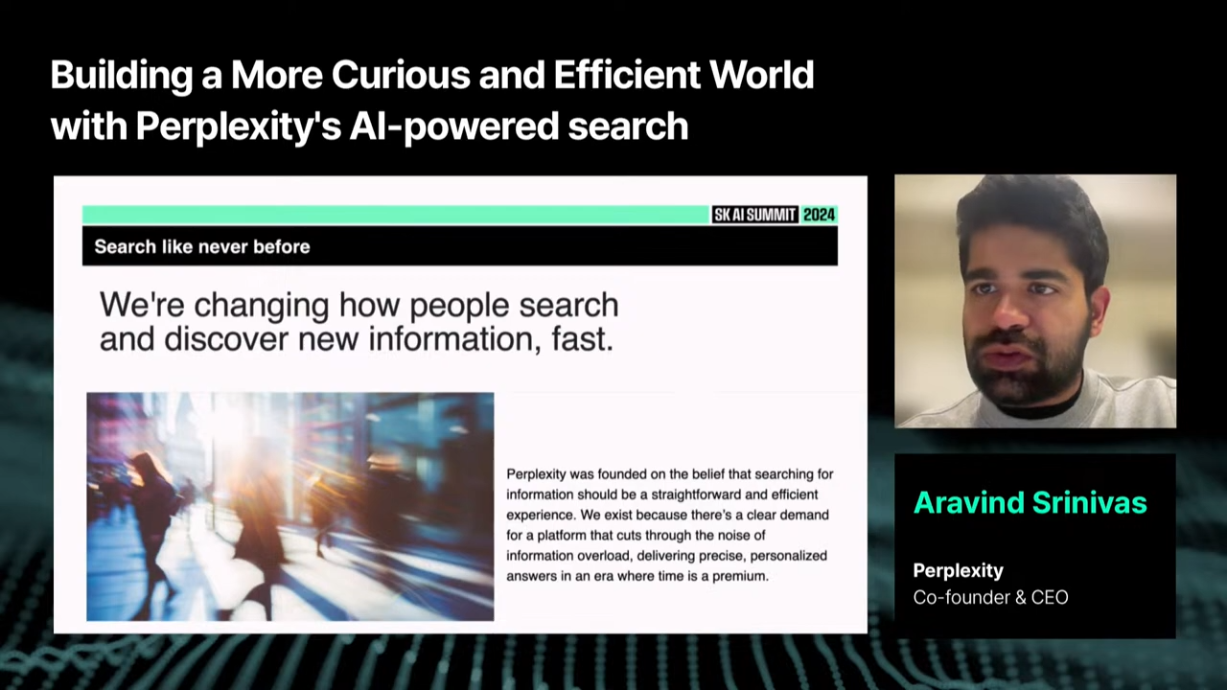

1. 검색의 변곡점: 새로운 패러다임의 시작

퍼플렉시티는 이러한 문제를 해결하기 위해 탄생했습니다. 공동창립자인 아라빈드 스리니바스(Aravind Srinivas)는 "AI 검색을 통해 사람들이 보다 탐구적이고 효율적인 세상을 경험하도록 돕겠다"는 목표를 내세우며 퍼플렉시티의 비전을 소개했습니다.

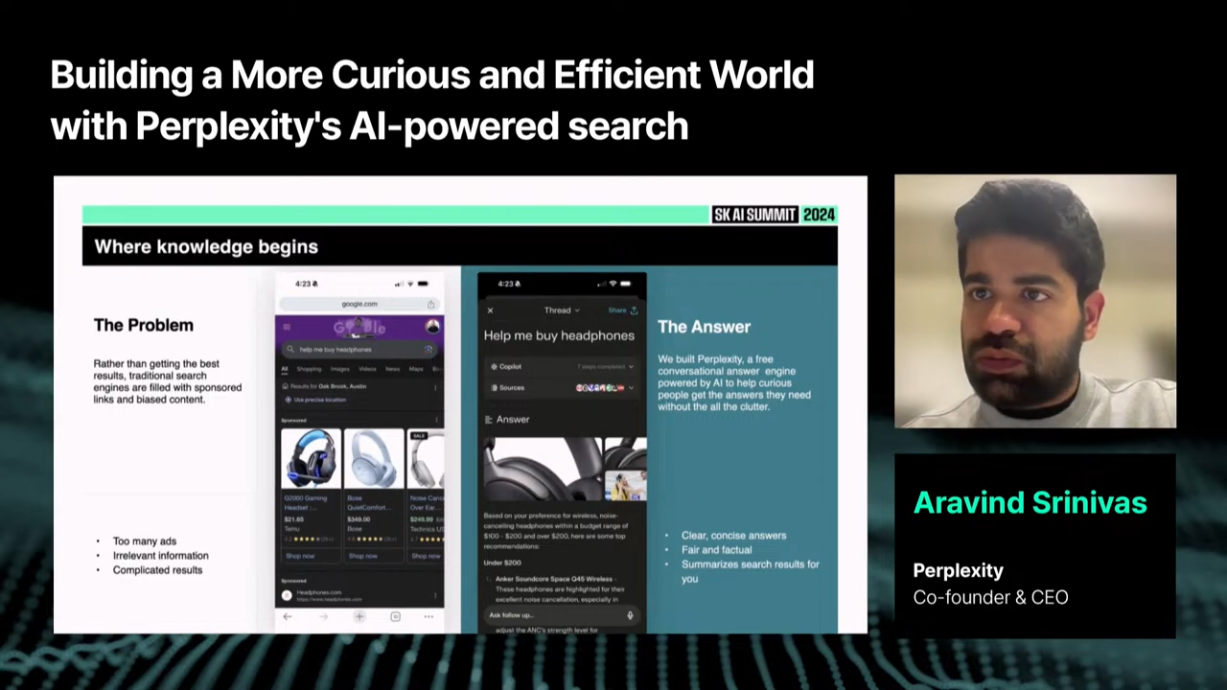

2. 광고와 스팸 없는 간단한 검색 경험

퍼플렉시티는 검색 결과를 간결하고 명확하게 제공하는 데 중점을 둡니다. 이 플랫폼은 정보의 출처를 명확히 밝히고, 개인화된 답변을 제공함으로써 사용자 경험을 혁신하고 있습니다.

사용자들이 복잡한 검색 결과에 압도되지 않도록 불필요한 광고와 스팸을 배제한 결과, 퍼플렉시티는 신뢰성과 효율성을 동시에 만족시키는 검색 도구로 자리 잡았습니다.

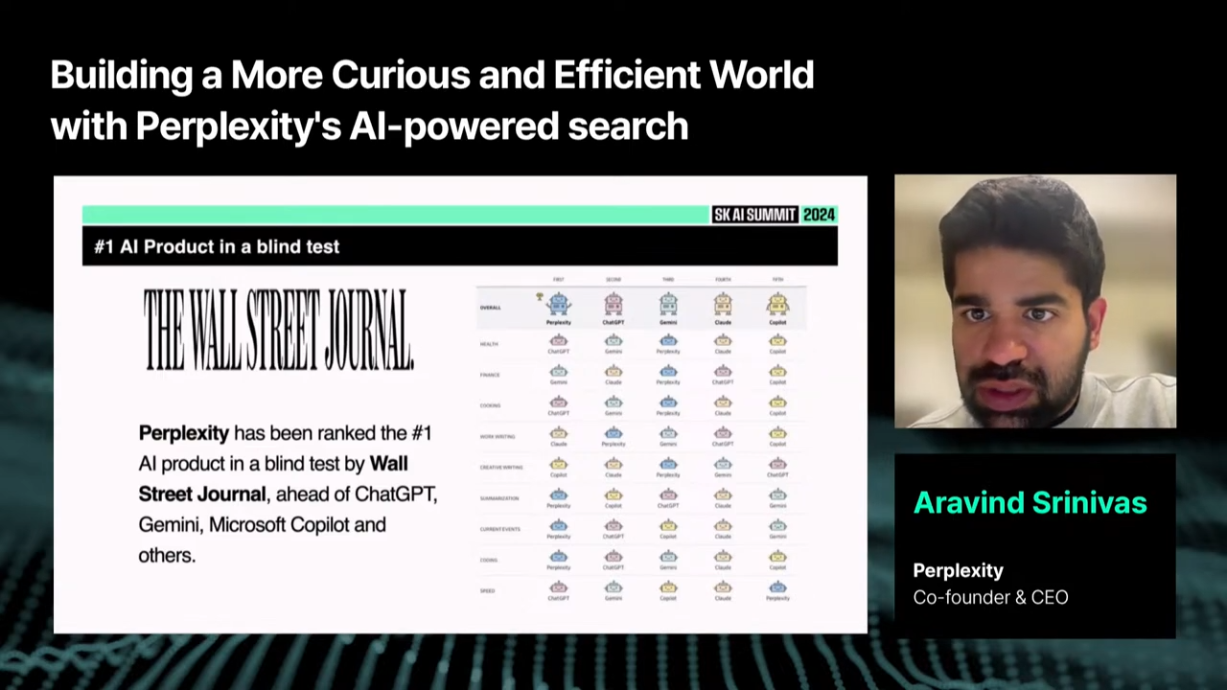

3. AI 성능의 새로운 기준: 블라인드 테스트 1위

퍼플렉시티는 의료, 금융, 요리, 창의적 글쓰기, 약물 요약, 시사 등 다양한 카테고리에서 경쟁 제품을 뛰어넘는 성과를 거두며 블라인드 테스트에서 1위를 차지했습니다.

단순히 정보를 나열하는 것이 아니라, 질문의 맥락을 파악하고 최적의 답을 찾아내는 능력 덕분에 이와 같은 성과를 거둘 수 있었습니다.

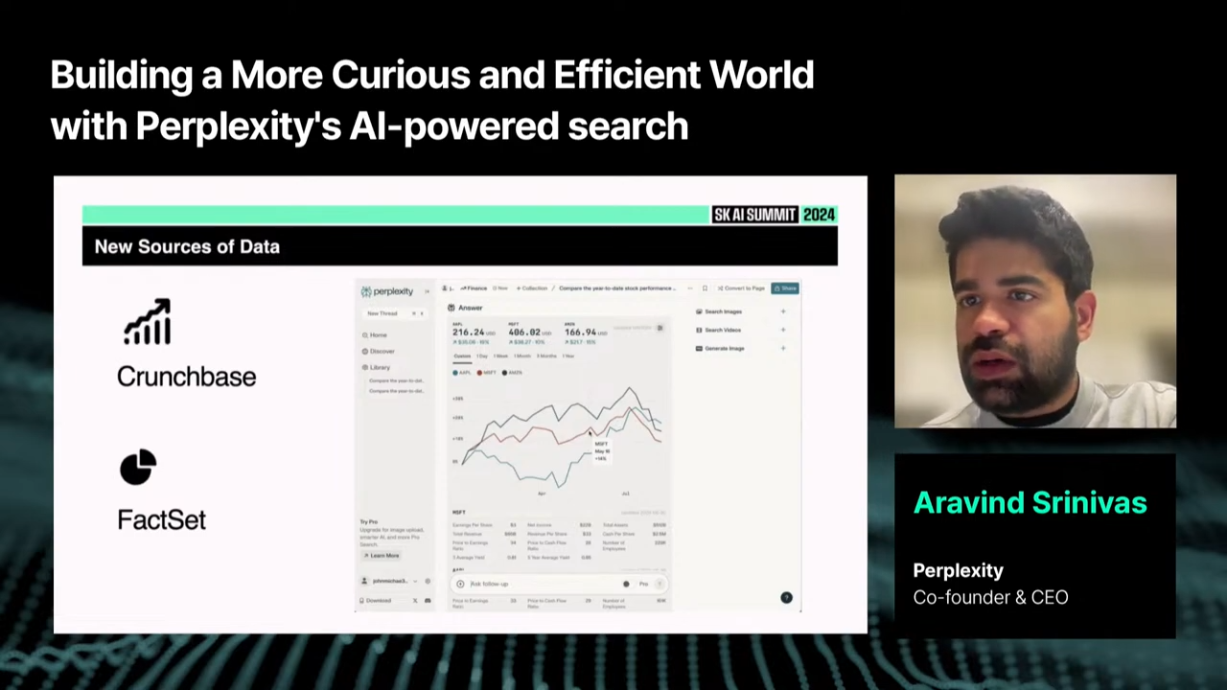

4. 시각화와 사용자 친화적인 정보 전달

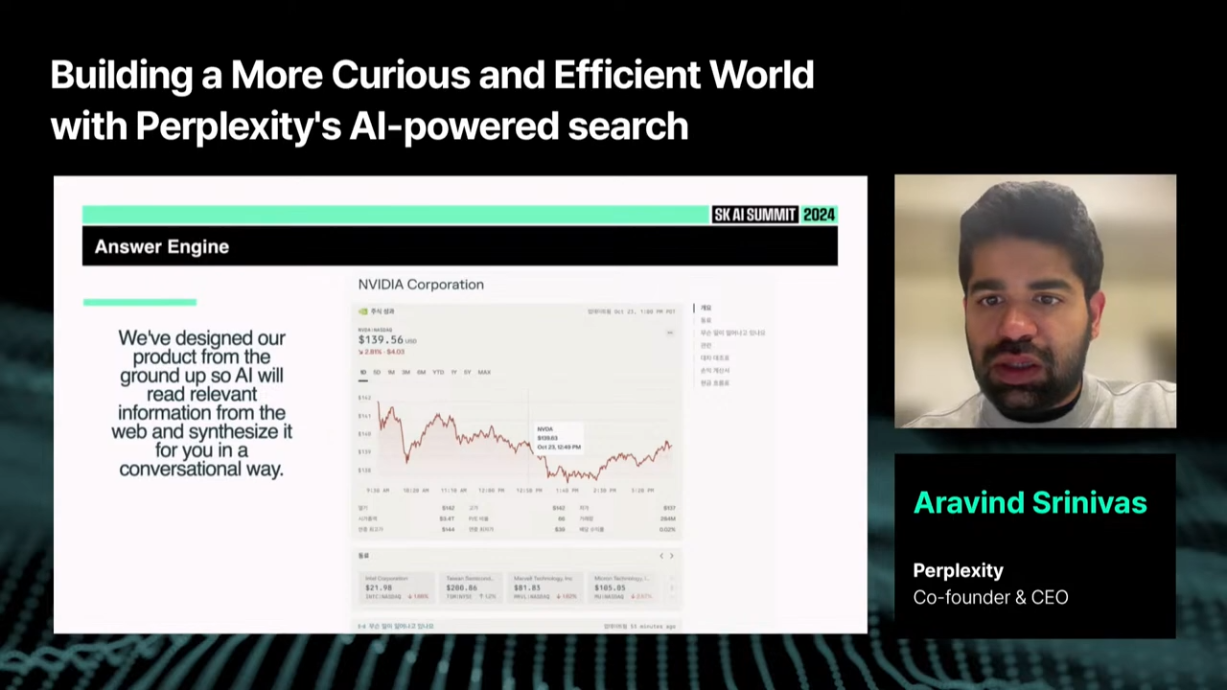

퍼플렉시티는 단순한 텍스트 응답에 그치지 않고, 데이터를 시각화하여 사용자에게 제공합니다.

- 예를 들어, 사용자가 특정 주식의 동향을 검색하면 차트 형태로 주가 흐름을 확인할 수 있습니다.

- 이는 사용자가 더 직관적으로 정보를 이해하고, 의사결정을 내리는 데 큰 도움을 줍니다.

이러한 시각화 기능은 특히 복잡한 금융 데이터나 시사 이슈를 분석할 때 유용합니다.

5. 복잡한 질문도 손쉽게 해결하는 검색 도우미

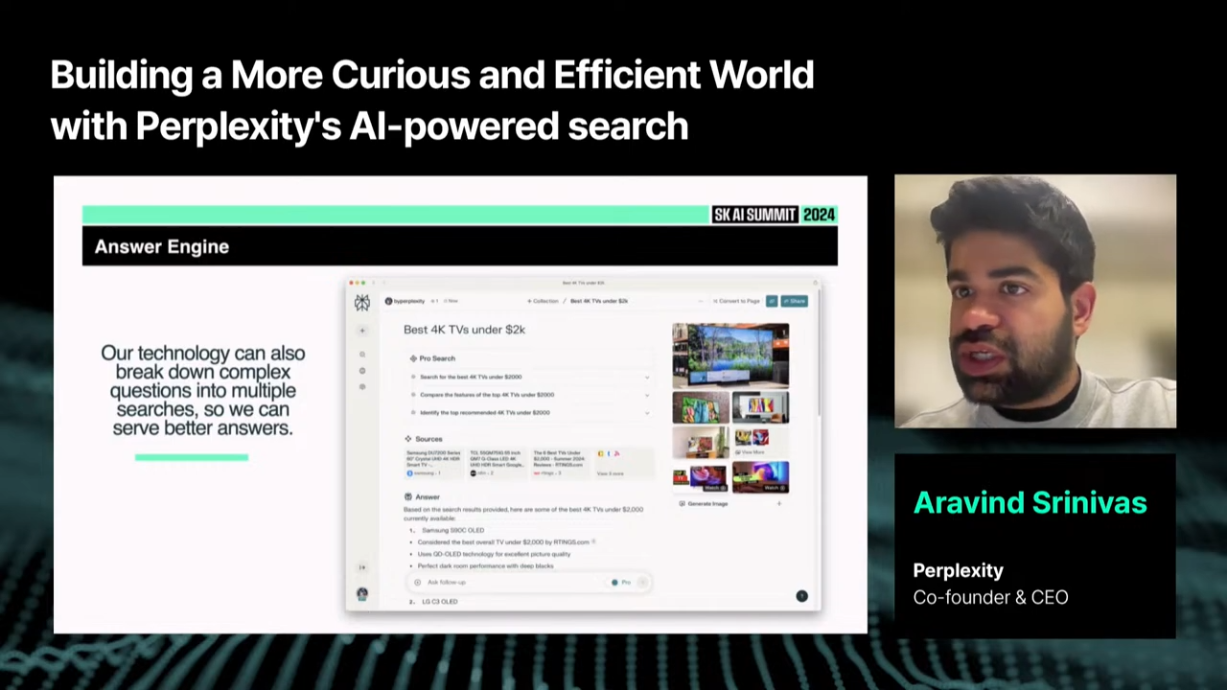

퍼플렉시티의 AI는 인간의 추론 방식을 모방하여 복잡한 질문을 단계별로 나누어 해결합니다.

- 예를 들어 "2000달러 이하에서 가장 좋은 4K TV"라는 질문에 대해, 가격 조건에 부합하는 TV를 필터링한 뒤, 리뷰 데이터를 분석하여 최적의 제품을 추천합니다.

이는 단순한 검색 엔진이 아니라 사용자의 결정을 돕는 진정한 도우미로서의 역할을 수행합니다.

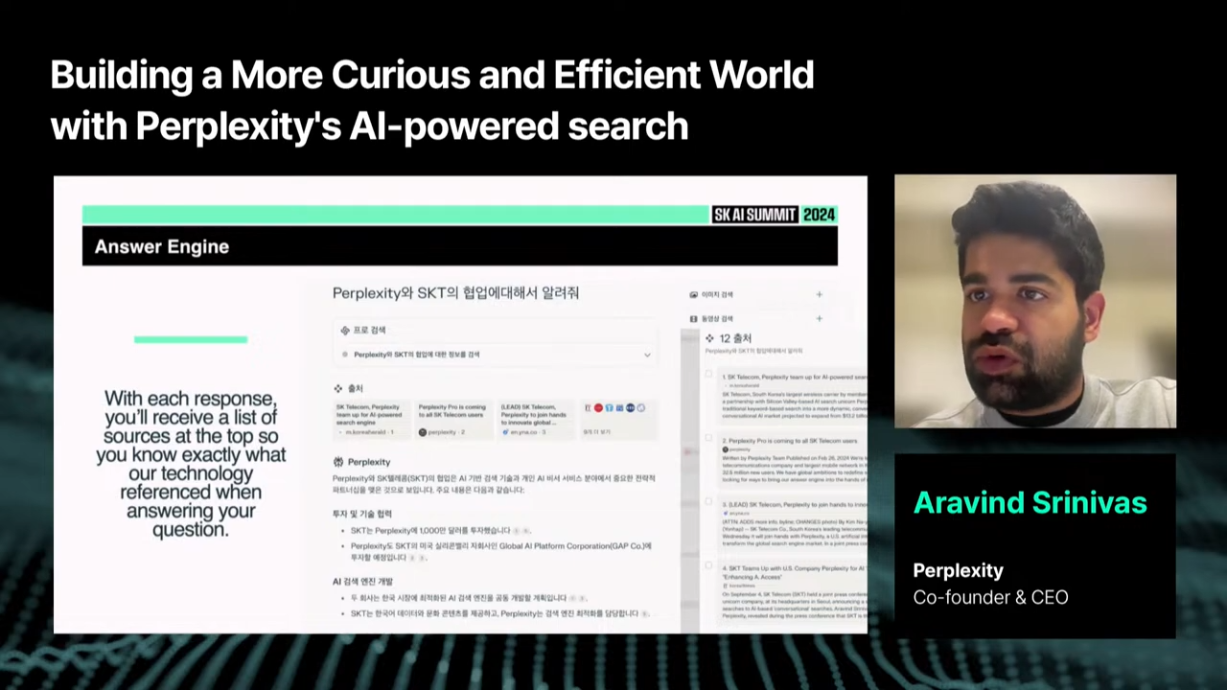

6. 신뢰성과 투명성: 출처 기반 검색

퍼플렉시티는 2022년 12월 출시 이후, 사용자 신뢰를 최우선 가치로 삼아왔습니다.

- AI가 생성한 답변에 오류가 있을 수 있기 때문에, 답변의 출처를 명확히 밝히는 기능은 필수적입니다.

이는 AI 검색을 일상에서 신뢰하고 활용할 수 있게 만드는 핵심 요소로 작용합니다.

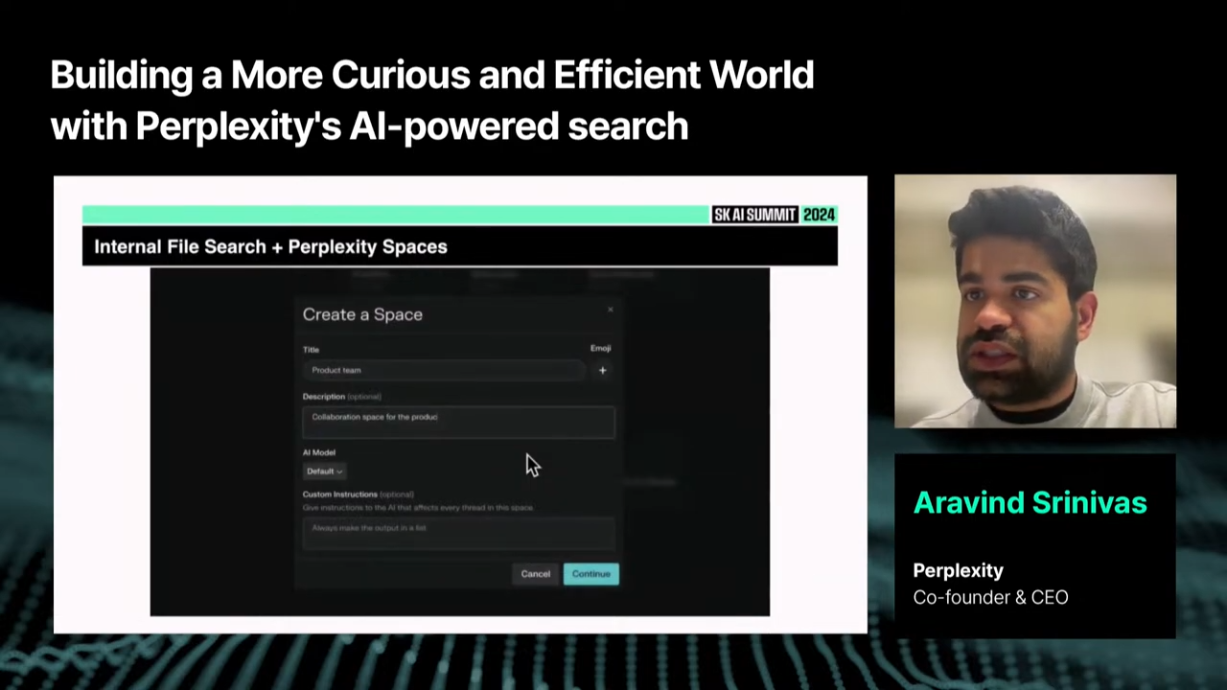

7. 웹 데이터부터 개인 데이터까지: 맞춤형 검색의 확장성

퍼플렉시티는 단순히 웹상의 정보를 검색하는 데 그치지 않습니다. 사용자 또는 기업의 내부 데이터를 검색하고 분석할 수 있는 기능도 제공합니다. (Space 기능)

- 예를 들어, 금융 리서치 기업이

크런치베이스(Crunchbase)나팩셋(FactSet)데이터를 활용하여 특정 기업의 재무 정보를 비교하거나, 기업 내부 데이터를 기반으로 빠르게 질문에 답할 수 있습니다.

이는 AI 검색이 단순 정보 제공 도구에서 정보 플랫폼으로 진화했음을 보여줍니다.

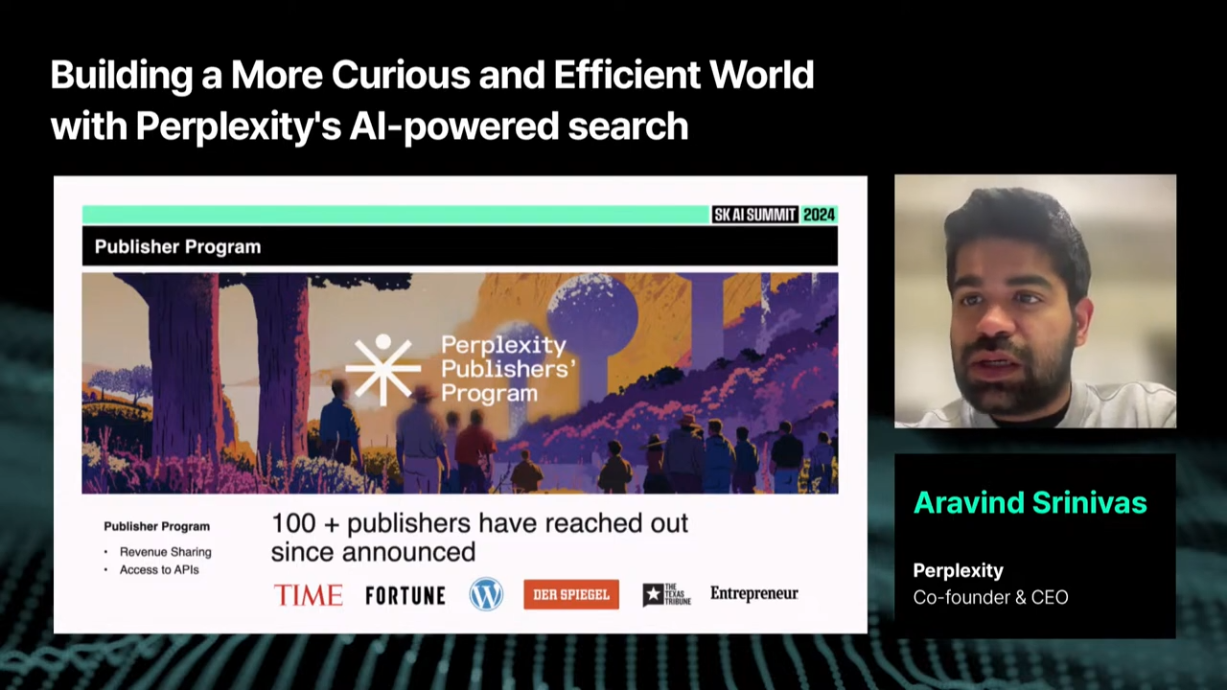

8. 글로벌 확장과 파트너십 전략

퍼플렉시티는 글로벌 확장을 위해 다양한 전략적 파트너십을 구축하고 있습니다.

-

타임즈(Times), 포춘(Fortune)과 같은 주요 미디어뿐만 아니라 워드프레스(WordPress)와 같은 독립 블로그와도 협력하며, 퍼블리셔들에게 수익 공유 모델을 제공할 계획입니다.

-

또한, API를 통해 더 많은 기업과 개발자가 퍼플렉시티의 기능을 활용할 수 있도록 지원하고 있습니다.

(후기) 아라빈드 스리니바스는 퍼플렉시티가 단순한 검색 엔진 이상의 역할을 할 것이라고 강조했습니다. 사용자에게 필요한 정보를 더 빠르고 정확하게 제공하며, 탐구적이고 효율적인 세상을 만들어 나가는 데 기여할 것이라고 얘기했습니다. 좀 더 비전에 대한 얘기를 듣고 싶었는데... 조큼 아쉬웠지만 직접 설명해주는 내용은 처음 들어서 그걸로 만족하는 걸로!! 😎

이상으로 Day1 오후 세션 상세 정리 마치겠습니다!!

읽어주셔서 감사합니다 :)