이번에 내가 하는건 진짜 찐 웹 크롤링은 아니다. 그저 긁어오는걸 따라해보는것이지..

수박을 한번 겉만 핥아보는....식이랄까?ㅎ그런데..하다가 중반에 깨달은 사실... 나는 이미 경험자다(?)

노마드코더 웹스크리퍼 만들기

근데 이거 다음단계에서 2일 🐕고생함

<Web Crawling이란?>

자동화 봇(bot)인 웹 크롤러(web crawler)가 조직적, 자동화된 방법에 따라 복수 개수 웹 페이지를 브라우징 하는 행위

오늘날 데이터사이언스와 머신러닝이 도래하며 빅 데이터가 중요성이 대두되었고, 이를 위해 인터넷에서 정보를 긁어오는 크롤링이 많이 사용되고 있다. (물론 개인적인 편의성과, 서비스를 위해서도 사용하는 경우도 많다)

파이썬이 크롤링으로 가장 유명하다는데, 실제론 다른 언어에서도 크롤링은 가능함(검색전까진 파이썬만 되는줄 알았다)

인터넷을 통해 크롤링을 검색하다보면 웹 스크래핑이라는 비슷한 개념이 나오니 이왕 나온김에 한번 정리를 해두자

웹 스크래핑(scraping) : 웹사이트 상에서 원하는 부분에 위치한 정보를 컴퓨터로 하여금 자동으로 추출해 수집하는 기술. 본인이 원하는 형태로 가공하는것.

~크롤링도 일종의 스크래핑기술이라 볼 수 있다.~

위에서도 말했지만, 말이야 웹크롤링이지

잘 따져보면 웹 스크래핑이다... 포괄적으로 표현하여 크롤링이라고 하는것일뿐

그래도 그게 어디냐 이제 3주차인데..!!!

실질적인 웹크롤링의 구조는 아래와 같다 그냥봐도 겁내 어려우니.. 일단 나는 조용히 보기만하고 넘어간다

그냥봐도 겁내 어려우니.. 일단 나는 조용히 보기만하고 넘어간다

시작전 깨알팁. Robots.txt🤖

저작권법과 지적재산에 대한 중요성이 증가한 현대사회에서, 누군가가 열~심히 만든 자료를 연습용으로 사용하는게 가능할까? 사이트주소에 /robots.txt를 쳐보자.

사이트별로 자기들이 정해둔 룰, 어디까지 쓰세요~가 친절히 기록되어있다.

[P.S]찾아보니 권고사항이라 사이트별로 robots.txt가 없는 곳도 있다. 그러나 다른사람의 지적재산권을 사용하는거니 무조건 한번 로봇을 넣어보는걸 권장

(사용 예시 : https://www.nike.com/robots.txt)

이렇게 이스터에그처럼 표현한 곳도 있다 (출처 Nike)

이렇게 이스터에그처럼 표현한 곳도 있다 (출처 Nike)

<웹 크롤링에서 사용되는 라이브러리>

1. BeautifulSoup

노마드코더의 니콜라스가 외치는 '뷰리풀 숩~'으로 익숙해진 라이브러리

HTML, XML 파일의 정보를 추출해내는 python 라이브러리이다. 사용하기 매우 쉽고, 심플하다는 장점이 있으나, 서버에서 HTML을 다운로드 받기때문에, 서버사이드렌더링을 사용하지 않는 SPA 사이트나, javascript 렌더링을 필요로하는 사이트들은 상당히 까다로운 편

- 장점 — 쉬움, 심플함, 빠름 (멀티프로세스, 멀티 스레드 적용시 해당)

- 단점 — javascript 렌더링이 필요한 사이트들을 크롤링하기 어려움. 병렬처리 로직을 별도로 작성하지 않으면 느린편.

2. Selenium

이거 셀레니움이라고 못읽던 바보->바로 '나'

(이제는 잘 읽음)

Selenium은 웹 자동화 테스트 (버튼 클릭, 스크롤 조작 등등)에 사용되는 프레임워크이다. 웹 페이지에서 javascript를 통해 동적으로 생성되는 데이터들을 손쉽게 가져올 수 있다.

- 장점 — 사용자가 보는 웹 페이지의 모든 정보를 가져올 수 있음, javascript rendering 기능 지원, 사용방법이 직관적이고 쉬운

- 단점 — 메모리를 많이 차지한다

<실전연습>

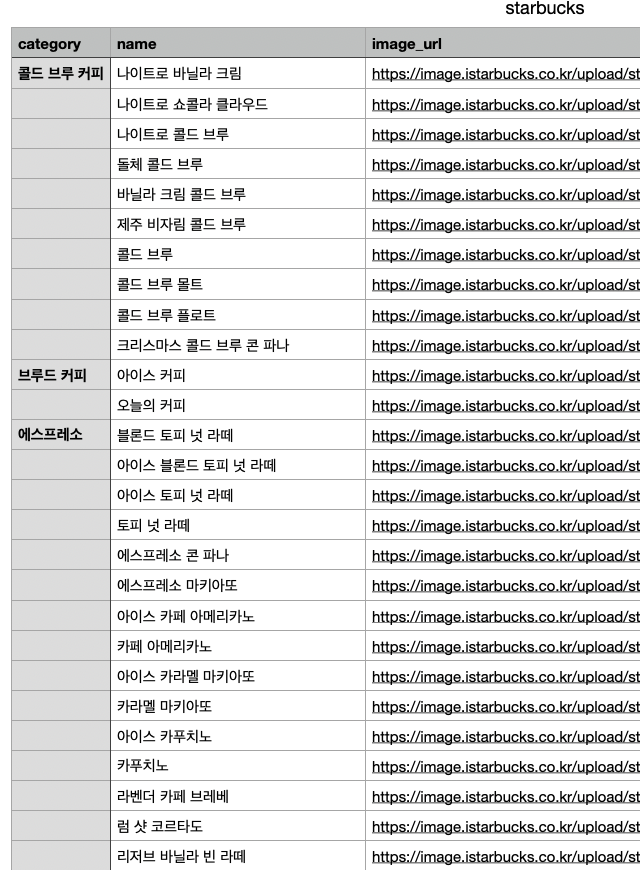

스타벅스 코리아에서 모든 음료의 제목과 이미지를 크롤링해서 csv로 저장해보기

CSV에 대해서

참고한 스타벅스사이트

이번 연습은 이미 사전에 코드를 다 알려주셨고, 크롤링이라기보다 그냥 흐름을 이해하는 수준이였다고 생각한다. 그래서 그냥 결과 코드만 기술하도록 하겠다

#필요한 애들 import

import csv

import time

from bs4 import BeautifulSoup

from selenium import webdriver

from webdriver_manager.chrome import ChromeDriverManager

#csv파일 작성해서 설정 이름은 stabucks.csv

csv_name = "starbucks.csv"

#csv열어본다

csv_open = open(csv_name, "w+", encoding = "utf-8")

csv_writer = csv.writer(csv_open)

csv_writer.writerow(('category','name','image_url'))

#크롬을 열게 하겠다

driver = webdriver.Chrome(ChromeDriverManager().install())

#가져오는 페이지

org_crawling_url = "https://www.starbucks.co.kr/menu/drink_list.do"

driver.get("https://www.starbucks.co.kr/menu/drink_list.do")

#가져오는 페이지의 전체 소스를 가져와라~

full_html = driver.page_source

#전체소스를 파이썬이 html을 알아볼 수 있게 하자

soup = BeautifulSoup(full_html, 'html.parser')

#불러오는데 3초정도 기다려주자

time.sleep(3)

#전체에서 내가 가져올 카테고리에 그 태그를 찾아주자

categories = soup.select('#mCSB_1_container > li > label')

#그 카테고리를 여러개 반복하기위한 for문

for i in range(2,len(categories)+1):

#카테고리 돌리는거 2,3,4,5,6순

element = driver.find_element_by_css_selector(f'#mCSB_1_container > li:nth-child({i}) > label')

category_name = element.text

time.sleep(2)

element.click()

#홈페이지에서 전체 소스 가져오고 거기서 html긁어왓!

full_html = driver.page_source

soup = BeautifulSoup(full_html, 'html.parser')

#각 카테고리는 2씩 늘어나는데,

titles = soup.select(f'#container > div.content > div.product_result_wrap.product_result_wrap01 > div > dl > dd:nth- child(2) > div.product_list > dl > dd:nth-child({i*2-2}) > ul > li > dl > dt > a > img')

print(titles)

for i, title in enumerate(titles):

#print('name: ',title['alt'])

#print('image_url: ',title['src'].split('/')[4:])

url = title['src']

print(url)

if i == 0:

csv_writer.writerow((category_name,title['alt'],url))

else:

csv_writer.writerow(('',title['alt'],url)) 결과

후기

이번건 솔직히 위코드에서 다 떠먹여준거라..(사전에 코드를 알려주심)

단지 계속 고생했던 부분은

BeautifulSoup가 Javascript를 인식하지 못한다는점을 사전에 인식하지 못하고

BeautifulSoup만 import해서 쓰다가 뒤늦게 다른동기분이 알려주신거였다..ㅎ..

그리고 원리를 이해했는데 사이트에서 알맞는 태그를 찾아내는것도..ㅎ 한 네다섯시간 고생한듯ㅠㅠ

이번 과제는 음.. 내가 노력한것보다 다른분들이 도와주신게 커서 좀 아쉬운 과제였다.

(그래도 이해는 하고 있으니 다음번에 한번더 혼자서 해봐야겠다. 할게 쌓이는중)