INFO 로그 없애는 게시글을 작성하다 $SPARK_HOME으로 환경변수를 세팅하여 간단하게 스파크 디렉토리를 지정하는 방식을 말했었는데,

내가 기억이 안날수도 있고, 혹시 궁금한 사람이 있을수도 있으니 그리 어렵진 않지만 기록으로 남기기로 했다.

사용 방식

자기 맘대로 세팅해도 되지만, 제일 일반적으로 SPARK_HOME으로 세팅하는게 다른사람이 이해하기도 쉽고 본인도 기억하기 쉽기 때문에 그렇게 쓰는게 좋을것 같다.

스파크 디렉토리로 이동하기 : cd $SPARK_HOME

스파크 pyspark 실행 : $SPARK_HOME/bin/pyspark

등이 있겠다. 확실히 세팅해두는 게 편하다.

적용 방법

먼저, JAVA_HOME을 환경변수 세팅하는 방법과 유사하다.

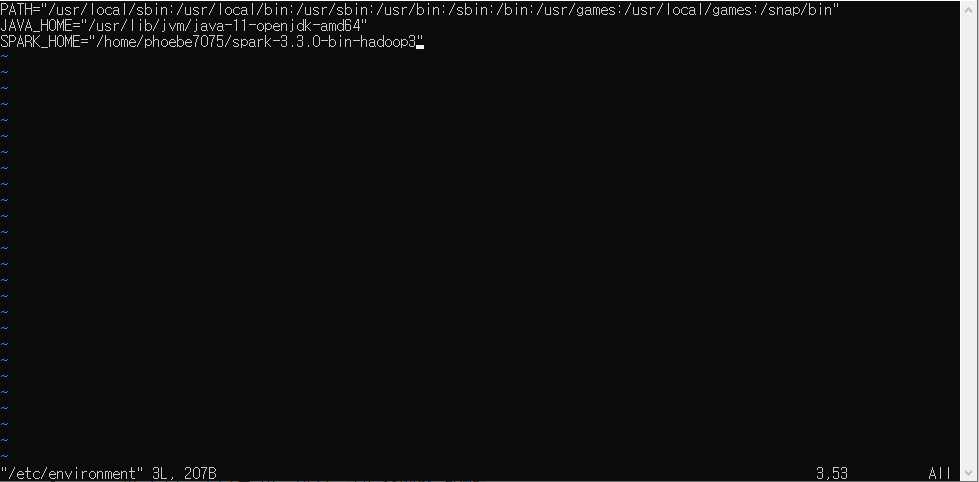

우리가 세팅해야하는 환경변수 파일은 /etc/environment 인데,

sudo vi /etc/environment로 에디터를 실행한다.

그러면 위와 같이 (만약 다른 환경변수가 더 많은 사람은 더 많은 세팅이 존재할 것이다.) environment 파일을 수정하면 된다.

i 로 편집모드 -> SPARK_HOME="/home/사용자이름/스파크디렉토리명" 와 같이 입력 후

esc -> :wq!로 저장 후 종료.

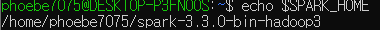

그 후 source /etc/environment 로 환경변수를 적용해주고, 테스트용으로 echo $SPARK_HOME을 실행했을 때

와 같이 링크가 나오면 성공이다. 사용할 때도 $ 표시를 꼭 붙여서 $SPARK_HOME으로 사용하면 된다.