.png)

딥러닝 시작!

NOTE1

-

퍼셉트론이란?

신경망을 이루는 가장 작은 단위.

다수의 신호를 입력으로 받아 하나의 신호를 출력.

입력값과 활성함수로 출력값을 넘기는 가장 작은 신경망 단위.

0과 1의 값 -

신경망(딥러닝)이 중요한 이유

단순 계산만이 아닌 이전에 컴퓨터가 잘 못하는 사물인식, 분할기술, 자연어 처리 등의 영역까지 사람보다 더 뛰어난 성과를 보이기 때문에 -

신경망은 어떻게 다시 대두되었나?

컴퓨터 성능, 인터넷 속도 증가, 데이터 용량 증가 등으로 딥러닝 기술이 눈에 띄게 발전해 가치를 인정받아 여러분야에 활용되게됨. -

딥러닝의 장점과 단점

장점 : 2번

단점 : 데이터가 적을 때는 성능을 발휘하지 못함. 즉, 단순한 문제를 풀 때는 쓸모가 없음. -

딥러닝(신경망)이란?

사람이 자극을 받고 생각을 도출하는 과정인 뉴런과 시냅스 등으로 구성된 신경망을 기계에 똑같이 적용해 컴퓨터가 사람처럼 '학습'하고 '생각'하게끔 만든 인공신경망.

(뇌를 모방해 만들었다는 주장이 틀렸다는 글이 있는 블로그)

인공신경망의 목표는 데이터 안의 복잡한 관계를 학습할 수 있는 강력한 알고리즘과 데이터 구조를 만드는 것.

딥(deep)은 연속된 층으로 표현을 학습한다는 개념을 나타냄. 최근 딥러닝 모델은 표현 학습을 위해 수십개, 수백개의 연속된 층을 가지고 있음. 이 층들은 모두 훈련 데이터에 노출해서 자동으로 학습시킴.

- 표현학습 Representation Learning

- 층 기반 표현 학습 Layered Representations Learning

- 계층적 표현 학습 Hierarchical Representations Learning

: 딥러닝은 데이터 특성을 풀기 쉽게 표현하도록 학습하는 능력이 있다. 신경망의 구조의 깊이를 변화시키며 데이터를 더욱 유용하게 표현할 수 있음.

-

가중치

가중치가 클수록 퍼셉트론에서는 강한 신호를 넘김.

가중치 = 시냅스의 연결강도(두께, 개수) -

XOR이란?

Exclusive OR

퍼셉트론의 한계를 설명하는 문제

(AND GATE, NAND GATE, OR GATE,XOR GATE(한계)) -

신경망 VS 인공신경망

- Dendrite(수상돌기) = Input*Weight+Bias

- Cell body(뉴런) = 시그마(노드)

- Axon hillock = 활성함수(Activation function)

- Axon = Output

- 머신러닝 VS 딥러닝

- 둘 다 전처리가 필요하지만 딥러닝은 특성공학 필요없음.(신경망이 알아서 필요한 특성들을 조합해 찾아냄.)

- 머신러닝 : 직접 데이터에 대해 파악해야하고 그 특징에 맞는 특성들을 설계하고 찾아내야함.

그러면 컴퓨터가 학습과정을 통해 특성과 출력값 과의 관계를 찾아준다. - 딥러닝 : 데이터에 필요한 특성들을 신경망이 알아서 조합해 찾아줌. 표현학습.

- 활성함수(Activation function)

: 풀고자 하는 문제에 따라 다른 종류의 활성화함수를 사용

- 계단 함수(Step Functionm)

- 시그모이드 함수(Sigmoid)

- ReLu 함수(Rectified Linear Unit)

회귀 문제 : 실수값 예측인 경우 활성함수 필요없음, 출력노드 수 = 출력변수 수

이진분류 문제 : 시그모이드 함수(출력 = 확률값 -> 레이블 결정)

다중클래스 분류 문제: 출력층 노드 수 = 분류 수 , Softmax함수

- 신경망 Layer

- Input Layers(입력층)

입력받기, 입력변수의 수 = 노드의 수, 계산하지 않고 값만 전달, 층 수에 포함하지 않음 - Hidden Layers(은닉층)

계산의 결과를 사용자가 볼 수 없음, 변수 수와 상관없이 다수의 노드가 가능, 2개 이상부터 딥러닝이라고 말함.

(딥러닝은 은닉층의 개수를 늘리고 그 연결과 학습 방법을 달리하여 더 복잡한 데이터의 구조를 학습하여 이전 성능 기록들을 갱신하면서 유명해짐)

복잡한 딥러닝 방법론에서는는 은닉층에서 활성함수를 사용하기 시작함. - Output Layers(출력층)

활성함수가 존재, 은닉층+출력층이 2개이상이면 다층신경망이라고 부름.

-

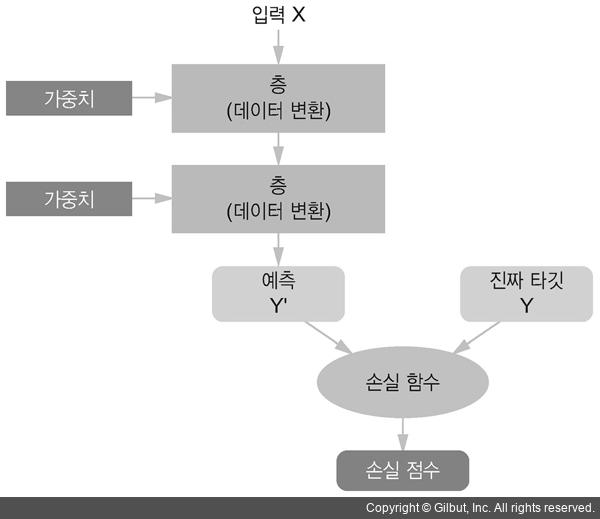

손실함수(loss function), 목적함수(objective function)

신경망의 출력을 제어하기 위해 출력이 기대하는 것보다 얼마나 벗어났는지 측정하는 것.

신경망이 한 샘플에 대해 얼마나 잘 예측했는지 측정하기 위해 손실 함수가 신경망의 예측과 진짜 타깃(신경망의 출력으로 기대하는 값)의 차이를 점수로 계산한다.

즉, 예측값과 실제값의 차이를 평가 -

경사 하강법(Gradient Descent)

손실값에 대한 미분값을 사용해 최저의 손실값을 갖는 매개변수(최적의 가중치, bias)를 찾음.

역전파는 미분값을 빠르고 효율적으로 찾는 알고리즘.