ETL pipeline Project

🔍프로젝트 개요

- .VER 230104

💡 목표

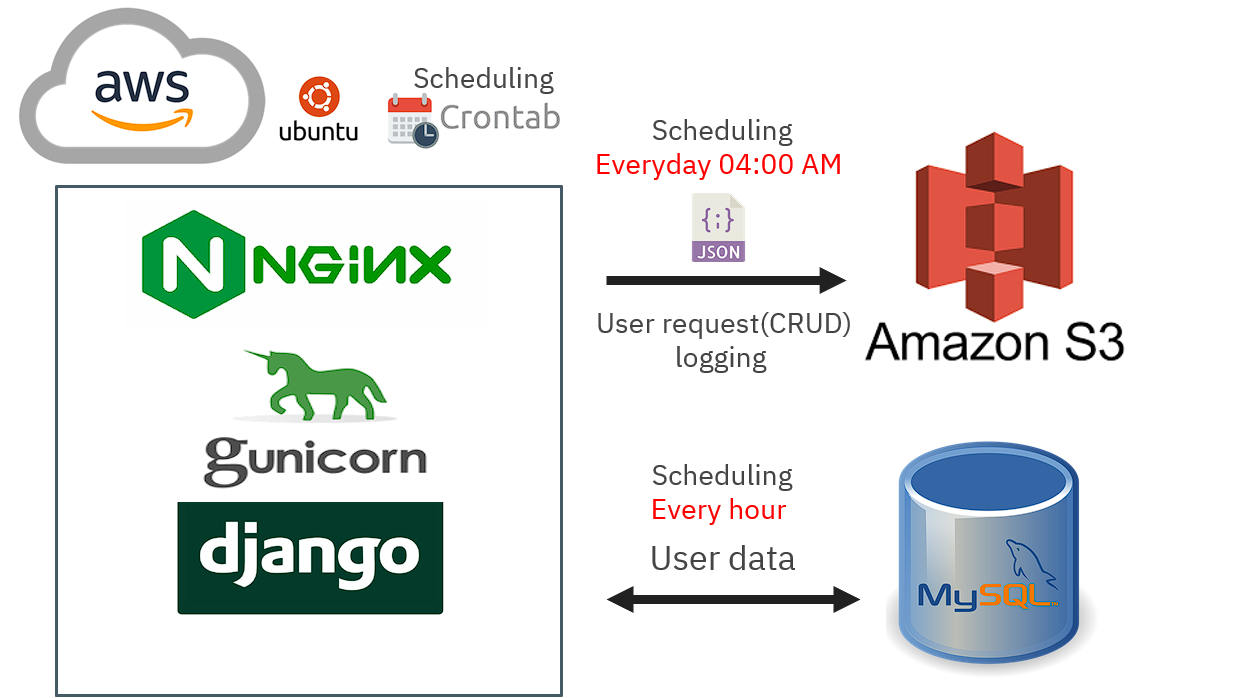

이 프로젝트를 통해 실제 서비스에서 발생할 수 있는 데이터를 가정해보기 위해 DRF를 활용해서 프론트엔드의 구현 없이 Rest API형태의 백엔드를 구현해보고 API요청(글의 생성, 수정,삭제)으로 발생한 로그를 수집하여 Json형태로 해싱, 암호화, 압축을 적용해서 추출합니다.

추가적으로 Amazon EC2에 가상 컴퓨팅 서비스를 사용하여 웹서버(nginx)를 구축했고, gunicorn과 django 프로젝트를 올려서 배포하였습니다.

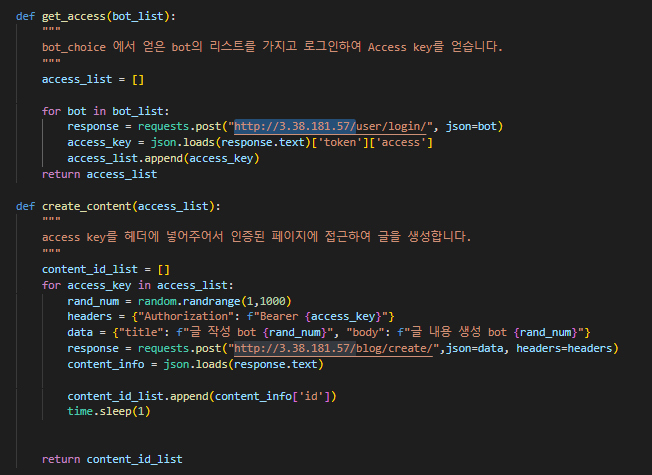

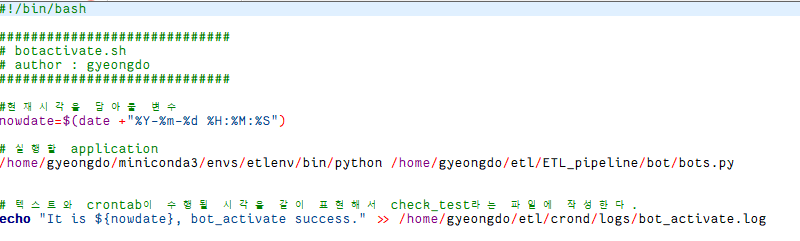

실제 이용자가 없기 때문에, 파이썬의 requests 라이브러리를 사용하여 Bot을 구현했습니다.

또한 웹서버로 사용되고있는 리눅스 서버에 크론탭을 활용하여 1시간마다 Bot을 활성화해서 로그 데이터를 수집하고, 이렇게 수집된 데이터를 변환하여 Amazon S3에 이용자가 적은시간은 오전 04:00 하루에 한 번 적재하는 흐름의 ETL 파이프라인을 구축하였습니다.

스케줄링은 Airflow로 대체될 수 있기 때문에, Airflow를 통해 워크플로우를 정의하여 효율적인 관리를 도입해볼 예정입니다.

👀 프로젝트 결과

Part 1. DRF 활용한 백엔드구현

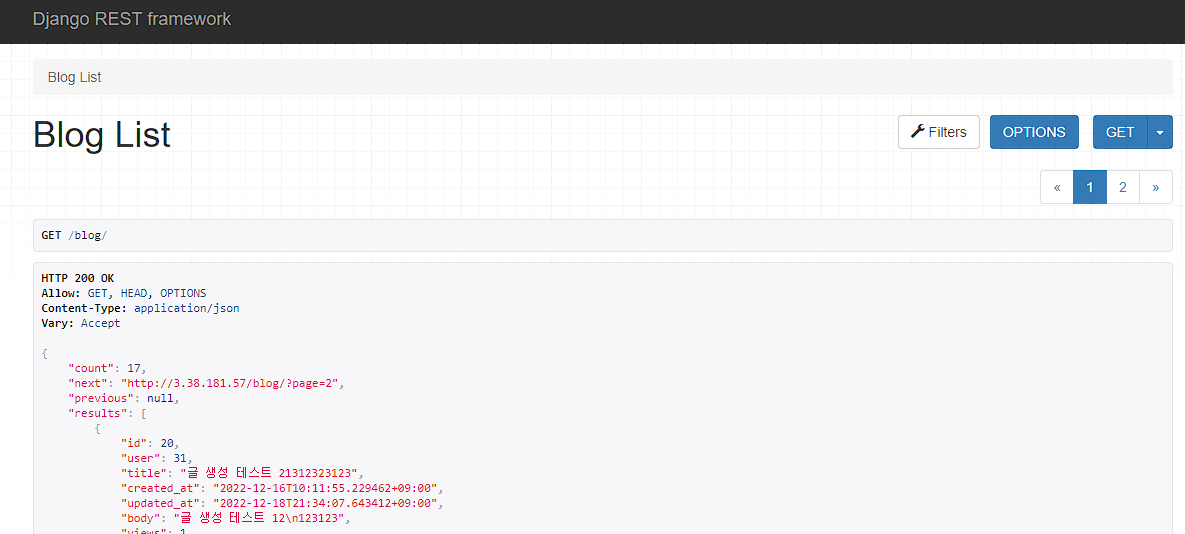

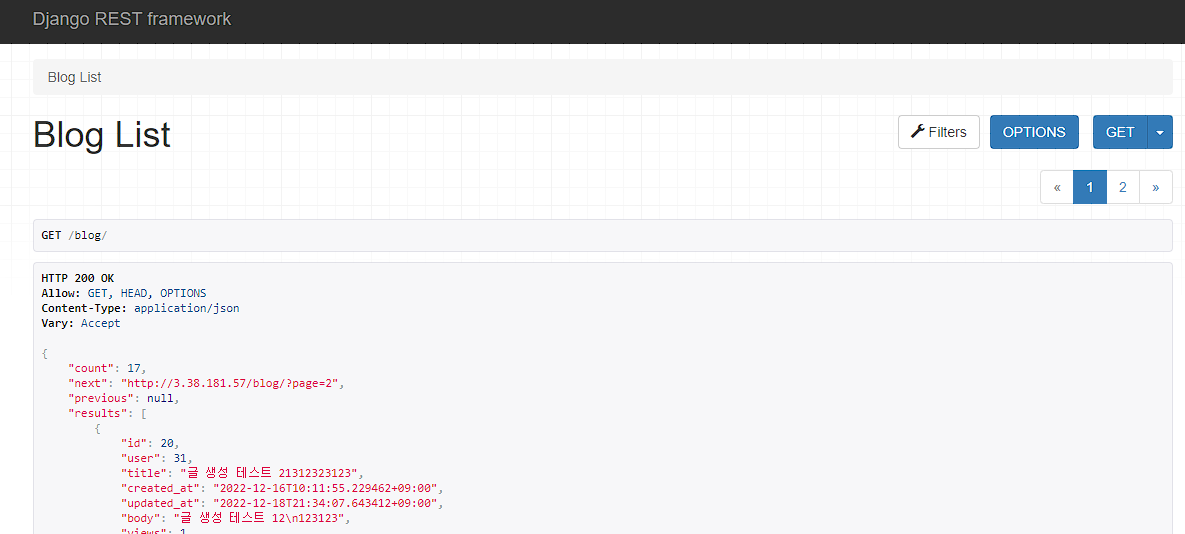

- 게시글 List

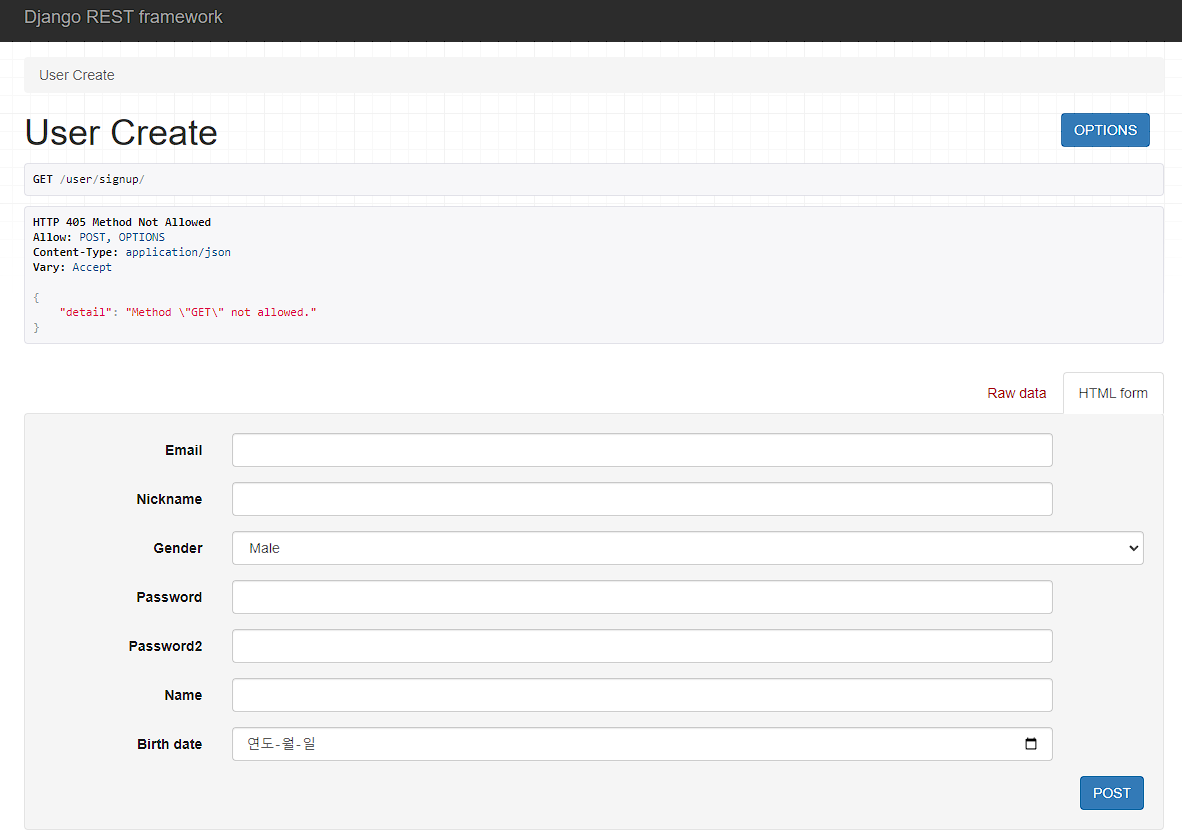

- 회원가입 화면

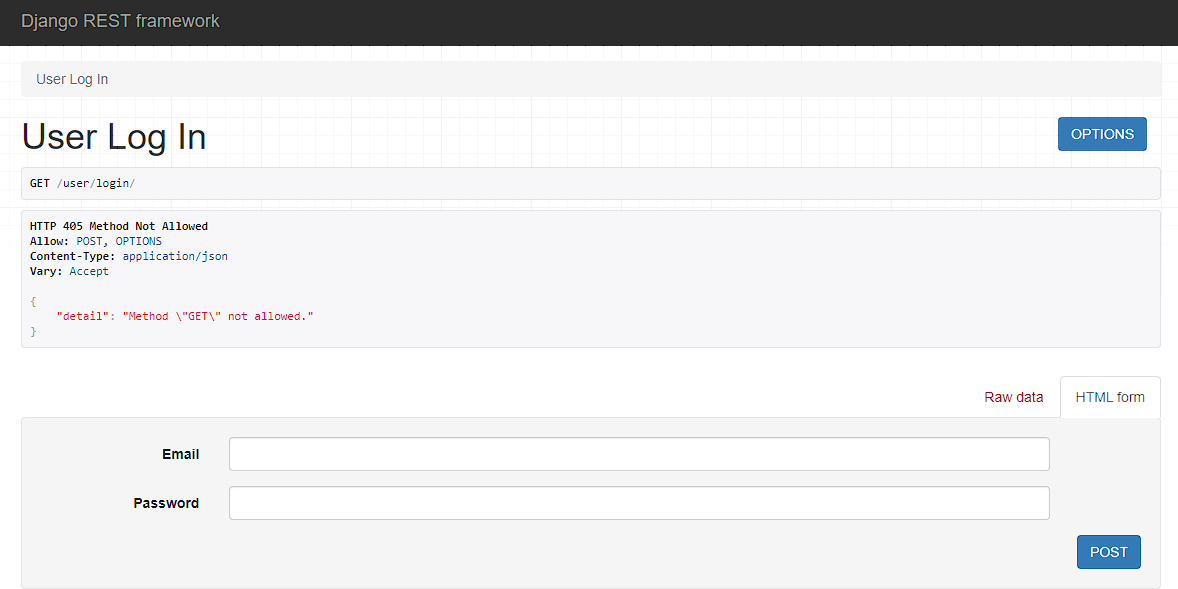

- 로그인 화면

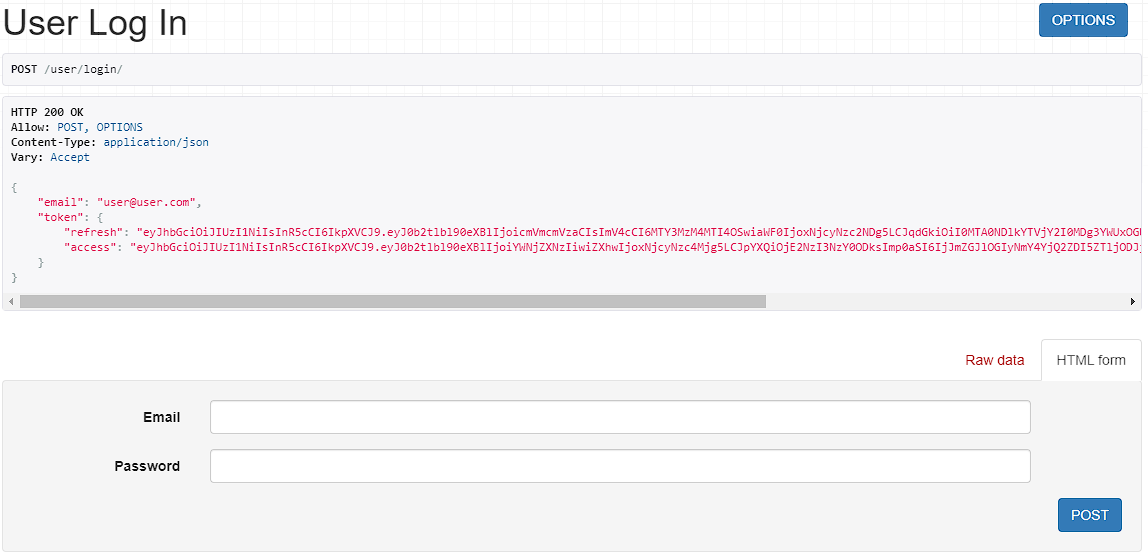

- 로그인시 발급되는 JWT 토큰

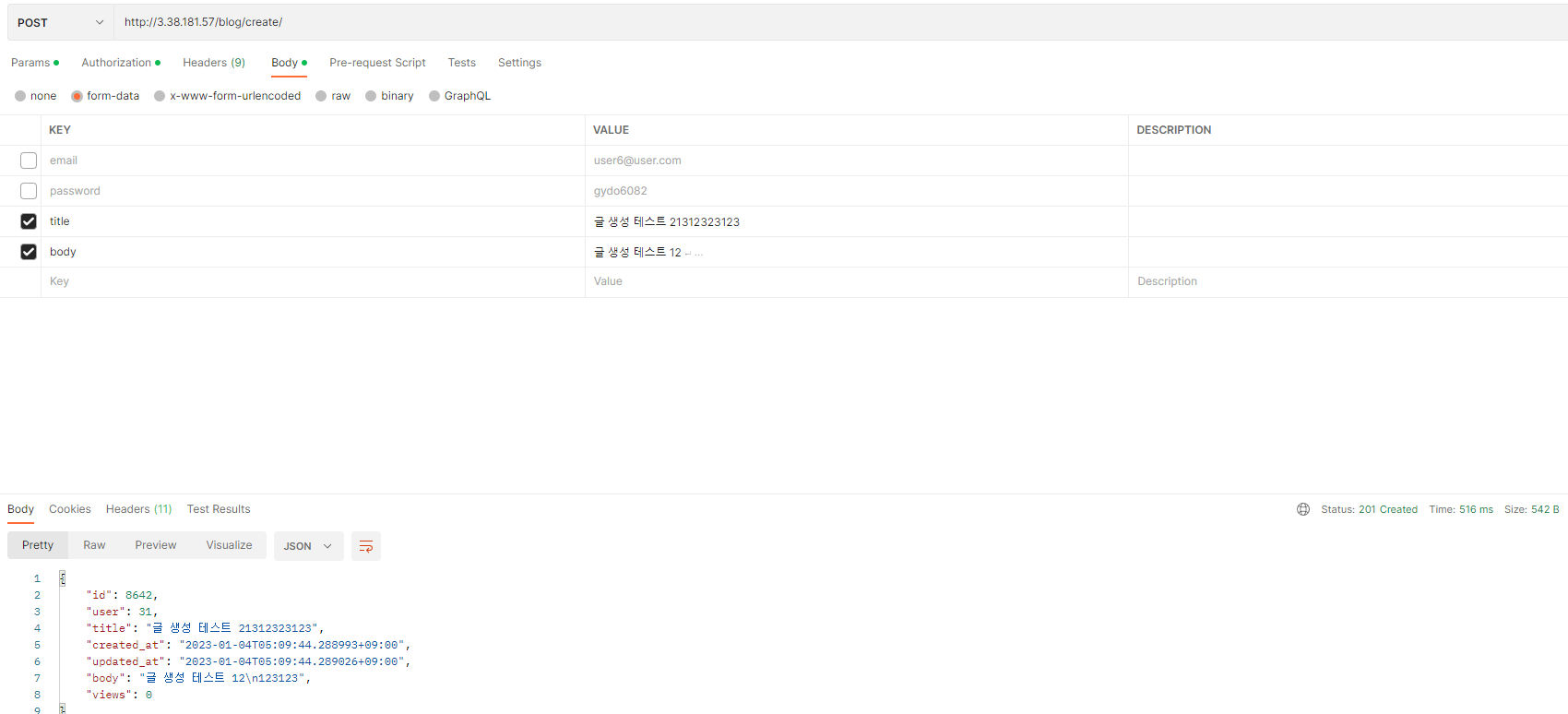

- JWT 토큰을 사용한 글 생성/수정/삭제를 위해 Postman 사용

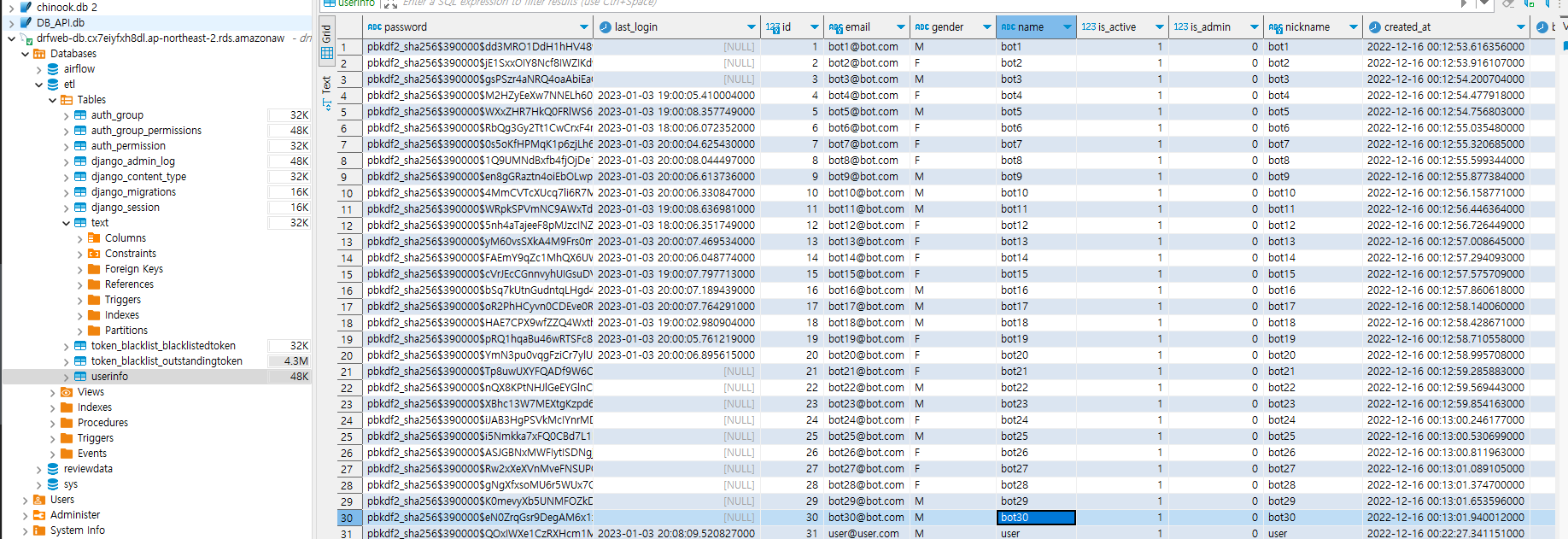

- 유저 데이터 (Mysql)

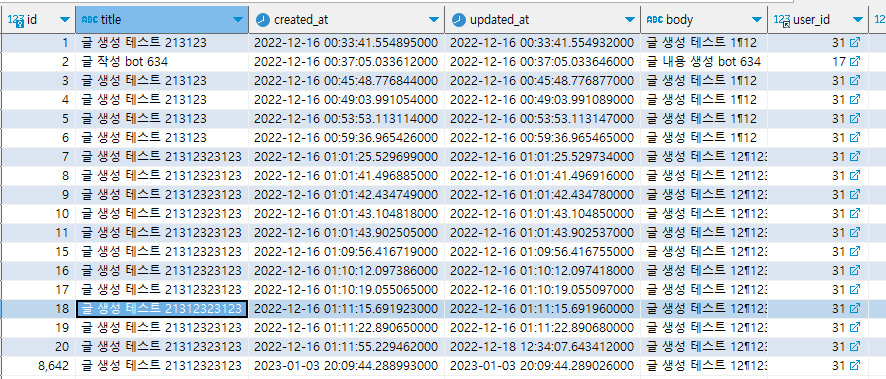

- 게시글 데이터 (MySQL)

Part 2. AWS EC2, RDS Service(프리티어)를 활용한 웹 서비스 구현 - 게시판 링크

- EC2 가상서버 인스턴스생성

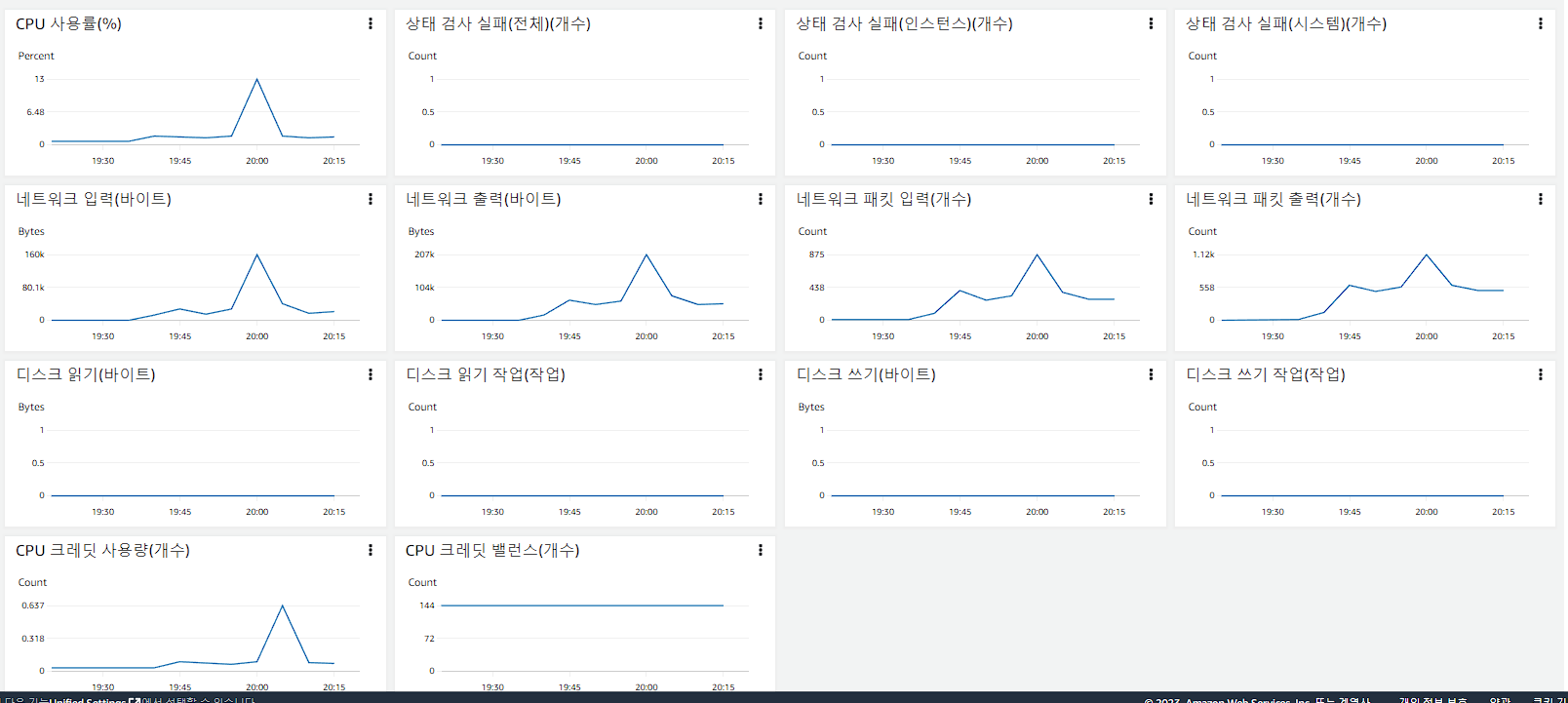

- 모니터링

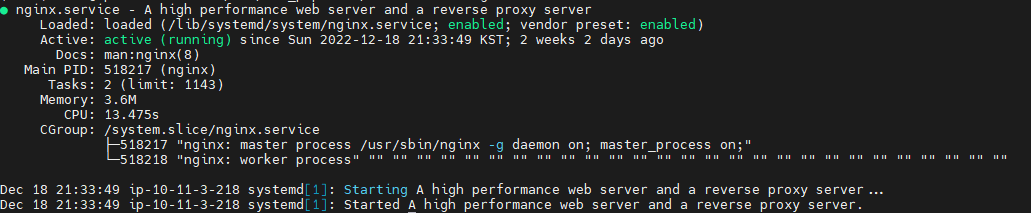

- 웹서버 시작

Part 3. Crontab, 파이썬 requests 모듈을 이용해 가상 유저 Bot 생성하여 CRUD에 대한 로그 생성

- bot 생성후 행동지정

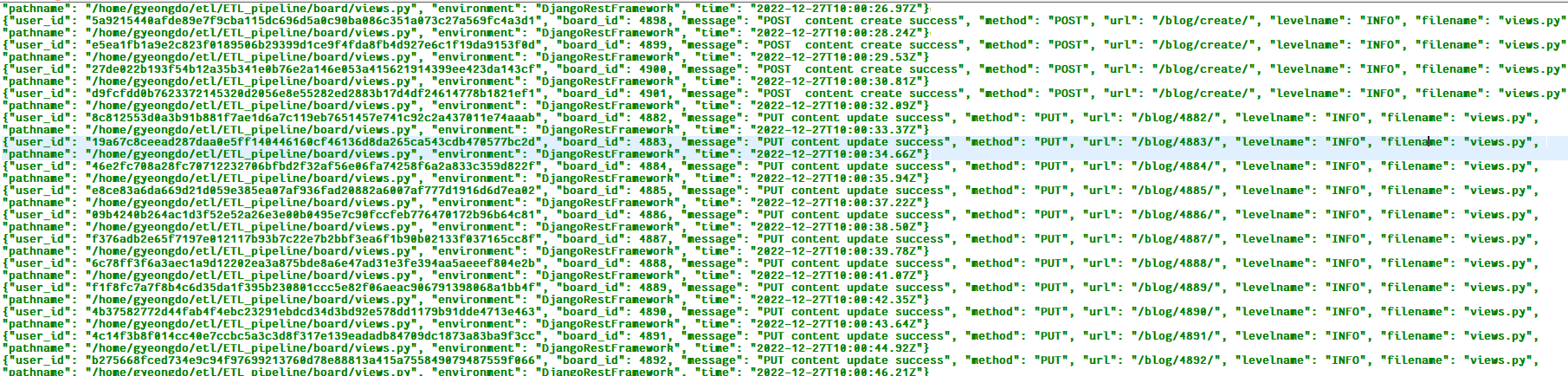

- 생성된 로그

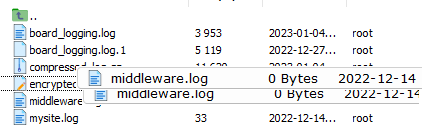

- 해싱, 압축 진행

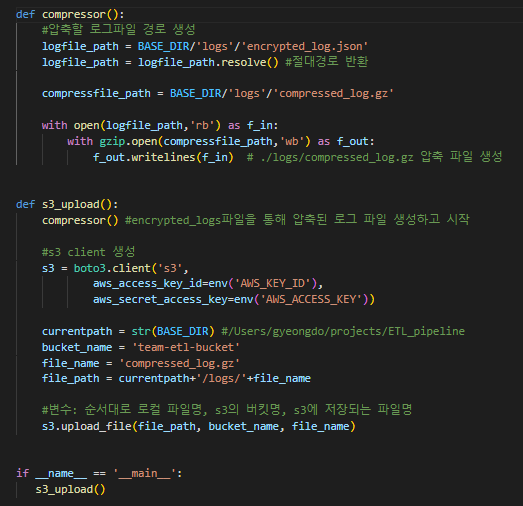

Part 4. 압축한 로그 데이터 Json형태로 AWS S3 적재

- AWS S3에 적재

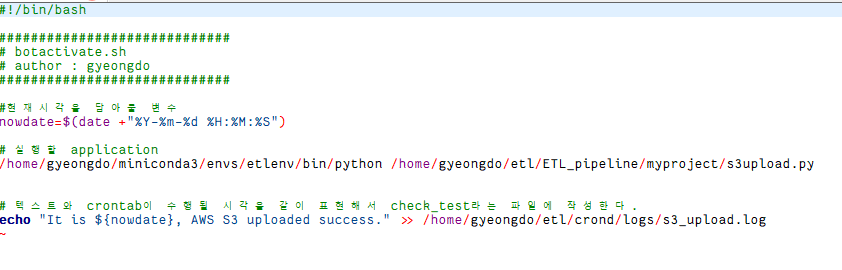

- 크론탭 활용한 스케줄링 - 1. 한시간마다 봇 활성화, 2. 매일 새벽 4시에 S3에 로그 데이터 적재

- 결과화면

Django Rest Framework(DRF)

AWS EC2 배포를 위한 초기 세팅하기

작업 기록

참고자료

- 장고 가상환경에서 mysql 연동하기 - ⭐⭐⭐

- 자신프로젝트에 맞는 .gitignore 생성하기

- JWT(Json Web Token)의 개념 - ⭐⭐⭐

- 장고 mysql DB 연결 table 연동

- 장고 게시판 만들기

- 깃 튜토리얼 - ⭐⭐⭐

- 파이썬에서 *, 의 뜻은 무엇인가?

- django rest knox

- 토큰 기반 인증에 대한 내용

- 해싱 알고리즘이란?

- 장고 튜토리얼.. 도움이 많이 됌 - ⭐⭐⭐

- JWT활용한 구현

- 장고 모델커스터마이징

- 장고 모델 choice field 사용법

- FBV vs CBV

- GenericAPIview Method - ⭐⭐⭐

- migration 관련 오류 발생시

- Django class형 viewsets 사용법 - ⭐⭐⭐

- JWT 로그인화면 구현 - ⭐⭐⭐

- DRF 로그파일 남기기, 로그란? 파이썬 로그체계 장고의 로그체계 - ⭐⭐

- DRF 로깅 - ⭐

- Django DB 조회, 집계

- 필터링, 페이징 공식 페이지 https://www.django-rest-framework.org/api-guide/filtering/- ⭐⭐

- DRF 공식사이트 - ⭐⭐⭐⭐⭐

- Datetime 한국으로 바꾸기

- DRF request와 CreateAPIview의 인증처리

- ViewSet overrides

- URL 과 URI의 차이

- 왜 JWT 인증을 사용할까?- ⭐⭐⭐

- 로깅- ⭐⭐⭐

- 하우투 로깅

- 해싱, 암호화 / 복호화

- 양방향, 단방향 암호화 알고리즘

- OS 모듈함수

- 세션 vs JWT인증

- JWT, OATUH

- python requests 모듈 헤더에 JWT 토큰값 넣기

- JSON 문자열 python에서 dict으로 변환하기

- JSON 데이터 python requests 모듈로 POST요청 보내기

- 장고 헤로쿠 배포하기

- 리눅스 yum

- amazon EC2에 python3.8 설치하기

- EC2 리눅스 root 권한 사용하기

- centos os python 3.7 upgrade 후 발생하는 yum 문법오류 해결방법

- 리눅스 버젼확인하기

- 아마존 리눅스 2 mysql 설치 및 세팅