swish는 ReLU를 대체하기 위해 구글이 만든 활성화 함수이다. 깊은 신경망에서 ReLU보다 높은 정확도를 가진다고 알려져있고, EfficientNet과 MobileNet에서 실제로 사용되고 있다. (MobileNet은 h-swish함수 사용)

Swish

Codes

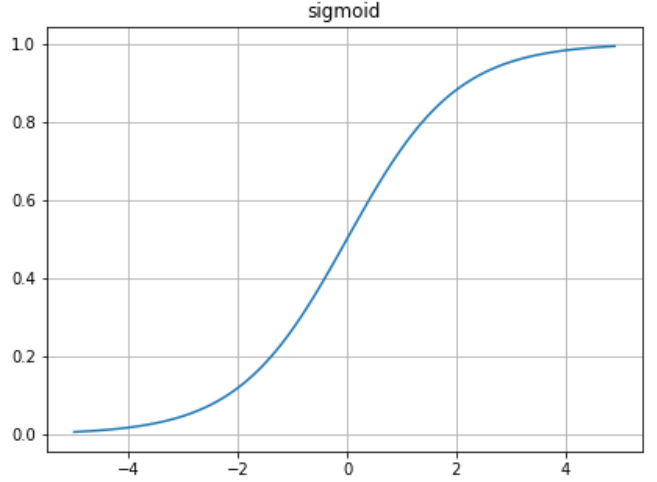

def sigmoid(x):

return 1 / (1 + np.exp(-x))def ReLU(x):

return np.maximum(0,x)def swish(x):

return x * sigmoid(x)Result