Bagging 이란?

Bagging은 Bootstrap Aggregating의 줄임말이다. Bootstrap이 뭔지 알아보고 다시 설명 ㄱㄱ!

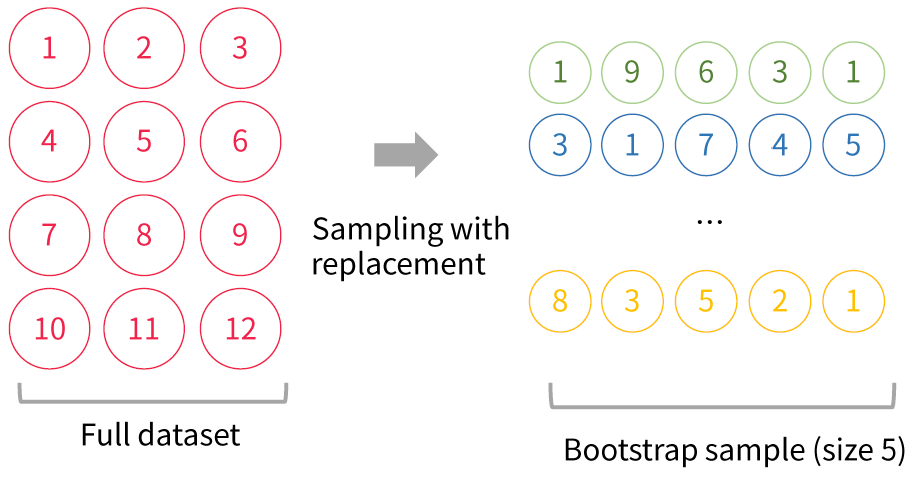

Bootsraping

dataset이 있다면 중첩을 허용한 sampling을 통해 다시 여러개의 세트로 분할하는 방식이다

(근데 랜덤하게 뽑아내다 보니, Full dataset에서 sample이 되지 못한애도 있지 않을까?

해서 나온개념이 Out-Of-Bag error, 학습데이터에서 미 추출된 데이터로 검증을 해보자!)

Bagging 장점?

- Tree와 비교했을 때, 트리는 깊어질수록 분산이 증가하고, 편향이 감소하는데, Bagging은 편향 유지, 분산 감소의 효과를 볼 수 있다.

- 학습데이터의 noise에 강건? 해진다.

즉 ! 애초에 model 학습 오류의 3가지 주요 원인을(분산, 편향, 노이즈) 완화시켜준다는 것!

그럼 Bagging의 한 종류인 Random Forest에 대해서 알아보자!

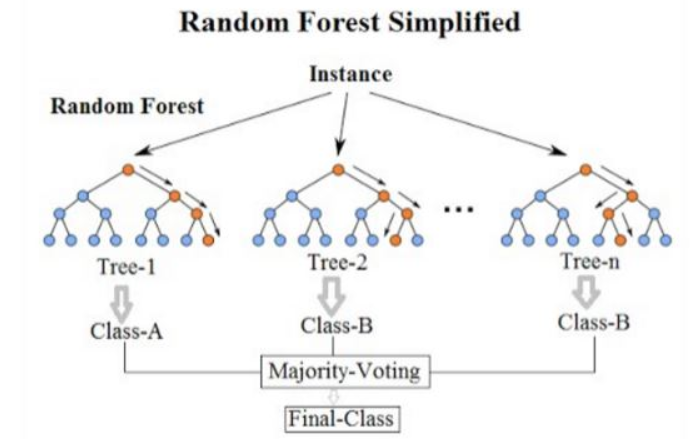

Random Forest 란?

랜덤 포레스트는 의사결정나무(Decision Tree)를 기반으로 만들어졌다. 여러 개의 Decision Tree를 생성해, 각자 무작위로 데이터를 선택하여(Bootstraping) 개별적으로 학습한다.

최종적으로 voting을 통해 예측 수행