AIHub?

- 머신러닝 이미지 학습용 데이터 셋을 다운 받기 위한 국내 페이지

머신러닝 이미지 데이터 셋은 용량이 굉장히 많이 필요합니다.

학습 방식에 따라 필요한 데이터 양도 차이가 있지만요. 기본 100GB입니다.

1. 내가 원하는 데이터 셋 찾기

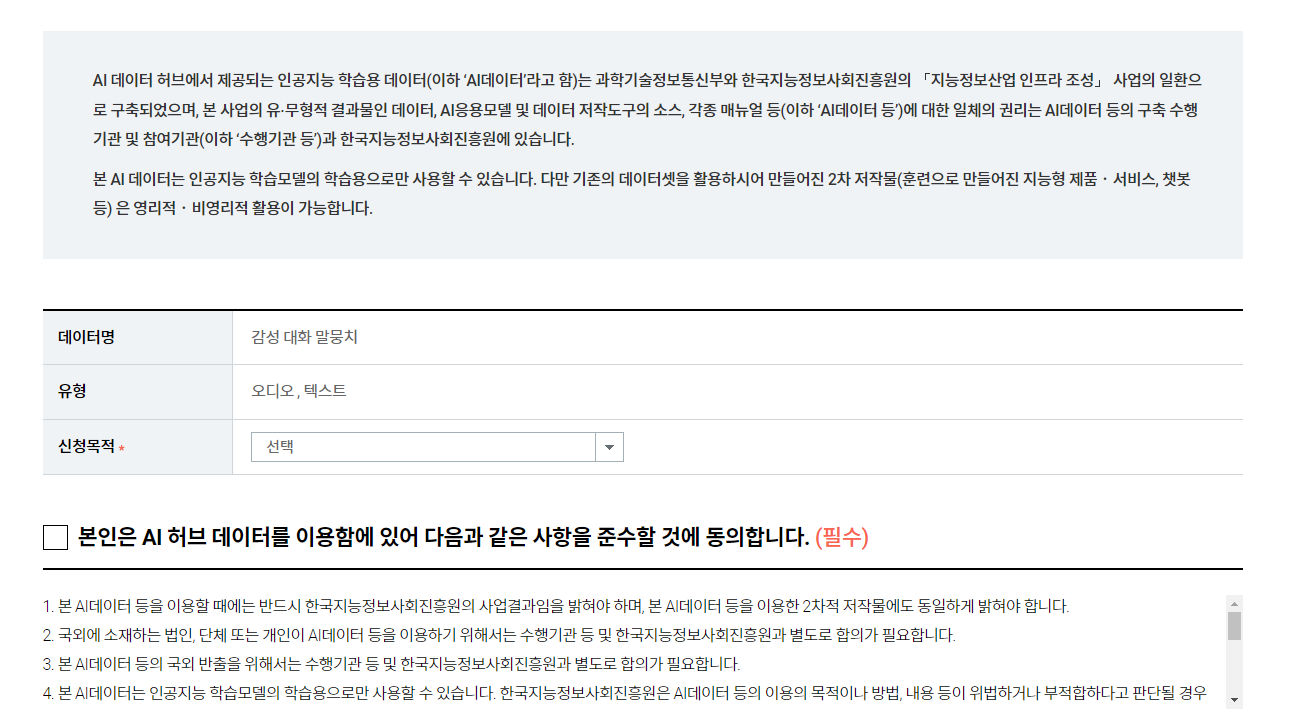

2. 로그인 후 데이터 사용 신청하기

다운로드 버튼을 누르면 넘어간다.

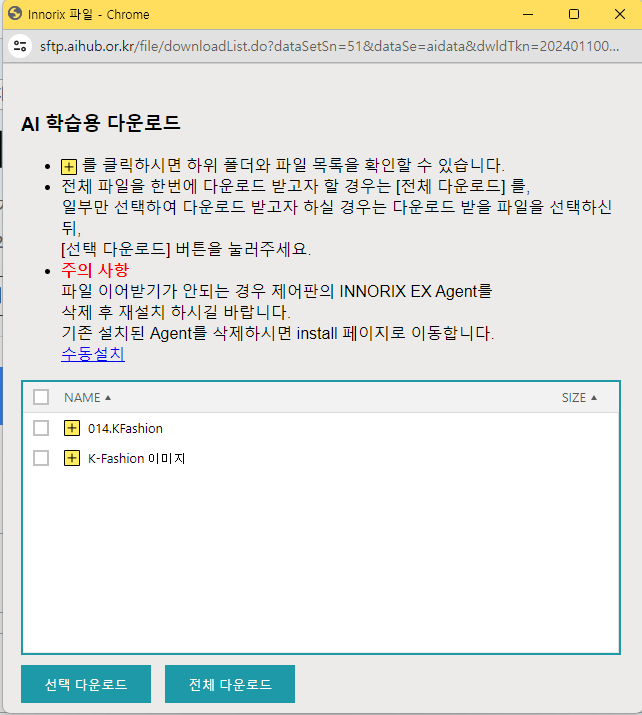

3. 다운 받을 방법 정하기

일단 학습할 환경을 먼저 정해야한다.

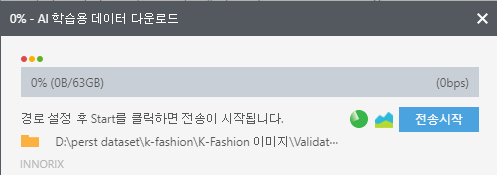

1. 윈도우에서 로컬로 머신러닝 학습 할 예정

- 다운로드 버튼을 누르면 파일을 다운 받을 수 있습니다.

이때 수동설치 버튼을 눌러INNORIX 프로그램을 먼저 설치해야합니다.

경로를 지정하고 원하는 파일을 다운받으면 됩니다.

하지만 데이터들이 압축되어 있어 압축도 해제해야합니다.. 😭 (내 시간..)

2. Mac, Ubuntu에서 로컬로 학습 할 예정

shell을 지원하는 환경에서는 aihubshell로 쉘에서 다운 받을 수 있습니다.

사실 Mac에서 shell로 받을 수 있는지 잘 모르겠습니다. 제가 맥은 안써봐서

https://www.aihub.or.kr/devsport/apishell/list.do?currMenu=403&topMenu=100

하지만 여기도 데이터들이 압축되어 있어 압축도 해제해야합니다.. 😭 (내 시간..)

3. 구글 코랩에서 학습 할 예정 (추천)

구글 코랩 : 머신러닝 학습에 최적화된 환경, GPU를 무료로 지원해준다?!

일단 저 같은 경우는 로컬에 데이터를 다운 받아서, 구글 드라이브에 업로드 했습니다.

❗❗여기서 중요한 점❗❗

다운 받으면압축 파일이 나옵니다.

학습을 위해서는 압축을 해제해야하는데, 로컬에서 압축 해제하지 마세요..

로컬에서 압축 해제하면 안되는 이유

- 압축 해제 개느립니다. 라벨링, 이미지 엄청 많기 때문에 저는 2시간 돌렸는데도, 10%인 것도 있었습니다.

- 압축 해제하면 구글 드라이브로 옮기는 데도 개느립니다. 이미지 파일 하나하나 옮기기 때문에 120만장 하나씩 옮기면;;

✅ 방법은?

- AIHub에서 데이터셋을 다운받는다.

- 데이터셋은 압축 형태로 되어 있는데, 일단 구글 드라이브로 이동 시킨다.

- 구글 드라이브 프로그램을 다운 받는다! 다운링크

(브라우저보다, 프로그램이 훨씬 빠릅니다!)- 구글 드라이브로 파일을 이동시킨다.

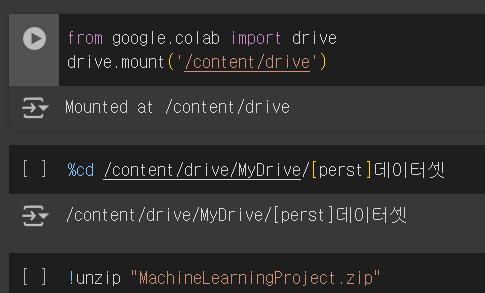

- 구글 코랩에서 압축 해제한다.

!unzip "/content/drive/MyDrive/파일명.zip"코랩 사용법 참고 : https://rubber-tree.tistory.com/126

너는 어디서 학습 했니?

저는 머신러닝 파트가 아니기 때문에, 머신러닝 환경만 조성해 달라는 임무를 받았습니다.

400GB 이상이 되는 데이터 셋은 다 어디로 가야 할 까요?

"아.. amazon aws ec2 서버로 올려야하나?"

그래서 저는 aws ec2 서버에 ubuntu에 모든 파일을 올리고 환경을 조성했습니다.

하루 서버를 풀로 가동시키면 4달러 (4코어, 램 16기가)

엄청 느리더라고요 GPU 없으면,,

EC2 서버 세팅하는데도 6시간 이상은 걸린 것 같은데..

제가 한 삽질은

삽질

- EC2에 6시간씩 걸려서 세팅해놓음

- 성능이 좋지 않음. CPU로만 돌리니..

- Colab으로 옮기려는 결정

- EC2 모든 파일을 .zip해서 일단 외장하드로 옮김 ➜ 2시간

- 압축 해제하는데 2시간 사용

- 압축 해제한 파일을 드라이브로 옮기려는 노력 ➜ 1시간 (전송 속도 : 14kb/s....)

저는 400GB인데요?

7,767시간 걸리는데 : 서울 - 부산 왕복 970번 가능;- 결국 압축 파일을 옮겨서 압축 해제하는 시간 ➜ 3시간 이상..

오늘 또 배웠다 😭

삽질2 (2024.01.11 03:53)

"공유로 해서 여러 계정으로 압축 해제하면 더 빠를듯?"

예.. 빠릅니다.. 하지만 단점이 있습니다.

[상황] 메인 계정 : 2TB 지원 / 서브 계정들 : 15GB 까지만

- 서브 계정들은 15GB까지만 저장 가능함.

- 압축 풀린다고 신나게 해제 다 해놨는데, 용량이 부족해서 압축 해제는 했지만 저장은 안되어 있는 사태 발생함 😭

- 저는, 압축 다 풀고나서 알았습니다...

다시!unzip *.zip하러 갑니다..- 2TB를 지원하는 계정의 여러 주피터 노트북을 열어서 작업하시는 것을 추천드립니다! 서브 계정 비추

- 여러 Colab 주피터 노트북을 열어도, 어짜피 메모리 다쓰면 튕깁니다. 적당히..

- 그리고 구글 드라이브로 파일 옮기는 방법도 고려하는 것도 좋을 것 같습니다.

저는, 이렇게 했습니다.

1. 드라이브 용량 늘리기

기본은 15GB입니다. 하지만, 용량을 늘려서 사용해야겠죠?

구글에서는 프리미엄 멤버십인 Google One이 있습니다!

Google One 2TB를 결제했습니다! (1달에 11900원)

2. 파일 전송

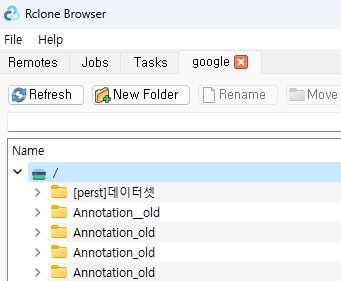

저는 Google Drive 프로그램과, Rclone 사용하고, Colab에서 unzip 세 가지 방법을 동시에 했습니다.

-

Google Dirve 프로그램 : 로컬에서 압축 해제한 파일을 업로드

https://www.google.com/intl/ko_kr/drive/download/

-

RClone : 파일 전송 프로그램

https://rclone.org/drive/ (공식 문서)

-

Google Colab Unzip

zip파일을 구글 드라이브에 업로드- Google Colab에서 Dirve 연동

zip파일 압축 해제

주의 1 : 여러개의 주피터 노트북을 사용하면 메모리 부족으로 정상적으로 압축 해제가 잘 되지 않을 수 있음

주의 2 : 압축 해제가 완료되어도, 구글 드라이브에 반영되는 시간이 걸릴 수 있으니 몇 시간 이후 확인해보기

이때가 방학 시즌이라서, 항상 노트북 켜놓고 계속 업로드 하는 과정을 거쳤습니다.

거의 2주? 세가지 방법을 동시에 돌려 놓고, 잠자고 일어나고, 나갈때도 해놓고

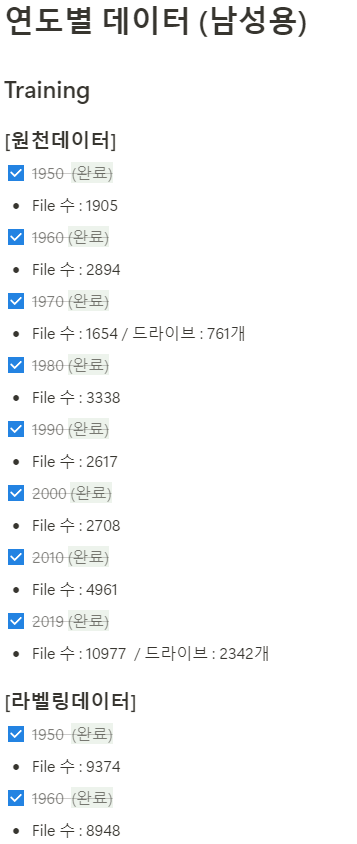

노션에 적어두고, 폴더마다 하나씩 잡고 업로드 했습니다.. 이렇게 2주간 400GB

더 좋은 방법이 있을 수 있으니,, 있으면 댓글로 알려주세요..!

추가) 나중에 삭제할 때도 문제입니다..ㅎㅎ, 작은 용량의 json 파일이 많으니 일주일동안 삭제 시도한듯..ㅎㅎ