2021 EMNLP 올라온 구글 리서치의 논문이다.

최근 구글 AI 블로그에 관련 포스팅이 올라와서 논문을 보게되었다.

이 논문에서는 프롬프트 튜닝이 앞으로 떠오르고 있는 튜닝 방법이 될거라고 말한다.

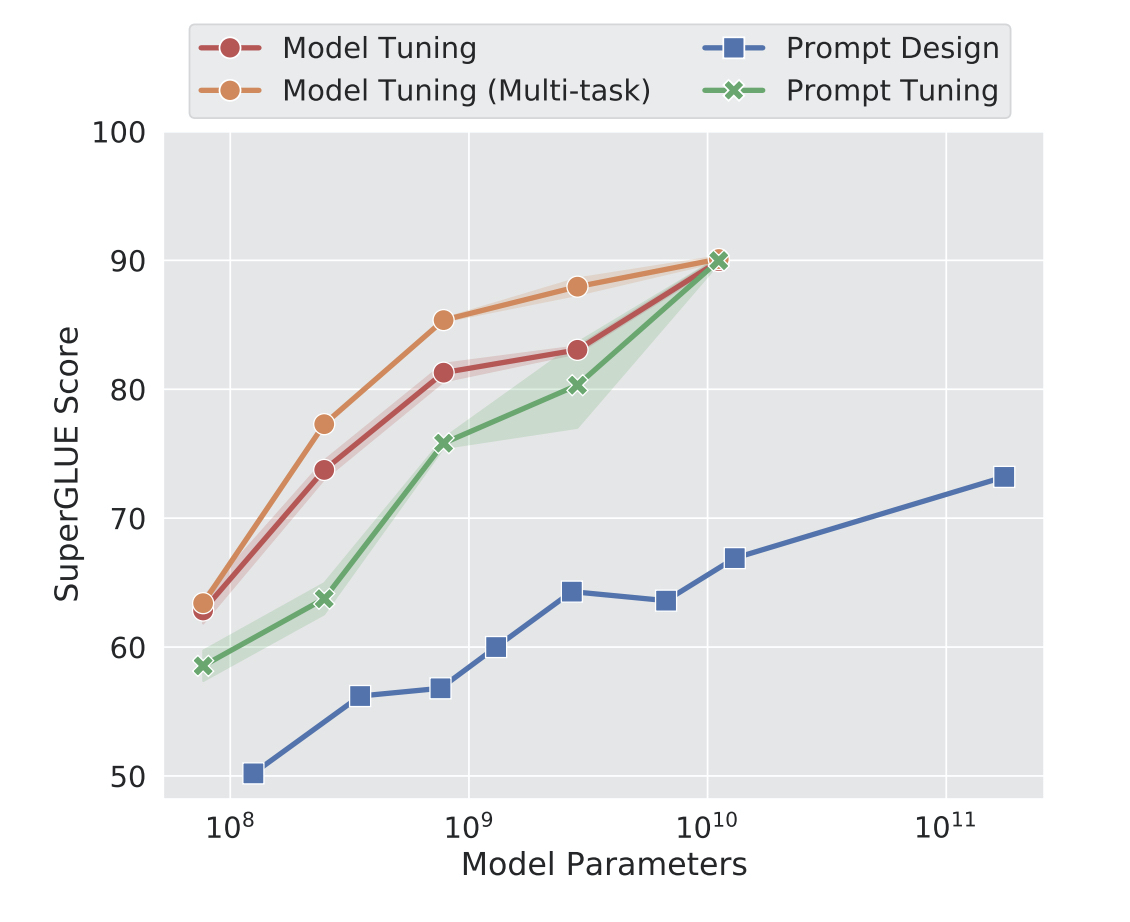

위 그래프에서 보여주고 있는 것처럼 T5모델로 SuperGLUE 벤치마크셋에 대해 점수를 내어 기존 파인튜닝 방법만큼 성능이 나오는 것을 가장 먼저 보여준다.(모델이 커질수록 차이가 줄어듦.) 기존 학습된 언어모델의 파라미터를 고정하고, 훨씬 적은 양의 파라미터만으로 특정 테스크들을 학습하게 하는 것이 오히려 오버피팅을 방지해서 좋은 결과를 이끌어냈을 것이라고 한다.

저장공간이나 서빙 면에서 줄 수 있는 이득이 확실하기 때문에, 언어모델 자체를 훈련하는 것과 특정 테스크에 적합하게 모델을 추가 학습할 때에 학습하는 파라미터를 분리하는 프롬프트 튜닝에서의 발전을 기대한다.