activation Function = 활성화함수

sigmoid = 시그모이드

softmax = 소프트맥스

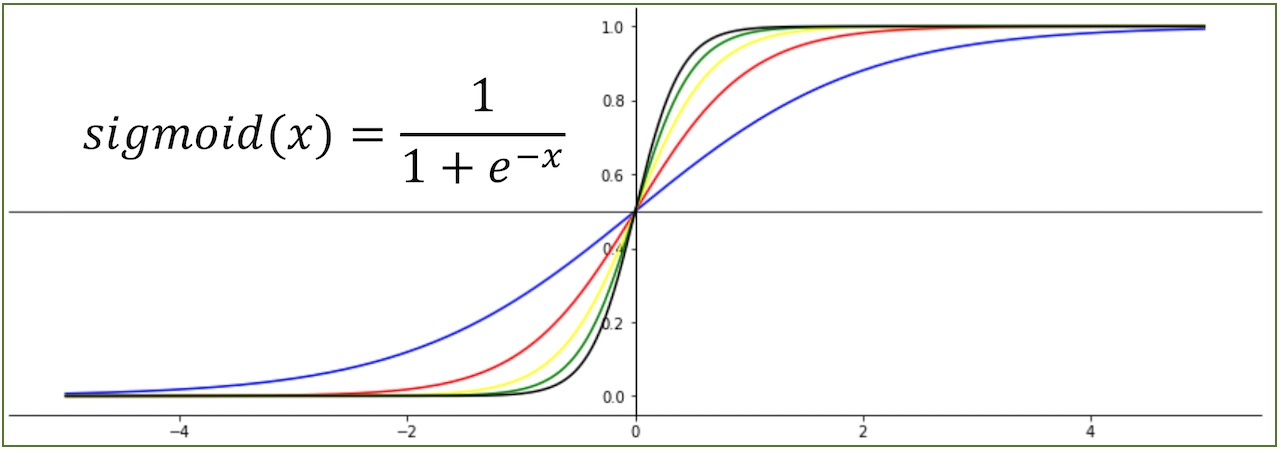

1. 시그모이드의 함수 식&그래프

1-1. 시그모이드는..

- 로지스틱(logistic) 함수의 한 케이스. 로지스틱 함수란 y값을 0과 1사이로 만드는 함수.

- 오직 1개의 인풋에 대해 1개의 아웃풋을 출력함.

- 아웃풋은 0~1사이의 값.

- 따라서 히든레이어의 활성화함수로 주로 사용됨.

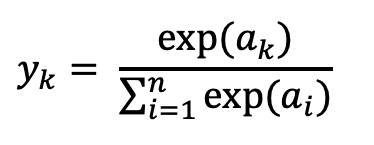

2. 소프트맥스의 함수 식/그래프

2-1. 소프트맥스는..

- 시그모이드의 확장형. 그래프는 시그모이드와 다를게 없음.

- 차이점은 n개의 인풋에 대해 n개의 결과값을 출력한다는 것.

- n개의 결과값은 0~1사이의 값이면서 동시에 결과값의 합은 항상 1임.

- 따라서 다중클래스 분류 모델의 마지막 활성화함수로 주로 사용됨.