EKS 에서 Fluent bit + Cloudwatch를 활용한 로깅 시스템 도입

Intro

기존 모놀리식 아키텍처인 소프트웨어를 마이크로 서비스 아키텍처로 마이그레이션 하는 작업을 수행하면서 인프라 환경도 기존 ECS가 아닌 EKS로 넘어가게 되었다.

EKS 에서 애플리케이션 컨테이너들의 로그들을 수집하기 위해서는 로그 수집을 수행하는 로그 수집기와 로그를 저장하고 Query할 수 있는 Data store 가 필요하다.

내부적으로 마이크로 서비스 아키텍처로 빠르게 넘어가야하는 피치 못할 상황이 있었기 때문에, EKS 환경에서 로깅 시스템을 빠르게 구축할 수 있는 Fluent bit + Cloudwatch를 도입 했던 과정을 소개하려고 한다.

Fluent bit & Aws Cloudwatch

Fluent bit 은 logstash, fluentbit, promtail 등 여러 로그 수집기 중 하나로 가볍고 분산 환경을 고려하여 만들어졌기 때문에 K8s의 로그 수집기로 많이 사용된다.

Aws CloudWatch 는 온프레미스, 하이브리드, 기타 클라우드 애플리케이션 및 인프라 리소스에 대한 데이터와 실행 가능한 인사이트를 제공하는 모니터링 및 관리 서비스이다. 우리의 경우 로그 수집 및 로그 쿼리에 사용하였지만, 실제로는 다양한 이벤트 데이터 및 성능 지표들을 수집할 수 있다. (E.g CPU 사용률, 데이터 전송 및 디스크 사용량 지표 등)

EKS 내 Fluent bit 배포

Fluent Bit를 DaemonSet 로그로 전송하도록 CloudWatch 설정 - Amazon CloudWatch

위 문서를 따라하면 손쉽게 설정할 수 있다.

- 우선

amazon-cloudwatchnamespace를 생성한다.

kubectl create ns amazon-cloudwatch- 클러스터 이름과 로그를 전송할 region 정보가 포함된 configmap을 생성한다.

ClusterName=cluster-name

RegionName=cluster-region

FluentBitHttpPort='2020'

FluentBitReadFromHead='Off'

[[ ${FluentBitReadFromHead} = 'On' ]] && FluentBitReadFromTail='Off'|| FluentBitReadFromTail='On'

[[ -z ${FluentBitHttpPort} ]] && FluentBitHttpServer='Off' || FluentBitHttpServer='On'

kubectl create configmap fluent-bit-cluster-info \

--from-literal=cluster.name=${ClusterName} \

--from-literal=http.server=${FluentBitHttpServer} \

--from-literal=http.port=${FluentBitHttpPort} \

--from-literal=read.head=${FluentBitReadFromHead} \

--from-literal=read.tail=${FluentBitReadFromTail} \

--from-literal=logs.region=${RegionName} -n amazon-cloudwatch위 Command에서 cluster-name, cluster-region을 자신의 클러스터 이름과 리전으로 바꿔주면 된다.

Fluent bit daemonset이 추후 이 configmap을 읽어들일 것이다.

- Fluent bit daemonset을 클러스터에 배포한다.

kubectl apply -f https://raw.githubusercontent.com/aws-samples/amazon-cloudwatch-container-insights/latest/k8s-deployment-manifest-templates/deployment-mode/daemonset/container-insights-monitoring/fluent-bit/fluent-bit.yamlfluentbit은 daemonset으로 설치되어 모든 노드에 항상 설치 및 실행된다.

- amaon-cloudwatch 네임스페이스로 이동해 fluent-bit daemonset이 있는지 확인한다.

kubectl config set-context --current --namespace=amazon-cloudwatch

kubectl get pod참고로 3번 step 의 링크에서는 fluent bit daemonset에 관한 설정이 포함되어 있다. daemonset에는 로그 관련된 설정이 담겨있으므로 필요 없는 로그 그룹을 따로 제거하거나, 더 수집하고 싶은 로그가 있거나 혹은 에러 로그의 멀티라인 처리를 하고 싶다면 설정을 커스터마이징 하기 위해 raw파일을 다운 받아서 해당 파일을 수정하고 kubectl apply -f file.yaml 을 통해 배포하면 된다.

파일 예시는 다음과 같다.

apiVersion: v1

kind: ServiceAccount

metadata:

name: fluent-bit

namespace: amazon-cloudwatch

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

name: fluent-bit-role

rules:

- nonResourceURLs:

- /metrics

verbs:

- get

- apiGroups: [""]

resources:

- namespaces

- pods

- pods/logs

- nodes

- nodes/proxy

verbs: ["get", "list", "watch"]

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding

metadata:

name: fluent-bit-role-binding

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: fluent-bit-role

subjects:

- kind: ServiceAccount

name: fluent-bit

namespace: amazon-cloudwatch

---

apiVersion: v1

kind: ConfigMap

metadata:

name: fluent-bit-config

namespace: amazon-cloudwatch

labels:

k8s-app: fluent-bit

data:

fluent-bit.conf: |

[SERVICE]

Flush 5

Grace 30

Log_Level info

Daemon off

Parsers_File parsers.conf

HTTP_Server ${HTTP_SERVER}

HTTP_Listen 0.0.0.0

HTTP_Port ${HTTP_PORT}

storage.path /var/fluent-bit/state/flb-storage/

storage.sync normal

storage.checksum off

storage.backlog.mem_limit 5M

@INCLUDE application-log.conf

@INCLUDE dataplane-log.conf

@INCLUDE host-log.conf

application-log.conf: |

[INPUT]

Name tail

Tag application.*

Exclude_Path /var/log/containers/cloudwatch-agent*, /var/log/containers/fluent-bit*, /var/log/containers/aws-node*, /var/log/containers/kube-proxy*

Path /var/log/containers/*.log

multiline.parser docker, cri

DB /var/fluent-bit/state/flb_container.db

Mem_Buf_Limit 50MB

Skip_Long_Lines On

Refresh_Interval 10

Rotate_Wait 30

storage.type filesystem

Read_from_Head ${READ_FROM_HEAD}

[INPUT]

Name tail

Tag application.*

Path /var/log/containers/fluent-bit*

multiline.parser docker, cri

DB /var/fluent-bit/state/flb_log.db

Mem_Buf_Limit 5MB

Skip_Long_Lines On

Refresh_Interval 10

Read_from_Head ${READ_FROM_HEAD}

[INPUT]

Name tail

Tag application.*

Path /var/log/containers/cloudwatch-agent*

multiline.parser docker, cri

DB /var/fluent-bit/state/flb_cwagent.db

Mem_Buf_Limit 5MB

Skip_Long_Lines On

Refresh_Interval 10

Read_from_Head ${READ_FROM_HEAD}

[FILTER]

Name kubernetes

Match application.*

Kube_URL https://kubernetes.default.svc:443

Kube_Tag_Prefix application.var.log.containers.

Merge_Log On

Merge_Log_Key log_processed

K8S-Logging.Parser On

K8S-Logging.Exclude Off

Labels Off

Annotations Off

Use_Kubelet On

Kubelet_Port 10250

Buffer_Size 0

[OUTPUT]

Name cloudwatch_logs

Match application.*

region ${AWS_REGION}

log_group_name /aws/containerinsights/${CLUSTER_NAME}/application

log_stream_prefix ${HOST_NAME}-

auto_create_group true

extra_user_agent container-insights

dataplane-log.conf: |

[INPUT]

Name systemd

Tag dataplane.systemd.*

Systemd_Filter _SYSTEMD_UNIT=docker.service

Systemd_Filter _SYSTEMD_UNIT=containerd.service

Systemd_Filter _SYSTEMD_UNIT=kubelet.service

DB /var/fluent-bit/state/systemd.db

Path /var/log/journal

Read_From_Tail ${READ_FROM_TAIL}

[INPUT]

Name tail

Tag dataplane.tail.*

Path /var/log/containers/aws-node*, /var/log/containers/kube-proxy*

multiline.parser docker, cri

DB /var/fluent-bit/state/flb_dataplane_tail.db

Mem_Buf_Limit 50MB

Skip_Long_Lines On

Refresh_Interval 10

Rotate_Wait 30

storage.type filesystem

Read_from_Head ${READ_FROM_HEAD}

[FILTER]

Name modify

Match dataplane.systemd.*

Rename _HOSTNAME hostname

Rename _SYSTEMD_UNIT systemd_unit

Rename MESSAGE message

Remove_regex ^((?!hostname|systemd_unit|message).)*$

[FILTER]

Name aws

Match dataplane.*

imds_version v1

[OUTPUT]

Name cloudwatch_logs

Match dataplane.*

region ${AWS_REGION}

log_group_name /aws/containerinsights/${CLUSTER_NAME}/dataplane

log_stream_prefix ${HOST_NAME}-

auto_create_group true

extra_user_agent container-insights

host-log.conf: |

[INPUT]

Name tail

Tag host.dmesg

Path /var/log/dmesg

Key message

DB /var/fluent-bit/state/flb_dmesg.db

Mem_Buf_Limit 5MB

Skip_Long_Lines On

Refresh_Interval 10

Read_from_Head ${READ_FROM_HEAD}

[INPUT]

Name tail

Tag host.messages

Path /var/log/messages

Parser syslog

DB /var/fluent-bit/state/flb_messages.db

Mem_Buf_Limit 5MB

Skip_Long_Lines On

Refresh_Interval 10

Read_from_Head ${READ_FROM_HEAD}

[INPUT]

Name tail

Tag host.secure

Path /var/log/secure

Parser syslog

DB /var/fluent-bit/state/flb_secure.db

Mem_Buf_Limit 5MB

Skip_Long_Lines On

Refresh_Interval 10

Read_from_Head ${READ_FROM_HEAD}

[FILTER]

Name aws

Match host.*

imds_version v1

[OUTPUT]

Name cloudwatch_logs

Match host.*

region ${AWS_REGION}

log_group_name /aws/containerinsights/${CLUSTER_NAME}/host

log_stream_prefix ${HOST_NAME}.

auto_create_group true

extra_user_agent container-insights

parsers.conf: |

[PARSER]

Name syslog

Format regex

Regex ^(?<time>[^ ]* {1,2}[^ ]* [^ ]*) (?<host>[^ ]*) (?<ident>[a-zA-Z0-9_\/\.\-]*)(?:\[(?<pid>[0-9]+)\])?(?:[^\:]*\:)? *(?<message>.*)$

Time_Key time

Time_Format %b %d %H:%M:%S

[PARSER]

Name container_firstline

Format regex

Regex (?<log>(?<="log":")\S(?!\.).*?)(?<!\\)".*(?<stream>(?<="stream":").*?)".*(?<time>\d{4}-\d{1,2}-\d{1,2}T\d{2}:\d{2}:\d{2}\.\w*).*(?=})

Time_Key time

Time_Format %Y-%m-%dT%H:%M:%S.%LZ

[PARSER]

Name cwagent_firstline

Format regex

Regex (?<log>(?<="log":")\d{4}[\/-]\d{1,2}[\/-]\d{1,2}[ T]\d{2}:\d{2}:\d{2}(?!\.).*?)(?<!\\)".*(?<stream>(?<="stream":").*?)".*(?<time>\d{4}-\d{1,2}-\d{1,2}T\d{2}:\d{2}:\d{2}\.\w*).*(?=})

Time_Key time

Time_Format %Y-%m-%dT%H:%M:%S.%LZ

---

apiVersion: apps/v1

kind: DaemonSet

metadata:

name: fluent-bit

namespace: amazon-cloudwatch

labels:

k8s-app: fluent-bit

version: v1

kubernetes.io/cluster-service: "true"

spec:

selector:

matchLabels:

k8s-app: fluent-bit

template:

metadata:

labels:

k8s-app: fluent-bit

version: v1

kubernetes.io/cluster-service: "true"

spec:

containers:

- name: fluent-bit

image: public.ecr.aws/aws-observability/aws-for-fluent-bit:stable

imagePullPolicy: Always

env:

- name: AWS_REGION

valueFrom:

configMapKeyRef:

name: fluent-bit-cluster-info

key: logs.region

- name: CLUSTER_NAME

valueFrom:

configMapKeyRef:

name: fluent-bit-cluster-info

key: cluster.name

- name: HTTP_SERVER

valueFrom:

configMapKeyRef:

name: fluent-bit-cluster-info

key: http.server

- name: HTTP_PORT

valueFrom:

configMapKeyRef:

name: fluent-bit-cluster-info

key: http.port

- name: READ_FROM_HEAD

valueFrom:

configMapKeyRef:

name: fluent-bit-cluster-info

key: read.head

- name: READ_FROM_TAIL

valueFrom:

configMapKeyRef:

name: fluent-bit-cluster-info

key: read.tail

- name: HOST_NAME

valueFrom:

fieldRef:

fieldPath: spec.nodeName

- name: HOSTNAME

valueFrom:

fieldRef:

apiVersion: v1

fieldPath: metadata.name

- name: CI_VERSION

value: "k8s/1.3.16"

resources:

limits:

memory: 200Mi

requests:

cpu: 500m

memory: 100Mi

volumeMounts:

# Please don't change below read-only permissions

- name: fluentbitstate

mountPath: /var/fluent-bit/state

- name: varlog

mountPath: /var/log

readOnly: true

- name: varlibdockercontainers

mountPath: /var/lib/docker/containers

readOnly: true

- name: fluent-bit-config

mountPath: /fluent-bit/etc/

- name: runlogjournal

mountPath: /run/log/journal

readOnly: true

- name: dmesg

mountPath: /var/log/dmesg

readOnly: true

terminationGracePeriodSeconds: 10

hostNetwork: true

dnsPolicy: ClusterFirstWithHostNet

volumes:

- name: fluentbitstate

hostPath:

path: /var/fluent-bit/state

- name: varlog

hostPath:

path: /var/log

- name: varlibdockercontainers

hostPath:

path: /var/lib/docker/containers

- name: fluent-bit-config

configMap:

name: fluent-bit-config

- name: runlogjournal

hostPath:

path: /run/log/journal

- name: dmesg

hostPath:

path: /var/log/dmesg

serviceAccountName: fluent-bit

tolerations:

- key: node-role.kubernetes.io/master

operator: Exists

effect: NoSchedule

- operator: "Exists"

effect: "NoExecute"

- operator: "Exists"

effect: "NoSchedule"나의 경우 특정 pod 은 fargate 를 사용했기 때문에 해당 노드에는 스케줄 되지 않도록 anti-affinity를 추가하였다. (왜냐하면 fargate에는 daemonset을 설치할 수 없기 때문이다.)

또 data-plane 로그는 사용할 일이 없는 것 같아서 configuration에서 제외했다.

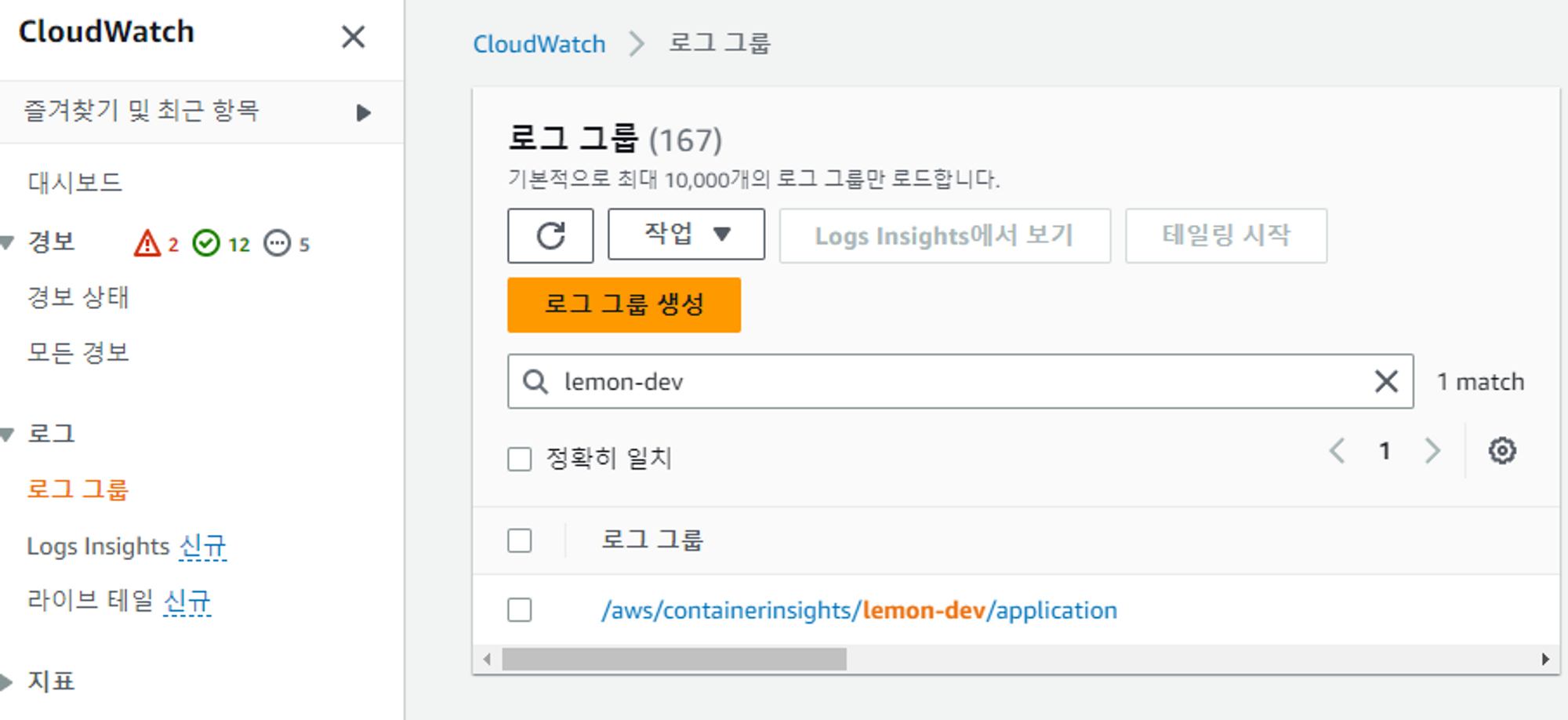

다 설정한 후 배포한 다음 Cloudwatch 콘솔에 들어가면 다음과 같이 로그 그룹이 생긴다.

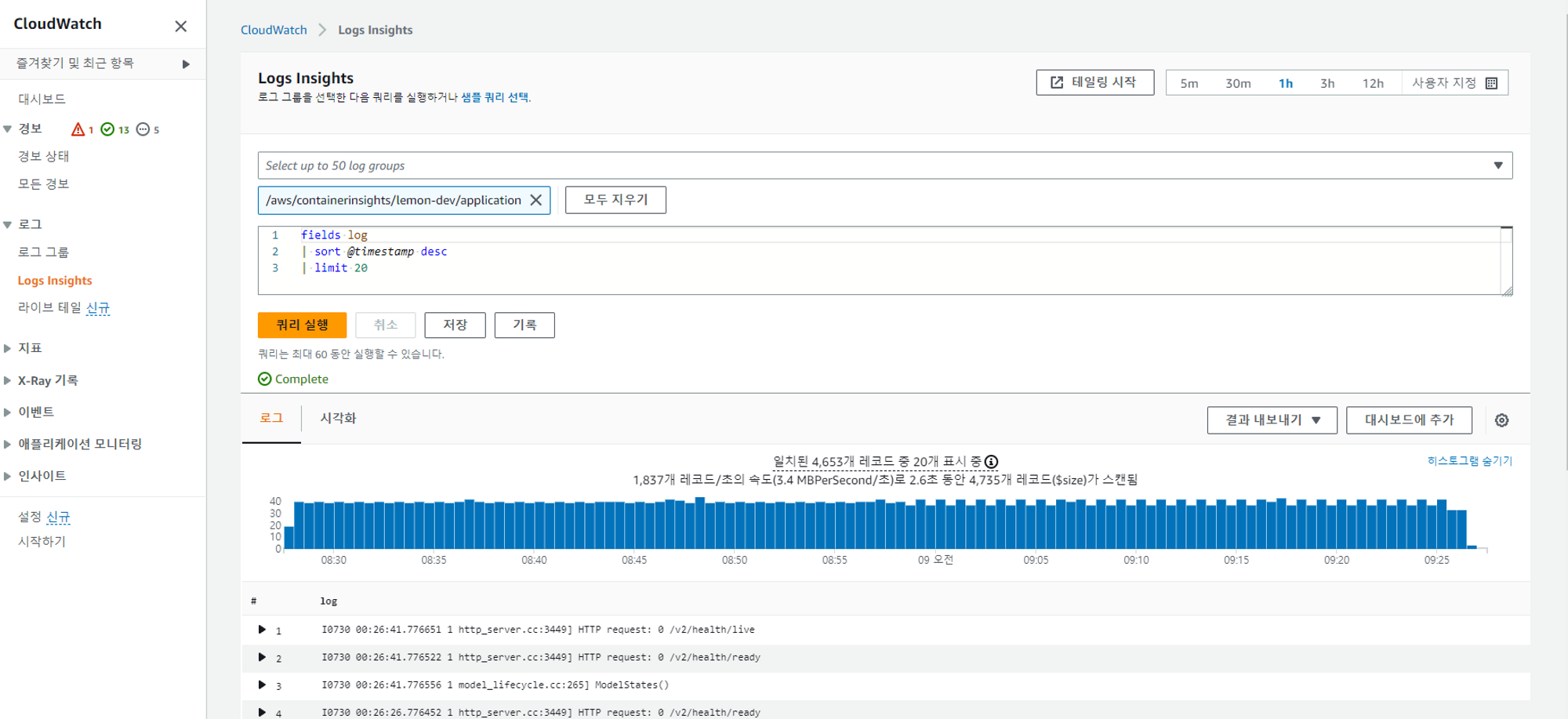

왼쪽 패널의 Logs insights 에서 로그 그룹을 선택한 후 Aws Cloudwatch 전용 쿼리 문법을 통해 원하는 로그를 필터링할 수 있다.

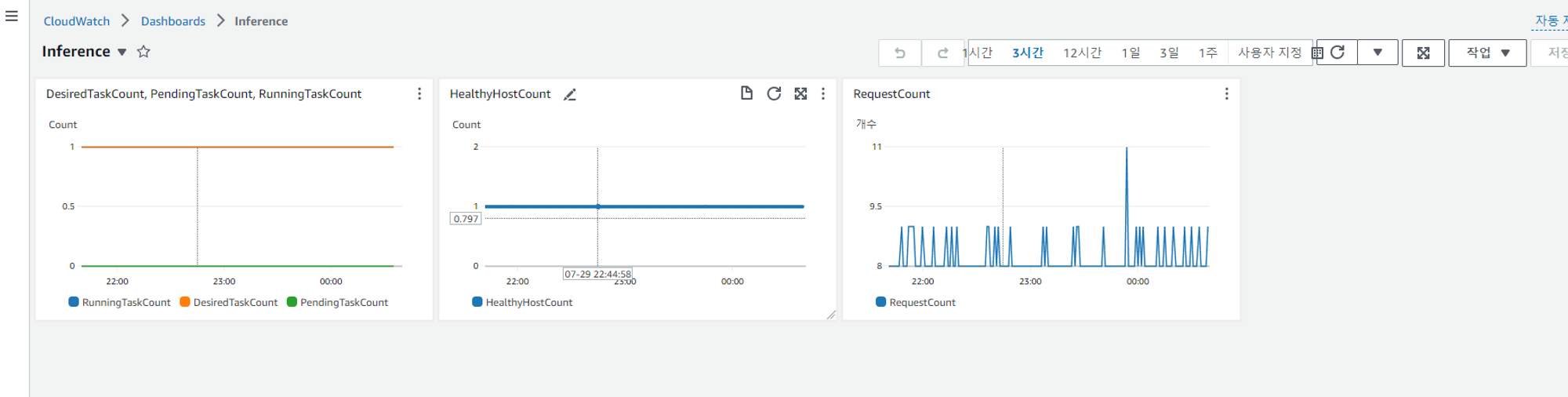

로그를 가지고 대시보드를 구성할 수도 있다.

결론

Aws 문서가 워낙 잘되어 있어서 EKS 환경에서 Fluentbit + Cloudwatch를 통해 애플리케이션 컨테이너의 로그를 수집하는 로깅 시스템을 쉽고 빠르게 구축할 수 있었다. 특히 Cloudwatch는 데이터를 저장하는 Data store를 내가 프로비저닝 할 필요가 없는 관리형 서비스이기 때문에 구축하기도 쉽고 운영하기도 쉽다는 장점이 있었다.

그러나 Fluentbit + Cloudwatch 조합은 더이상 사용하지 않고 promtail + loki + grafana로 넘어가게 되었다. 그 이유는 EKS 내 노드 및 Pod 모니터링 툴로 prometheus + grafana 를 선택하였는데, 로그 관련된 대시보드도 grafana에 통합시켜야 보기 편했기 때문이다. 물론 grafana에서 다양한 data source를 지원하고 Aws Cloudwatch도 지원하였으나 대시보드 몇 개만 구축해도 쿼리하는 데이터 양도 방대하고 Cloudwatch 밖으로 나가는 데이터도 방대하기 때문에 cloudwatch 비용이 천문학적으로 증가하는 문제점이 있었다. 따라서 구축하는 데 조금의 공수가 들더라도 로그 데이터를 클러스터 내 인프라에 저장하고 Grafana와 쉽게 연동할 수 있는 Loki를 도입하게 되었다.

기회가 된다면 promtail + loki + grafana 를 통해 MSA 환경에서 로깅 시스템을 구축한 기록도 공유해보고자 한다.