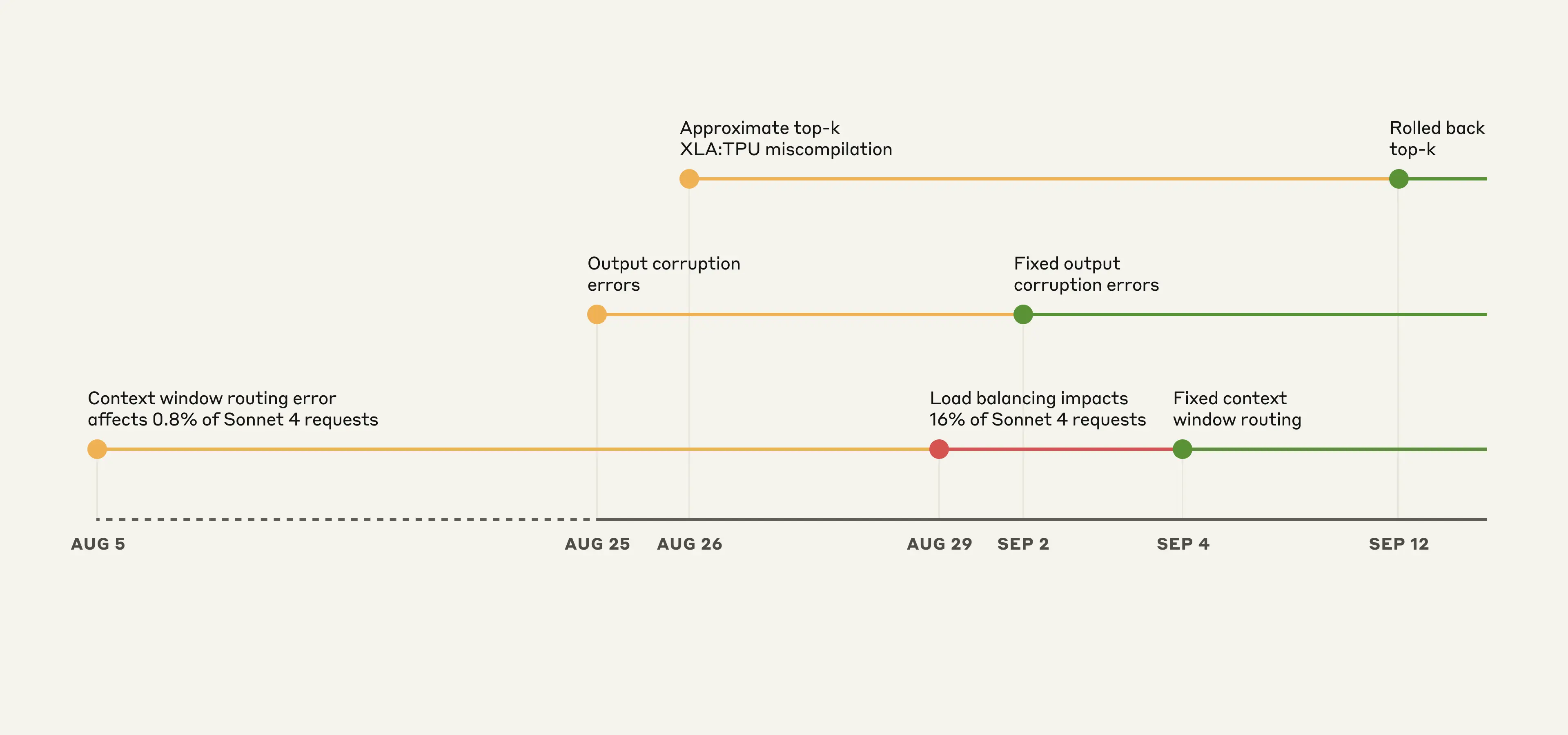

골치 아픈 버그가 하나 터졌다. 대형 모델 서빙할 때, JAX 쓰고 TPU로 돌리니까 XLA 컴파일러에서 이상한 정밀도(16비트-32비트) 엇갈림 때문에, 가장 확률 높은 토큰이 아예 누락되는 등, 한참 동안 아무도 알아채지 못했던 이상 버그가 간헐적으로 등장한 거다.

솔직히 말하면, NVIDIA 서버에 PyTorch만 썼으면 이런 일 진짜 거의 없었을 거다.

오히려 JAX+TPU+XLA라는 최신(?) 조합이 아니었으면, 누구나 원인 짚고 패치하기 쉬웠다. PyTorch는 개발자 수, 디버깅 편의성, 정밀도 자동 관리를 이미 수년간 검증받았다.

앞으로도 AMD든, 뭐든 새로운 하드웨어&프레임워크 쓰면 비슷한 꼬인 버그 만날 확률 정말 높다.

결국 진짜 중요한 건, 코드를 누구보다 멋지게 짜는 것도 아니고, 가장 적합한 '도구'와 아키텍처, 그리고 제대로 동작하는지 일찍 알아낼 수 있는 환경과 습관이다.

아직까지는 NVIDIA+PyTorch. 이 조합이 실패 없는 안전빵이고, 새로운 플레잉필드에선 막연한 혁신보다, 검증된 프레임워크와 개발 생태계가 훨씬 더 중요하다.

앞으로 변화 더 빨라진다면, 괜히 최신 기술 따라가다 내 일자리까지 털릴 수 있으니, 자기가 쓰는 도구와 플랫폼의 한계, 버그까지 미리 파악해두는 사람이 진짜로 살아남는다.