https://www.jeremyjordan.me/autoencoders/

-

Q. Autoencoder 에 대해 설명해보세요.

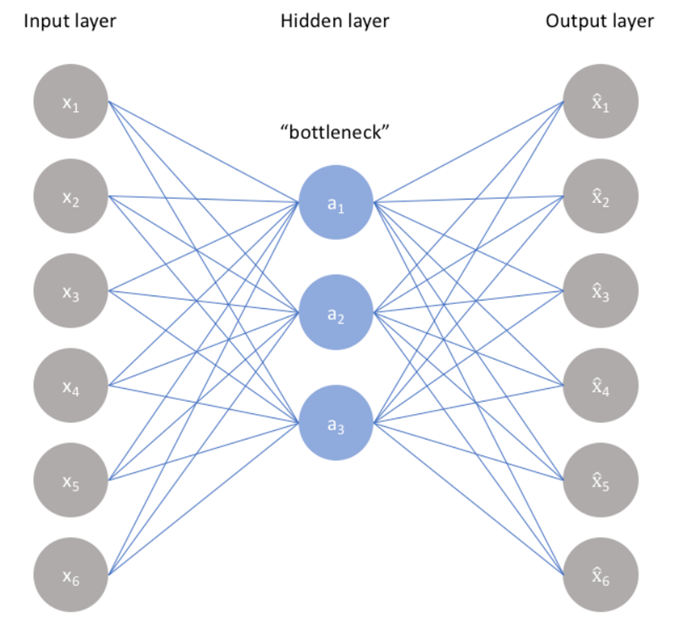

A. Autoencoder 이란 딥러닝 모델에서 흔히 latent layer, bottleneck layer 을 이용해 데이터의 high dimensional information 을 뽑아낼때 사용합니다. 이는 representation learning 에서 처음 제시되었지만 현재는 딥러닝에 아주 넓은 분야에 사용되고 있습니다. -

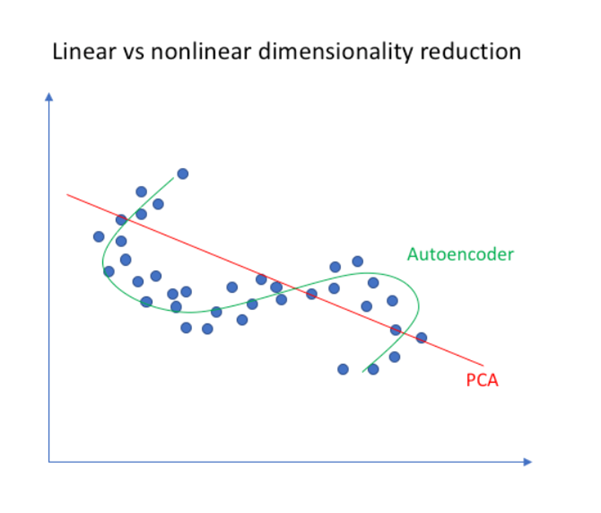

Q. AutoEncoder 와 PCA 의 관계에 대해 설명해보세요.

A. 두 기법은 차원 축소를 한다는 점에서 공통점을 가지고 있습니다. 하지만 PCA 은 linearly 하게 최대한의 정보량을 보존하는 벡터를 파악하고 그와 orthogonal 한 관계의 벡터를 계속해서 파악해가는 방식이라면, AutoEncoder 은 nonlinear activation function 등을 이용해 nonlinear 한 관계까지 파악할 수 있습니다.

Autoencoders.

Autoencoders 은 사실 거의 모든 딥러닝 모델에 기본적으로 접목이 되어있는 개념이다. 이러한 Autoencoder 은 bottleneck layer, 또는 latent space 을 통해 high dimensional characteristic 을 찾는데 목적을 두고 있다.

예시로는 인간은 다른 사람의 얼굴을 눈코입의 모양과 크기 등을 통해 파악을 한다. 하나하나의 픽셀값으로 파악하지 않고 대략적이며 큰 특징들을 이용해 알아본다. 인간에게는 이 과정이 자연스럽고 쉽지만 기계에게 이 과정을 공부하게 만드는 것은 그리 쉽지만은 않다.

이 과정을 구현한 것이 autoencoder 이다. autoencoder 에서의 latent layer 이 이제 눈, 코, 입 등을 파악한다. 중요변수들을 파악하는 것이다. 이를 통해 데이터의 전체적인 성향을 파악할 수 있고 자잘한 redundant 한 feature 들은 제외할 수 있는 것이다.

< 출처 >

https://www.jeremyjordan.me/autoencoders/

Autoencoder 을 사실 PCA 와 연관 지을 수 있다. PCA 은 linear 하게만 적용이 가능하지만 AE 는 activation function 들을 통해 nonlinear 하게 차원축소가 가능한 것이다.

Notes

Autoencoders are used mostly in representation learning. Or in other words, finding the latent characteristics of a specific dataset.

“The bottlencek imposes a compressed knowledge representation of the original input.” One good example of this would be face data. Latent dimensions would include eye size and shape, mouth size and shape and so on. While we humans can find these characterstics with ease, computers with only pixel inputs as data cannot do this as easily. Therefore, autoencoders impose a bottleneck layer and impose learning these important features.

The learning of an autoencoder can be said as a reconstruction of the original input x. Minimizing the reconstruction error between the estimated value and true value. Without a bottleneck, if all layers were of the same size, then the network would simply memorize the dataset, leading to overfitting. We can see an autoencoder with non-linear activation functions as a PCA that can take nonlinearity into account.