NLG (Natural Language Generation)

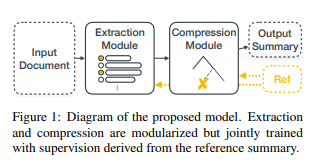

NLG extractive summarization task

- Document에서 중요한 내용을 추출해 요약문을 return 하는 task

- input (원문)에서 중요한 문장을 extract 하여 그대로 반환하는 특징을 가진다.

Dataset

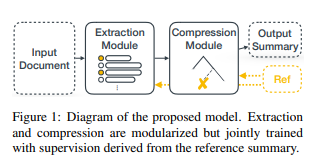

CNN/Daily mail

Human generated abstractive summary bullets were generated from news stories in CNN and Daily Mail websites as questions (with one of the entities hidden), and stories as the corresponding passages from which the system is expected to answer the fill-in the-blank question. The authors released the scripts that crawl, extract and generate pairs of passages and questions from these websites.

- 286,817개의 training, 13,368 validation, 11,487 test pairs 로 이루어져 있으며 abstrative summarization 과 extractive summarization 에 모두 용이 하다.

- 각 document 마다 요약본 과 문장 중요도에 따라 highlight 으로 구성되며 highlighting 된 문장들이 target으로 설정된다.

SOTA models

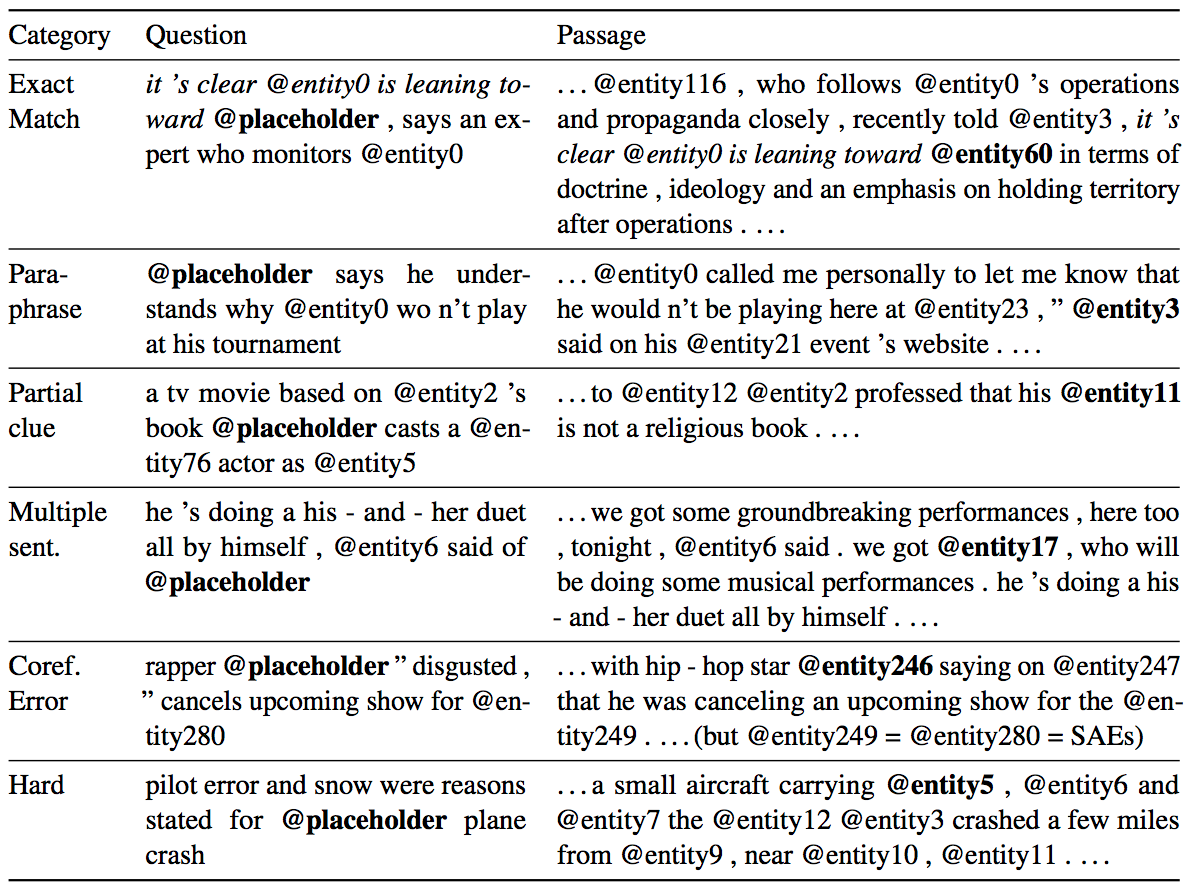

BART

- BERT에도 적용된 Masked language model과 denoising autoencoder을 통한 텍스트 재생성 기술의 결합

- seq2seq 구조로 구성되며 pre-trainning은 noise function으로 손상된 text를 복구하며 모델을 학습

- 특정 task에 집중하여 적용할 수 있는 분야가 한정되는 단점을 가지고 있음.

Main Keyword : seq2seq, denosing autoencoder, noise functionMatchSum

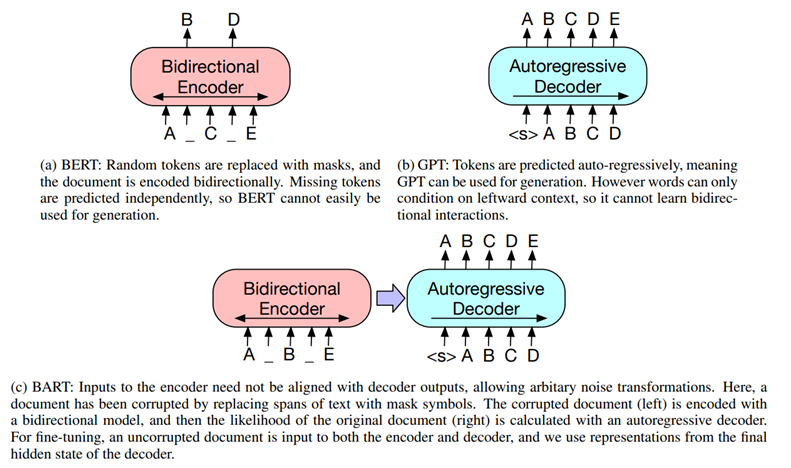

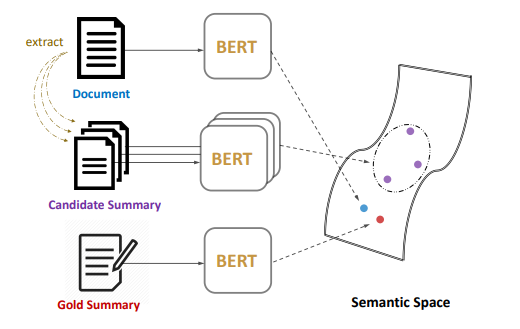

- 문장별로 중요도 score을 평가하여 요약을 만들어내는 기존 deep learning 과는 달리 matchSum은 semantic text matching을 통하여 문서와 문서의 추출에서 얻는 candidate 요약문들을 semantic space상에서 매칭함

Main Keyword : semantic text matching, semantic spaceRefrences