🔎 비트(Bit)

- 컴퓨터가 처리할 수 있는 가장 작은 단위

- 숫자 0, 1 즉

binary digit만 담을 수 있다.

🔎 바이트(Byte)

- 1Byte = 8bits 로 0~255(256)의 데이터를 표현할 수 있다.

- 컴퓨터 프로그래밍에서는 1Byte을

가장 최소의 단위로 잡고 있다.

1byte × 1024 = 1KB

1KB × 1024 = 1MB

1MB × 1024 = 1GB

1GB × 1024 = 1TB

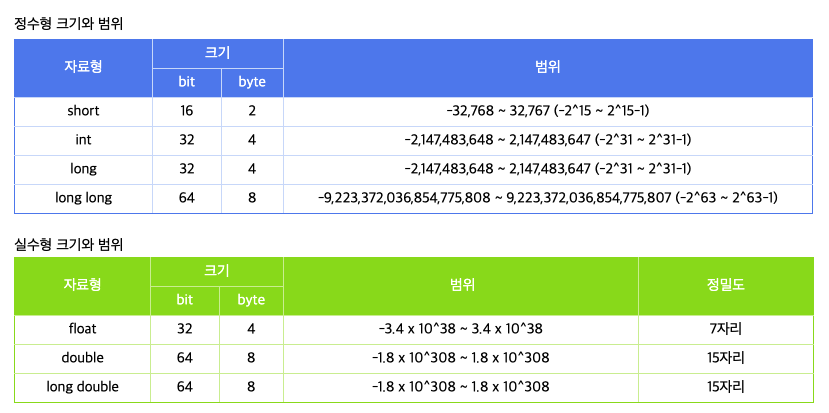

💡 프로그래밍 언어의 경우 변수를 선언할 때 어떤 데이터 타입이냐에 따라 메모리 공간 크기가 달라진다.

즉 1과 같이 한 자리 데이터를 담을꺼면서 2byte 4byte의 데이터 타입을 지정하게 되면 메모리가 낭비된다.

c언어의 경우 데이터 타입에 따라

🔎 텍스트 인코딩

- 사람의 문자를 컴퓨터가 알아볼 수 있는

Binary Type(2진수)로 바꿔주는 것을 문자 인코딩이라 하며 이를 저장한 형태, 표를 character set이라고 부른다.

📌 UTF-8 (Unicode Transformation For Mat - 8 bit)

-

국제적으로 전세계 언어를 모두 표시할 수 있는 표준코드로 가장 범용적으로 많이 쓰이는 방식이

UTF-8방식이다. -

가변길이 유니코드 인코딩 길이가 정해져 있지 않고 필요에 따라 길어질 수 있는 인코딩 방식

-

유니코드는 최소 2Byte, 최대 4Byte 까지 표현할 수 있다.

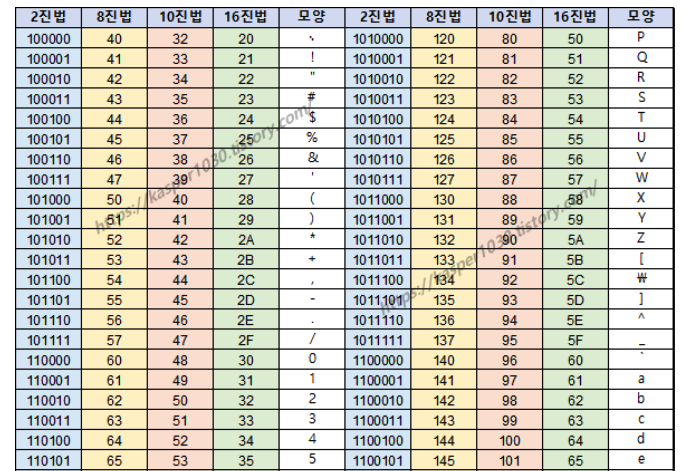

📌 아스키 코드

- 각 문자열은 1byte 크기로 영어 알파벳, 몇가지 특수 기호 등을 2진수로 바꾸는 character set 이다.

- 하지만 ASCII의 경우 알파벳만을 담고 있고 전 세계에 존재하는 다국어, 다양한 문자열의 경우 ASCII로 표현될 수 없다.