저장소 지정(workers) 하기

cd ~/hadoop/etc/hadoop에서 vim workersdatanode1, datanode2, datanode3 입력

workers 파일 복사(scp 사용법)

scp [파일대상][서버][서버의 파일경로]

scp ./workers namenode:/home/hadoop/hadoop/etc/hadoop/ (namenode, secondnode, datanode3 모두 같은 명령어 실행)다른 서버끼리 미리 ssh 연결되어 있어야 scp 명령어 사용 가능

이 작업을 완료하면 worker 노드를 식별하고 클러스터의 구성을 설정, 작업 분산을 할 수 있음

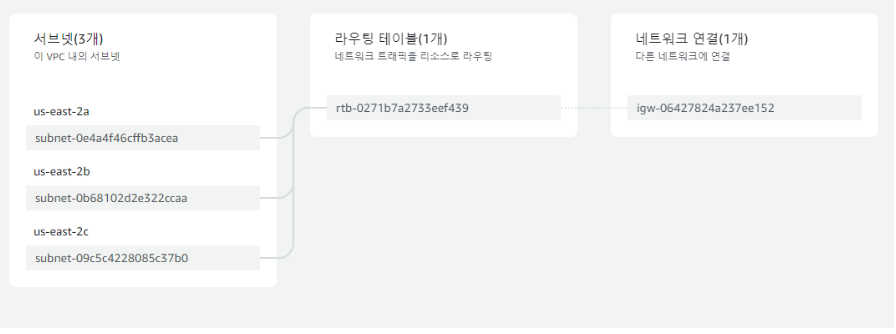

하둡 서버의 resource map

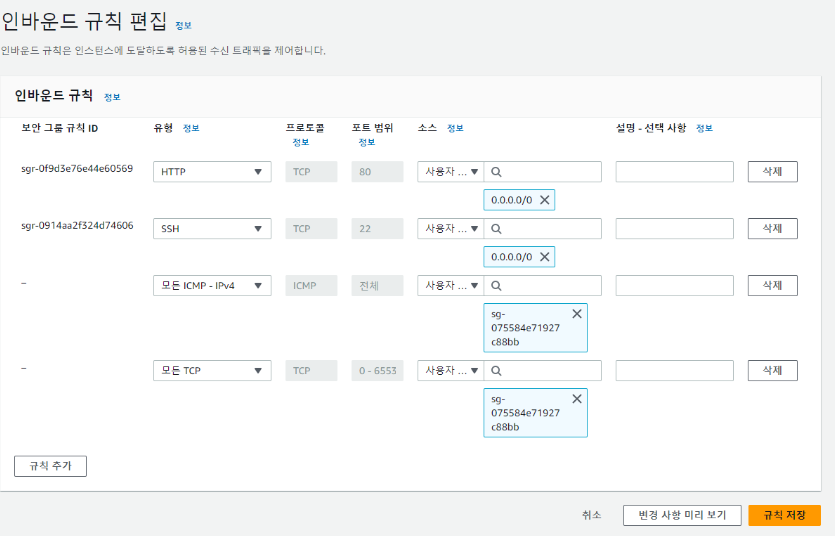

ec2 보안그룹 설정

인바운드 규칙 추가

hadoop이 형성된 인스턴스의 보안그룹으로 설정하면 ping datanode3을 했을 때, 핑이 날라가는 걸 확인할 수 있음

hadoop format

ssh namenode

hadoop namenode -format #namenode 초기화hadoop 클러스터를 처음 설정할때 또는 데이터를 삭제하고 새로운 클러스터를 구성할 때 사용

namenode에 어떤 파일이 어디에 저장되고 정보를 저장하는 장부 역할을 수행

그 장부를 초기화해서 내용을 쓸 준비를 하는 과정

start-dfs

sssh namenode

start-dfs.sh : 분산파일시스템(HDFS)의 서비스를 시작jps : 자바프로세스를 알려주는 명령어

jps를 입력하면 Namenode, Jps, Datanode가 출력됨

start-yarn

ssh secondnode

start-yarn.shyarn은 지원부서같은 개념, 한 node가 빡세면 다른곳으로 보내주는 개념

jps를 입력하면 Datanode, Nodemanager, Jps, Resourcemanager, secondaryNamenode가 출력됨

start-mr

mr-jobhistory-daemon.sh start historyserver

jps입력 시 Datanode, Jps, Nodemanager가 출력됨

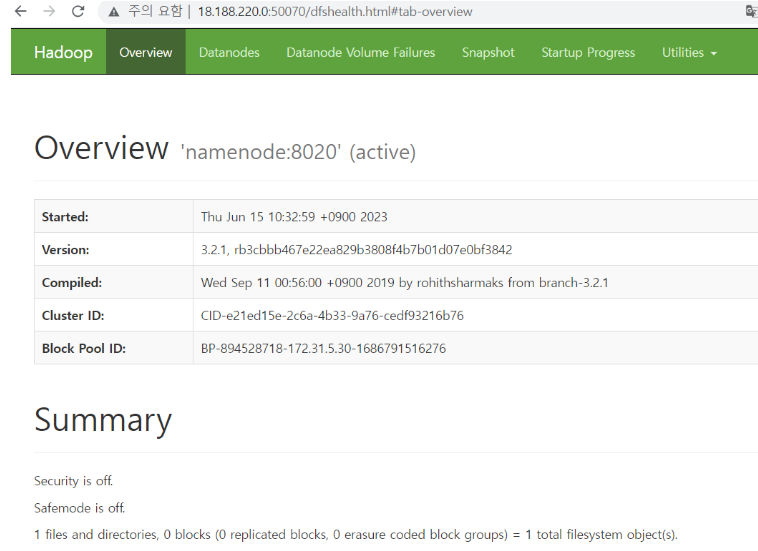

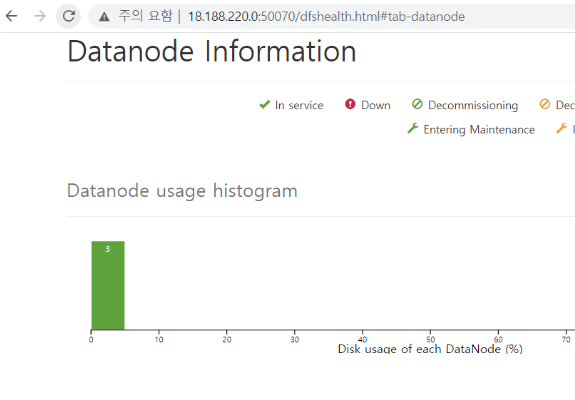

hadoop 상태 확인 페이지

보안그룹 인바운드 규칙 추가

50070 포트로 소스는 0.0.0.0/0으로 시정하고 규칙 추가

hadoop 상태 확인하는 페이지 열기

주소창에 namenode public IP:50070 입력

하둡 로그 확인

cd hadoop/logs에서 log를 확인할 수 있음

대문자 G - 맨끝으로가기

소문자 gg - 맨 처음으로 가기

tail을 맨 앞에 붙이면 해당 파일의 끝부분만 보여줌, 끝에 3줄만 보고 싶으면 명령어 맨 뒤에 -n 3를 붙여줌

log파일을 vim으로 열어서 error가 뜨는 부분을 확인

명령어 쉽게 사용하기

ssh namenode stop-dfs.sh, ssh secondnode start-yarn.sh같은 명령어를 쉽게 사용하기 위해 별칭 설정

vim ~/.bashrc 입력하고 아래 부분을 추가

alias start-dfs="ssh namenode start-dfs.sh"

alias start-yarn="ssh secondnode start-yarn.sh"

alias stop-dfs="ssh namenode stop-dfs.sh"

alias stop-yarn="ssh secondnode stop-yarn.sh"

alias start-mr="ssh namenode mr-jobhistory-daemon.sh start historyserver"

alias stop-mr="ssh namenode mr-jobhistory-daemon.sh stop historyserver"