크롤링에 대한 정보는 따로 작성해서 게시글에 올려놓은 것이 있다.

요기!

크롤링은 잘못 하면 불법이다!

크롤링에 대한 공부를 하고 나서 막 여기저기 사이트의 정보를 가져와보고 싶은 마음은 이해할수 있지만, 그렇다고 아무거나, 혹은 아무데나 정보를 가져오면 불법이 된다.

그럼 어떻게 하지?

수집해도 되는 문제없는 저옵인디, 수집하면 안되는 정보인지 확인하는 방법은, 해당사이트에 존재하는 "robots.txt"이라는 파일을 참조한다.

robots.txt 파일은 무분별한 크롤링을 막고 제어하기 위해서 만들어졌는데, 이 파일은 사람이 보라고 만든게 아니라 크롤링을 하는 검색엔진 복들이 이 파일을 참고해서 크롤링이 가능한지 아닌지의 여부를 판단하는 것이다. 따라서 자신이 해당 사이트의 정보를 가져오기 전에 반드시 robots.txt파일을 확인해야한다.

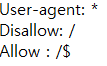

robots.txt 형식

user-agent: <- 검색 봇 이름

Disallow: <- 접근 설정

Crwl-delay: <- 다음 방문까지의 지연시간

예를 들어서 네이버의 robots.txt를 읽어보자. 읽는 방법은 해당 사이트 url의 뒤에 /robots/txt라고 추가하여 엔터를 누르면 robots.txt 파일을 다운로드 받아볼수 있다.

https://www.naver.com/robots.txt

이렇게 작성하고 검색을하면 파일이 나타난다.

파일의 내용을 보면

위의 내용은 모든 검색 엔진로봇에 대해서 해당 사이트의 루트페이지만 수집 허용으로 설정한 것이다.

다른 rotox.txt의 규칙에 대한 정보는 아래의 링크를 남겨놓았으니 참고할 것.