Natural Language Understanding (NLU)

- NLP에는 NLU와 NLG가 있다.

NLU(Natural Language Understanding) 자연어 이해: 언어를 이해하는 기술.

NLG(Natural Language Generation) 자연어 생성: 새로운 언어를 생성하는 기술.

오늘은 그 중 NLU에서 관심 있는 task에 대해 간략하게 정리해봈다.

1. Paraphrase Identification

문제 정의

- 두 개의 context가 같은 의도를 가졌는지의 여부를 판별한다.

- 기업 입장에서 소비자가 유사한 질문을 할 경우, 기존의 context data를 토대로 일치여부를 판별하여 answer를 제공할 수 있다.

Charformer

- 모델: soft grandient-based subword tokenization (GBST)를 사용하여 단어의 토크나이징이 아닌, 더 하위 레벨인 character 단위의 특징과 위치 임베딩을 사용하여 학습한 모델이다. 노이즈가 있는 단어(오탈자 등) 에서 강한 성능을 보인다고 한다.

- 논문: Charformer: Fast Character Transformers via Gradient-based Subword Tokenization

- 코드: Charformer

- 키워드: paraphrase identification, sentiment textual similarity,

- 학습 자료: 유튜브

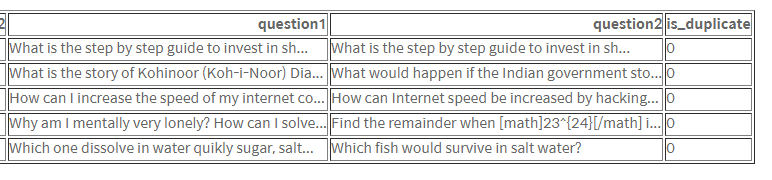

데이터

- Quora Question Paris

- 사용자가 직접 질문하고 답변하는 커뮤니티 사이즈 (like 지식인)에서 제공하는 데이터로, 중복 질문 식별 여부를 판단하기 위해 데이터를 공개했다.

- data_detail

2. Semantic Textual Similarity

문제 정의

- 두 개의 context의 유사도를 판별하는 task이다.

- 추천시스템에서 어떻게 쓰일까❓

영화/책의 줄거리 유사성이나, item의 상세글 유사성으로 비슷한 아이템인지 판별할 수 있을 것이다.- x_train: 두 개의 contexts

- y_label : 1~5까지 유사성을 점수 메긴 score

SMART-RoBERTa

- 모델: Transformer를 기반으로 한 RoBERT모델의 진화 버전. Semantic Textual Similarity, Sentiment Analysis, Natural Lnaguage Inference 등에서 좋은 성능을 보인 SOTA 모델이다. 기존의 pre-trained 모델은 용량이 너무 크다는 단점이 존재하고, 해당 모델에서 이를 극복하기 위해 Smoothness-Inducing Adversarial Regularization과 Bregman Proximal Point Optimization을 도입한다.

- Single Model을 기준으로 3개의 GLUE Subtask에서 약 30배의 Parameter 수의 차이를 보이는 T5를 상회하는 성능을 기록하였고, MT-DNN과의 Ensemble을 통해 GLUE Benchmark 평균 성능에서 T5를 상회하는 성능을 기록하고, State-of-the-art를 갱신한 모델이다.

- 논문: SMART: Robust and Efficient Fine-Tuning for Pre-trained Natural Language Models through Principled Regularized Optimization

- 코드: 깃헙의 namisan/mt-dnn

- 키워드: Linguistic Acceptability, Natural Language Inference, Semantic Textual Similarity, Sentiment Analysis, Transfer Learning

- 학습 자료: 유튜브

데이터

- Sementic Textual Similarity Benchmark(STS-B)

- 영어로 구성되어 있다. 이미지 캡션, 뉴스 헤드라인 및 사용자 포럼의 텍스트가 포함된다.

Charformer의 작동 원리를 보니 더 다양한 곳에 쓸 가능성이 있어 보이네요. 잘 읽었습니다:)