Rectified Linear Unit(ReLU)

ReLU는 Rectified Linear Unit의 약자로, 인공 신경망에서 사용되는 활성화 함수 중 하나입니다. ReLU 함수는 입력이 양수인 경우에는 입력 값을 그대로 출력하고, 음수인 경우에는 0으로 출력하는 간단한 비선형 함수입니다.

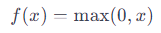

ReLU 함수 수식 :

여기서 x는 입력 값이고, f(x)는 출력 값입니다.

ReLU 함수의 장점 :

비선형성(Non-linearity): ReLU는 비선형 함수로서, 모델이 복잡한 데이터의 패턴을 학습할 수 있도록 돕습니다. 이는 다층 퍼셉트론(MLP)과 같은 다층 신경망에서 매우 중요합니다.

계산 효율성: ReLU 함수는 간단한 수식을 가지고 있으며, 양수 값에 대해서는 그대로 전파되므로 미분이 연속적이고 계산이 효율적입니다. 이는 역전파(backpropagation) 알고리즘을 통해 모델을 학습시킬 때 계산 효율성을 높여줍니다.