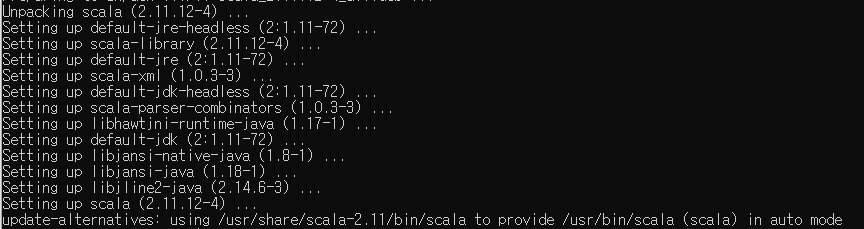

1. 필요한 패키지 다운로드

sudo apt install default-jdk scala git -y

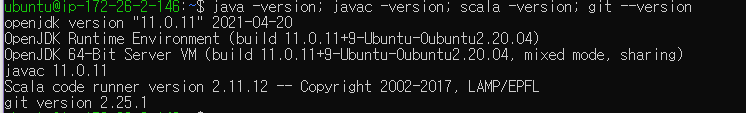

설치가 잘 되었는지 확인

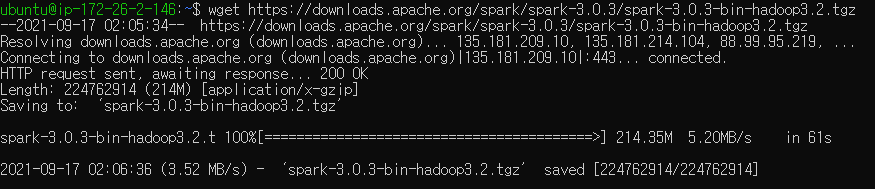

2. Spark 설치하기

https://downloads.apache.org/spark/

본인에게 맞는 버전 다운로드 후 압축풀기

wget https://downloads.apache.org/spark/spark-3.0.3/spark-3.0.3-bin-hadoop3.2.tgz

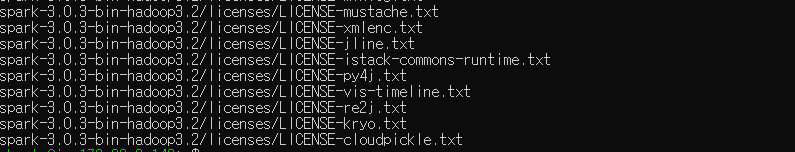

tar xvf spark-3.0.3-bin-hadoop3.2.tgz

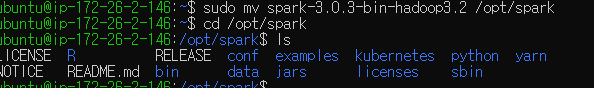

spark 폴더를 /opt/spark로 이동

3. 환경설정

.profile 파일 열기

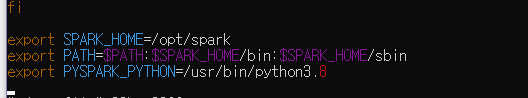

vim ~/.profile환경변수 추가

export SPARK_HOME=/opt/spark

export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

export PYSPARK_PYTHON=/usr/bin/python3.8변경사항 적용

source ~/.profile.profile이랑 .bashrc랑 뭐가 다른거지?

- ~/.profile은 지역적으로(해당 사용자에게만) 영향을 미치는 profile 파일

- bashrc는 bash에서 작업할 때마다 수행되는 파일로서, 환경변수의 개념

=> https://spidyweb.tistory.com/221

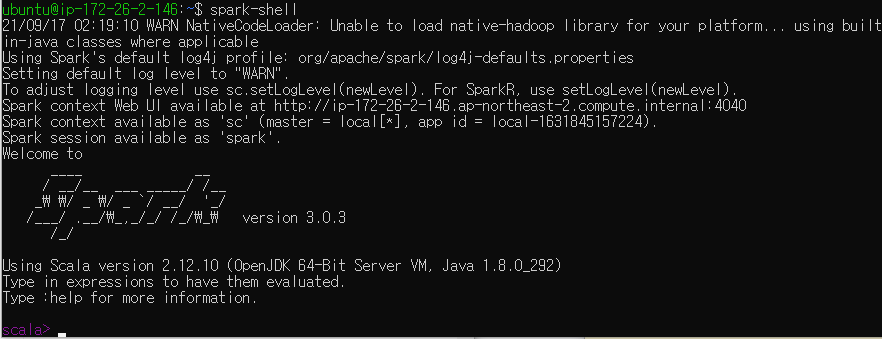

4. Spark 실행

spark-shell

.png)