요즈음, LLM의 인기와 더불어 sLM, sLLM의 인기도 커지고 있는데 문득 궁금증이 생겼다

"모바일에서 LLM을 사용할 수 있을까?"

LLM은 워낙 무겁기도 하고 클라우드 기반으로 사용되니까...🧐

모바일 내에서 컨트롤할 수 있을지에 대해 궁금해서 이것저것 찾아봤다.

그 중 특히 메타에서 24년 2월에 출간한 논문을 리뷰하려고 한다 !

오늘 포스팅은 논문 리뷰가 포함되어 있습니다 !

📖오늘의 논문

MobileLLM: Optimizing Sub-billion Parameter Language Models for On-Device Use Cases

(모바일LLM: 기기 내 사용 사례를 위한 10억 미만 매개변수 언어 모델 최적화)

1. 온디바이스 AI(On-Device AI)란 ?

1) 정의

- 물리적으로 떨어진 클라우드 서버에 의존하지 않고 사용자의 디바이스 내부에서 인공지능 연산을 바로 수행하는 것

- 애플 '시리'에 'gpt-4o-mini' 탑재나 삼성 Galaxy AI 같이

기존에 주로 사용되던 클라우드 서버가 아닌 스마트폰 자체에서 정보를 처리할 수 있는 기술

2) 장점

- 작은 용량으로 비용 절감, 전력 소모량 감소

- 프라이버시 확보

- 빠른 응답 속도

- 초개인화

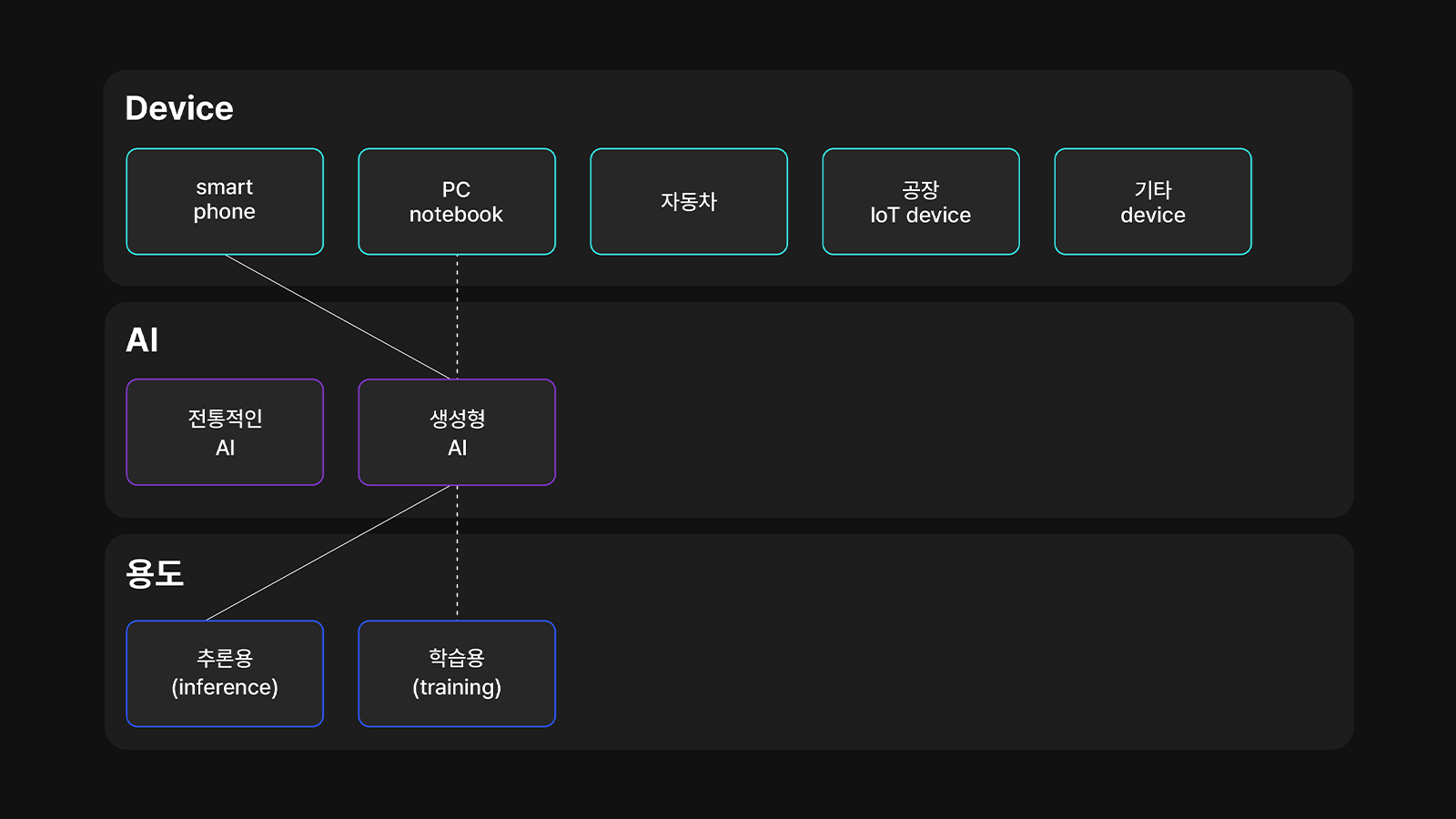

3) 온디바이스 AI의 구성요소

- 디바이스 ≒ 하드웨어 정도로 생각하면 쉬움

- 내장 AI = 간단한 작업을 하는가(전통적인) ? 다양하고 복잡한 작업을 하는가(생성형)?

- 용도 = 결과를 도출하는가(추론)? 대량의 데이터를 학습하는가(학습)?

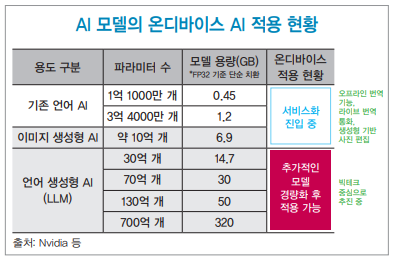

보통의 LLM 모델은 모델의 크기가 크기 때문에 주로 클라우드에 기반하지만,

스마트폰에서 원활히 구동하려면 파라미터를 40억개 이하로 줄여야 한다고 한다.

그렇기 때문에 많은 개발사는 성능은 그대로 유지하면서 모델의 크기는 줄이는 방안을 모색하고 있는 것!

2. 📖 논문 리뷰

1) 논문 요약

- 모바일 배포를 위한 10억개 미만의 파라미터를 가진 LLM 설계

- 데이터와 파라미터 수의 중요성을 강조하는 기존과 달리, 본 연구는 10억 규모 LLM에서 모델 아키텍처의 중요성을 강조.

- SwiGLU, Embedding Share, GQA, Layer Sharing 메커니즘을 활용하여 MobileLLM이라는 강력한 기준 네트워크를 구축

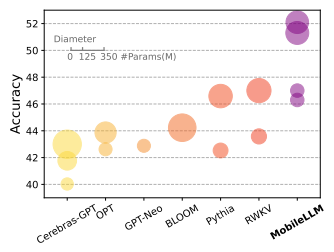

- 이전의 125M/350M 최첨단 모델보다 각각 2.7%와 4.3%의 정확도 향상.

- 모델 크기 증가 없이 지연 오버헤드가 미미한 블록 기반 가중치 공유 접근 방식 제안.

→ MobileLLM-LS라는 모델이 MobileLLM 125M/350M보다 각각 0.7%와 0.8%의 정확도 향상.- MobileLLM 모델은 이전의 10억 미만 모델에 비해 채팅 벤치마크에서 상당한 개선을 보였으며,

API 호출 작업에서 LLaMA-v2 7B와 근접한 정확도를 보여줌

∴ 소형 모델이 일반적인 모바일 사용 사례를 처리할 수 있는 능력 강조

2) study

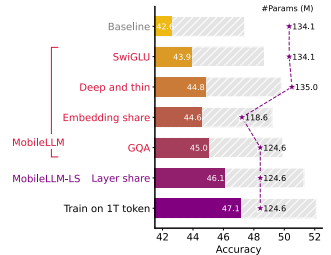

mobileLLM의 정확도가 다른 모델에 견주어도 나쁘지 않다는 걸 잘 보여주고 있음!

이 그래프는 MobileLLM 모델들에게 다양한 최적화 기법을 적용했을 때 정확도와 모델 크기를 비교한 그래프

SwiGLU, Embedding Share, GQA, Layer Sharing 등의 최적화 기법을 통해 모델 크기를 줄이면서도 정확도를 향상시키거나 유지할 수 있음을 보여주고, 최종적으로 MobileLLM-LS가 가장 높은 성능을 보이면서도 모델 크기는 상대적으로 작은 걸 보여준다

| 기법 | 설명 | 주요 장점 | 활용 이유 |

|---|---|---|---|

| SwiGLU | Gated Linear Units(GLU)의 변형으로 활성화 함수에서 다양한 경로를 활성화함 | 연산 효율성이 높고 모델의 복잡한 정보를 처리할 수 있음 | 계산 효율성을 높이면서 성능을 향상시키기 위해 사용됨 |

| Embedding Share | 입력 및 출력 임베딩 레이어에서 동일한 가중치를 재사용하는 방법 | 메모리 사용량 절감, 모델 크기 축소 | 메모리 제약이 있는 환경에서 성능을 유지하면서 효율성 극대화 |

| GQA | 쿼리 어텐션을 그룹으로 나누어 연산하는 기법 | 연산 비용 절감, 성능 저하 없이 효율성 증가 | Attention 메커니즘의 연산 효율을 극대화하기 위해 사용됨 |

| Layer Sharing | 동일한 가중치를 여러 레이어에 걸쳐 재사용하는 방법 | 모델의 크기 증가 없이도 깊이를 늘리고 메모리 절감 | 모바일 장치 등 리소스가 제한된 환경에서 모델 크기를 줄이면서도 성능 유지 |

-

이 논문에서 나온 건 아니지만, 모델 최적화 기술 중에 지식 증류(Knowledge Distillation) 라고 있는데, LLM을 이용해 더 작은 모델을 훈련시키는 방법이다. 이 방법으로 원래 모델보다 몇 배나 작은 모델로 크기를 감소 시킬 수 있다!

-

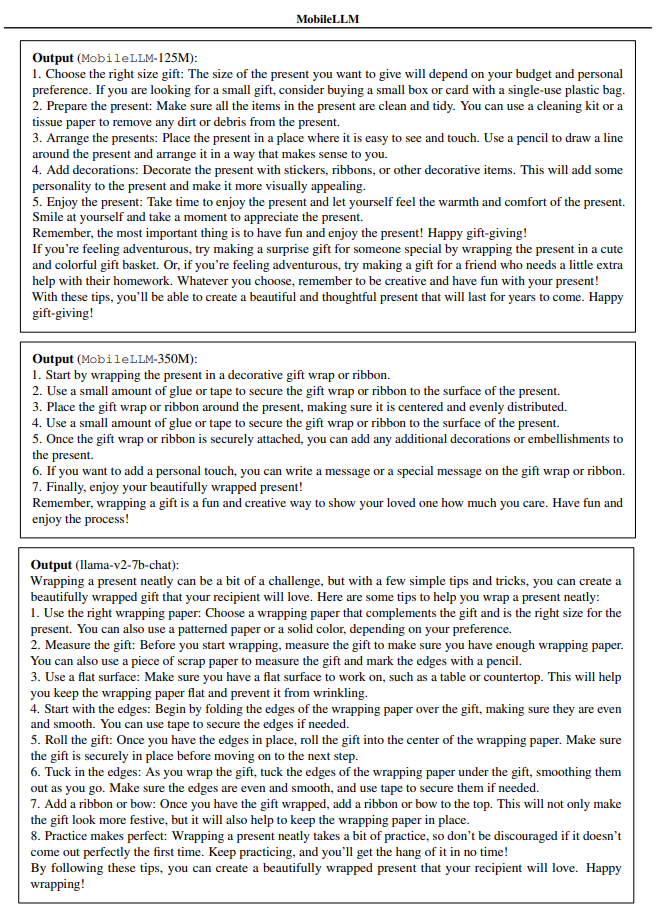

논문 부록을 보면 같은 질문에 대해 각 모델들이 어떻게 Output을 냈는지 확인할 수 있다

input : How do I wrap a present neatly? (선물포장 예쁘게 하는 법)

3) insight

결론부터 말하자면, 아직 개개인이 스마트폰으로 LLM을 자유자재로 다룰 수 있는 정도로는 오지 않았다

다만, 성능을 유지하면서 모델의 크기는 경량화시키는 방향으로 개발이 이루어 지고 있다는 것!

현재 스마트폰을 사용하면서 보통 하나에 하나씩 작업하기 마련인데, 온디바이스 AI를 통해 여러 개의 앱을 동시에 수행하며, 복잡한 과정을 더 간편하게 할 수 있다는 사실이 매력적으로 다가왔다

기존에는 문자를 보내고 사진을 찍고 번역 앱을 이용하는 등 각각의 기능이 별도로 존재했다면, 이제는 그런 기본 기능과 스마트폰의 내부 정보를 이용하여 스마트폰 갤러리 사진을 선택 및 편집하고, 이메일로 전송하는 서비스가 가능해진다는 것!

현재 기술적인 측면도 있지만 여기서 더 나은 서비스가 나올 것인지에 대해 기획적인 부분도 생각이 든다.

아직 어떤 시장이 될지 감이 잘 안잡힌다.

한국저작권위원회의 온디바이스 AI 산업현황 보고서에 따르면 AI 시장과 더불어 온디바이스 AI 시장도 상승세를 보일 전망이지만,

"실제 사용하는 유저에게는 어떻게 다가올 것인가?"

흥미로운 불확실성의 세계다.

4) 참고문헌

Liu, Z., Zhao, C., Iandola, F. N., Lai, C., Tian, Y., Fedorov, I., Xiong, Y., Chang, E., Shi, Y., Krishnamoorthi, R., Lai, L., & Chandra, V. (2024). MobileLLM: Optimizing Sub-billion Parameter Language Models for On-Device Use Cases. arXiv.

[문화칼럼] LLM을 넘어 온디바이스 AI로-(41).

https://m.mdilbo.com/detail/CBIT5x/726288

[All Around AI 5편] 스마트폰과 온디바이스(on-device) AI의 미래. https://news.skhynix.co.kr/post/all-around-ai-5

온디바이스 AI(On-Device AI) 산업현황 보고서. https://www.copyright.or.kr/information-materials/trend/tmis/view.do?brdctsno=53345

생성형 AI 열풍으로 성큼 다가온 온디바이스 AI. 박종석, 유지호https://www.lgbr.co.kr/uploadFiles/ko/pdf/busi/LGBR_Report_240408_20242808162819203.pdf