개요

- 자연어 데이터는 인간이 일상적으로 사용하는 언어에서 발생하는 텍스트 또는 음성 데이터로, 자연어 처리(Natural Language Processing, NLP)의 주된 연구 및 응용 대상이며, 여러가지 고유한 특징을 갖음

- 다양성 및 변동성

- 문맥 의존성

- 비구조적 데이터

- 언어학적 뉘앙스

- 특수문자와 형식

- 진화하는 언어

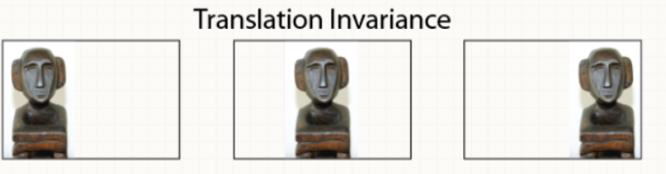

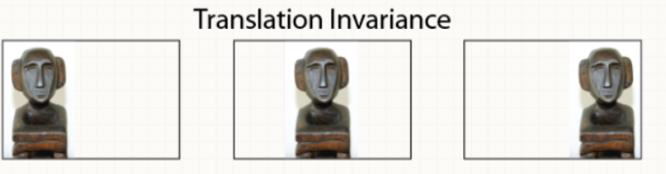

- 이미지와 달리, 자연어 데이터(문장)의 경우, 문장을 구성하고 있는 단어들의 위치가 변해서는 안됨

- 단어들 간의 관계가 중요하며 하나의 단어만 바뀌거나 추가되어도 전혀 다른 의미(context)를 가질 수 있음

- 2017년 Google의 연구팀에 의해 소개된 모델로, "Attention Is All You Need"라는 논문에서 처음 등장함

- 이 모델은 기존의 순차적인 처리방식(ex. RNN, LSTM)을 벗어나, 전체 입력을 한꺼번에 처리할 수 있는 새로운 구조를 제하였음

- Transformer의 핵심은 "Attention Mechanism"으로, 입력 데이터의 각 부분이 다른 부분과 어떻게 상호작용하느지를 학습하여 중요한 정보에 더 많은 가중치를 두고 처리함 (이를 통해 문맥 이해와 정보의 흐름을 크게 향상시킬 수 있음)

- 2018년에 Google이 발표한 모델로, Transformer아키텍처를 기반으로 함

- Bert의 혁신적인 점은 입력 데이터를 양방향에서 동시에 처리하는 "양방향 트랜스포머(Bidirectional Transformer)"를 사용한다는 것이며, 이를 통해 모델이 주어진 텍스트를 좀 더 깊이 있게 이해할 수 있음

- 결과적으로, 문맥적 의미를 포함한 다양한 언어 이해 작업에서 뛰어난 성능을 보이며, BERT는 특히 문장 내 단어의 의미를 문맥에 따라 변화시키는 능력이 있음

- GPT는 OpenAI에 의해 개발된 시리즈의 모델로, 최초의 GPT는 2018년에 발표됨

- GPT도 Transformer의 아키텍처를 기반으로 하지만, 특히 '생성적 사전학습(Generative Pre-trainning)'단계에서 학습 방법론에 차이를 둠

- GPT는 대규모 데이터셋에 사전 학습을 수행한 후, 특정 작업에 대해 미세 조정(Fine-tunning)을 통해 다양한 NLP작업에 적용될 수 있음

- GPT는 텍스트 생성에서 특히 강력한 성능을 보이며, 자연어 이해와 생성 작업 모두에서 뛰어난 결과를 보여주고 있음