Kafka Cluster 스펙

- Zookeeper 1개

- Broker 3개

- kafdrop

Kafka를 쉽게 관리할 수 있도록 Web UI를 제공하는 OpenSource

docker-compose.yml 작성하기

Local에서 Cluster를 구축하기 어렵기 때문에 Docker를 이용하여 Kafka Cluster를 구축해본다.

docker-compose.yml

version: '3'

services:

zookeeper:

image: zookeeper:3.7

hostname: zookeeper

ports:

- "2181:2181"

environment:

ZOO_MY_ID: 1

ZOO_PORT: 2181

volumes:

- ~/data/zookeeper/data:/data

- ~/data/zookeeper/datalog:/datalog

kafka1:

image: confluentinc/cp-kafka:7.0.0

hostname: kafka1

ports:

- "9091:9091"

environment:

KAFKA_BROKER_ID: 1

KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181

KAFKA_ADVERTISED_LISTENERS: LISTENER_DOCKER_INTERNAL://kafka1:19091,LISTENER_DOCKER_EXTERNAL://${DOCKER_HOST_IP:-127.0.0.1}:9091

KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: LISTENER_DOCKER_INTERNAL:PLAINTEXT,LISTENER_DOCKER_EXTERNAL:PLAINTEXT

KAFKA_INTER_BROKER_LISTENER_NAME: LISTENER_DOCKER_INTERNAL

KAFKA_OFFSETS_TOPIC_REPLICATION_FACTOR: 1

volumes:

- ~/data/kafka1/data:/tmp/kafka-logs

depends_on:

- zookeeper

kafka2:

image: confluentinc/cp-kafka:7.0.0

hostname: kafka2

ports:

- "9092:9092"

environment:

KAFKA_BROKER_ID: 2

KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181

KAFKA_ADVERTISED_LISTENERS: LISTENER_DOCKER_INTERNAL://kafka2:19092,LISTENER_DOCKER_EXTERNAL://${DOCKER_HOST_IP:-127.0.0.1}:9092

KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: LISTENER_DOCKER_INTERNAL:PLAINTEXT,LISTENER_DOCKER_EXTERNAL:PLAINTEXT

KAFKA_INTER_BROKER_LISTENER_NAME: LISTENER_DOCKER_INTERNAL

KAFKA_OFFSETS_TOPIC_REPLICATION_FACTOR: 1

volumes:

- ~/data/kafka2/data:/tmp/kafka-logs

depends_on:

- zookeeper

kafka3:

image: confluentinc/cp-kafka:7.0.0

hostname: kafka3

ports:

- "9093:9093"

environment:

KAFKA_BROKER_ID: 3

KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181

KAFKA_ADVERTISED_LISTENERS: LISTENER_DOCKER_INTERNAL://kafka3:19093,LISTENER_DOCKER_EXTERNAL://${DOCKER_HOST_IP:-127.0.0.1}:9093

KAFKA_LISTENER_SECURITY_PROTOCOL_MAP: LISTENER_DOCKER_INTERNAL:PLAINTEXT,LISTENER_DOCKER_EXTERNAL:PLAINTEXT

KAFKA_INTER_BROKER_LISTENER_NAME: LISTENER_DOCKER_INTERNAL

KAFKA_OFFSETS_TOPIC_REPLICATION_FACTOR: 1

volumes:

- ~/data/kafka3/data:/tmp/kafka-logs

depends_on:

- zookeeper

kafdrop:

image: obsidiandynamics/kafdrop

restart: "no"

ports:

- "9000:9000"

environment:

KAFKA_BROKER_CONNECT: "kafka1:19091"

depends_on:

- kafka1

- kafka2

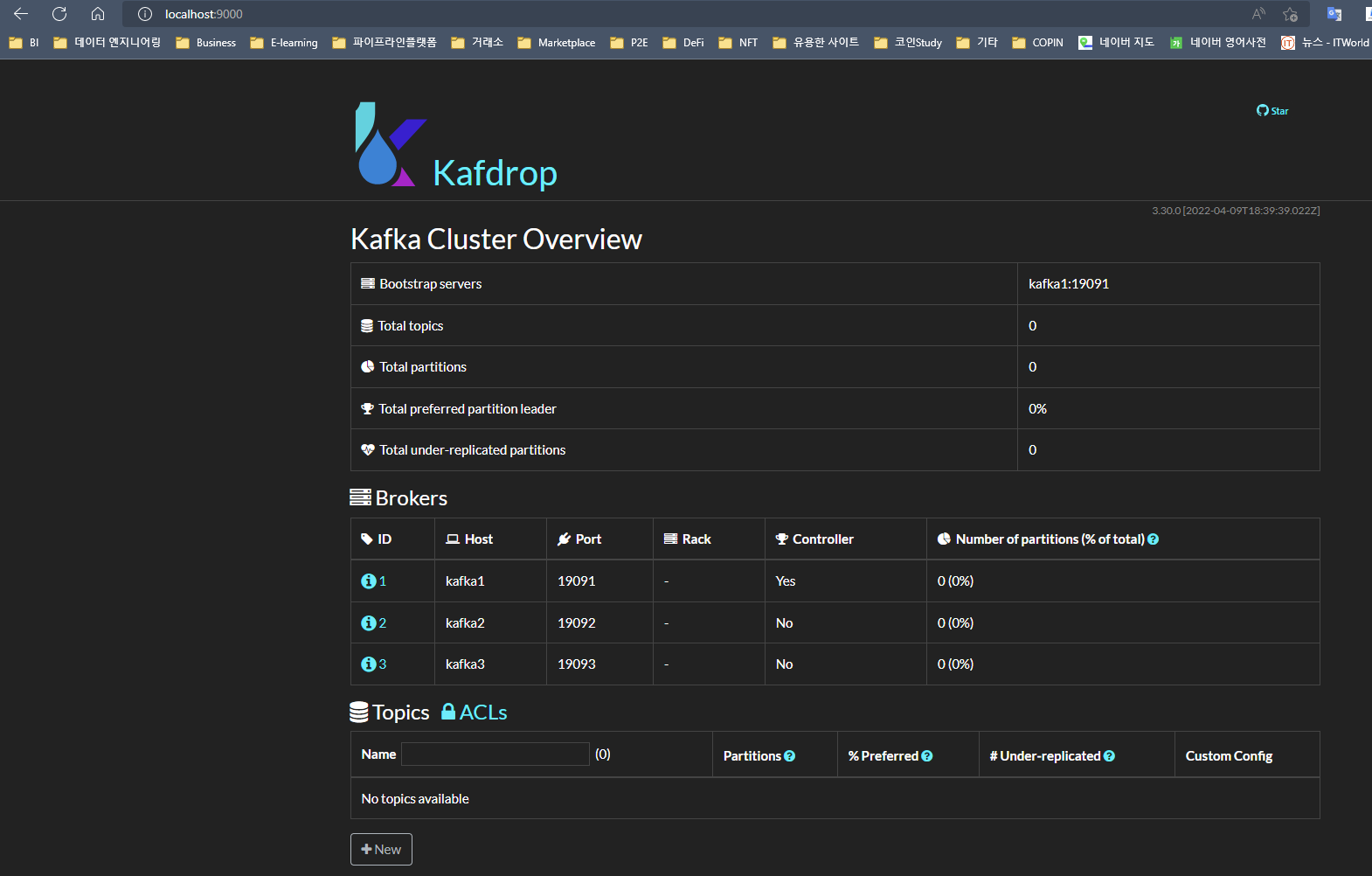

- kafka3kafdrop

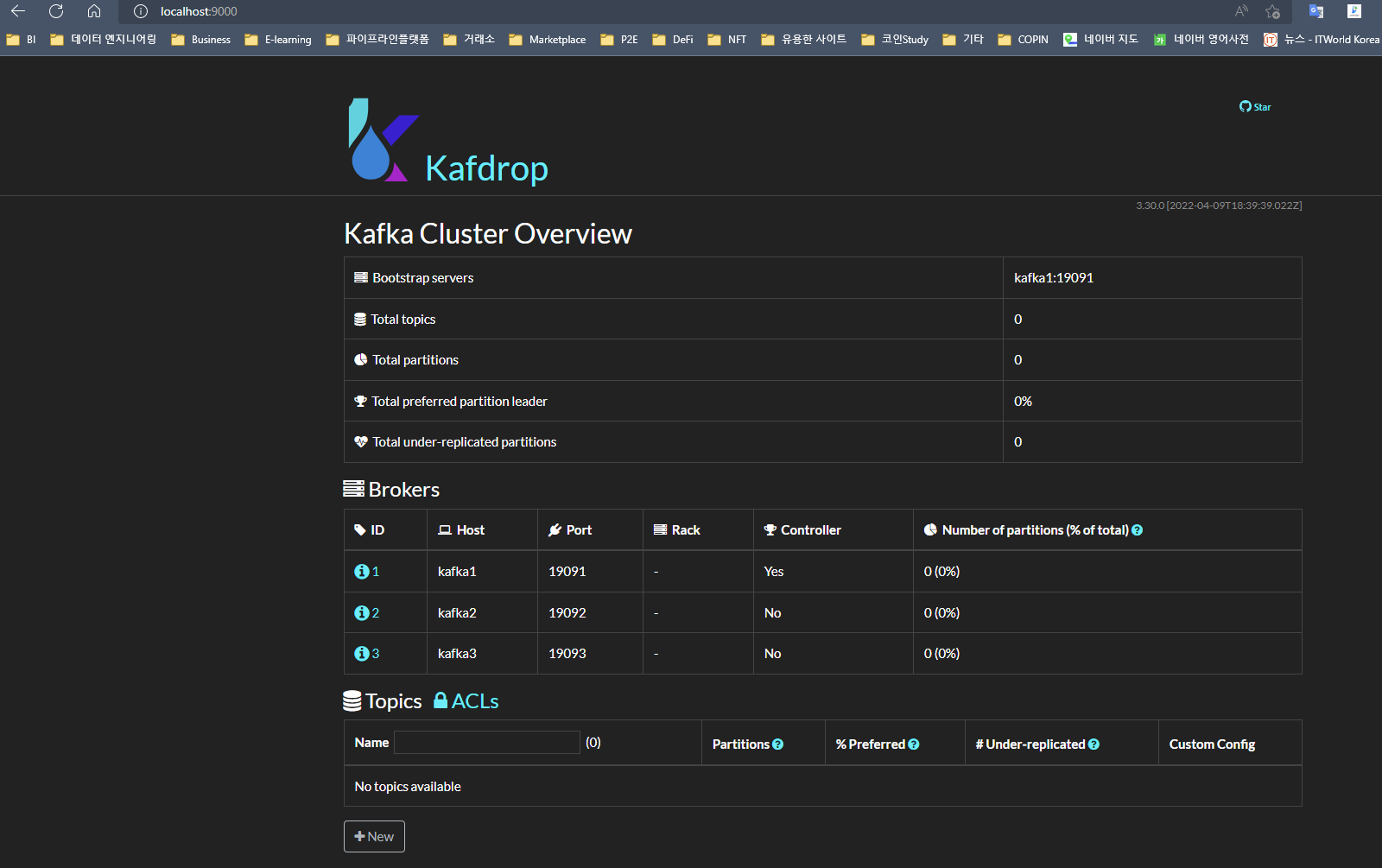

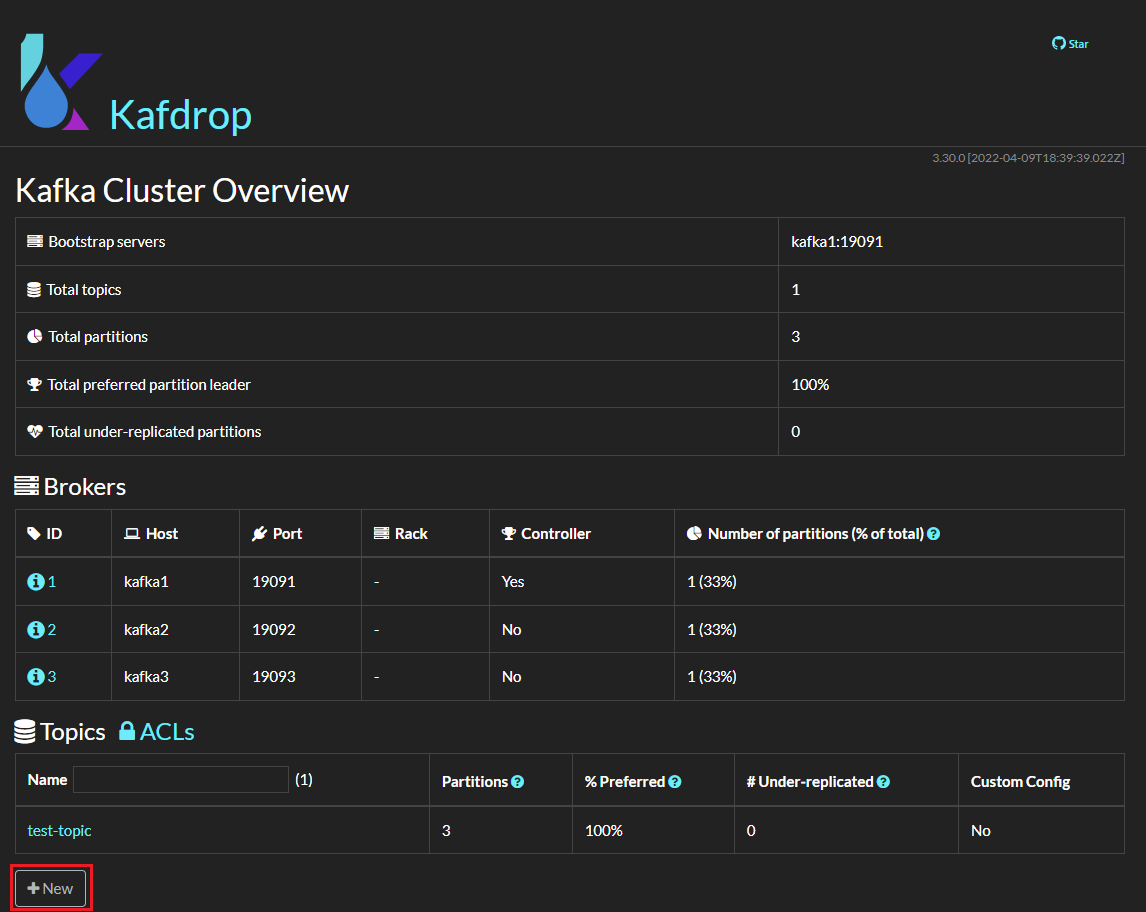

Kafka Web UI OpenSource로, http://localhost:9000 으로 접속하여 Kafka를 직관적으로 관리할 수 있다.

Broker는 하나만 연결해주어도 되기 때문에

KAFKA_BROKER_CONNECT에kafka1을 임의로 연결한다.

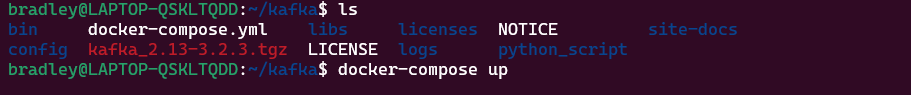

Kafka Cluster 실행하기

docker-compose.yml 파일 기반으로 Kafka Cluster를 실행한다.

docker-compose up 또는 docker-compose up -d (detach 모드, 백그라운드에서 실행)

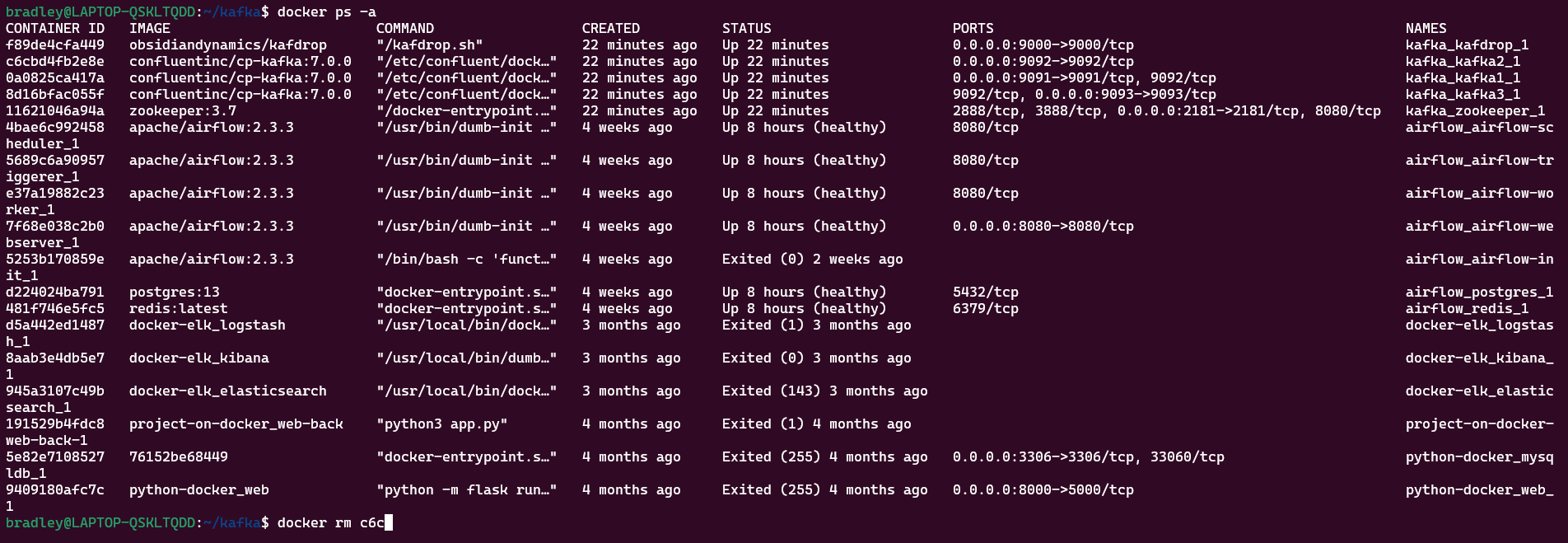

docker-compose.yml을 잘못 작성하는 등 여러 이유로 특정 Container에 Error가 발생한 경우

Container Process가 잡혀있어 다시 Error가 나게 될 수 있다. 따라서 재실행 전 다음 과정을 거치는 편이 좋다.1)

docker ps -a명령으로 Process 목록을 확인한다.

2)docker rm명령으로 kafka 관련 Container Process들을 삭제한다.

3)docker-compose up또는docker-compose up -d를 실행한다.

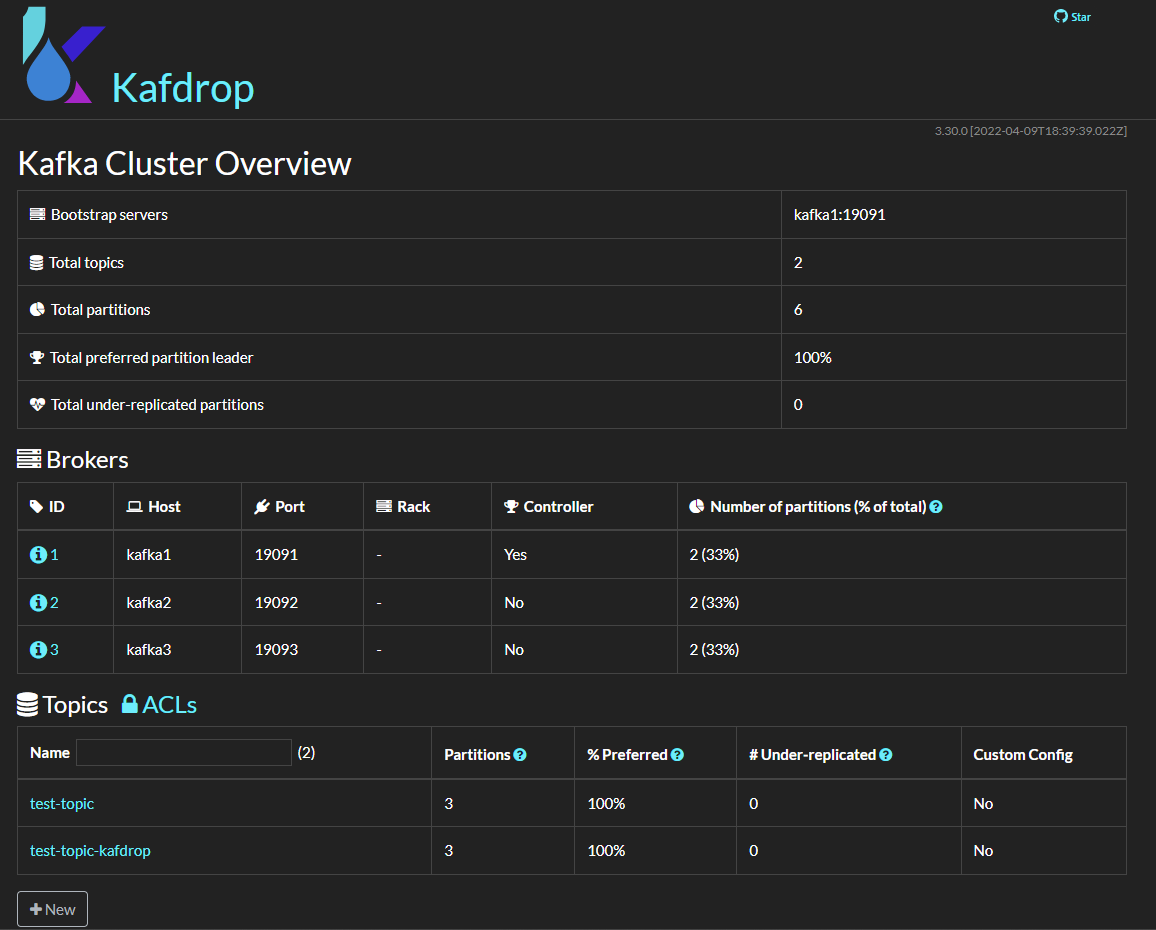

http://localhost:9000 에서 kafdrop이 실행되고 Broker 3개가 구동되는 것을 확인한다.

Topic 만들기

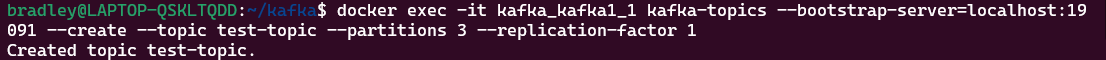

Docker CLI로 Topic 만들기

docker exec 명령으로 kafka Container에 kafka-topics 명령을 실행한다.

docker exec -it kafka_kafka1_1 kafka-topics --bootstrap-server=localhost:19091 --create --topic test-topic --partitions 3 --replication-factor 1

위 명령을

kafka2,kafka3에 실행해도 되지만, Container Name과 Port에 유의할 것

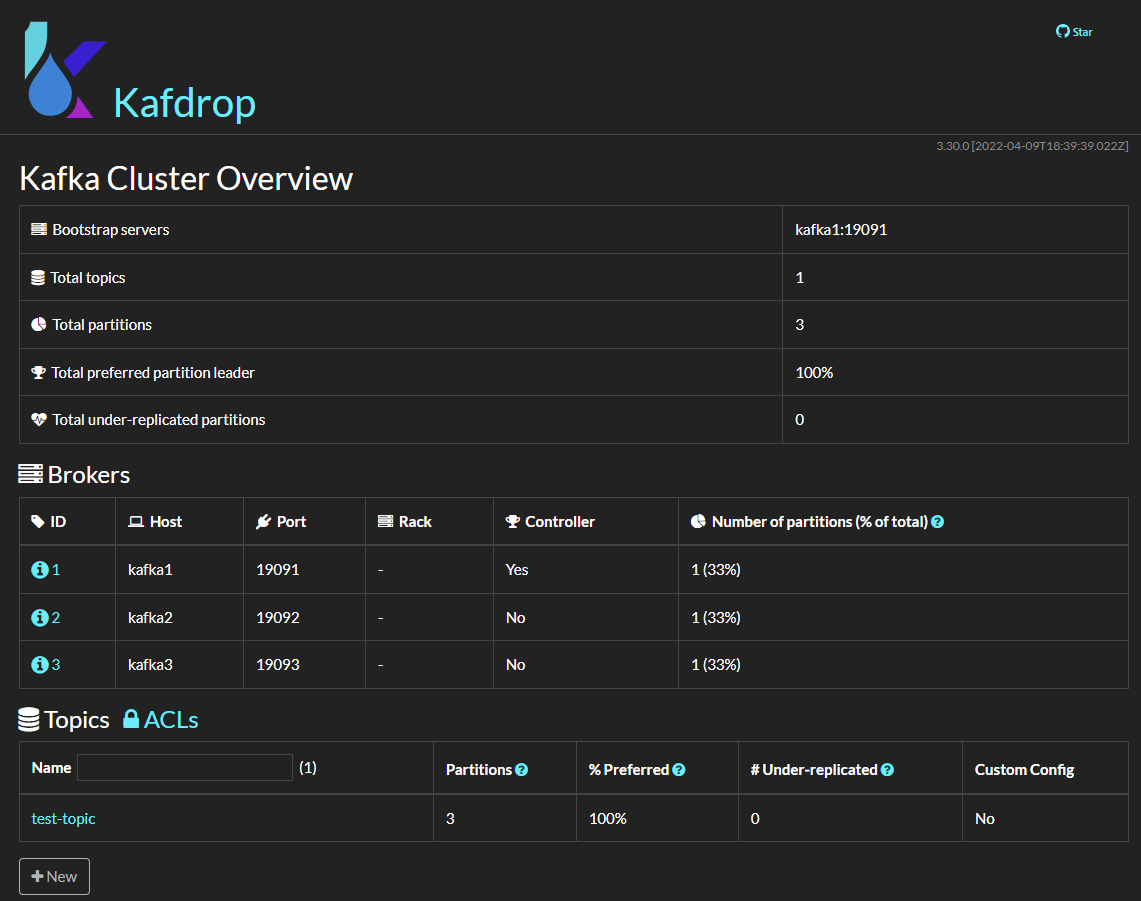

kafdrop에도 test-topic Topic이 생성된 것을 확인할 수 있다.

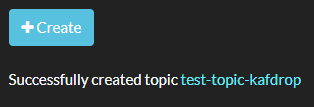

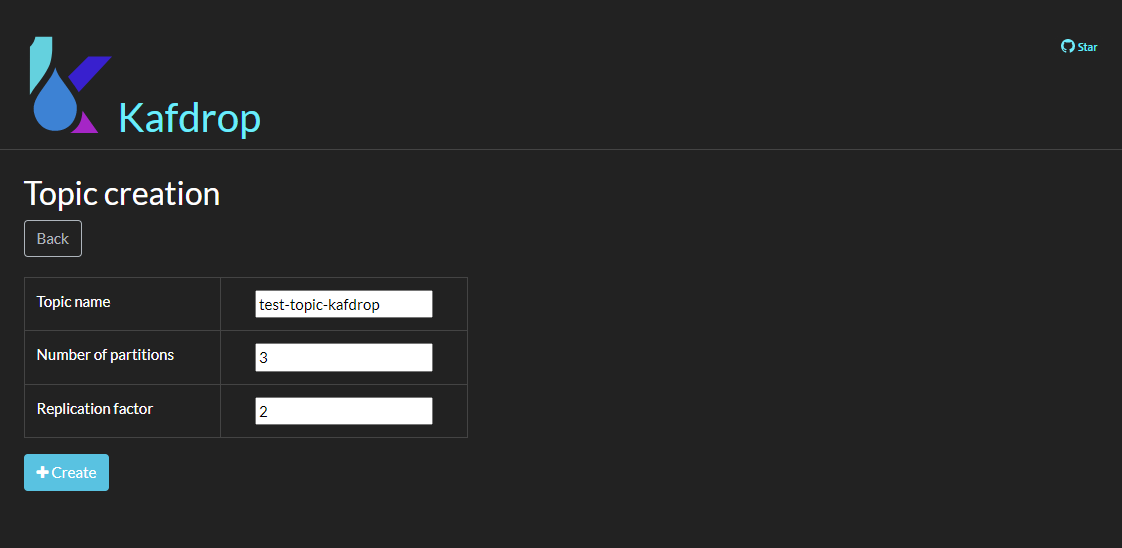

kafdrop으로 Topic 만들기

kafdrop 왼쪽 하단의 [New]를 클릭한다.

Topic 스펙을 기입 후 [Create]를 클릭한다.

Topic 생성이 성공되었다는 메세지와 함께 메인페이지에서 생성된 Topic을 확인할 수 있다.